Datawhale分享

谷歌:Gemini 2.0,整理:Datawhale

Datawhale分享

谷歌:Gemini 2.0,整理:Datawhale

最强 Pro 版本支持 2M 上下文,配备了谷歌搜索、代码执行能力,编码推理性能完全碾压 1.5 Pro。

Flash 版本被称为「高效主力模型」,支持 1M 上下文,低延迟构建应用。图像生成和文本转语音功能即将推出。

Flash-Lite 是最具性价比的模型,支持 1M 上下文和多模态输入,在相同速度和成本下性能超越 1.5 Flash。

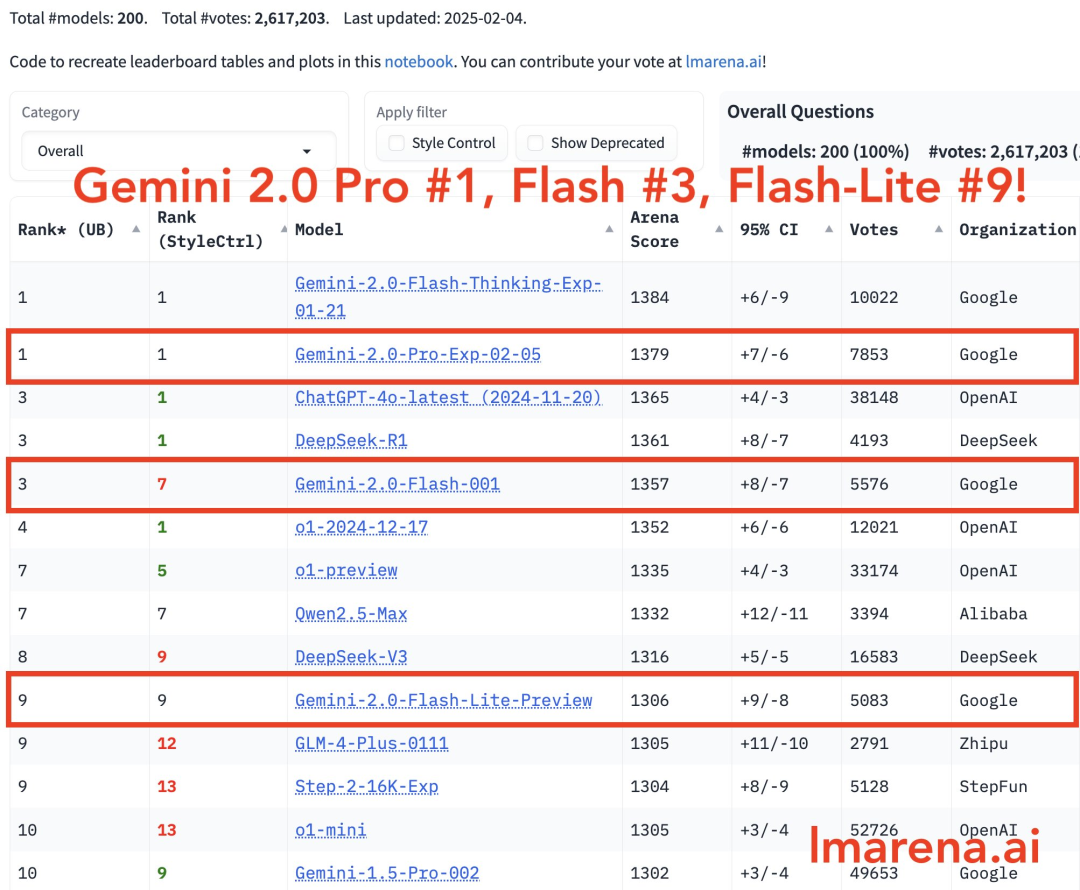

在大模型 LMSYS 排行榜中,Gemini 2.0 Pro 与四大模型并列第一,Flash 版本位列第三, Flash-Lite 位列第 9。

多模态能力仍是核心优势

此前,Google DeepMind 的 CTO Koray Kavukcuoglu 在公司博客中写道:“这些模型在发布时将支持多模态输入(文本输出),并将在未来几个月内开放更多模态的全面使用。”

令人惊讶的是,谷歌的推理模型支持上传图片,下面是一个测试示例:

于此同时,该模型可以连接到 Google 地图、YouTube 和 Google 搜索,从而实现一系列全新的 AI 驱动研究和交互。

谷歌 Gemini 2.0 三大模型:全方位加强

1. Gemini 2.0 Pro 实验版:最为出色

Gemini 2.0 Pro 实验版是谷歌迄今为止在编码和复杂指令任务中表现最好的模型。

在 Gemini 2.0 早期实验版本中(如 Gemini-Exp-1206),谷歌收到了来自开发者们的关于这些模型的优势和最佳用例的反馈,比如编码、复杂指令。

此次,Gemini 2.0 Pro 实验版本进一步强化了这些功能,具备了最强大的编码性能和处理复杂指令的能力,并且比谷歌此前发布的任何模型都具备更好的理解和推理世界知识的能力。

据官方博客介绍,该模型支持了谷歌最长的 200 万 tokens 上下文窗口,可以处理 2 小时视频、22 小时音频、6 万+ 行代码和 140 万 + 单词,从而能够全面分析和理解大量信息。同时,该模型还支持调用 Google Search 等工具和执行代码。

目前,Gemini 2.0 Pro 已经作为实验模型向 Google AI Studio 和 Vertex AI 的开发者以及桌面和移动设备上的 Gemini Advanced 用户提供。

2. Gemini 2.0 Flash:性能升级,全面可用

其次来看 Gemini 2.0 Flash,它是谷歌 Flash 系列模型的最新「成员」。

在 2024 年谷歌 I/O 大会上,Gemini 2.0 Flash(实验版本)首次亮相,此后便作为强大的主力模型而深受开发者的喜爱,并最适合大规模处理高容量、高频率任务,并能够通过 100 万 tokens 上下文窗口对海量信息进行多模态推理。

当前,Gemini 2.0 Flash 已经在谷歌的 AI 产品中向更多人全面开放使用。据介绍,该模型提供了全面的功能,包括原生工具使用。目前支持文本输出,并即将推出图像生成与文本转语音功能,未来几个月还将提供多模态 Live API。

https://developers.googleblog.com/en/gemini-2-family-expands/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢