物质科学

Physical science

以ChatGPT、Claude Sonnet、Deepseek系列为首的大语言模型(LLMs)的迅猛发展为自然语言理解与生成领域带来了前所未有的突破。这些模型在长文本理解、数学推理、自由创作等多个任务中展现出接近人类水平的表现,然而其“黑箱”属性使得内部推理机制仍然不够透明,尤其是与注意力头(attention heads)相关的关键机制。已有研究表明,注意力头在信息处理与推理过程中扮演了核心角色,其功能在一定程度上与人类大脑的认知过程存在相似性。通过系统梳理注意力头的功能分类与协作机制,有助于加深对LLMs推理瓶颈的理解,并为优化模型结构提供理论依据。近年来,借助实验验证与理论建模,研究者逐步揭示了注意力头在大模型推理过程中的多个阶段的独特作用。这些发现不仅为进一步探索模型可解释性奠定了基础,也为开发更具通用性和鲁棒性的人工智能系统提供了新思路。

近日,由上海算法创新研究院主导的研究团队在Cell Press细胞出版社旗下期刊Patterns发表了题为"Attention Heads of Large Language Models"的综述文章。该文章系统总结了大语言模型中注意力头的机制研究,包括其在模型推理中的关键作用、相关实验方法及评估标准,并创新性地提出了一个基于人类认知过程的四阶段框架,将注意力头的功能进行分类与解析。文章总结了当前研究成果,分析了模型内部机制的局限性,并展望了未来研究方向,为提升模型的解释性和推理能力提供了重要理论依据和研究思路。

▲长按图片识别二维码阅读原文

论文亮点

前沿调研与系统归纳:本论文收录了大量最新研究成果,聚焦 LLM 中注意力头的重要性及其内在机制,总结出关键实验方法与评估指标,为学术界和工业界提供了全面的理论和实证支持。

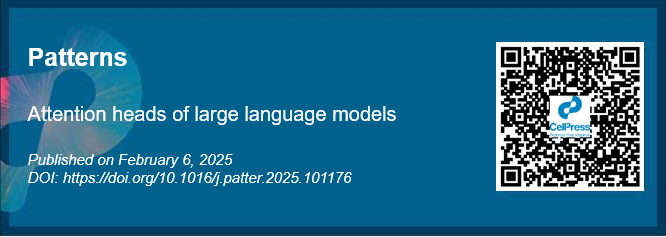

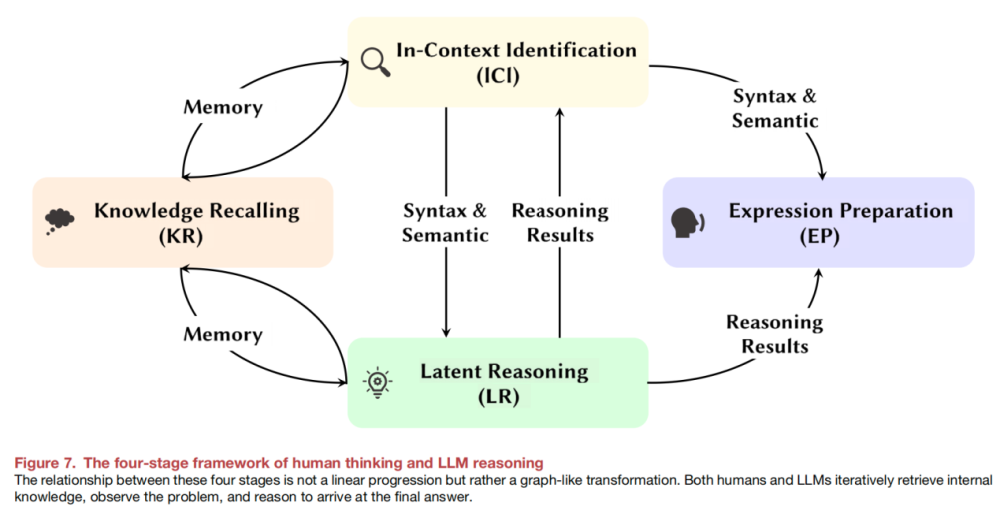

创新四阶段思维框架:以人脑思考过程为启发,作者将大语言模型的注意力头功能划分为知识召回 (Knowledge Recalling, KR)、上下文识别 (In-Context Identification)、隐式推理 (Latent Reasoning) 与表达准备 (Expression Preparation) 四个阶段,形象生动地展示了模型内部信息流转的层次结构和协同机制。

跨层协作与人脑类比:论文指出,注意力头不仅各司其职,更在不同层级中形成跨层协作,类似于大脑中各区域同步工作的模式。这一发现为解释为何模型在人类语言理解和推理任务上表现卓越提供了新思路。

实验方法与评估体系:文章详细总结了当前主流的实验方法,包括基于激活修补 (Activation patching)、消融实验 (Ablation study)、方向性干预 (Directional intervention)等建模无关技术与探针 (Probing)等建模相关技术,同时展示了多项针对知识推理、语义表达及逻辑检验的评测基准,全面呈现了注意力头的评价体系。

大模型的“脑细胞”如何思考

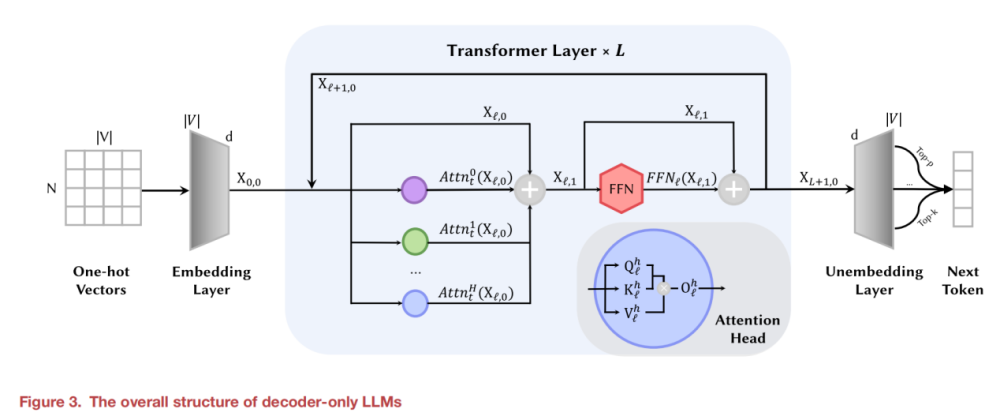

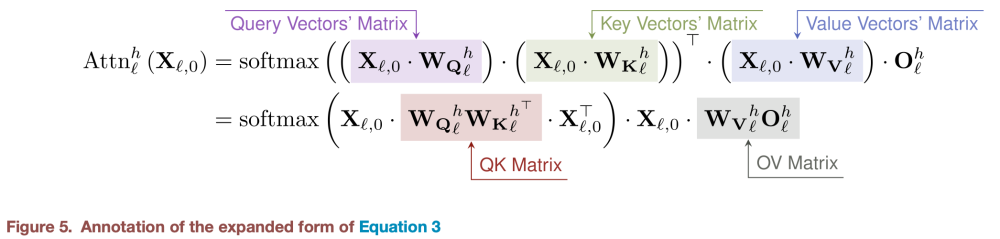

从架构层面来讲,当前主流大模型仍采用仅解码器的Transformer架构。在Transformer架构中,每个注意力头由查询矩阵 (Query Matrix)、键矩阵 (Key Matrix)和值矩阵 (Value Matrix)组成,其计算上下文中不同词元之间的注意力分数动态捕捉文本的语法、语义关系,并将信息写入到残差流 (Residual Stream)中供后续处理。

形式化表示大模型的“大脑”——四阶段认知框架

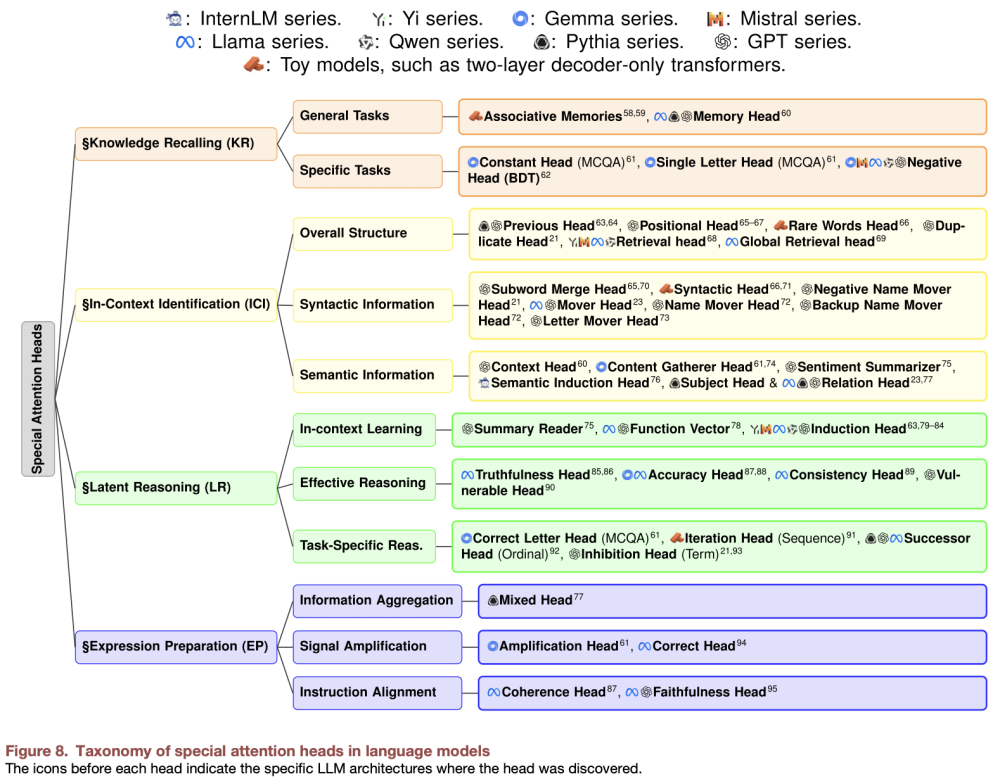

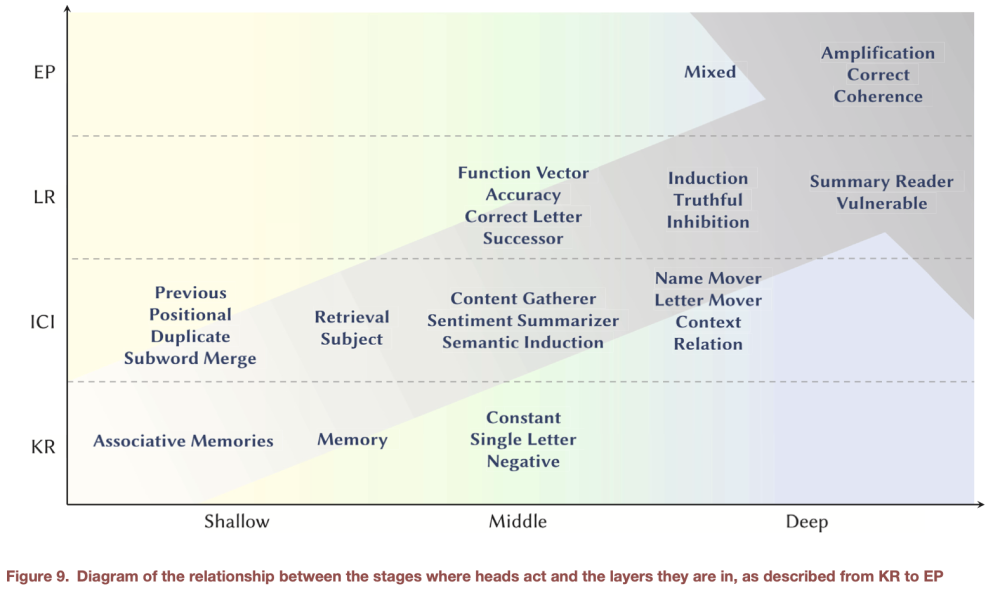

本研究表明,大模型中的特定注意力头具备高度专业化的功能,其协作模式与人类认知过程十分相似。借鉴认知神经科学方法,作者从人脑认知过程出发,提出了创新性的KR-ICI-LR-EP四阶段的类人脑认知框架,将LLM推理过程与人类推理机制进行了对齐。这四个阶段并非严格线性关系,而是存在彼此重复循环等关系,下图展现了当前研究者们所探究出的具有特定作用的注意力头与所属认知阶段的对应关系。

知识回忆(Knowledge Recalling):类比人脑的长期记忆提取,多位于模型的中浅层。其作用主要是从模型内嵌的参数化知识提取出相关概念。例如在选择题场景中,常量头(Constant Head)会为所有选项分配初始注意力权重,而负向头(Negative Head)基于训练数据中的否定表达偏好提前抑制错误选项。

上下文识别(In-Context Identification):定位关键信息、捕捉文本结构和语义关系,多位于模型的中间层。例如重复检测头(Duplicate Head)会捕捉高频词,全局检索头(Global Retrieval Head)则在长文本中精准定位关键信息(如从千字文档提取特定日期),而语义归纳头(Semantic Induction Head)则负责识别部分-整体、用途等概念关系。

隐式推理(Latent Reasoning):基于上下文信息实现逻辑推导与模式匹配,并执行核心逻辑运算,多位于模型中深层。例如归纳头(Induction Head)负责识别A→B模式并结合后续出现的A归纳推理出B,迭代头(Iteration Head)则执行数学序列迭代式推理(如奇偶性推理),而真实性头(Truthfulness Head)负责抑制与事实矛盾的推理路径。

表达准备(Expression Preparation):将内部推理结果转化为准确表达的语言形式,多位于模型的深层。例如混合头(Mixed Head)会聚合各阶段信息流,信号放大头(Amplification Head)则用以提升正确答案的logit值,而忠实性头(Faithfulness Head)负责确保思维链与实际输出结果的一致性。

揭开“黑盒” 的工具——机制探究的实验方法论

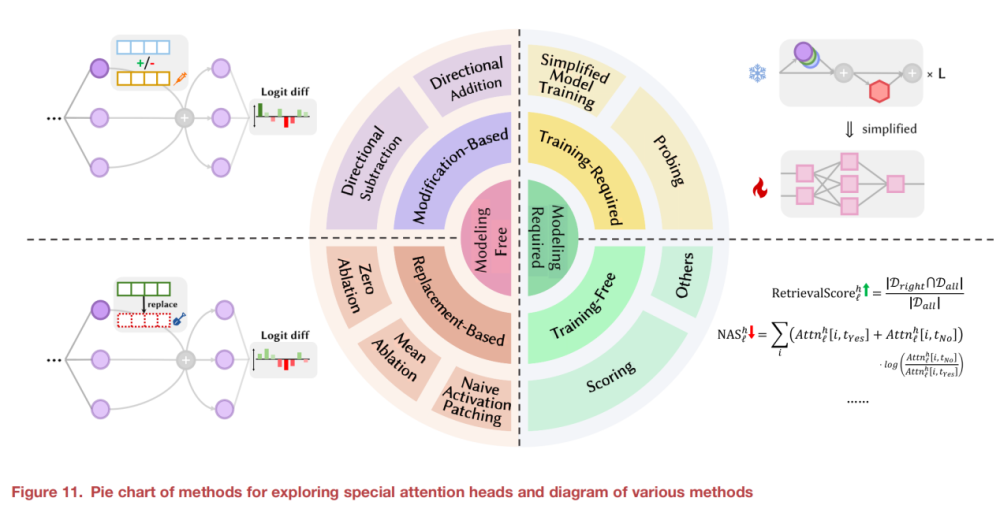

本文还详细总结了之前研究者在探究具有特定功能的注意力头的实验方法论,并分为了建模无关方法 (Modeling-Free)和建模相关方法 (Modeling-Required)。

建模无关方法主要包括激活修补和消融实验。研究者通过直接修改或屏蔽特定层的激活状态,比较扰动前后的输出变化,从直观上判断这些注意力头在信息提取、情感筛选和逻辑推理等任务中的作用;同时,利用方向性干预手段,通过添加或减少特定语义信息,进一步验证模型内部线性表示的有效性。

建模相关方法需构建简化模型或探测器,从训练角度定量分析注意力头功能。通过训练相关分类器或设计评分机制(如 Retrieval Score、Negative Attention Score),研究者能更精确地评估各注意力头在知识召回、隐式推理等环节中的关键贡献。

总结与讨论

作者在本文系统探讨了大语言模型中注意力头的内部机制及其类脑协作现象,为揭示模型推理过程提供了全新视角。然而,目前在任务泛化性、机制迁移、多头协作和理论支撑方面仍存在明显局限。展望未来,我们亟需在复杂任务情境下深入挖掘注意力头的关键功能,提升提示表达的鲁棒性,并开展跨模型泛化实验,构建覆盖全组件的认知解释框架。同时,借鉴机器心理学 (Machine Psychology)的理论,为模型注入更符合人类认知的“灵魂”。只有不断突破这些技术难题,我们才能逐步彻底揭开黑箱,为通用人工智能时代的到来奠定根基。

作者介绍

李志宇

研究员/CTO

李志宇,上海算法创新研究院大模型中心技术负责人/研究员,记忆张量(上海)科技有限公司 CTO。先后在阿里巴巴业务平台事业部、小红书商业化技术部、上海算法创新研究院带领团队从事算法研究与落地研发工作。主要研究方向包括Graph和Language Pre-train相关,已在Patterns、ICLR、NeurIPS、TKDE、ACL和AAAI等领域国内外期刊会议发表论文40余篇。现任中国中文信息学会信息检索专委会委员、大模型与生成专业委员会委员。近期核心工作围绕大模型可控生成、可信评估与检索增强展开,系列工作被《麻省理工科技评论》(封面文章)、《机器之心》、PaperWeekly等主流科技学术媒体多次报道。

郑子帆

硕士研究生

郑子帆,北京理工大学本科,悉尼大学工程学院计算机科学系在读硕士研究生,上海算法创新研究院大模型中心实习生。其主要研究方向包括可解释人工智能、大模型幻觉优化等。

相关论文信息

论文原文刊载于Cell Press细胞出版社旗下期刊Patterns,

点击“阅读原文”或扫描下方二维码查看论文

▌论文标题:

Attention heads of large language models

▌论文网址:

https://www.sciencedirect.com/science/article/pii/S2666389925000248

▌DOI:

https://doi.org/10.1016/j.patter.2025.101176

▲长按图片识别二维码阅读原文

Patterns现已加入Cell Press MJS多刊审稿!Cell Press Multi-Journal Submission(点击查看)的前身Cell Press Community Review模式于2021年推出。对于通过Cell Press Multi-Journal Submission“多刊审稿”模式投稿的作者,我们将提供稿件被多本期刊同时考虑的机会。超过80%通过Cell Press Multi-Journal Submission“多刊审稿”模式投稿的文章获得了至少一个或多个期刊的评审。

CellPress细胞出版社

推荐阅读

Patterns特刊征稿:多模态AI模型的发展与应用

▲长按识别二维码关注细胞科学

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢