导语

如何像画家一样,用简洁的笔触勾勒出复杂网络的精髓?这个网络科学领域的“素描”难题,本质上是指我们如何对网络进行粗粒化,同时也能保留网络的信息动力学特性。近期,我们在《自然通讯》上提出了一种基于统计物理和机器学习的复杂网络粗粒化方案,该方案既能在压缩网络尺寸的同时保留网络的信息动力学特性,又能够显著降低网络压缩算法的时间复杂度,并揭示网络的多尺度规律。研究团队人员来自北京师范大学,集智科学研究中心和帕多瓦大学。相关算法也已在github开源,欢迎大家访问:

https://github.com/3riccc/nfc_model

近年来,张江课题组聚焦于利用新兴AI技术进行基于数据驱动的自动建模研究,并立志破解复杂系统的涌现之谜。课题组希望构建名为“复杂AI次方”的开放实验室,欢迎对复杂系统自动建模领域有热情,且认可这个领域发展前景的朋友一起来合作,促进这一领域的快速发展!

集智科学研究中心致力于营造跨学科探索小生境,催化复杂性科学新理论。集智研究中心长期关注复杂科学中的核心问题,如涌现、因果、自指、意识、生命起源等等,并充分结合人工智能机器学习技术尝试解决这些问题。目前已有15篇文章发表于国际期刊,其中包括一篇因果涌现的综述和一篇生命起源的综述。这里的文章大部分产生于集智社区读书会。(访问集智科学研究中心网站了解详情:www.research.swarma.org)

背景

背景

论文题目:Coarse-graining network flow through statistical physics and machine learning 论文地址:https://www.nature.com/articles/s41467-025-56034-2 论文作者:Zhang Zhang, Arsham Ghavasieh, Jiang Zhang & Manlio De Domenico

复杂系统是一个令人着迷的研究对象,一些简单的单元的集群,以特定的规则和方式进行交互,竟然导致宏观层面涌现出人们不曾预知的功能,从大规模的社会合作到人脑中智能与意识的涌现,甚至现在基于联结主义的深度学习模型莫不是如此。为什么复杂系统如此重要而有趣?我想是因为复杂系统在试图回答一些关于我们这个世界为何如此这一很本质的问题——在相当长一段时间的科学史中,许多科学家们相信只要能够以还原论的视角挖掘出世界最基本的组成单元和机制,那么我们就能理解世界的全部奥秘,但复杂系统告诉我们并非如此,因为世界的组成本身比其组成元素要复杂得多。

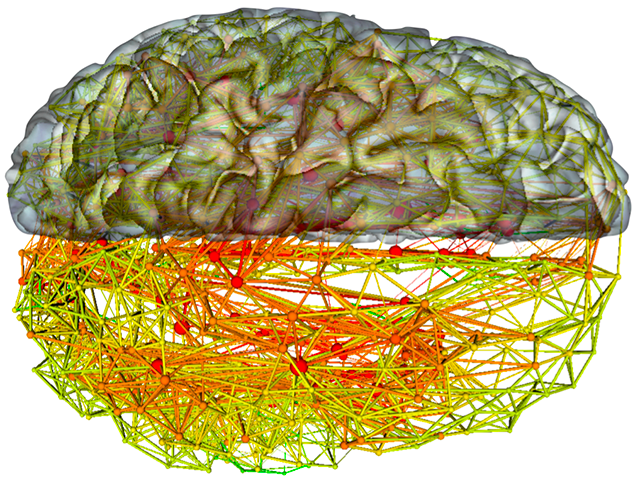

来源:Martijn van den Heuvel, Journal of Neuroscience

一个极端的例子是,我们现在基本知道大脑中智能的涌现是其中约860亿个神经元共同作用的结果,但如果我们有一个理想实验室,里面整齐的摆放着860亿个充满活性的神经元和一台高精度手术刀可以让我们任意连接这些神经元。即便如此,我想我们也对如何重组人脑毫无头绪,因为神经元如何连接,如何交互的秘密尚未被揭示,“连接,交互与组成”的秘密,或许比神经元本身的生物化学性质更加重要。

另一个科学家们已经很熟练但细细想来稍显吊诡的例子是计算机对复杂系统的模拟,例如人工股票市场或鸟群模型,在这些模型中,科学家们通过编程决定每一个投资人算法或每一只鸟的算法如何彼此交互,从而在宏观层面展现出和真实金融市场和鸟群高度相似的行为。细细想来十分诡异,这意味着这些复杂系统的表现,不但和其底层的物理基础毫无关系,甚至不要求其底层的物理基础真实存在,这种“隔绝效应”再一次印证了“连接,交互与组成”才是一个系统何以如此的根本。

既然复杂系统如此奇妙而重要,且往往与其底层的物理基础无关,那我们应该从何种角度入手来理解复杂系统呢?我们相信结构与结构上的信息传递是一把理解系统涌现功能的金钥匙。尽管复杂系统横跨不同领域且功能多样,但我们也发现不同领域的复杂系统存在着共性:他们大多数都有底层的网络作为骨架,这就是复杂网络,而复杂网络上流动着的信息支撑着复杂系统的功能。已经有许多研究专注于解决网络结构与涌现功能之间的关系的问题,但这些研究受限于尺度和算力的变量:一个能涌现出奇妙功能的复杂网络往往有极大的规模,而计算这一大规模网络系统的信息动力学性质又需要极高的算力,这使得我们很难直接处理这种大规模的复杂网络,并理解他的结构与信息传递功能的关系。

毫无疑问这是一座巨大的金矿,而我们近期发表的工作为大家在这里淘金提供一把小巧轻便的铲子,使用我们提出的方法,大家可以以极低的复杂度,通过粗粒化来建立大网络的微缩小网络模型,模型虽小,却保留了原始网络在扩散动力学下所有时间尺度的动力学性质,使用这把铲子,人们可以更轻松的发掘大规模系统结构和动力学关系的巨大金矿。

我们的工作核心在于提出一套复杂网络粗粒化方案,该方案让我们在压缩网络尺寸的同时保留系统的信息动力学行为,在设计网络的粗粒化方案时,我们将会面临两个主要的挑战。首先,粗粒化必然会丢掉一些关于复杂网络本身的信息,而这里的原则和目的设计就是我们面临的第一道关卡,很多经典的复杂网络粗粒化方法的研究会倾向于选择尽可能保留网络的结构性质(例如度分布的无标度性质)。然而,正如前述所言,对许多复杂系统而言,运行在复杂网络结构上的信息动力学真正支撑着系统的功能,因此在网络粗粒化时,保留信息动力学行为将会更有利于我们分析原始网络的功能特性。

我们面临的第二个挑战是粗粒化方案的具体设计。当我们特定类型的网络上进行粗粒化时,或许我们可以根据网络的结构或动力学特性,从启发式的角度去进行设计和尝试。但我们如果想要的是一款针对不同类型的网络都有效的方案的时候,启发式设计将会失效。在面临这种高灵活性的要求时,我们选择利用机器学习方法,以数据驱动的方式,将网络粗粒化方案训练出来。

接下来,我们将首先介绍我们解决这两大挑战的核心思路,并分享一些实验成果,最后我们将深入机器学习算法,从可解释性的角度理解机器学到的粗粒化方案带给了我们哪些启发。

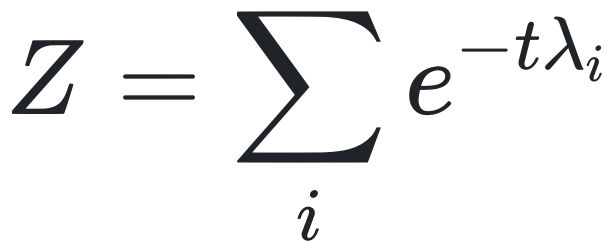

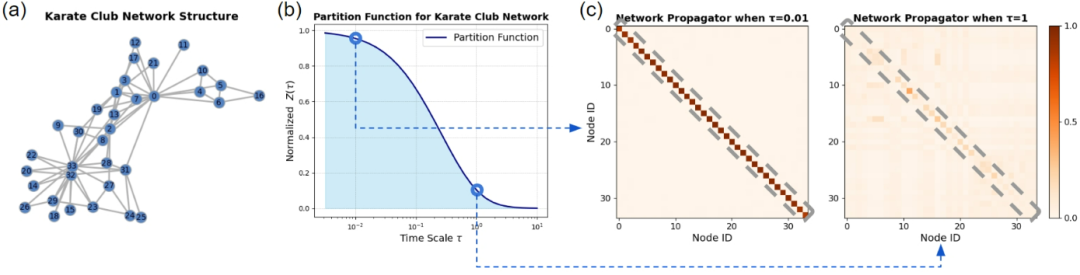

统计物理描述网络的信息动力学行为

统计物理描述网络的信息动力学行为

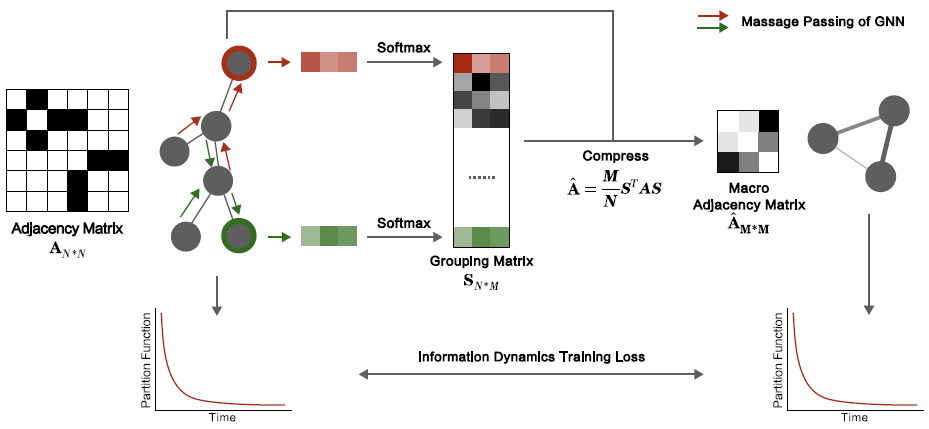

基于图神经网络的复杂网络粗粒化方案

基于图神经网络的复杂网络粗粒化方案

模型表现

模型表现

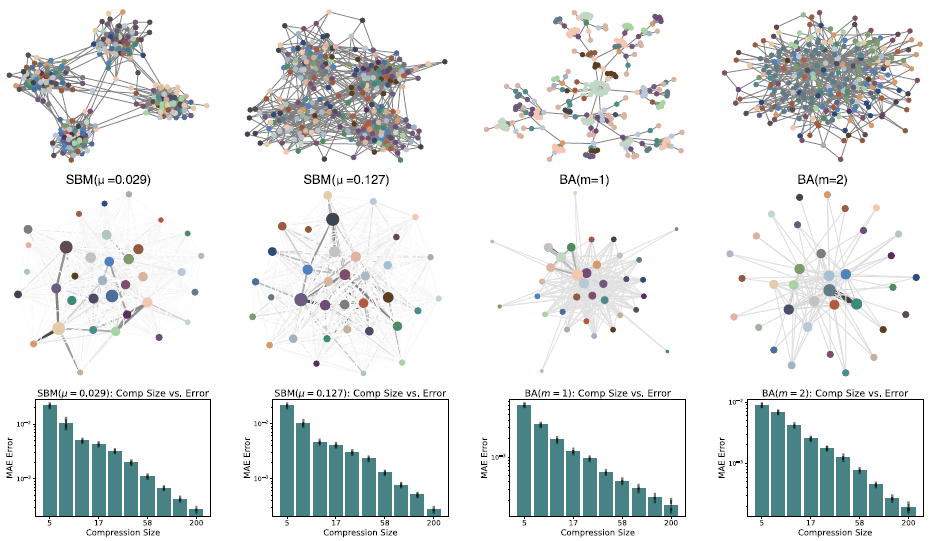

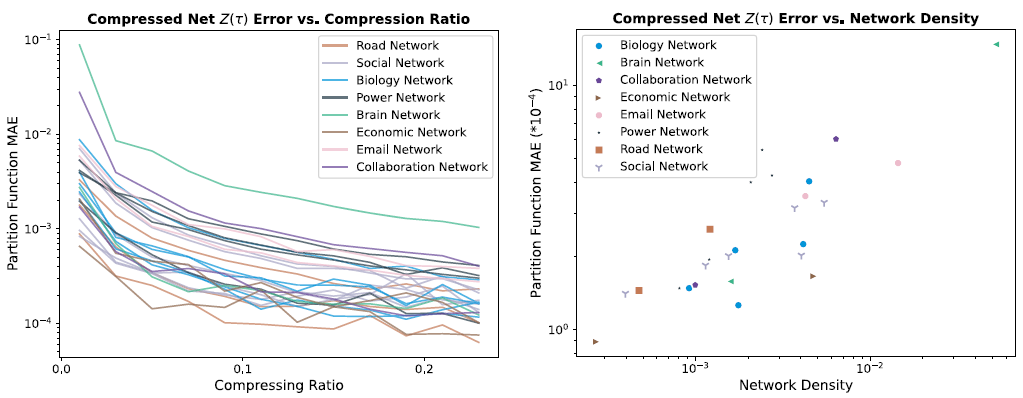

首先,我们发现模型很好的实现了我们的预定目标,即在粗粒化网络的同时保留配分函数,此外通过实验,我们还发现了很多模型的有趣性质。在这里与大家分享:

误差与规模之间的无尺度性质

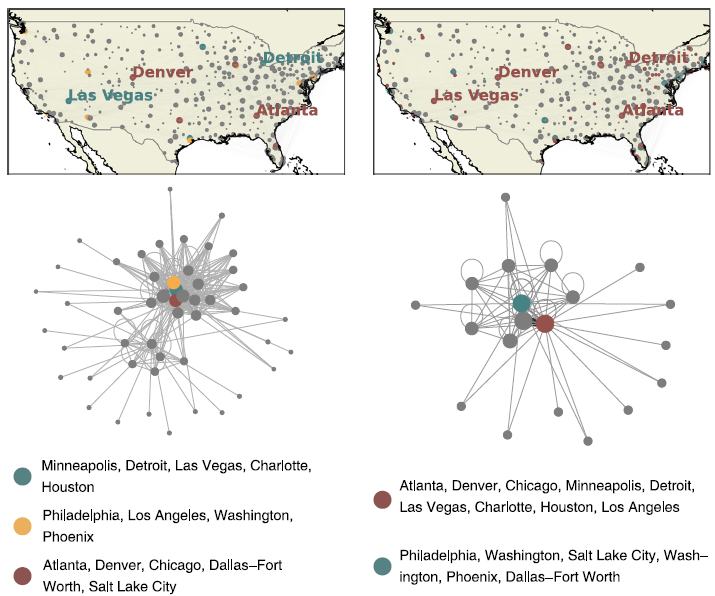

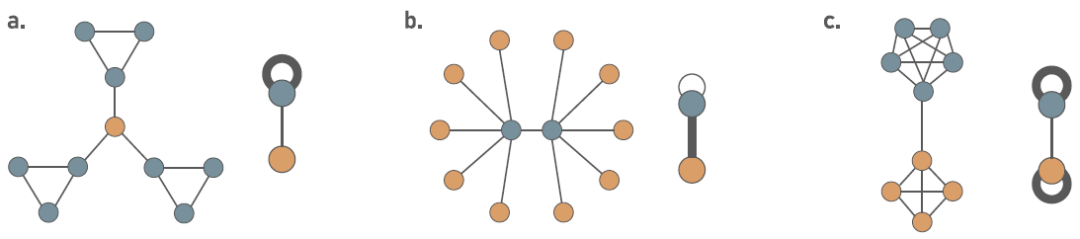

具有相似局部结构的节点将被粗粒化为相同超节点

模型可解释性探究

网络密度影响模型性能

总结

总结

这篇文章后续也会在复杂网络动力学读书会上由第一作者张章来做深入的解读分享。

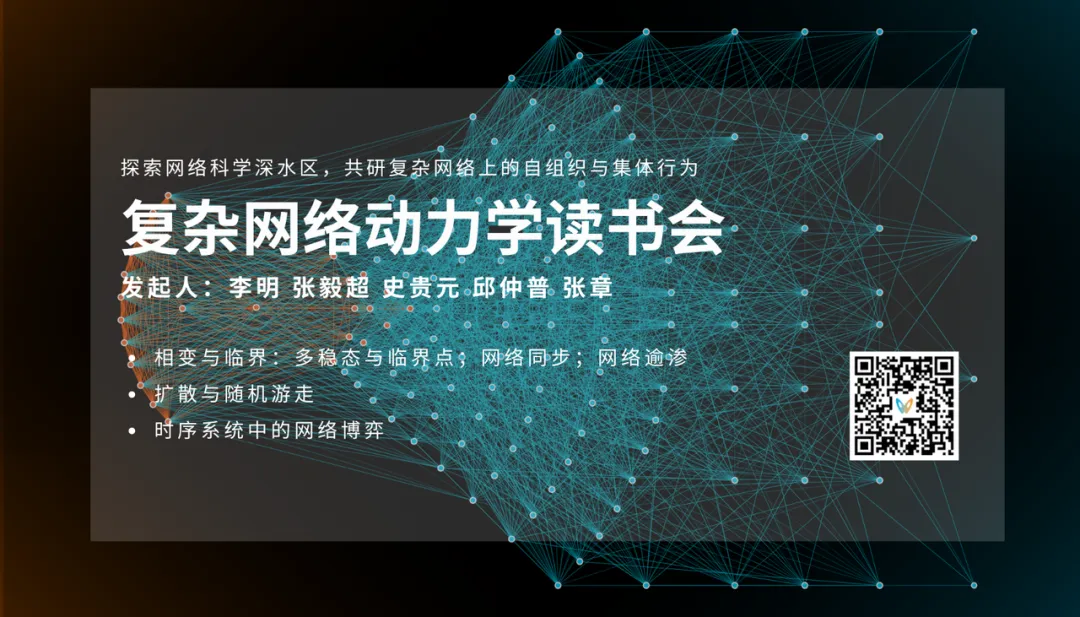

复杂网络动力学读书会

读书会计划从3月7日开始,每周五晚19:30-21:30进行,持续8-10周。诚挚邀请领域内研究者、寻求跨领域融合的研究者加入,共同探讨。

访问集智科学研究中心网站了解详情:www.research.swarma.org/research

6. 加入集智,一起复杂!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢