近日,Deepseek创始人梁文锋团队发布技术论文,提出“原生稀疏注意力”(Native Sparse Attention,NSA)算法。据悉,这是一种为硬件架构优化、支持端到端原生训练的稀疏注意力机制。NSA 的稀疏注意力机制,能让AI 能以更智能的方式阅读,仅聚焦于关键情节,自动忽略无关细节。就像阅读小说或文章时,人类会本能地抓住关键信息,跳过次要内容。论文提出将硬件优化与原生稀疏训练相结合的方法,是目前处理长序列 AI 任务最高效的解决方案之一。与传统的注意力模型不同,NSA 能与现代 AI 硬件良好配合,确保运行更快且不浪费资源。与许多仅关注推理的现有稀疏注意力方法不同,NSA 优化了整个 AI 训练过程,使其从头到尾更加高效。论文中介绍,NSA 算法比全注意力模型的运行速度快了11.6倍,能够更快速、更经济地处理长序列。论文标题:Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention

论文地址:https://arxiv.org/pdf/2502.11089NSA 技术的推出展现了 DeepSeek 在优化注意力机制方面的重大突破。他们不仅成功降低了大模型训练的算力门槛,更重要的是选择开源这项关键技术。NSA 的核心:

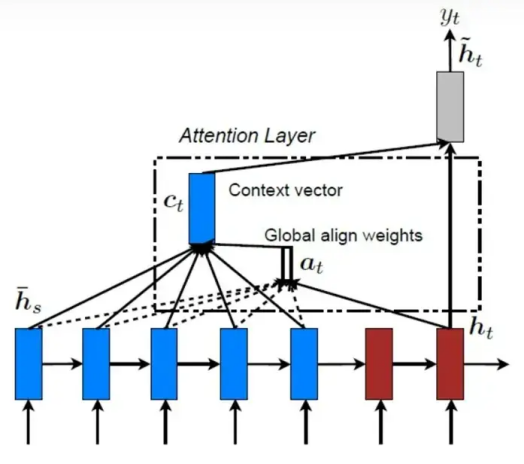

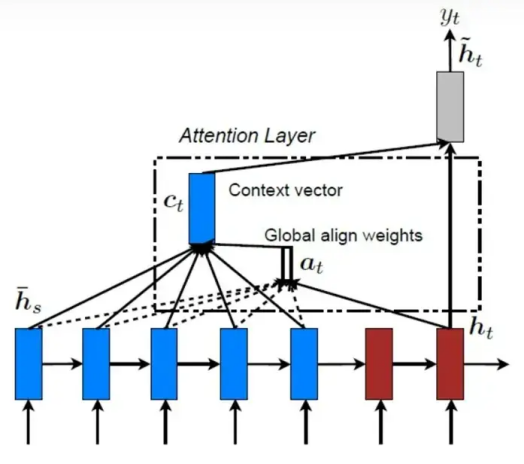

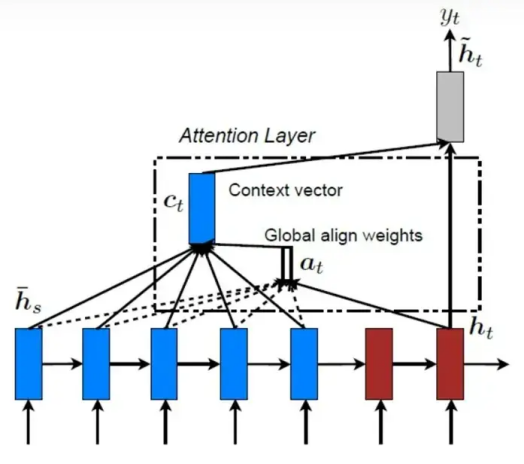

Transformer 模型是许多AI系统的核心架构,工作原理是处理由Tokens组成的信息序列,从而理解或生成文本。(注:Token可以是简短的单词或者完整的句子。)

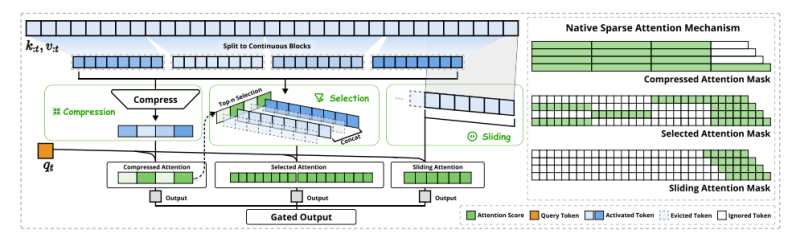

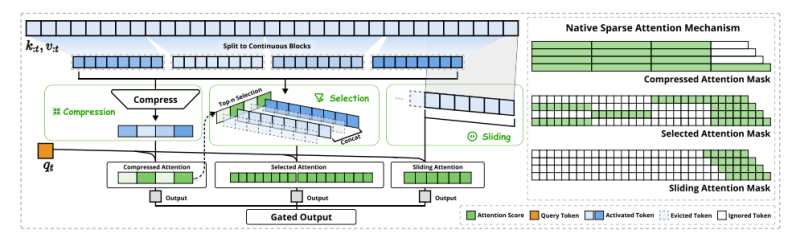

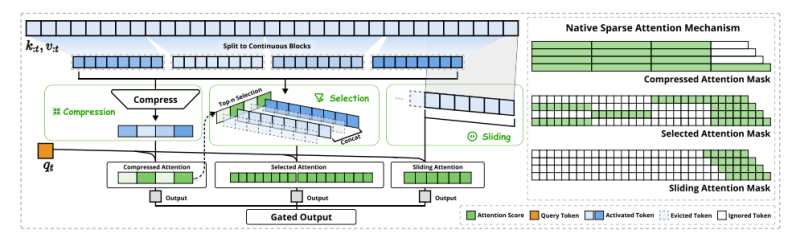

全局注意力(global attention)是 Transformer 理解能力的关键所在,它允许一个Token与其他所有Token进行“互动”。序列一旦变得越长,互动次数呈指数级增长,大大增加了计算复杂性。想象一下,你试图与房间里的每一个人分别进行对话。如果只有几个人,这是可以应对的。但随着人数的增加,很快就变得难以承受。NSA 巧妙地改变了我们处理注意力的方式。主要创新点有三:压缩注意力:可以把它想象成过滤掉一部分不重要的声音,只关注部分人的讲话。例如,我们可以设置规则,只听取每四个人中的一个人的声音,这样能减少计算负担,同时保留大致的信息。选择注意力:这一策略类似于只关注真正有价值的对话。在 NSA 算法中,会挑选出最相关的信息,而不是平均对待所有内容。比如,在一场聚会中,你可能会特别留意讲故事最精彩的人,而忽略那些闲聊的人。滑动注意力:这个方法类似于在房间里来回走动,逐个聆听不同的小团体对话。相比于全局关注,它更加灵活,可以确保模型不会错过局部的重要信息。NSA 的关键不在于单独使用某一种策略,而是结合三者的优点,以最有效的方式理解信息,就像一个经验丰富的听众能够从多个角度提炼关键信息一样。

图注:NSA架构总览。

如上所述,NSA 架构总览图的左侧显示,该框架通过三个并行的注意力分支来处理输入序列:对于每个查询位置,会以三种方式处理之前的键和值:另外,NSA架构总览图右侧展示了三个分支各自产生的不同注意力模式。其中绿色区域表示需要计算注意力得分的部分,白色区域则表示可以略过不计算的部分。除了三重注意力机制优化方案,论文还着重强调了NSA算法的两项创新:面向硬件的系统:通过块级稀疏注意力的优化来充分利用 Tensor Core,并提升内存访问效率,确保算术强度均衡。面向训练的设计:通过高效的算法与反向传播算子,保证端到端训练的稳定性。NSA的性能:

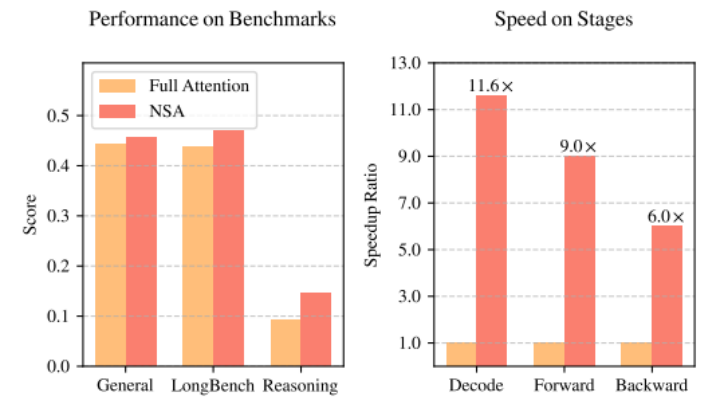

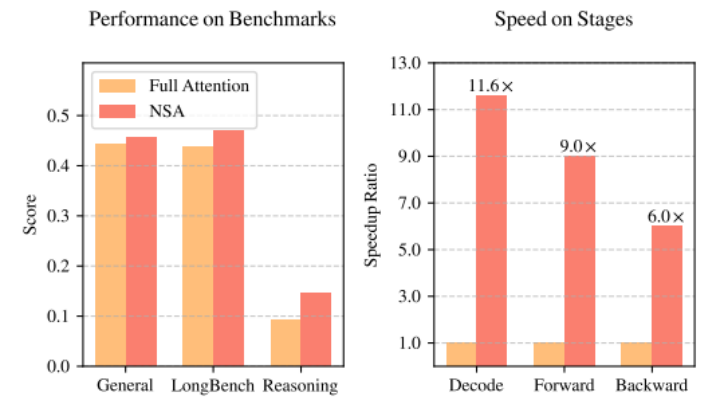

图注:全注意力模型和NSA的性能和效率比较

据论文介绍,NSA 算法比全注意力模型的运行速度快了11.6倍,能够更快速、更经济地处理包含64,000个token的长序列。不仅如此,NSA还提升了模型的准确性,大幅缩短了训练和实际应用所需的时间。

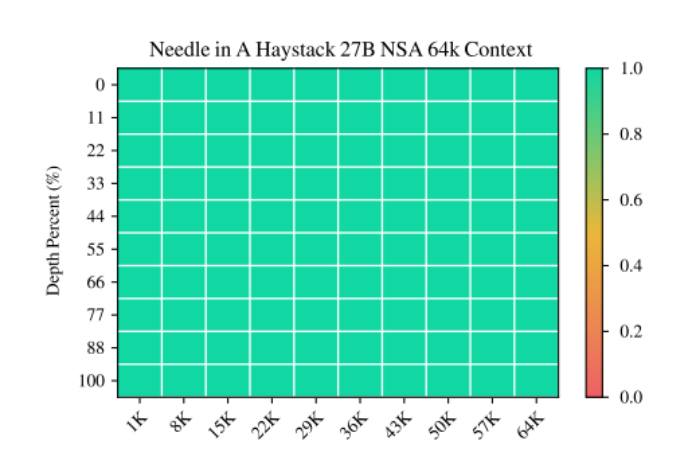

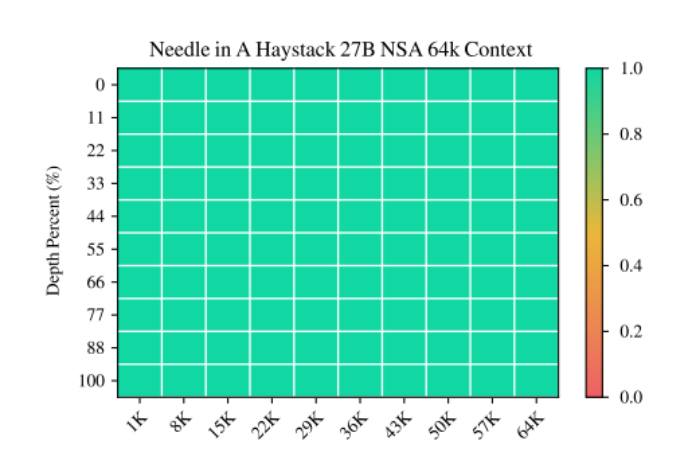

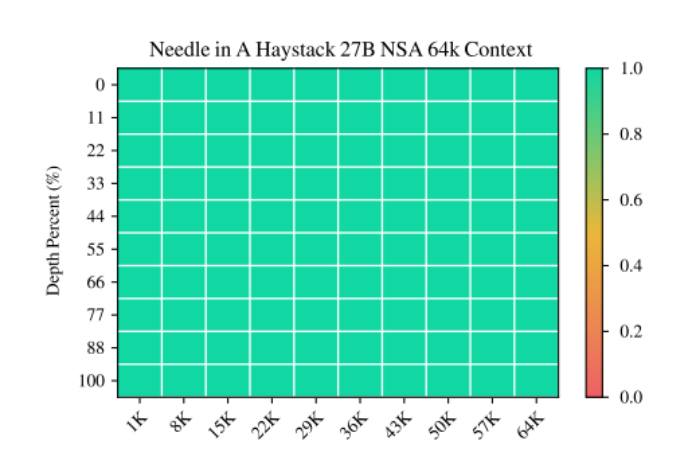

图注:在64k上下文长度的情况下,在不同上下文位置进行"大海捞针"式检索的准确率。NSA 通过其分层稀疏注意力设计实现了完美准确率。

此外,NSA与全注意力模型和其他稀疏注意力技术进行了对比测试。在计算量更少的情况下,NSA在推理能力和长文本处理的基准测试中表现不降反升。在长文本信息检索任务中,NSA更是取得了完美的准确率,证明了它能有效地从大规模数据中提取和利用信息。DeepSeek 的研究团队还指出,在处理长上下文时,注意力计算占总延迟的 70% 至 80%。他们表示,NSA 采用高效的稀疏注意力机制,旨在解决这一瓶颈,并与现代 AI 硬件高度兼容。许多现有的稀疏注意力方法虽然在理论上具有优势,但在实际应用中难以真正提升性能,而 NSA 从一开始就专为高效硬件适配而设计,并具备良好的可训练性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢