新智元报道

新智元报道

【新智元导读】Transformer论文八位作者之一Llion Jones创立的Sakana AI发布重磅成果——全球首个「AI CUDA工程师」!它能将PyTorch代码自动转换为高度优化的CUDA内核,速度比PyTorch原生实现快10-100倍。

论文地址:https://pub.sakana.ai/static/paper.pdf

CUDA调试异常繁琐,需要大量领域专业知识,有时候就像是炼金术; 奖励函数定义得非常清晰:数值正确性和执行时间; 进化周期很快,因为正确性检查很轻量,奖励评估也很简单; 可以进行完全并行化的搜索。

「AI CUDA工程师」:基于智能体的CUDA内核自动发现、优化、组合

CUDA是一个底层软件层,能够直接访问英伟达GPU的硬件指令集来进行并行计算。CUDA内核,则是使用CUDA语言编写的、在GPU上运行的函数。 通过在CUDA内核层面直接编写指令,我们能够显著提升AI算法的性能。 然而,使用CUDA需要扎实的GPU专业知识,而在实践中,大多数机器学习算法都是在PyTorch或JAX等更高层次的抽象层中编写的。

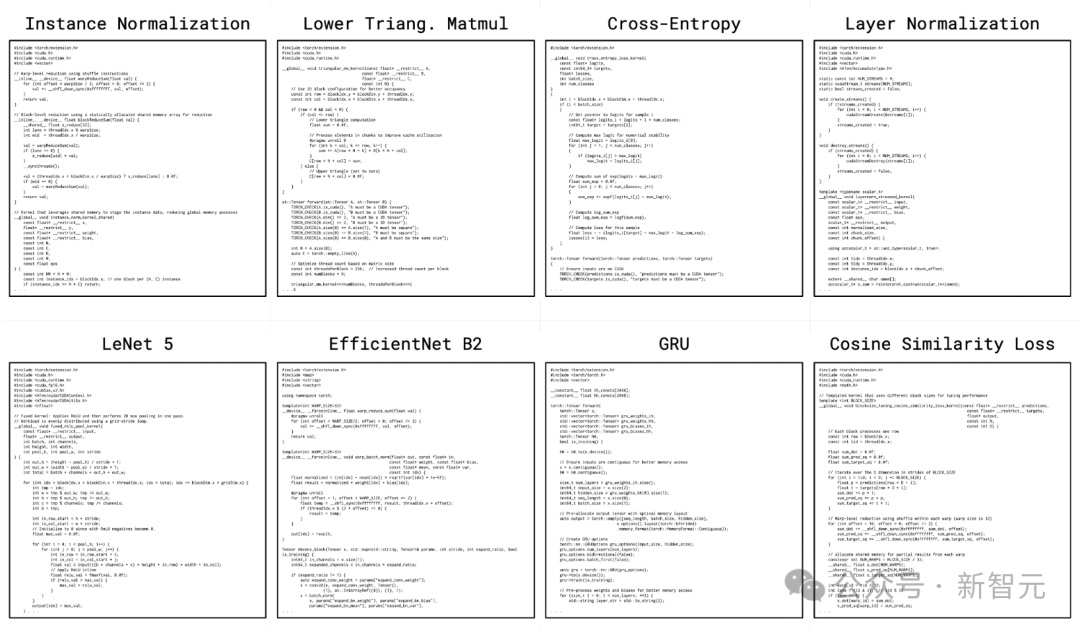

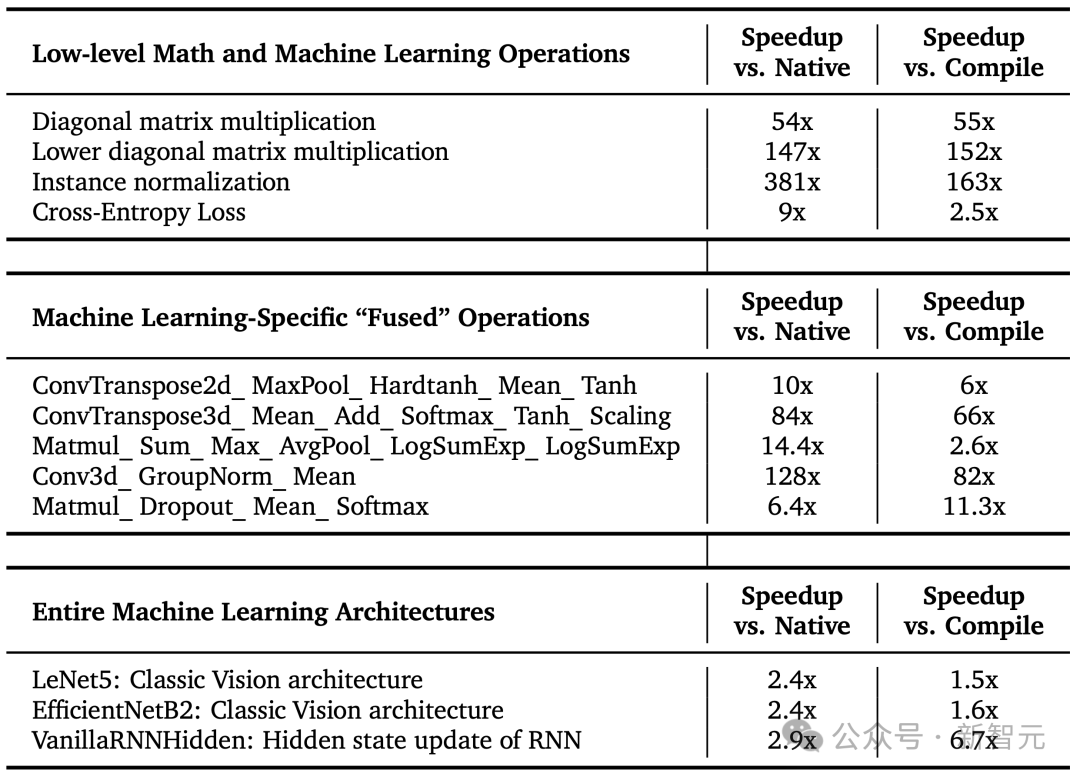

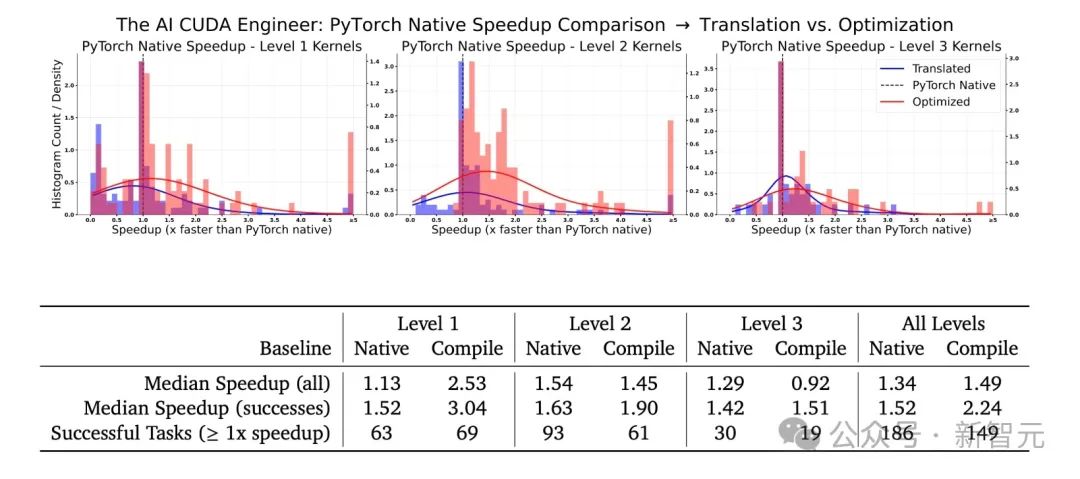

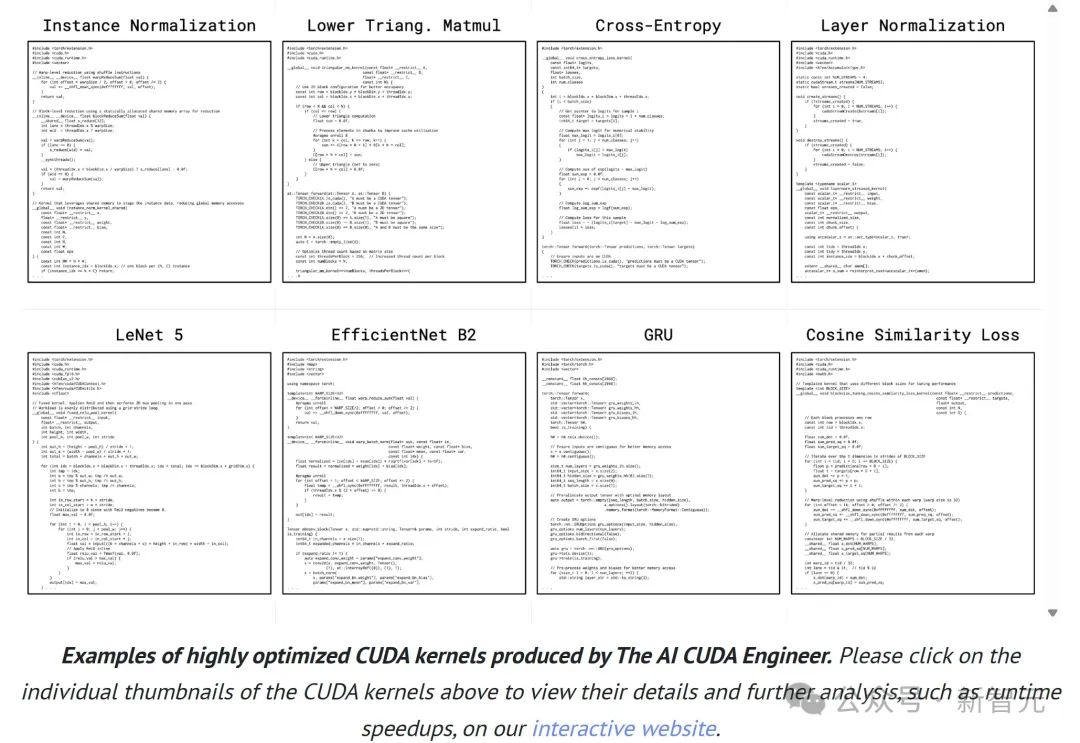

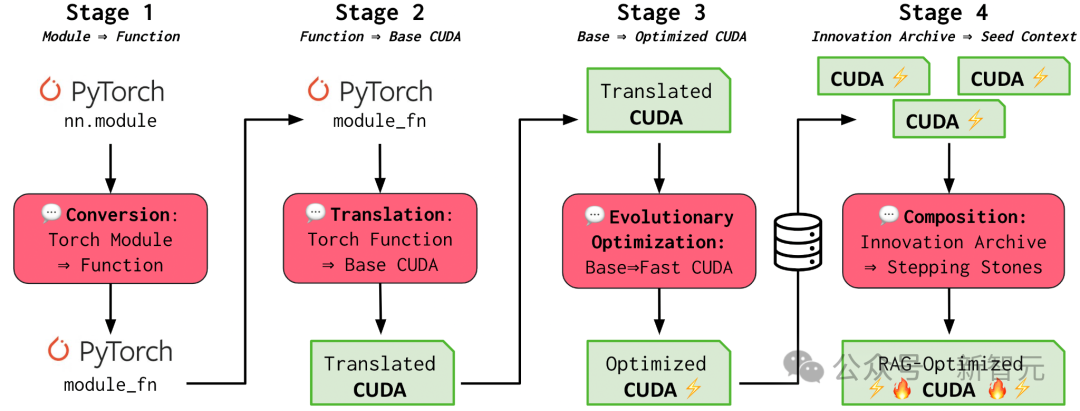

「AI CUDA工程师」是一个基于前沿LLM的AI智能体框架,目的是将标准PyTorch代码自动转换为高度优化的CUDA内核。 通过运用进化优化技术,并借鉴进化计算中的「交叉」操作和「创新档案」等概念来发现具有潜力的过渡性内核,研究人员提出的框架不仅能够自动将PyTorch模块转换为CUDA内核,而且他们的高度优化的CUDA内核通常能够实现显著的性能提升。 研究团队相信这项技术能够带来性能加速,从而加快LLM或其他生成式AI模型等基础大模型的训练和运行(推理)速度,最终让AI模型在英伟达GPU上运行得更快。 第1和第2阶段(转换和翻译):「AI CUDA工程师」首先将PyTorch代码转换为可运行的CUDA内核。即便在没有专门优化的情况下,它们就已经观察到初步的性能提升。

第3阶段(进化优化):借鉴生物进化中的适者生存法则,框架采用进化的方法来确保只保留最优秀的CUDA内核。同时,团队创新性地提出了内核交叉提示策略,能够将多个优化后的内核进行有效组合。

第4阶段(创新档案):正如文化通过千年的文明传承来塑造人类智慧一样,「AI CUDA工程师」也会利用在过往创新和发现中积累的经验,构建一个由高性能CUDA内核构成的创新档案库,并以这些积累的优化经验为基础,实现更进一步的转换和性能突破。

第1和第2阶段(转换和翻译):「AI CUDA工程师」首先将PyTorch代码转换为可运行的CUDA内核。即便在没有专门优化的情况下,它们就已经观察到初步的性能提升。

第3阶段(进化优化):借鉴生物进化中的适者生存法则,框架采用进化的方法来确保只保留最优秀的CUDA内核。同时,团队创新性地提出了内核交叉提示策略,能够将多个优化后的内核进行有效组合。

第4阶段(创新档案):正如文化通过千年的文明传承来塑造人类智慧一样,「AI CUDA工程师」也会利用在过往创新和发现中积累的经验,构建一个由高性能CUDA内核构成的创新档案库,并以这些积累的优化经验为基础,实现更进一步的转换和性能突破。

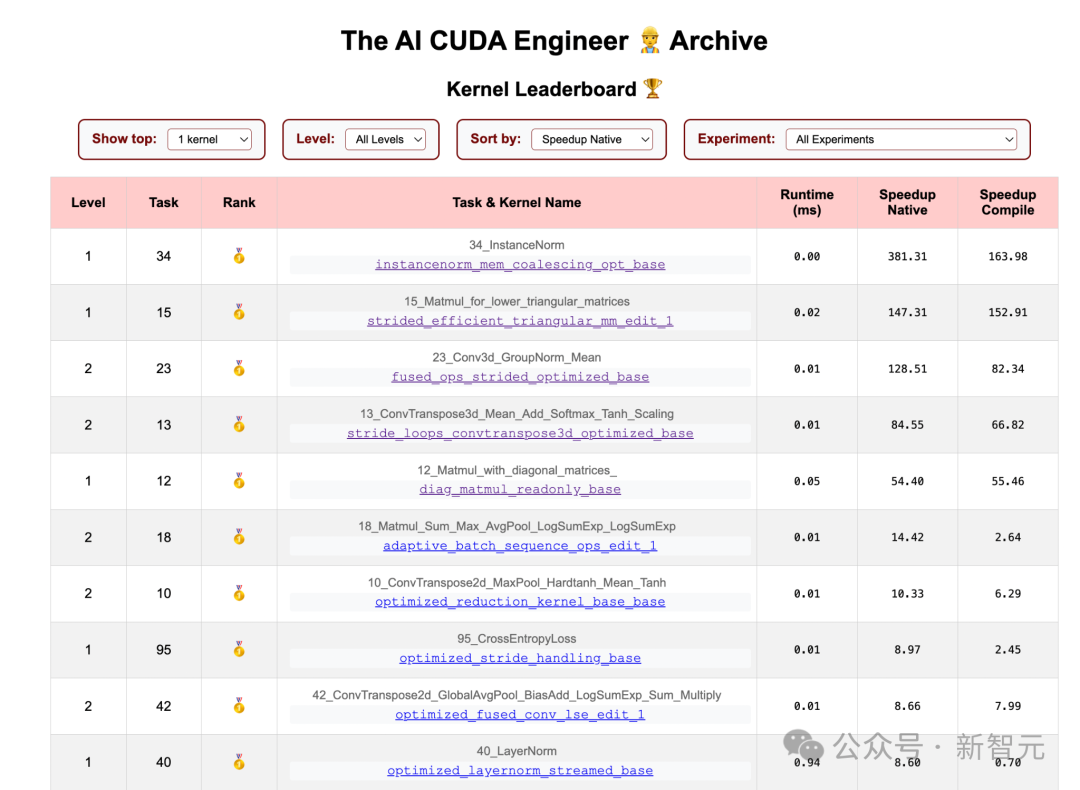

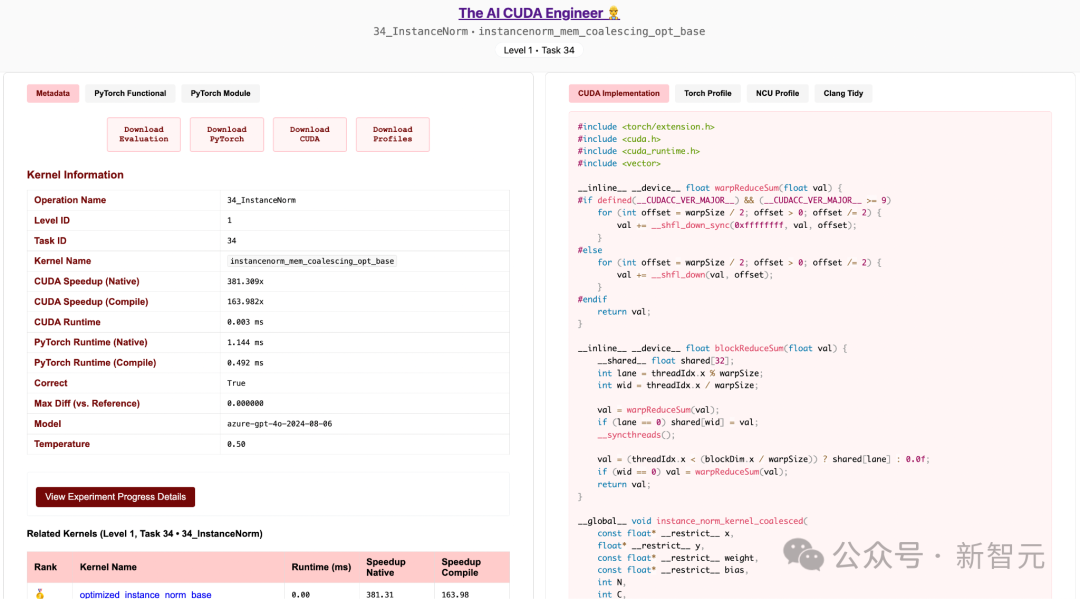

提升内核运行速度

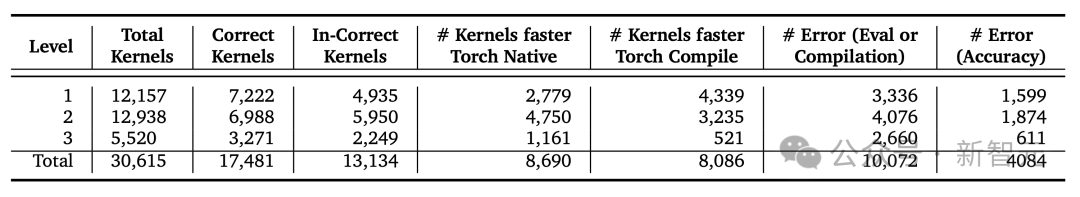

17,000+个已验证CUDA内核数据集

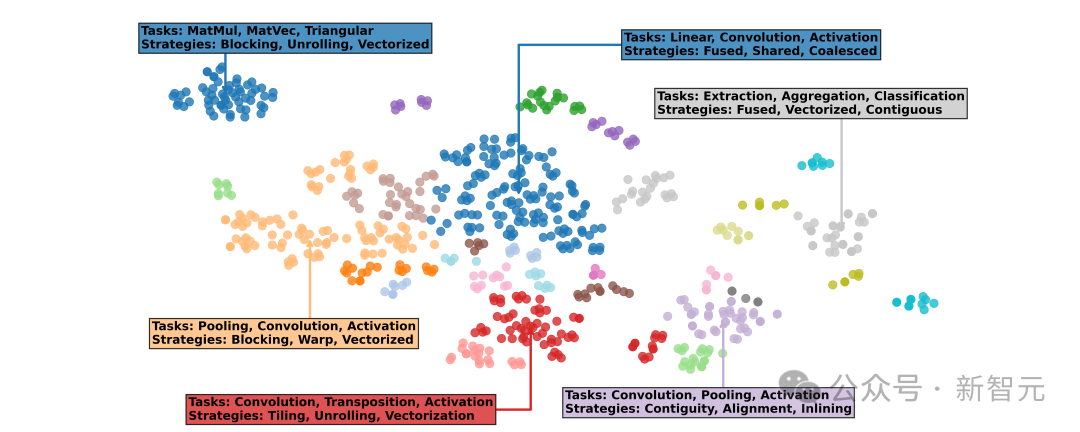

探索内核资料库

AI革命才刚刚起步

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢