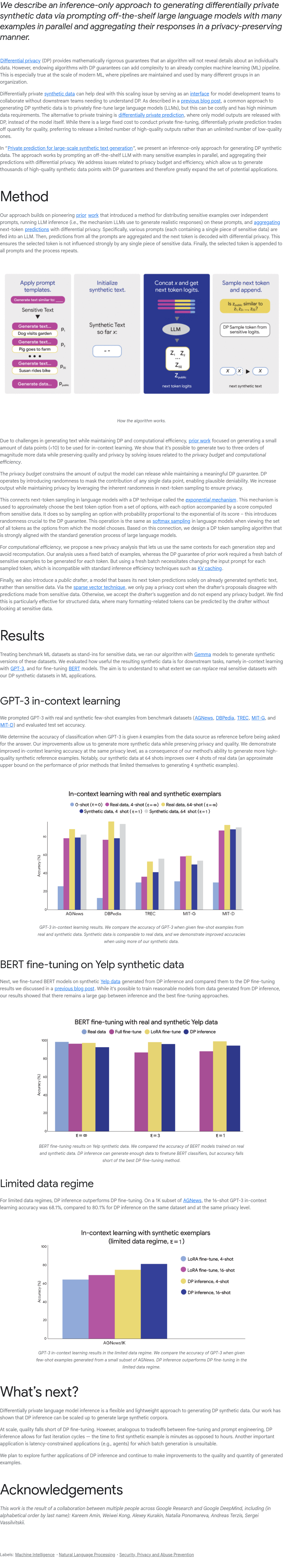

本文提出了一种仅基于推理的方法,通过并行提示现成的大型语言模型(LLMs)生成差分隐私(DP)合成数据,并以保护隐私的方式聚合其响应。差分隐私提供严格的数学保证,确保算法不会泄露个人数据细节,但为算法添加DP保障会增加机器学习(ML)管道的复杂性,尤其在现代大规模ML环境中更为显著。DP合成数据可通过充当接口解决这一扩展问题,使下游团队无需了解DP即可与模型开发团队协作。传统方法通常依赖于对LLMs进行私有微调以生成DP合成数据,但这成本较高且复杂。而本文方法利用LLMs的推理能力,在减少成本和复杂性的同时,实现了高效、隐私保护的合成数据生成。这种方法为大规模ML环境下的隐私保护提供了新思路。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢