关键词:机器人操纵; 视觉-语言-动作大模型

导 读

本文是对发表于计算机人工智能领域顶级会议 CVPR 2025 的论文 CrayonRobo: Object-Centric Prompt-Driven Vision-Language-Action Model for Robotic Manipulation 的解读。该论文由北京大学董豪课题组完成,第一作者为李晓琦。

本文提出了一种新颖的方法,利用全面的多模态提示,以直观的方式明确传达低级动作和高级规划。本文同时设计了一种训练策略,使模型能够理解 2D 视觉-语言提示,并预测精确的接触姿态及运动方向,从而确保任务执行的可靠性。这种可被模型理解的提示在已见任务和未见任务上均表现出色,展现了其强大的鲁棒性。

项目主页:

https://sites.google.com/view/crayonrobo

01

背 景

作为人类的贴心助手,机器人必须理解并成功执行人类所需的任务。为了向机器人传达其应完成的目标,存在多种方法,例如语言描述、目标图像或目标视频。

语言指令要么较为简短且存在歧义,使得机器人难以准确理解任务,要么过于详细,从而增加模型执行的难度。目标图像虽然能提供准确的目标,但通常包含过度与任务无关的额外信息,例如背景元素和非交互对象。一些方法使用人类演示视频或生成的视频逐步描述任务。然而,模型编码人类演示视频的过程较为繁琐,而生成视频的质量对任务执行的效果有很大影响。

因此,我们想,是否有一种方法能够精确且无冗余地传达目标,同时清晰地表达末端执行器的动作?

02

方 法

我们提出了 Crayon-Robo,这是一种可在图像上自动生成或手绘蜡笔风格的视觉提示,以有效地表示关键帧序列中的低级动作和高级规划。

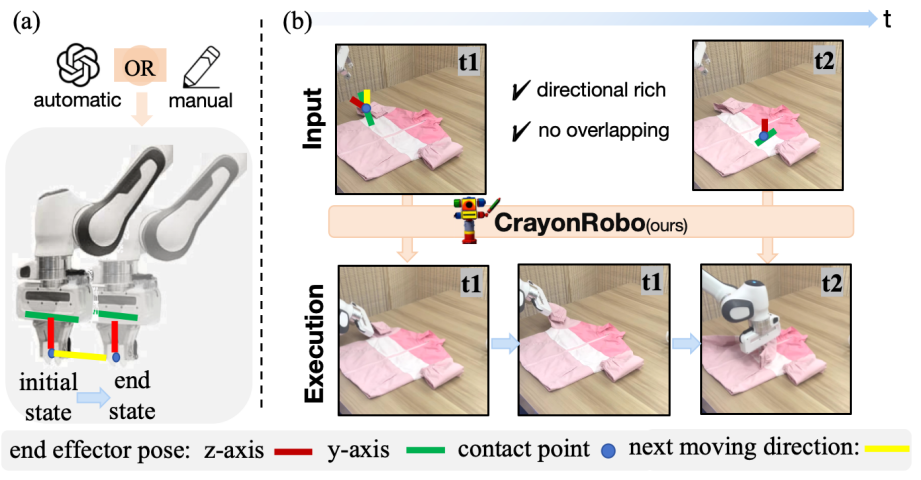

图1

如图 1(a) 所示,这些提示包括接触点、末端执行器的 Z 轴方向、末端执行器的 Y 轴方向以及接触后的下一步移动方向,用于传达与物体交互的方式和位置。

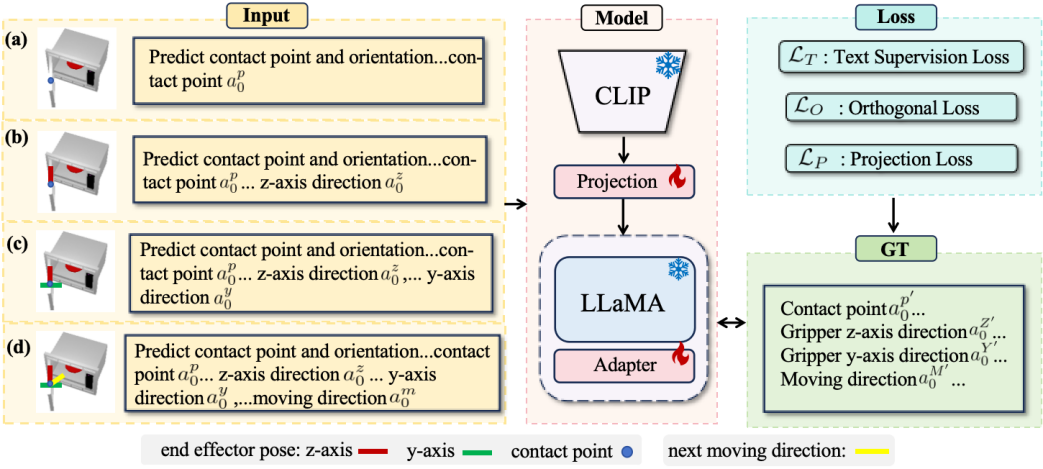

此外,如图 2 所示,我们进一步设计了一种训练策略和监督目标,以逐步增强模型对各类提示的理解能力,使其能够准确预测 SE(3) 接触姿态及接触后的 3D 运动方向,从而顺利完成各个子目标任务。具体而言,为了提升模型对不同提示的理解,我们构建了一系列视觉-文本输入对,逐步传递不同层次的信息。这种渐进式学习 机制使模型能够深入掌握每个组件的物理意义。此外,我们提出了三种损失函数(loss)以确保模型的预测质量:任务目标约束保证模型能够输出符合预期模式的预测;旋转分量正交性约束确保旋转矩阵的正交性质,提高姿态估计的准确性;2D-3D 投影一致性约束保证预测结果在 2D 视角和 3D 空间中保持一致性。

图2

在推理阶段,我们使用关键帧序列作为输入,以表达任务规划过程。每张图像都包含蜡笔风格的视觉提示,用于指示其关键帧任务目标。图 1(b) 展示了我们如何利用带有蜡笔风格视觉提示的图像序列来表达关键帧步骤,每个步骤都说明了所需的低级任务目标,例如 t1-抓取(pick)、t2-放置(place)。基于输入的目标提示,模型确定 6DoF 接触姿态,使其能够按照要求与物体交互。当存在黄色提示时,模型还会预测 3D 运动方向,以指导接触后的移动,例如在 t1 中向上抓取(pick)。对于简单步骤(如 t2-place),则无需提供接触后的移动方向。我们利用预测的 3D 运动方向将各个步骤顺序连接,从而完成整个长时序任务。

03

实验验证

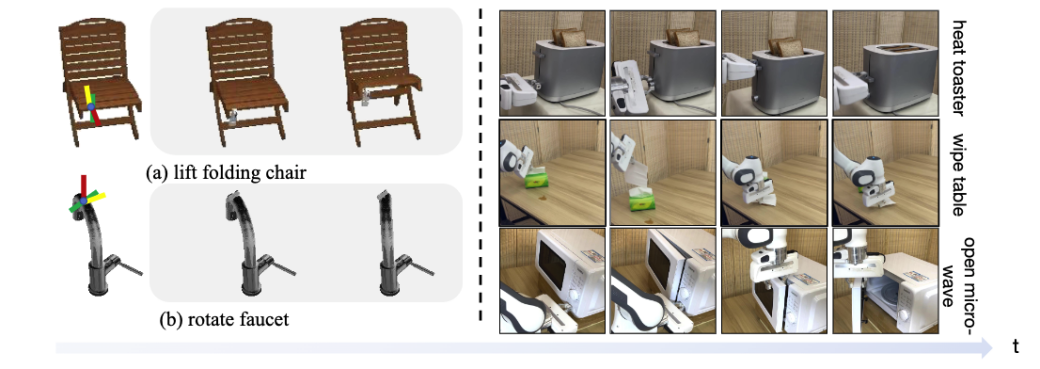

图3

我们在 SAPIEN 模拟器的 30 个任务上验证了该方法的有效性。尤其是在全新任务上,我们的方法相较于以往的 SOTA 提高了 20%。这种显著提升源于模型对视觉提示的理解能力,因为它能够直接解析提示所表达的任务需求,而无需依赖以往任务的经验来推测执行动作,从而展现出更强的泛化能力。图 3 的左侧展示了两个模拟器中的任务,提起来折叠椅和旋转水龙头。

同时我们还在真实世界中,进行了 zero-shot 的实验,证明方法的泛化性。实验表明,我们的方法依旧展现出在真实世界中很强的能力,可以很好的理解所需执行的动作,并预测出准确的位姿。图 3 的右侧展示了模型在真实世界中的执行过程。

叠衣服

擦桌子

烤吐司

04

总 结

本文提出了一种新颖的方法,利用全面的多模态提示,以直观的方式明确传达低级动作和高级规划。本文同时设计了一种训练策略,使模型能够理解 2D 视觉-语言提示,并预测精确的接触姿态及运动方向,从而确保任务执行的可靠性。这种可被模型理解的提示在已见任务和未见任务上均表现出色,展现了其强大的鲁棒性。

PKU-Agibot Lab

PKU-Agibot Lab 由北京大学前沿计算研究中心董豪助理教授领导,该科研团队专注于机器人视觉,物体操作,语义导航和具身自主决策等领域的前沿技术,致力于为工业应用和家用场景创建具有成本效益的人形机器人。

实验室 PI 简介:董豪 助理教授

董豪课题组相关新闻:#PKU-Agibot Lab

扫码浏览实验室主页

https://zsdonghao.github.io/

图文 | 李晓琦

PKU-Agibot Lab

PKU-Agibot Lab 近期科研动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转项目主页

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢