关键词:量子优化算法; 非凸优化; 鲁棒性

导 读

本文是发表于计算机人工智能领域顶级会议 ICLR 2025 的论文 Robustness of Quantum Algorithms for Nonconvex Optimization 的详细解读。该项工作由北京大学李彤阳课题组完成,论文的共同第一作者是哈佛大学的龚维元与斯坦福大学的张辰逸。

论文系统地研究了带噪声的非凸优化量子算法,证明了对于不同的参数空间,量子非凸优化量子算法分别能够以多对数、多项式或指数级的查询次数,找到近似局部最优解。同时,我们用信息论证明,存在一个参数空间,即使允许无限次查询,也无法找到近似局部最优解。此外,在某些设定下,我们进一步建立了经典算法的查询复杂度下界,并设计了相应的量子算法,其在查询复杂度上相较于经典下界或当前最先进的经典算法实现了多项式或指数级的加速。

↑扫码跳转

论文链接:

https://arxiv.org/abs/2212.02548

01

引 言

现有理论研究表明,量子计算机在解决诸多优化问题(如线性规划、半正定规划、凸优化、非凸优化等)方面具有潜在优势。衡量量子优化算法的一个关键方面是其鲁棒性。一方面,当前的量子设备存在硬件噪声,在最坏情况下,这些噪声可能呈对抗性,从而抵消量子算法的优势。另一方面,经典优化问题中固有的噪声同样对算法的鲁棒性提出了挑战。例如,在统计机器学习中,目标函数通常是多个子函数的统计平均,而优化算法往往只能访问子函数的信息,而无法直接获取目标函数的精确值,因此只能对其进行有误差的估计。

在从理论角度分析有噪声的非凸优化问题时,现有的一系列优化理论文献提出了以下模型:尽管算法无法直接获取光滑目标函数

02

问题设定

给定一个

我们的目标是逃离鞍点并找到 满足如下条件的一个

模型1:函数值的有噪声估计

存在一个与

存在一个与

03

理论结果

在本文中,我们系统地研究了带噪声的非凸优化量子算法。在模型1和模型2中,我们识别并分析了不同的参数空间,量子算法在这些空间中分别能够以多对数、多项式或指数级的查询次数,找到

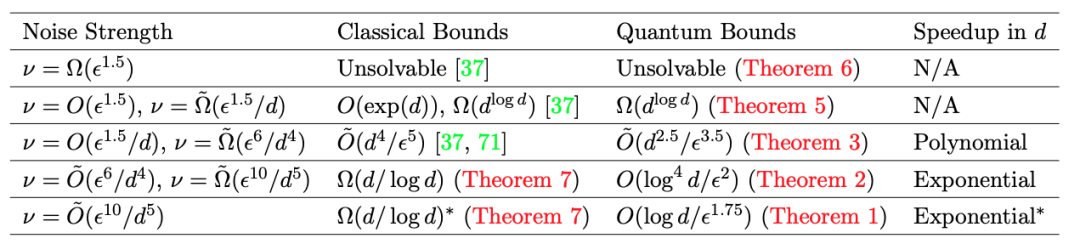

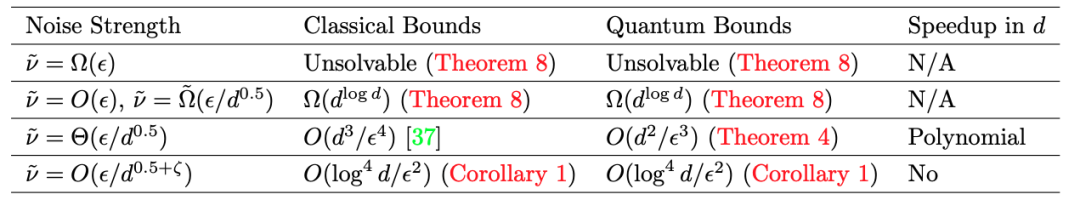

在某些设定下,我们进一步建立了经典算法的查询复杂度下界,并设计了相应的量子算法,其在查询复杂度上相较于经典下界或当前最先进的经典算法实现了多项式或指数级的加速。我们在表1和表2中分别汇总了模型1和模型2下的主要结果。

表1. 模型1中的主要结果,以及与当前最先进的经典算法上界和下界的对比。查询复杂度以维度

表2. 模型2中的主要结果,以及与当前最先进的经典算法上界和下界的对比。查询复杂度以维度

04

算法设计

接下来,我们简要介绍模型1下针对不同噪声层级的算法设计思路。

微小噪声:扰动加速梯度下降的鲁棒性

已有研究[1]表明,当梯度存在误差时,扰动加速梯度下降算法(PAGD)[2, 3]的性能仍然得以保持。我们严格证明了,结合 Jordan 提出的量子梯度估计算法[4],算法[3]在函数值量子黑盒存在微小噪声

较小噪声:量子梯度估计的鲁棒性

当噪声强度增大时,扰动加速梯度下降(PAGD)中的负曲率估计部分将失效。在这种情况下,我们展示了结合量子梯度估计的扰动梯度下降算法对噪声的鲁棒性。已有文献[5, 6]从概念层面指出,结合 Jordan 提出的梯度估计方法[4]的扰动梯度下降算法(PGD)[7]对噪声具有一定的鲁棒性。在本文中我们证明,在函数值量子黑盒存在较小噪声

中等噪声:基于量子均值估计的加速

当噪声强度进一步增加到

05

复杂度下界的构造

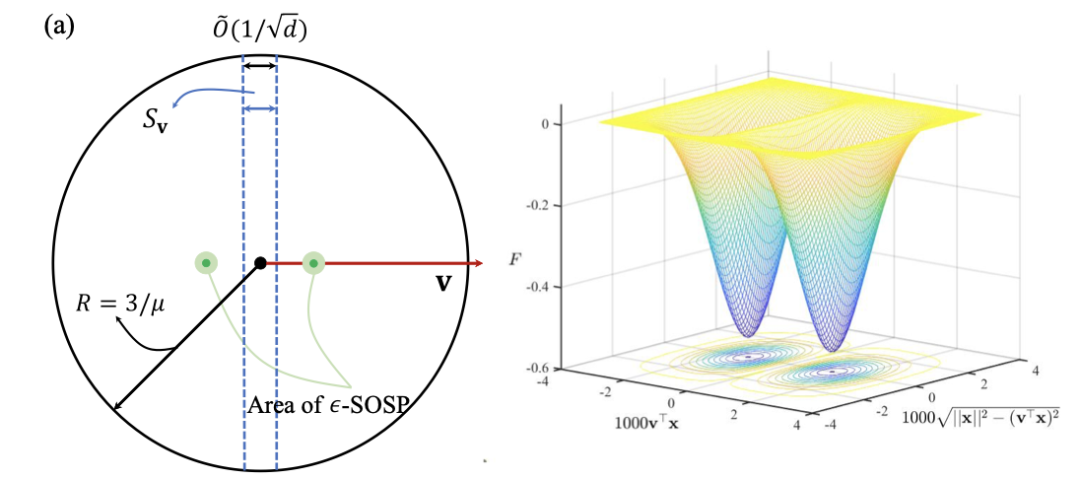

接下来,我们简要介绍模型1下针对较大噪声层级的复杂度下界构造思路。我们借鉴文献[8]的方法构造了一个困难实例(图1):我们在一个超立方体内定义目标函数

在噪声较大,达到

图1. 困难实例的表示图

如果噪声强度继续增加到

06

开放性问题

我们的工作引出了若干值得进一步探讨的开放问题:

(1)是否可以设计更高效的量子算法,用于解决在带噪声量子黑盒模型下的非凸优化问题?例如,能否在维度

(2)是否可以建立更紧的量子查询下界以刻画非凸优化问题的复杂度?尤其是,对于一般的优化问题(无论使用无噪声还是带噪声的量子黑盒),是否可以建立在维度

(3)本文采用了一种简化的噪声模型,仅考虑了噪声强度的上界。更一般地,是否可以在更复杂的噪声假设下(例如,更贴近实际的量子噪声模型或随机噪声模型)从理论上分析非凸优化算法的鲁棒性与加速性,或通过数值模拟甚至在实际量子设备上进行验证?

参考文献

[1]. Hualin Zhang, and Bin Gu. Faster gradient-free methods for escaping saddle points. The Eleventh International Conference on Learning Representations, 2022

[2]. Chi Jin, Praneeth Netrapalli, and Michael I. Jordan, Accelerated gradient descent escapes saddle points faster than gradient descent, Conference on Learning Theory, pp. 1042–1085, 2018

[3]. Chenyi Zhang and Tongyang Li, Escape saddle points by a simple gradient-descent based algorithm, Advances in Neural Information Processing Systems 34, 2021

[4]. Stephen P. Jordan, Fast quantum algorithm for numerical gradient estimation, Physical Review Letters 95, 2005

[5]. Shouvanik Chakrabarti, Andrew M. Childs, Tongyang Li, and Xiaodi Wu, Quantum algorithms and lower bounds for convex optimization, Quantum 4, 2020

[6]. Chenyi Zhang, Jiaqi Leng, and Tongyang Li, Quantum algorithms for escaping from saddle points, Quantum 5, 2021

[7]. Chi Jin, Praneeth Netrapalli, Rong Ge, Sham M. Kakade, and Michael I Jordan, On nonconvex optimization for machine learning: Gradients, stochasticity, and saddle points, Journal of the ACM (JACM) 68, 2021

[8]. Chi Jin, Lydia T. Liu, Rong Ge, and Michael I. Jordan, On the local minima of the empirical risk, Advances in Neural Information Processing Systems, vol. 31, 2018

[9]. John C. Duchi, Michael I. Jordan, Martin J. Wainwright, and Andre Wibisono, Optimal rates for zero-order convex optimization: The power of two function evaluations, IEEE Transactions on Information Theory 61, 2015

图文 | 张辰逸 龚维元

PKU QUARK Lab

关于量子算法实验室

量子算法实验室 QUARK Lab (Laboratory for Quantum Algorithms: Theory and Practice) 由李彤阳博士于2021年创立。该实验室专注于研究量子计算机上的算法,主要探讨机器学习、优化、统计学、数论、图论等方向的量子算法及其相对于经典计算的量子加速;也包括近期 NISQ (Noisy, Intermediate-Scale Quantum Computers) 量子计算机上的量子算法。

实验室新闻:#PKU QUARK

实验室公众号:

课题组近期动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文链接

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢