行业动态

1. 真「AI抢饭碗」,国外大厂CEO不招人了

2. Meta 高管否认人为提高 Llama 4 的基准测试成绩

3. 白宫:各机构需在 6 个月内消除 AI 应用障碍

4. IBM 发布新一代大型机 IBM z17

5. 联合国警告称,AI 将影响全球 40% 就业岗位

热门论文

1. UC 伯克利宋晓冬教授团队:揭露 LLM API 中的模型替换

2. 通过测试时训练生成一分钟视频

3. 港中文、腾讯团队提出 TransMamba:灵活切换 Transformer 和 Mamba

4. 保卫 agent!芝加哥大学李博团队提出 ShieldAgent

Shopify 首席执行官 Tobi Lutke 正在改变公司在 AI 时代的招聘方式。他在一份备忘录中告诉公司员工,他们必须证明某些工作无法由 AI 完成,然后才能要求增加员工数量和资源。他表示,Shopify 对员工在日常工作中使用 AI 抱有“基本期望”,并表示对于那些使用 AI 的人来说,可以实现生产力倍增。“我看到许多人通过对 AI 的反思和巧妙运用,完成了 100 倍的工作,这些任务是我们以前甚至不会选择去解决的。”

Meta 生成式 AI 副总裁 Ahmad Al-Dahle 在 X 上发表文章称,Meta 在“测试集”上训练 Llama 4 Maverick 和 Llama 4 Scout 模型的说法“根本不属实”。此前,X 和 Reddit 上开始流传一则未经证实的谣言,称 Meta 人为提高了其新模型的基准成绩。

3.白宫:各机构需在 6 个月内消除 AI 应用障碍

白宫周一表示,将命令联邦机构任命首席人工智能官,并制定扩大政府使用 AI 的战略,取消拜登旨在对该技术实施保障措施的命令。管理和预算办公室指示政府机构在 6 个月内对 AI 的高影响用途实施最低风险管理实践,并制定一项生成式 AI 政策,以确定和消除他们负责任地使用 AI 的障碍,并提高企业范围内应用程序成熟度。

4.IBM 发布新一代大型机 IBM z17

为加速 AI 的落地应用,IBM 发布了新一代大型机 IBM z17。该主机采用 IBM Telum II 处理器,支持超过 250 个 AI 用例,包括 AI agent 和生成式 AI。相比前代产品,z17 的性能提升了 50%,并支持 48 个 IBM Spyre AI 加速芯片,未来可扩展至 96 个。此外,IBM z17 也更加节能。

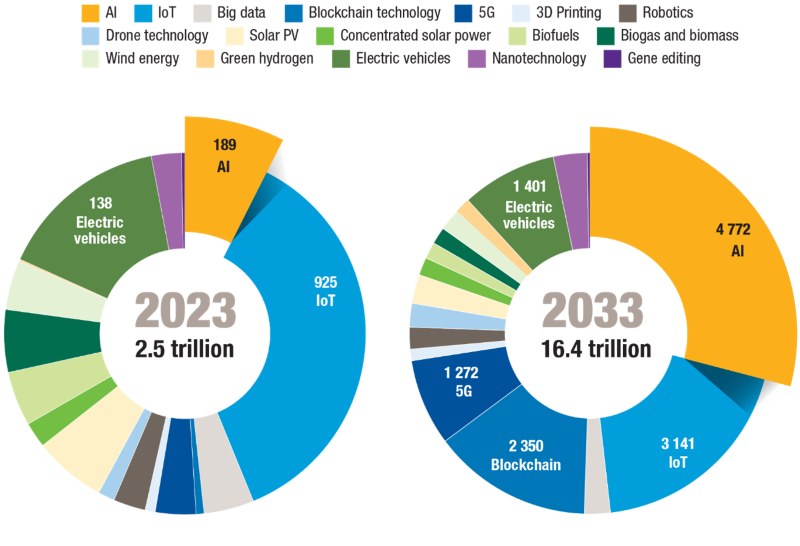

5.联合国警告称,AI 将影响全球 40% 就业岗位

在《2025年技术与创新报告》中,联合国贸易和发展会议(UNCTAD)指出,人工智能市场预计将达到 4.8 万亿美元,但其收益高度集中;全球多达 40% 的就业岗位受到影响;只有不到 1/3 的发展中国家制定了人工智能战略;118个国家在人工智能治理方面缺乏代表性,限制了全球包容性;发展中经济体必须投资于人工智能基础设施、数据和技能,以充分利用其潜力。

热门论文

1. UC 伯克利宋晓冬教授团队:揭露 LLM API 中的模型替换

通过黑盒 API 访问的大语言模型(LLM)的激增带来了巨大的信任挑战:用户根据宣传的模型能力(如大小、性能)支付服务费用,但提供商可能会暗中用更便宜、质量更低的替代品来替代指定的模型,以降低运营成本。这种缺乏透明度的做法破坏了公平性,削弱了信任度,并使可靠的基准测试变得更加复杂。由于黑箱性质,检测这种替换非常困难,通常仅限于输入输出查询。

在这项工作中,加州大学伯克利分校 Dawn Song(宋晓冬)教授团队正式提出了 LLM API 中的模型替换检测问题。他们系统地评估了现有的验证技术,包括基于输出的统计测试、基准评估和日志概率分析,以及模型量化、随机替换和基准规避等各种现实攻击场景下的验证技术。他们揭示了仅依赖文本输出的方法的局限性,尤其是在应对微妙或自适应攻击时。虽然对数概率分析在可用时能提供更强的保证,但其可用性往往受到限制。最后,他们讨论了基于硬件的解决方案(如可信执行环境 TEE)作为实现可证明模型完整性的途径的潜力,并强调了安全性、性能和提供商采用之间的权衡。

由于自注意力层对于长上下文来说效率低下,如今的 Transformers 仍然难以生成一分钟的视频。而 Mamba 层等替代层在处理复杂的多场景故事时也表现一般,因为它们的隐藏状态表现力较差。

在这项工作中,来自加州大学伯克利分校、斯坦福大学和英伟达的研究团队及其合作者尝试使用测试时训练(TTT)层,其隐藏状态本身可以是神经网络,因此更具表现力。将 TTT 层添加到预训练 Transformer 中,它就能根据文本故事板生成一分钟的视频。为了验证这一概念,他们制作了一个基于汤姆和杰瑞动画片的数据集。与 Mamba-2、Gated DeltaNet 和滑动窗口注意力层等基线相比,TTT 层生成的视频更加连贯,能够讲述复杂的故事,在对每种方法生成的 100 个视频进行的人工评估中,TTT 层以 34 个 Elo 点实现领先。

尽管潜力很大,但结果中仍有人工痕迹,这可能是由于预训练的 5B 模型能力有限。实施效率也有待提高。研究团队表示,由于资源限制,他们只对一分钟的视频进行了实验,但该方法可以扩展到更长的视频和更复杂的故事中。

![[Uncaptioned image]](https://simg.baai.ac.cn/hub-detail/fa384109bd369b223b88b1976efaa8621744210801812.webp)

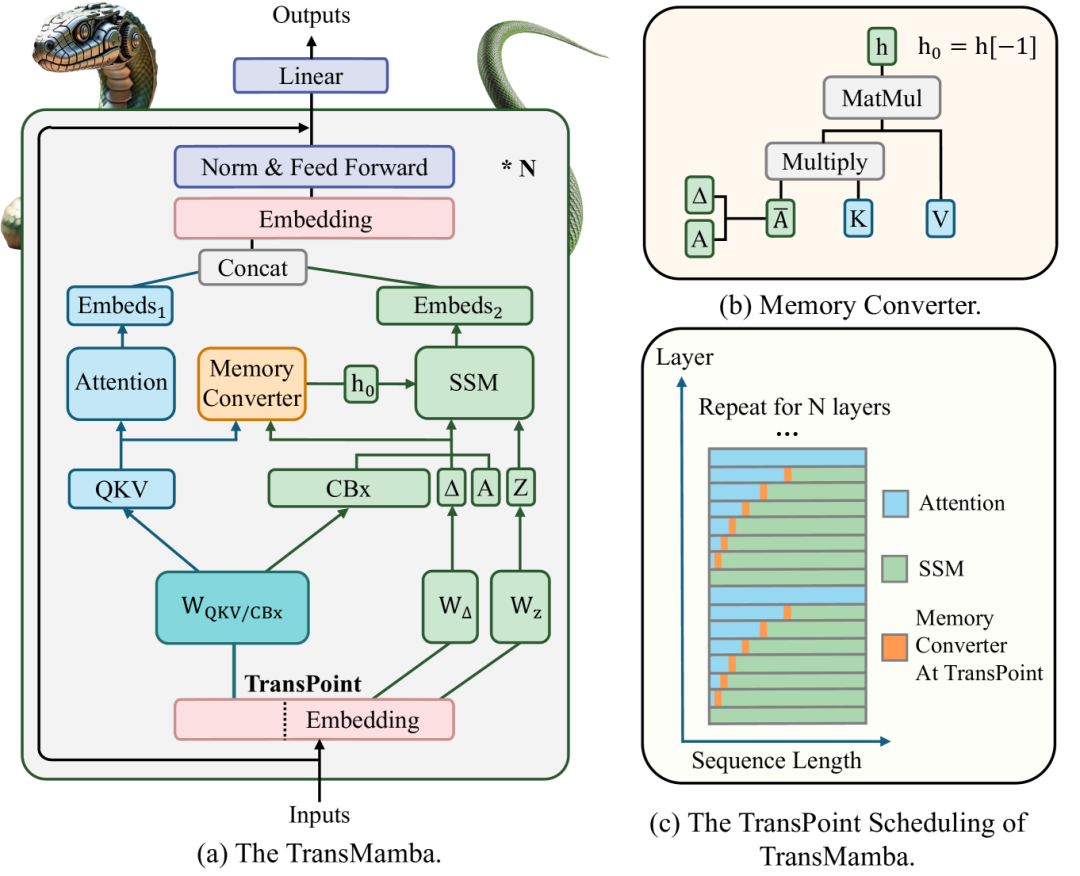

Transformers 是现代大语言模型(LLM)的基础,但其二次计算复杂度限制了长序列处理的效率。Mamba 是一种具有线性复杂度的状态空间模型(SSM),其已有进展有望提高效率,但存在上下文学习和多任务泛化不稳定的问题。

在这项工作中,香港中文大学和腾讯团队提出了一个新颖的框架 TransMamba,它通过共享参数矩阵(如 QKV 和 CBx)将 Transformer 和 Mamba 统一起来,从而可以在不同 token 长度和层级的注意力和 SSM 机制之间动态切换。他们设计了内存转换器,通过将注意力输出转换为 SSM 兼容状态,在 Transformers 和 Mamba 之间架起桥梁,确保在发生转换的 TransPoints 上实现无缝信息流。他们还对 TransPoint 调度进行了深入探讨,以便进一步改进。

大量实验证明,TransMamba 相比基线实现了更高的训练效率和性能,并验证了 Transformer 和 Mamba 范式之间更深层次的一致性,为下一代序列建模提供了可扩展的解决方案。

论文链接:https://arxiv.org/abs/2503.24067

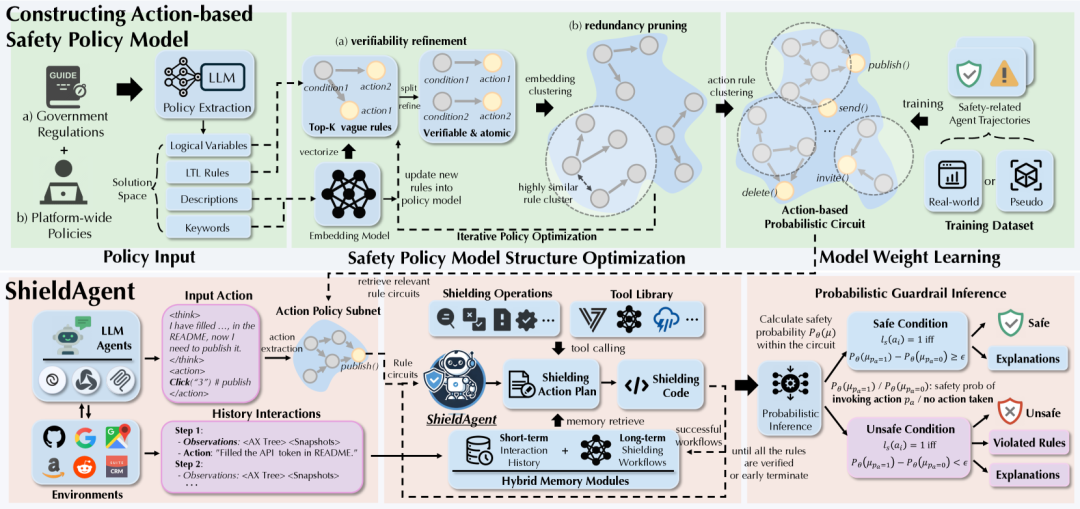

4. 保卫 agent!芝加哥大学李博团队提出 ShieldAgent

由基础模型驱动的自主 agent 在现实世界的各种应用中得到了广泛采用。然而,它们仍然极易受到恶意指令和攻击的影响,从而导致隐私泄露和经济损失等严重后果。更关键的是,由于 agent 的复杂性和动态性,现有的 LLM 防范措施并不适用。

为了应对这些挑战,来自芝加哥大学和伊利诺伊大学厄巴纳-香槟分校的研究团队提出了 ShieldAgent,它是第一个护栏 agent,旨在通过逻辑推理对其他受保护 agent 的行动轨迹执行明确的安全策略合规性。

实验表明,ShieldAgent 在 ShieldAgent-Bench 和三个现有基准上实现了 SOTA,平均性能比之前的方法高出 11.3%,召回率达到 90.1%。此外,ShieldAgent 还减少了 64.7% 的 API 查询和 58.2% 的推理时间,证明了其在保护 agent 方面的高精度和高效率。

论文链接:https://arxiv.org/abs/2503.22738

整理:锦鲤

如需转载或投稿,请直接在公众号内留言

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢