点击蓝字

关注我们

本研究揭示三大转向:技术伦理从研发边缘走向治理中心,创新范式从单一竞争转向协同共生,价值取向从效率优先转向普惠包容。

未来研究需聚焦:(1)AI社会影响的评估方法论创新;(2)全球治理体系的制度兼容性设计;(3)人机协同社会的治理范式重构。唯有建立包容性创新生态,方能实现AI技术的普惠价值,推动人类社会向智能文明时代迈进。

Part1

1.知识生产的全球化重构

2.技术研发的范式突破

2.2 研发成本的结构性分化

3.GitHub AI项目数量与活跃度

Part2

1.基准测试的范式革新

1.2 多模态泛化能力涌现

2.关键技术路线的竞争格局

2.2 推理范式的效率革命

Part3 负责任的AI:伦理治理的制度化探索

1.全球治理体系的碎片化特征

2.技术伦理风险的实证表征

2.2深度伪造的治理困境

Part4

1.宏观经济增长的赋能效应

1.2 投资与创新的正向循环

2.劳动力市场的结构性变革

2.2 就业形态的数字化转型

Part5

1.基础科学的范式转换

2.临床医学的智能化转型

Part6

1.国际规制的路径依赖

2.新兴风险的治理真空

Part7

1.人才培养体系的迭代升级

2.教育范式急需数字化转型

Part8

1.技术接受度的国别区分

2.伦理担忧与政策方向

2013-2023年全球AI学术论文总量达242,000篇,占计算机科学文献比重从21.6%跃升至41.8%。东亚及太平洋地区以34.5%(中国(23.2%)、美国(9.2%))的贡献率主导全球AI研究。值得注意的是,在2021年至2023年引用次数最多的100篇人工智能论文的产出机构中,谷歌每年均位居榜首,而清华大学于2023年以8篇论文与谷歌并列。

Meta的旗舰LLM Llama 3.3于2024年夏季发布,其训练数据量约为15万亿个标记。硬件算力需求同步攀升,训练GPT-4能耗碳排放达5184吨,凸显算力-能耗悖论。

工业界主导超大规模模型研发,2024年全球参数量前十模型均来自企业。头部企业研发投入呈现幂律分布,谷歌、微软年度研发支出超百亿美元,而中小企业的边际创新成本上升至研发总成本的83%。

GitHub AI项目数突破430万项,美国贡献率达23.4%但呈下降趋势;而与人工智能相关的项目总加星数持续增长,从2023年的1400万增加到2024年的1770万。2024年美国和中国在GitHub中获得的加星数量分别为2100万和360万。

新推出的模型增强了推理能力,但也带来经济与延迟成本的增加。例如,o1的速度大约是GPT-4o的40倍,但无论是经济成本还是延迟成本,o1都要比后者高上许多。

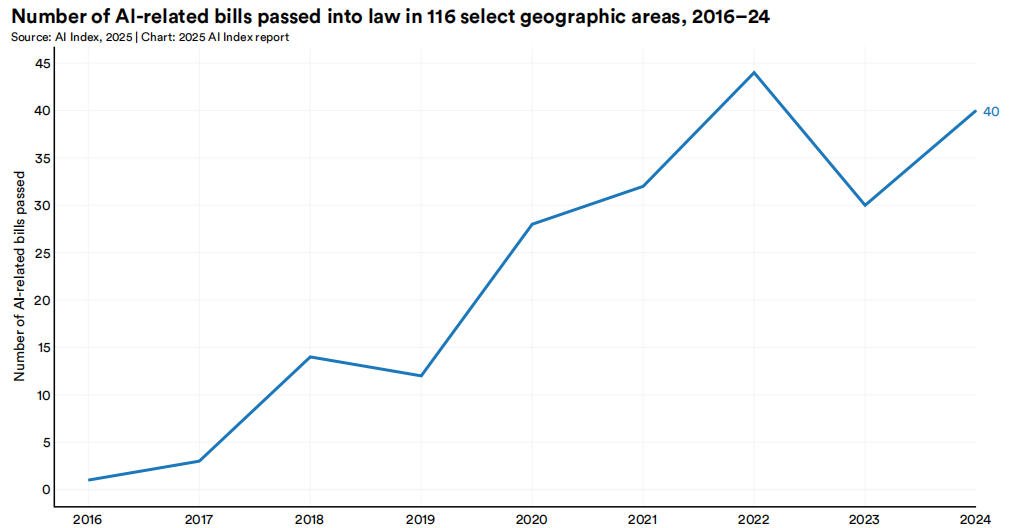

2016年至2024年,39个国家至少通过了一项与人工智能相关的法律(图6.2.1)。而在报告参考的114个国家中,共计通过了204项与人工智能相关的法律。此外,与人工智能相关的法律总数从2023年的30项增加到2024年的40项,使2024年成为有记录以来仅次于2022年的“立法年”。

2016-2024年116 个特定地理区域通过的与人工智能相关的法案数量

许多高级大型语言模型,以GPT-4和Claude 3 Sonnet为例,哪怕存在抑制显性偏见的设计,但依旧会表现出隐性偏见。这些模型不成比例地将负面词汇与黑人个体联系起来,更常将女性与人文领域而非STEM领域联系在一起,并倾向于让男性担任领导职务,从而在决策过程中强化了种族和性别偏见。尽管偏见指标已比标准基准有所改善,但人工智能模型的偏见仍然是一个普遍存在的问题。这种偏差在招聘筛选、信贷评估等场景引发社会公平性质疑。

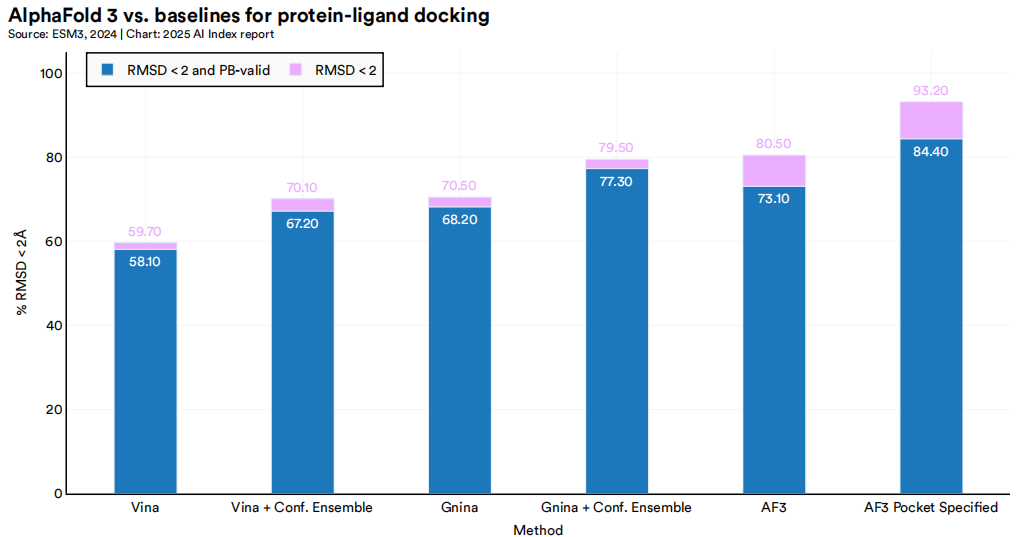

AlphaFold 3模型预测

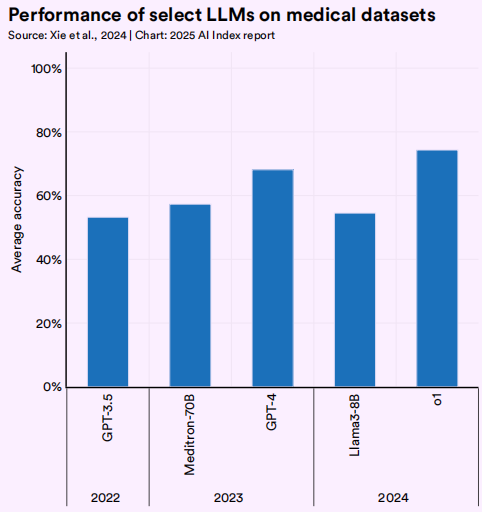

不同大型语言模型在医疗数据集上的表现

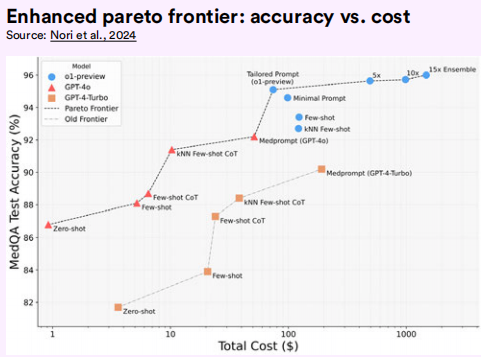

增强型帕累托前沿:准确性与成本的关系

中美欧技术标准分歧持续深化:美国侧重技术创新,欧盟强调权利保护,中国突出内容治理。这种分歧导致全球技术标准制定进程受阻,技术治理话语权争夺加剧。

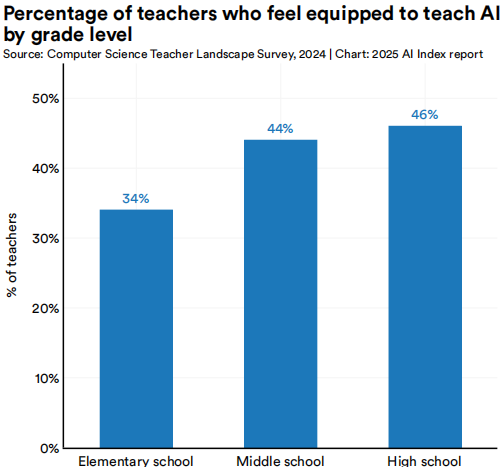

按年级划分认为具备教授AI能力的教师百分比

据调查显示,2022年至2024年间,公众对人工智能的认识度保持相对稳定。2024年,67%的受访者表示对人工智能有很好的了解,66%的人预计人工智能将在不久的将来深刻改变他们的日常生活。认为人工智能产品和服务利大于弊的全球人口比例略有增加,从2022年的52%上升到2024年的55%。

然而,各国对人工智能利弊的看法差异显著。总体而言,亚洲和拉丁美洲的受访者认为人工智能的好处多于弊端:83%的中国人、70%的墨西哥人和62%的印度受访者认为人工智能产品和服务带来的好处大于危害。相比之下,在欧洲与北美洲,仅有46%的英国人、44%的澳大利亚人、40%的加拿大人和39%的美国人认为人工智能的好处多于弊端。尽管如此,相关总体对人工智能持怀疑态度的国家对于人工智能的接受度大多有所上升。

伴随着AI在科研与制造场景的应用,自动驾驶汽车在技术和普及方面都取得了显著进展。然而,大多数美国人(61%)仍然对这项技术感到恐惧。只有13%的受访者表示信任自动驾驶汽车。

审核丨梁正 鲁俊群

清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢