速览热门论文

1. 微软发布首个开源、原生 1-bit 大语言模型

2. 再试一次,即可提高 LLM 搜索能力

3. Cobra:利用 200 张参考图像实现高效线条着色

4. ActPRM:通过主动学习高效训练 PRM

5. 综述:高效推理模型

1. 微软发布首个开源、原生 1-bit 大语言模型

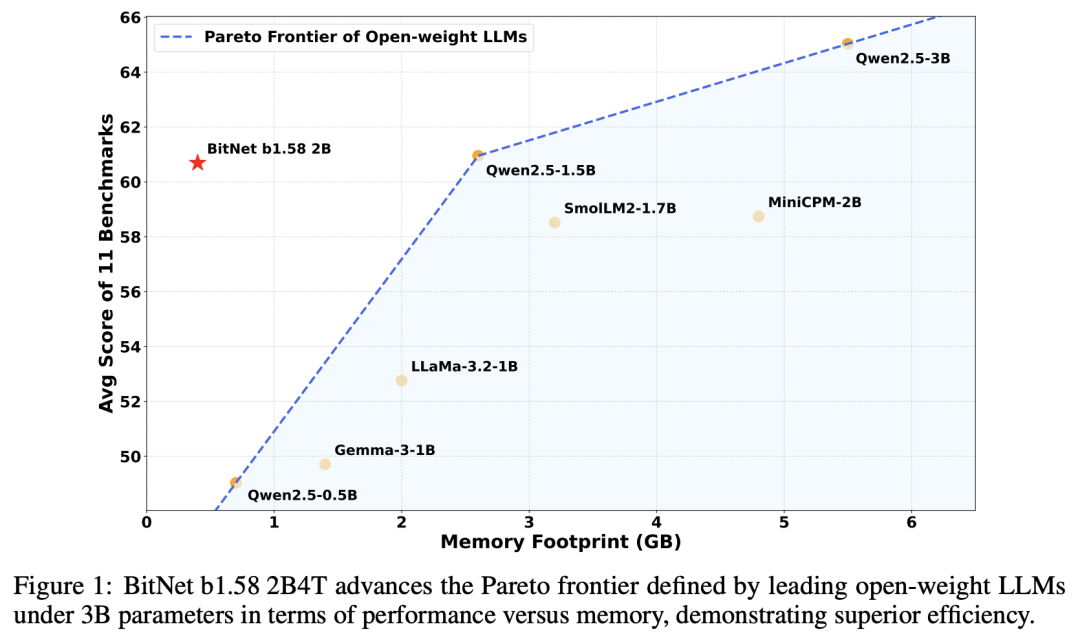

在这项工作中,微软研究院团队提出了 BitNet b1.58 2B4T——首个开源、原生 1-bit 大语言模型(LLM),参数规模为 20 亿。该模型在包含 4 万亿 token 的语料库中进行了训练,并在语言理解、数学推理、编码能力和会话能力等方面进行了基准评估。

结果表明,BitNet b1.58 2B4T 的性能与同等规模的领先开放权重、全精度 LLM 不相上下,同时在计算效率方面具有显著优势,包括大幅减少内存占用、能耗和解码延迟。

为了促进进一步的研究和应用,他们发布了模型权重以及 GPU 和 CPU 架构的开源推理实现。

论文链接:https://arxiv.org/abs/2504.12285

2. 再试一次,即可提高 LLM 搜索能力

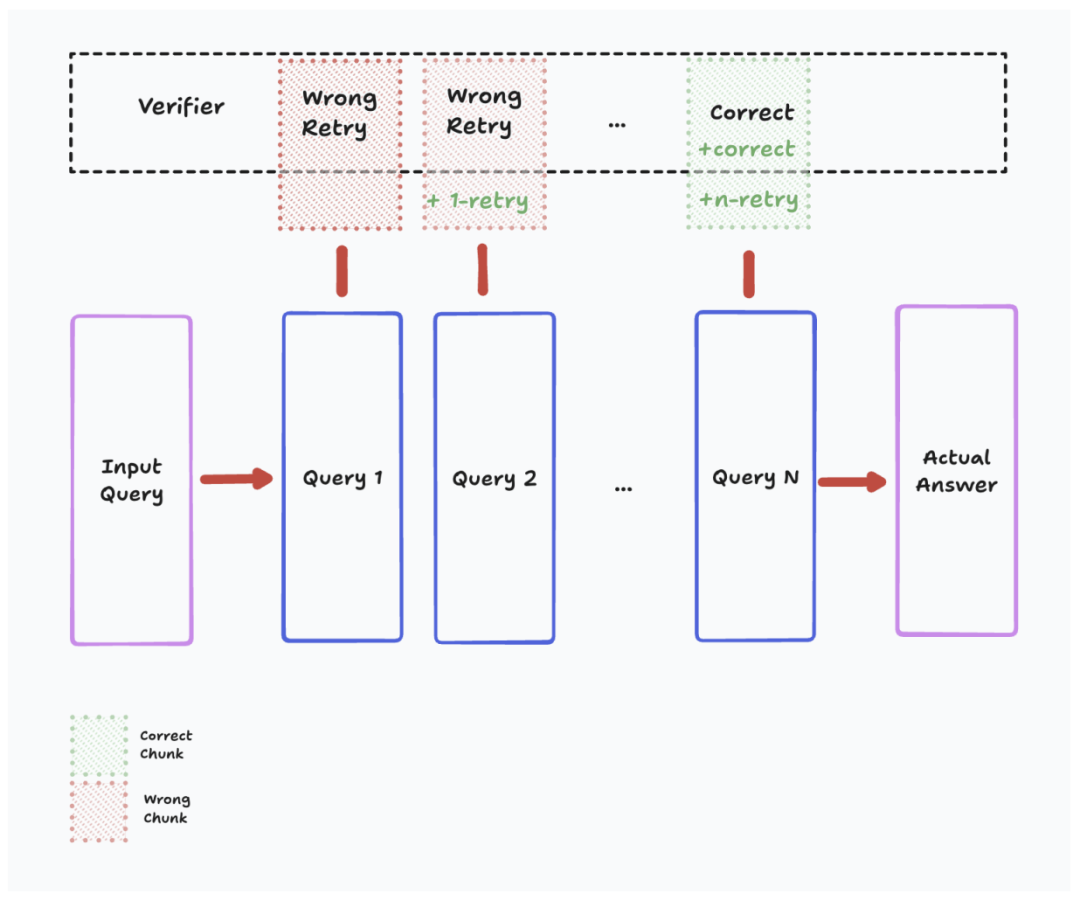

检索增强生成(RAG)提高了大语言模型(LLM)在知识密集型任务中的性能,但这在很大程度上取决于初始搜索查询的质量。当前方法通常使用强化学习,侧重于查询表述或结果推理,而不会明确鼓励在搜索失败后继续搜索。

在这项工作中,Menlo Research 团队提出了一个新的强化学习框架——ReZero(Retry-Zero),其直接奖励初次尝试失败后重试搜索查询的行为。这激励 LLM 探索其他查询,而不是过早地停止。

与 25% 的基线相比,ReZero 取得了 46.88% 的准确率,增强了 LLM 在复杂信息搜索场景中的鲁棒性,在这种场景中,最初的查询可能被证明是不够的。

论文链接:https://arxiv.org/abs/2504.11001

3. Cobra:利用 200 张参考图像实现高效线条着色

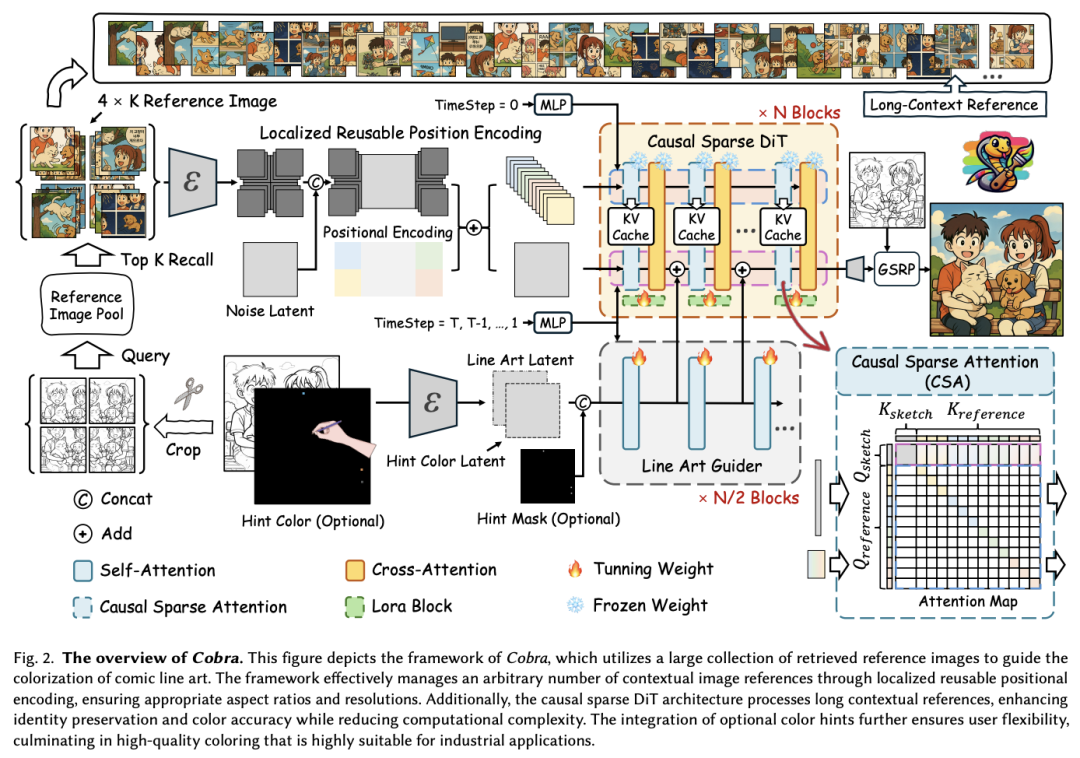

漫画制作行业需要基于参考资料的线稿着色,要求精确度高、效率高、上下文一致、控制灵活。漫画页面通常涉及不同的人物、物体和背景,这使得着色过程变得复杂。用于图像生成的扩散模型在线描着色中的应用依然有限,面临着处理大量参考图像、推理耗时和灵活控制等挑战。

在这项工作中,来自清华大学、香港中文大学和腾讯的联合团队研究了大量上下文图像引导对线稿着色质量的必要性。为了应对这些挑战,他提出了一种高效、多用途的方法 Cobra,其支持色彩提示,可利用 200 多张参考图像,同时保持较低的延迟。

Cobra 的核心是因果稀疏 DiT 架构,该架构利用专门设计的位置编码、因果稀疏注意力和键值缓存来有效管理长上下文参考,并确保色彩身份的一致性。结果表明,Cobra 通过广泛的上下文参考实现了准确的线条美着色,提高了推理速度和交互性,从而满足了关键的工业需求。

论文地址:https://arxiv.org/abs/2504.12240

4. ActPRM:通过主动学习高效训练 PRM

过程奖励模型(PRM)为大语言模型(LLMs)提供了阶段级监督,但对于人类和 LLM 来说,扩大训练数据标注仍然是一项挑战。

为了解决这一局限性,来自新加坡国立大学和 Sea AI Lab 的研究团队提出了一种主动学习方法 ActPRM,它可以主动选择最不确定的样本进行训练,从而大大降低标注成本。在训练过程中,他们使用 PRM 估算前向传播后的不确定性,只保留高度不确定的数据。随后,功能更强的推理模型会对这些数据进行标注。然后,他们计算与标注相关的损失,并更新 PRM 的权重。

他们在基于池的主动学习设置中比较了 ActPRM 和 vanilla 微调,结果表明 ActPRM 减少了 50% 的标注,但却实现了相当甚至更好的性能。除了标注效率之外,他们还利用 ActPRM 过滤了 100 多万条数学推理轨迹,保留了 60% 的数据,从而进一步提高了主动训练 PRM 的性能。与同等规模的模型相比,在这一选定数据集上进行的后续训练在 ProcessBench(75.0%)和 PRMBench(65.5%)上产生了 SOTA PRM。

论文链接:https://arxiv.org/abs/2504.10559

5. 综述:高效推理模型

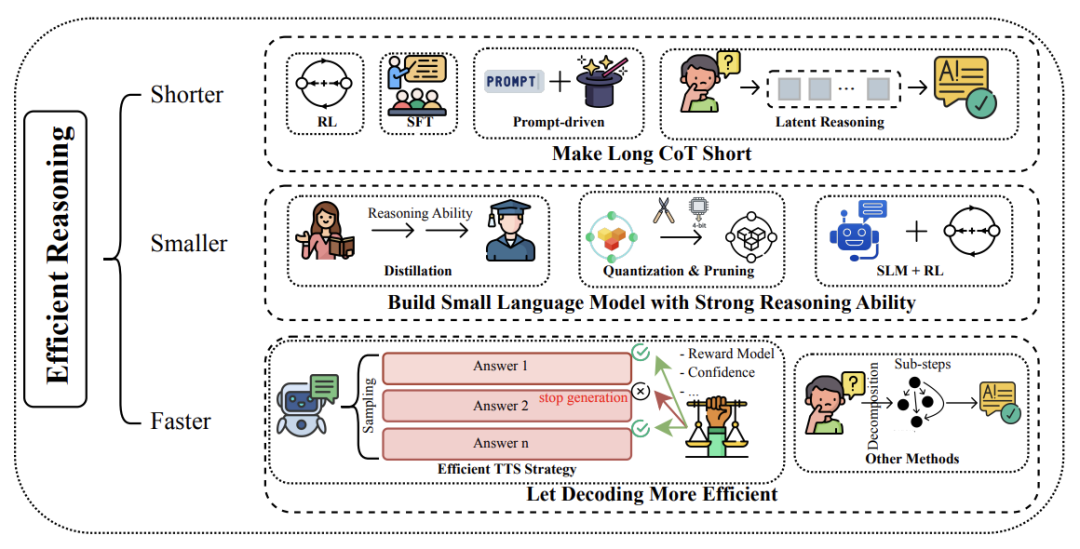

推理模型通过在得出最终答案之前生成扩展的“思维链”(CoT),在解决复杂的逻辑密集型任务方面取得了很大的进展。然而,这种“慢思考”模式的出现,以及依次生成的大量 token,不可避免地带来了大量计算开销。这凸显了对有效加速的迫切需求。

在这项工作中,新加坡国立大学团队旨在全面概述高效推理的新进展,将现有工作分为三个主要方向:(1)更短--将冗长的 CoT 压缩成简洁而有效的推理链;(2)更小--通过知识蒸馏、其他模型压缩和强化学习等技术,开发具有强推理能力的紧凑语言模型;(3)更快--设计高效的解码策略以加速推理。

论文链接:https://arxiv.org/abs/2504.10903

整理:学术君

如需转载或投稿,请直接在公众号内留言

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢