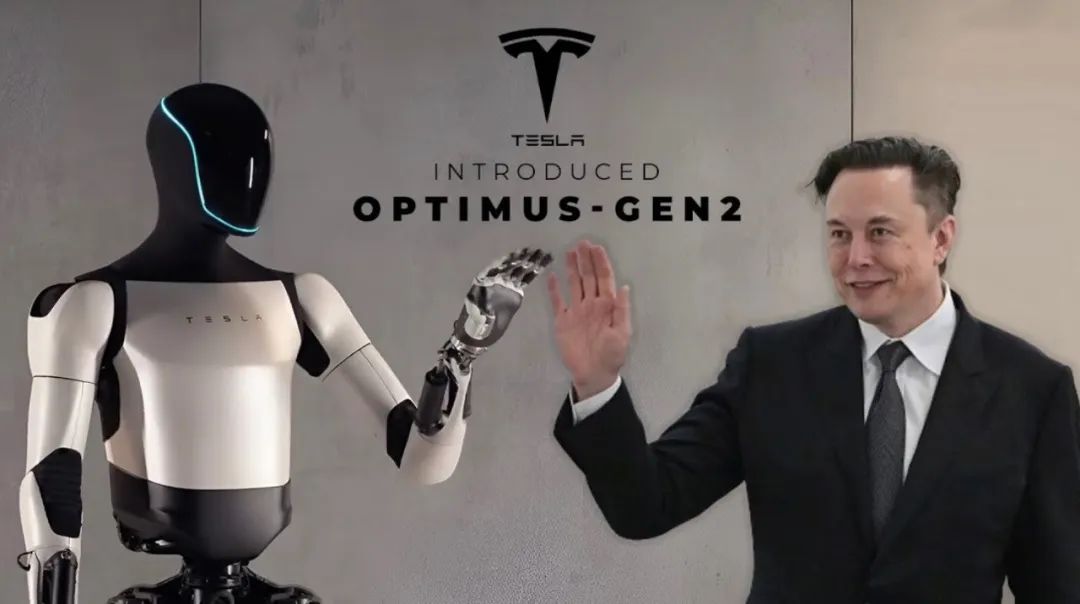

在过去十年里,AI 已经证明它能听懂语言、看懂图像、甚至能“写作”与“编程”。但让 AI 走出虚拟世界、接触真实环境,是更大的挑战。Tesla 的人形机器人 Optimus 正是这一挑战的答卷:让深度学习模型不仅能“思考”,还能“行动”。

从自动驾驶到机器人

Optimus 的诞生,延续了 Tesla 在自动驾驶中积累的核心技术。自动驾驶本质上是一种“机器人系统”,需要对视觉环境进行理解、做出实时决策并精准控制车辆。而 Optimus 所面对的物理世界复杂度更高:它需要在三维空间中识别物体、理解语义、精细控制双手和双足完成任务。

Tesla 选择沿用自动驾驶系统的 AI 架构,包括视觉感知模型(多摄像头输入)、神经网络规划模块、时间序列预测机制等。这使 Optimus 在应对动态环境时具备类似于人类的反应能力。

感知:机器人“看懂”世界的第一步

Optimus 配备了多个摄像头和 IMU(惯性测量单元),用于构建周围环境的 3D 表示。它使用基于 Transformer 架构的大型视觉模型,对场景中的物体进行识别、跟踪和空间定位。和常见图像分类不同,这里的视觉模型不仅输出“是什么”,更重要的是“在哪里”“能不能操作”“如何接近”。

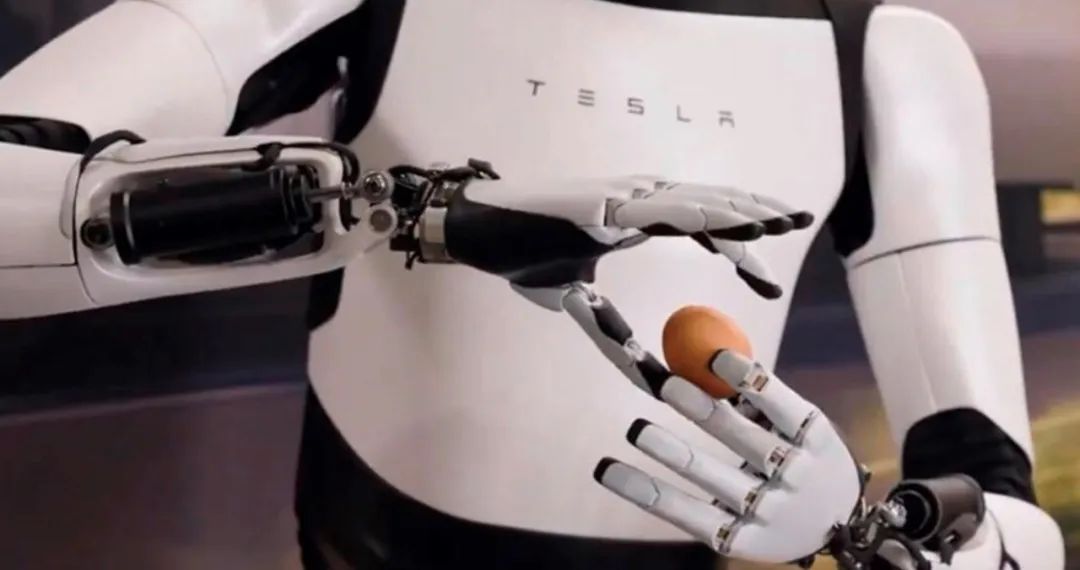

例如,在演示中,Optimus 能够准确判断桌上的物体,并决定采用哪种抓取方式。这一能力依赖于端到端训练的视觉-动作网络,结合模仿学习与强化学习进行策略优化。

控制:将“意图”变成“动作”

机器人控制是 AI 不熟悉但极为关键的环节。Optimus 的控制系统包含运动规划器(Motion Planner)、逆运动学(IK)解算器,以及低层的电机控制模块。

相比于自动驾驶只需要控制方向和速度,Optimus 需要控制几十个关节,保持平衡、调整姿态、同时协调手脚动作。Tesla 使用模型预测控制(MPC)与学习控制混合的方法,使机器人能适应地形变化,实现类人步态。

此外,Optimus 的手部拥有超过 10 个自由度,能完成较复杂的操作任务,如拣选、分类、搬运物品等。这一能力的训练部分来源于示教(teleoperation)系统,即人类控制机器手完成任务,生成数据供模型模仿学习。

能源与硬件:AI 的“肉身”如何构建?

Tesla 对硬件结构的控制力使其具备独特优势。Optimus 使用定制的伺服电机、高能效的电池包和轻量化结构材料,在保证灵活性的同时优化了续航和负载能力。整个机器人以模块化结构构建,便于批量生产与维护。

Optimus 并不只是一个工程秀,它代表的是 AI 发展的新阶段:从信息处理走向物理交互。过去 AI 模型解决的是“输入-输出”的抽象问题,而在机器人中,AI 直接影响物理世界——这意味着,它不再只是“大脑”,更承担起“身体”的责任。

文 | 李晓琦

图 | 除标注外,均源自网络

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢