DRUGAI

在生物技术领域,生成式人工智能(AI)的快速应用带来了巨大的潜力,但同时也引发了严重的安全担忧。用于蛋白质工程、基因组编辑和分子合成的AI模型可能被滥用,用于增强病毒毒性、设计毒素或修改人类胚胎,而伦理和政策讨论仍远远滞后于技术进步。

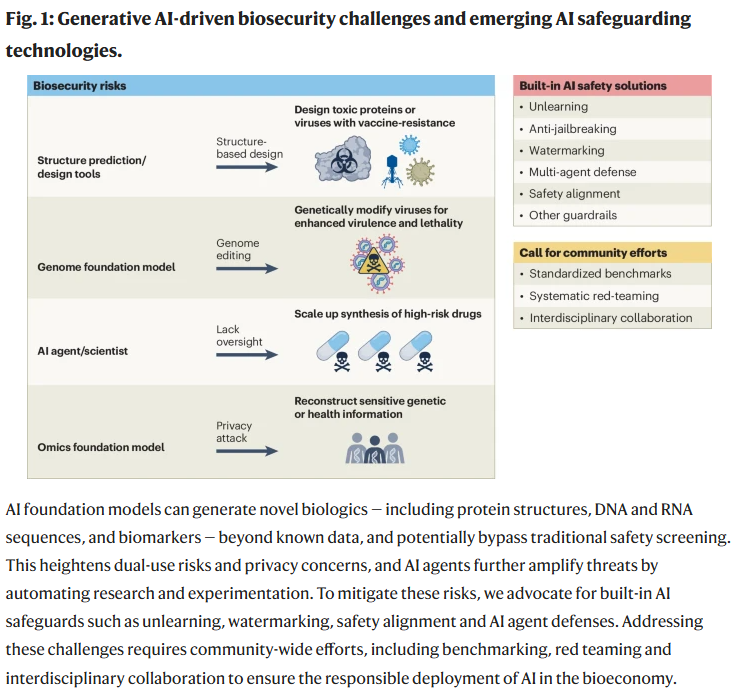

本文呼吁在生成式AI工具中主动内置、原生设计生物安全防护机制。通过进一步的研究与开发,水印技术、对齐技术、防越狱机制和反向学习(unlearning)等新兴AI安全技术有望与治理政策形成互补,提供可扩展的生物安全解决方案。研究人员同时强调,全球社会在研究、开发、测试和实施这些措施方面应发挥积极作用,以确保生成式AI在生物技术领域的负责任部署(图1)。

生成式AI在生物科学中的生物安全威胁

生成式AI正在重塑生物技术研究,推动药物发现、蛋白质设计和合成生物学的加速发展,同时也提升了生物医学成像、个性化医疗和实验室自动化水平。然而,这些突破也带来了生物安全风险,引发了政策和学界的关注。

生成式AI的强大之处在于能够从已知数据推断未知内容。深度生成模型可预测出与现有基因组或蛋白质序列不同的新型生物分子。这一能力带来了双重用途风险,可能绕过目前依赖数据库比对的核酸合成安全筛查。AI工具被滥用,可能用于设计病原体、毒素或其他具有破坏性的分子,AI科学代理也可能因自动化实验设计而放大风险。

尽管生物安全问题早在二十多年前已被提出,AI的出现进一步加剧了这一威胁。部分研究人员已警示,蛋白质设计技术、基因编辑平台等均存在被滥用的风险。生物技术的双重用途特性、高风险的基因操控,以及AI安全与生物科学领域交叉专业知识的缺乏,使生成式AI带来的挑战尤为复杂且紧迫。

呼吁为生物安全内置AI防护机制

目前,许多生物技术领域的AI工具尚未配置防护措施,存在严重风险。研究人员呼吁采取紧急协调行动,通过整合技术防护、推动全球协作和制定强有力的政策,确保生物技术领域的负责任创新。

技术性、内置的安全防护是减少AI滥用风险的一种途径。这类防护措施需具备主动性、可扩展性和有效性,且不应显著影响AI模型的有益性能。当前有多种新兴AI安全技术有望应用于生物安全,但仍需进一步研发与优化:

水印技术:在生成的生物设计中嵌入不可见标记,便于溯源和审计。

安全对齐:训练模型避免响应恶意请求,如避免生成致病DNA序列。

反向学习:有针对性地删除模型中与有害应用相关的知识。

防越狱机制:使模型能识别并拒绝试图绕过安全限制的用户请求。

自主AI代理:实时监测并快速响应异常行为,交叉验证输出,防止潜在滥用。

加密技术:在远程设备中集成AI防护,确保安全筛查与物理合成之间不可篡改的连接。

这些方法可与治理政策相辅相成,构建系统性的生物安全技术防线。

尽管对生物安全风险的认识正在提高,目前相关技术仍处于初步阶段,且现有模型大多缺乏保护机制。内置防护可能增加成本、降低性能,需在开发过程中权衡利弊。因此,研究人员呼吁社区力量加速开发这些防护措施,并评估其对生物经济的潜在影响。

呼吁社区合作

除了技术进步,研究人员还呼吁建立标准化基准测试和系统性红队测试,以评估和提升AI安全防护。例如,应开发用于识别不安全基因序列的AI基准测试,同时建立涵盖不同生物领域和威胁情境的生物安全提示基准。

红队测试,即由专家进行的对抗性测试,是揭示AI系统漏洞的重要手段。研究人员倡导跨学科合作,模拟潜在滥用场景,提升模型韧性,并建立共享的测试用例和威胁模型数据库,加速生物技术与AI安全领域的学习与应对能力。

生成式AI融入生物技术领域,要求AI研究人员、生物学家与安全专家紧密协作,主动防范双重用途风险。研究人员认为,构建模型层约束、解码层过滤、代理层防御的内置防护体系,将是防止AI工具被滥用的关键路径。为实现这一目标,研究人员提出三项优先事项:推进面向生物基础模型的AI安全研究,建立AI-生物技术工具的标准化风险评估体系,以及开发全球威胁监测系统。

通过深入理解、开发并在生成式AI生物技术工具中整合内置防护机制,同时配合治理策略,生物技术领域有望在充分利用生成式AI带来的创新潜力的同时,有效降低其生物安全风险。

整理 | WJM

参考资料

Wang, M., Zhang, Z., Bedi, A.S. et al. A call for built-in biosecurity safeguards for generative AI tools. Nat Biotechnol (2025).

https://doi.org/10.1038/s41587-025-02650-8

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢