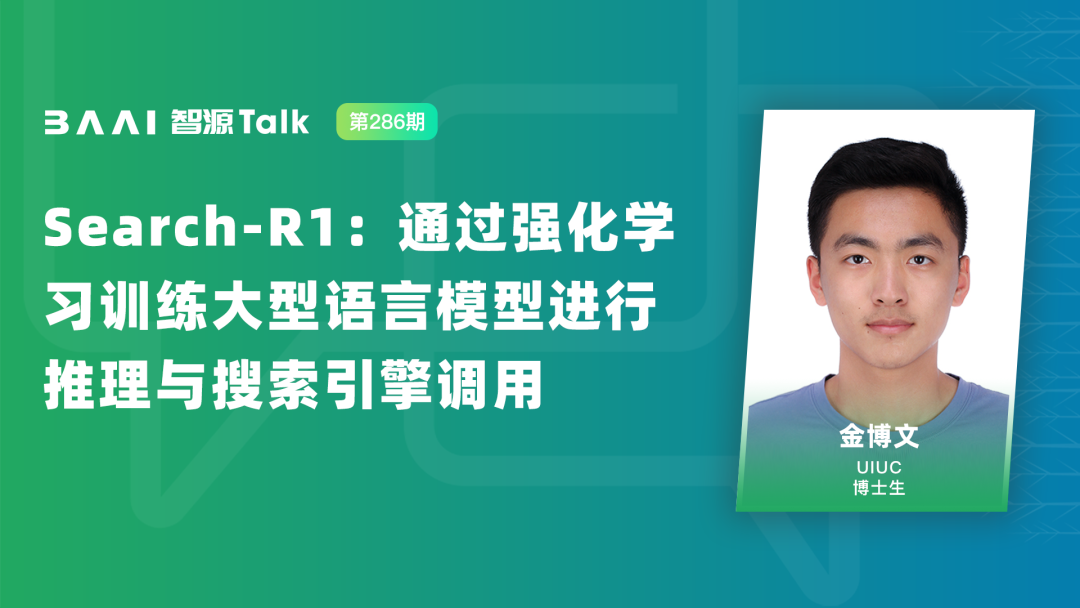

报告主题:通过强化学习训练大型语言模型进行推理与搜索引擎调用

报告日期:05月08日(本周四)10:30-11:30

报告要点:

金博文是伊利诺伊大学厄本那-香槟分校(UIUC)计算机科学系的博士四年级学生,师从韩家炜教授。他获得了 Apple 博士奖学金(Apple PhD Fellowship)和鲍云妮-鲍美心纪念奖学金(Yunni and Maxine Pao Memorial Fellowship)的资助。他的研究兴趣主要集中在大型语言模型(LLMs)、多模态学习与信息网络的交叉领域,特别关注基础模型如何融合文本、网络和多模态数据,来解决信息检索与知识发现等现实世界问题。目前,他的研究兴趣包括 LLM Agent、推理与强化学习(RL)。他以第一作者身份在 ICLR、ICML、NeurIPS、KDD、SIGIR、ACL、COLM 和 EMNLP 等国际顶级会议上发表了多篇论文。

更多信息请访问他的个人主页:https://hub.baai.ac.cn/users/106296。

扫码报名

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢