大模型进入 RL 下半场。前段时间,OpenAI Agent Reseacher 姚顺雨的博客文章《The second half》掀起热议,从「模型算法」到「实际效用」,如何重新定义问题和设计真实用例的 evaluation 变得尤为重要。

从评测基准到实际应用效果,现有的评估体系怎样有效衡量 Agent 产品的 ROI?对于创企、希望应用 AI 的企业来说,如何用好模型的测评结果来指导产品的开发落地?

Superclue 在模型测评领域有着深厚的经验,与国内外众多模型及 Agent 团队保持着紧密的联系与交流。Superclue 近期推出了中文通用 AI 智能体的测评基准 AgentCLUE-General,对主流的 Agent 产品能力进行了深度剖析。

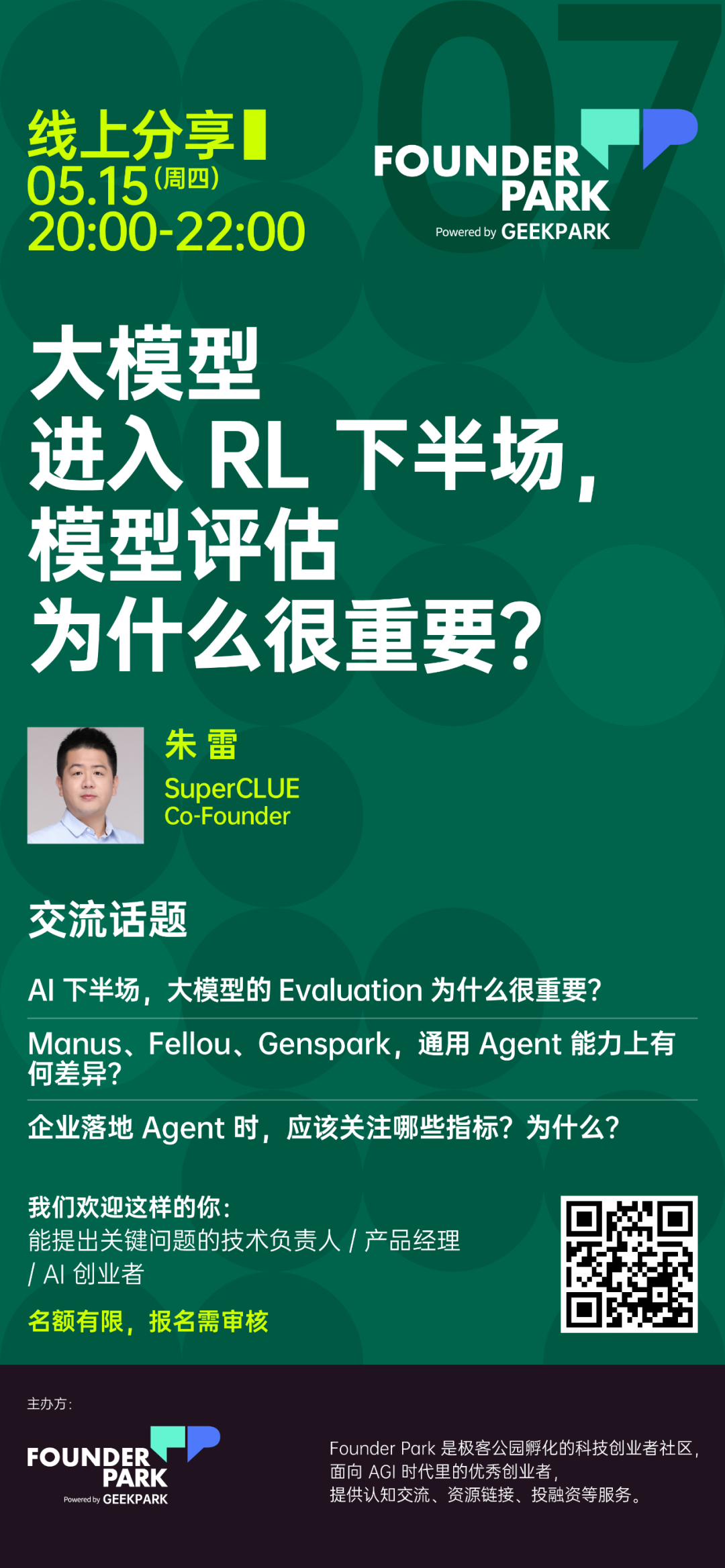

我们特别邀请到 SuperCLUE 的联合创始人朱雷,一起聊聊当前大模型、Agent 评估中的核心难题。

AI 下半场,大模型的 Evaluation 为什么很重要?

Manus、Fellou、Genspark,通用 Agent 能力上有何差异?

企业落地 Agent 时,应该关注哪些指标?为什么?

下周四(5 月 15 日),20 点 - 22 点,线上分享。名额有限,扫描下方海报二维码报名。

转载原创文章请添加微信:founderparker

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢