速览热门论文

2.微软推出 X-Reasoner:跨模态、跨领域泛化推理

3.北大团队:CoT token 是计算机程序变量

4.北理工王钢团队:多 agent 具身智能综述

5.蚂蚁集团、浙大综述:LLM 解决复杂问题的能力和局限性

6.LLM 多智能体系统的自动故障归因

7.Zero8.Search:无需搜索即可提升 LLM 搜索能力

8.人大文继荣团队新作:LLM 群体智能 benchmark

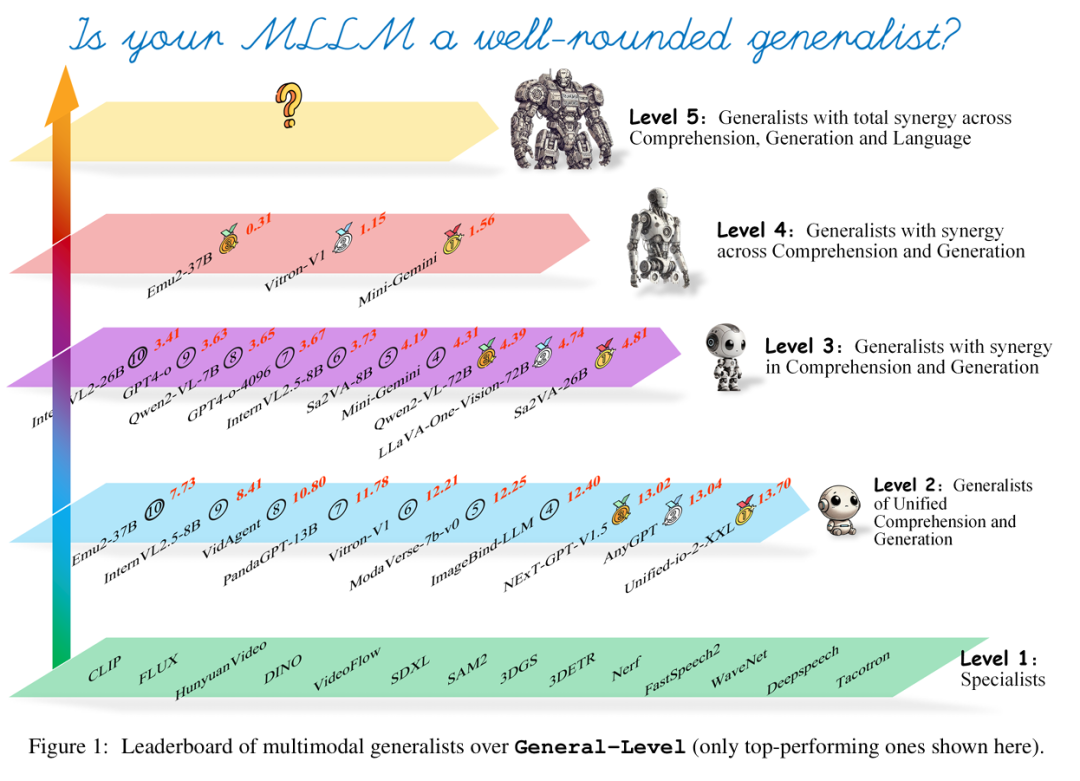

9.迈向多模态通才之路:General-Level、General-Bench

1.清华刘知远团队:高质量 LLM 训练数据的高效获取

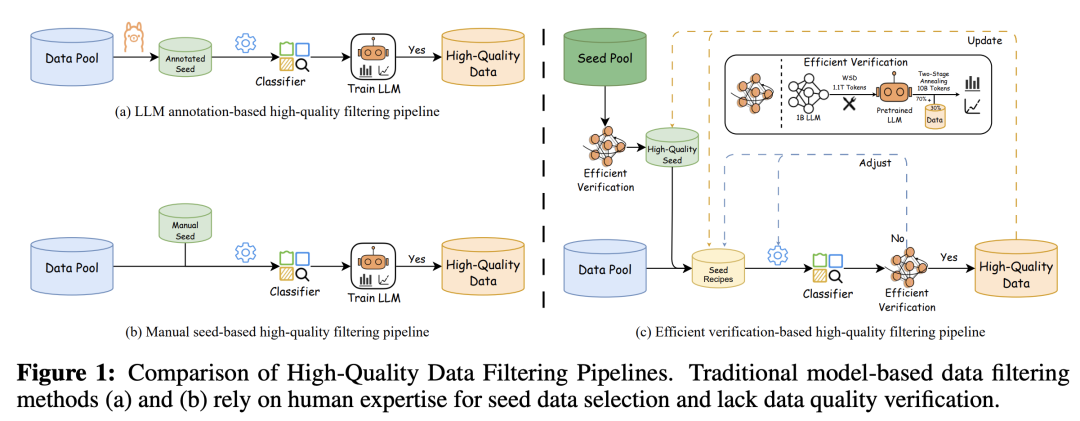

数据质量,已经成为提高大语言模型(LLM)性能的关键因素。模型驱动的数据过滤是获取高质量数据的主要方法之一,但仍然面临着两大挑战:(1)缺乏高效的数据验证策略,难以及时提供数据质量反馈;(2)用于训练分类器的种子数据的选择缺乏明确的标准,且严重依赖于人类的专业知识,带入了一定程度的主观性。

为了应对第一个挑战,清华大学计算机科学与技术系副教授刘知远团队提出了一种高效的验证策略,以最小的计算成本快速评估数据对 LLM 训练的影响。为了应对第二个挑战,他们基于高质量种子数据有利于 LLM 训练的假设,通过整合所提出的验证策略,优化了正样本和负样本的选择,并提出了一个高效的数据过滤管道,不仅提高了过滤效率、分类器质量和鲁棒性,还显著降低了实验和推理成本。

此外,为了高效地过滤高质量数据,他们采用基于 fastText 的轻量级分类器,成功地将过滤管道应用于 FineWeb 和 Chinese FineWeb 数据集,创建了更高质量、包含约 1 万亿个英文 token 和 1200 亿个中文 token 的 Ultra-FineWeb 数据集。结果表明,在 Ultra-FineWeb 上训练的 LLM 在多个基准任务中表现出了显著的性能提升。

论文链接:https://arxiv.org/abs/2505.05427

2.微软推出 X-Reasoner:跨模态、跨领域泛化推理

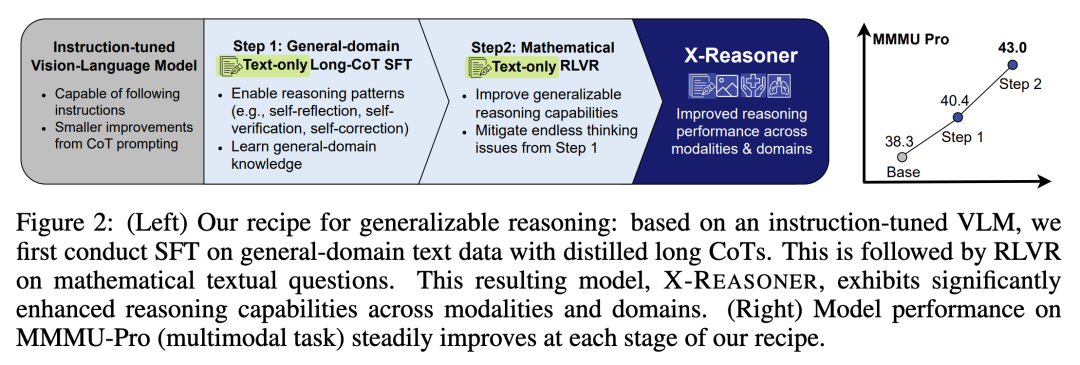

专有模型(如 o3)已经展现出强大的多模态推理能力。然而,现有开源研究大多集中于训练纯文本推理模型,评估主要局限于数学和通用领域的任务。因此,如何有效地将推理能力扩展到文本输入和通用领域之外,仍是一个难题。

在这项工作中,微软团队探讨了一个基本研究问题:推理是否可以跨模态和跨领域泛化?他们得出的结果是:基于通用领域文本的后训练可以实现这种强大的泛化推理能力。基于这一发现,他们推出了一种完全基于通用域文本进行后训练即可实现通用推理的视觉语言模型 X-Reasoner,其采用两阶段方法:最初的监督微调阶段,使用经过蒸馏的长思维链,随后使用可验证奖励的强化学习。

实验表明,X-Reasoner 成功地将推理能力转移到了多模态和域外环境中,在各种通用和医疗基准中的表现优于使用域内和多模态数据训练的现有 SOTA 模型。此外,他们还发现,通过对特定领域的纯文本数据进行持续训练,X-Reasoner 在专业领域的性能还能进一步提高。在此基础上,他们推出了 X-Reasoner-Med,它是一种医疗专业变体,在众多纯文本和多模态医疗基准上实现了 SOTA。

论文链接:https://arxiv.org/abs/2505.03981

3.北大团队:CoT token 是计算机程序变量

思维链(CoT)使得大语言模型(LLM)在得出最终答案之前生成中间步骤,已被证明能有效帮助 LLM 解决复杂的推理任务。然而,CoT 的内在机制在很大程度上仍不清楚。

在这项工作中,北京大学团队实证研究了 CoT token 在 LLM 中对多位数乘法和动态编程这两个组合任务的作用。虽然 CoT 对解决这些问题至关重要,但如果只保留存储中间结果的 token,也能获得相当的性能。此外,他们还发现,以另一种潜在形式存储中间结果不会影响模型性能。他们还在 CoT 中随机干预了一些值,并注意到随后的 CoT token 和最终答案都会发生相应的变化。

这些发现表明,CoT token 可以像计算机程序中的变量一样发挥作用,但也有潜在的缺点,如 token 之间的意外捷径和计算复杂性限制。

论文链接:https://arxiv.org/abs/2505.04955

4.北理工王钢团队:多 agent 具身智能综述

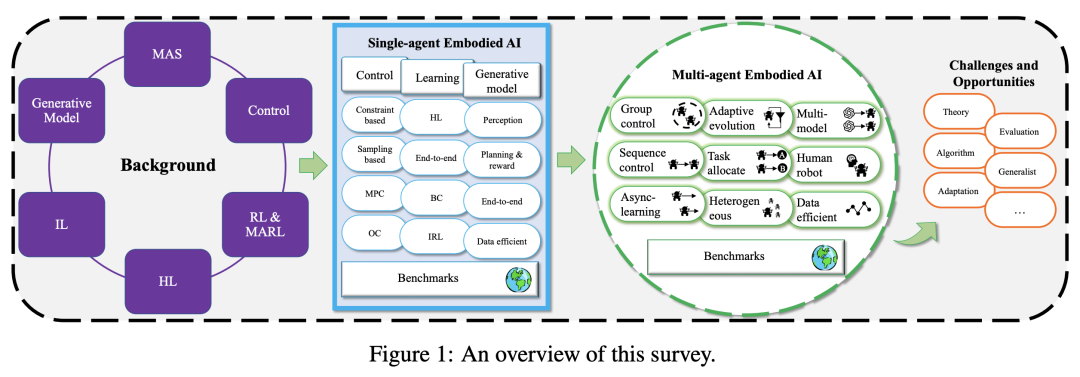

通过使用用于输入的传感器和用于行动的执行器,具身智能(Embodied AI)系统可以根据现实世界的反馈进行学习和调整,从而在动态和不可预测的环境中有效地执行任务,应用范围涵盖机器人、医疗保健、交通和制造等领域。

然而,大多数研究都集中在单智能体(agent)系统上,这些系统通常假设静态、封闭的环境,而现实世界中的具身智能系统必须在复杂得多的场景中航行。在这种情况下,智能体不仅要与周围环境互动,还要与其他智能体协作,这就需要复杂的适应、实时学习和协作解决问题的机制。尽管人们对多智能体系统的兴趣与日俱增,但现有的研究范围仍然狭窄,往往依赖于简化的模型,无法捕捉动态、开放环境中多智能体具身智能的全部复杂性。此外,业内还没有一项全面的调查系统地回顾这一领域的进展。随着具身智能的快速发展,加深我们对多智能体具身智能的理解以应对现实世界应用所带来的挑战至关重要。

为了填补这一空白并促进该领域的进一步发展,北京理工大学王钢教授团队回顾了具身智能的研究现状,分析了主要贡献,并指出了挑战和未来方向。

论文链接:https://arxiv.org/abs/2505.05108

5.蚂蚁集团、浙大综述:LLM 解决复杂问题的能力和局限性

大语言模型(LLM)已成为能够解决不同领域复杂问题的强大工具。与传统的计算系统不同,LLM 将原始计算能力与人类推理能力近似地结合在一起,使其能够生成解决方案、进行推理,甚至利用外部计算工具。然而,将 LLM 应用于现实世界的问题解决面临着巨大挑战,包括多步推理、领域知识整合和结果验证。

在这篇综述中,来自蚂蚁集团和浙江大学的研究团队探讨了 LLM 在解决复杂问题方面的能力和局限性,研究的技术包括思维链(CoT)推理、知识增强以及各种基于 LLM 和基于工具的验证技术。此外,他们还强调了软件工程、数学推理和证明、数据分析和建模以及科学研究等不同领域的特定挑战。该综述还从多步推理、领域知识集成和结果验证的角度,进一步讨论了当前 LLM 解决方案的基本局限性以及基于 LLM 的复杂问题求解的未来发展方向。

论文链接:https://arxiv.org/abs/2505.03418

6.LLM 多智能体系统的自动故障归因

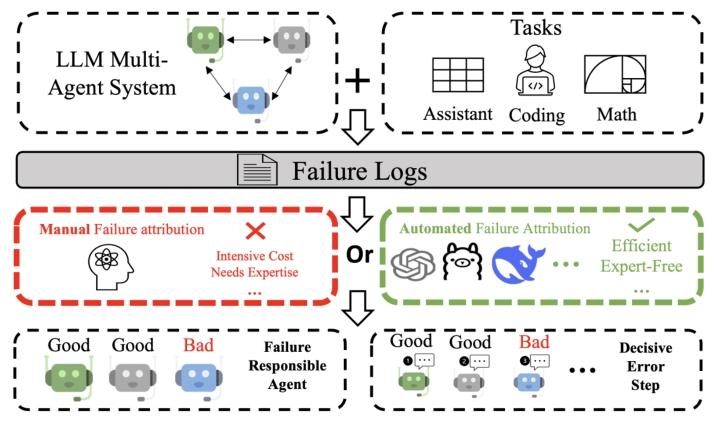

LLM 多智能体系统中的故障归因,即识别对任务失败负责的智能体和步骤,为系统调试提供了关键线索,但仍未得到充分探索,且耗费大量人力物力。

来自宾夕法尼亚大学、杜克大学的研究团队及其合作者提出并制定了一个新的研究领域:LLM 多智能体系统的自动故障归因。为了推进该研究,他们提出了 Who&When 数据集,该数据集由 127 个 LLM 多智能体系统的大量故障日志组成,其中包含将故障与特定智能体和决定性错误步骤联系起来的细粒度注释。

利用 Who&When,他们开发并评估了三种自动故障归因方法,总结了它们各自的优缺点。最好的方法在识别故障责任智能体方面达到了 53.5% 的准确率,但在精确定位故障步骤方面仅为 14.2%,有些方法的准确率甚至低于随机方法。即使是 SOTA 推理模型,如 OpenAI o1 和 DeepSeek R1,也未能达到实际可用性。

论文链接:https://arxiv.org/abs/2505.00212

7.ZeroSearch:无需搜索即可提升 LLM 搜索能力

有效的信息搜索对于提高大语言模型(LLM)的推理和生成能力至关重要。最近的研究探索了使用强化学习(RL),通过在真实世界环境中与实时搜索引擎交互来提高 LLM 的搜索能力。虽然这些方法取得了可喜的成果,但也面临着不受控制的文档质量和极高的 API 成本等挑战。

为此,阿里通义实验室团队推出了强化学习框架 ZeroSearch,该框架可激励 LLM 的搜索能力,而无需与真正的搜索引擎进行交互。他们的方法从轻量级监督微调开始,将 LLM 转化为一个搜索模块,能够根据查询生成相关文档和噪声文档。在 RL 训练过程中,他们采用基于课程的推广策略,逐步降低生成文档的质量,通过将模型暴露在越来越具有挑战性的搜索场景中,逐步激发模型的推理能力。

实验证明,ZeroSearch 可以有效地激励使用 3B LLM 作为搜索模块的 LLM 的搜索能力。值得注意的是,7B 搜索模块实现了与真实搜索引擎相当的性能,而 14B 搜索模块甚至更优。此外,它在各种参数大小的基础模型和指令微调模型中都有很好的通用性,并与各种 RL 算法兼容。

论文链接:https://arxiv.org/abs/2505.04588

8.人大文继荣团队新作:LLM 群体智能 benchmark

大语言模型(LLM)已显示出复杂推理的潜力,然而,当多智能体系统(MAS)在严格的约束条件下运行时,其涌现协调能力在很大程度上仍未得到探索,尤其是在蜂群智能的细微差别方面。现有基准往往不能完全捕捉到当智能体在不完整的时空信息下运行时,分散协调所面临的独特挑战。

为了填补这一空白,中国人民大学文继荣团队推出了 SwarmBench 基准,旨在系统地评估作为分散智能体的 LLM 的群体智能能力。SwarmBench 在可配置的二维网格环境中执行五项基本的 MAS 协调任务,迫使智能体主要依靠本地感官输入(k×k 视图)和本地通信。他们提出了协调效果的衡量标准,并分析了新出现的群体动态。他们评估了零样本环境中几种领先的 LLM,发现不同任务的性能差异很大,突出了本地信息限制带来的困难。虽然出现了一些协调,但结果表明,在这些分散场景中,不确定性条件下的鲁棒规划和战略形成存在局限性。在类似于蜂群的条件下对 LLM 进行评估,对于实现其在未来分散系统中的潜力至关重要。

论文链接:https://arxiv.org/abs/2505.04364

9.迈向多模态通才之路:General-Level、General-Bench

多模态大语言模型(MLLM)不仅能够理解模态,还可以跨模态生成。它们的能力已从粗粒度多模态理解扩展到细粒度多模态理解,从支持有限模态扩展到支持任意模态。虽然有许多基准可用于评估 MLLM,但还是出现了一个关键问题:我们是否可以简单地认为,在各种任务中表现出更高的性能表明 MLLM 的能力更强,从而使我们更接近人类级别的人工智能?

来自新加坡国立大学、南洋理工大学、浙江大学的研究团队及其合作者认为,答案并不像看起来那么简单。他们推出了 General-Level 评估框架,该框架定义了 MLLM 性能和通用性的 5 个等级,提供了一种方法来比较 MLLM,并衡量现有系统在实现更强大的多模态通用性以及最终实现 AGI 方面的进展。该框架的核心是“协同”(Synergy)概念,即衡量模型在理解和生成过程中以及在多种模态下是否保持了一致的能力。为了支持这一评估,他们提出了 General-Bench,它涵盖了更广泛的技能、模态、格式和能力,包括 700 多个任务和 325800 个实例。评估结果涉及现有的 100 多种 MLLM,揭示了通才的能力排名,凸显了实现真正人工智能所面临的挑战。

论文链接:https://arxiv.org/abs/2505.04620

整理:学术君

如需转载或投稿,请直接在公众号内留言

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢