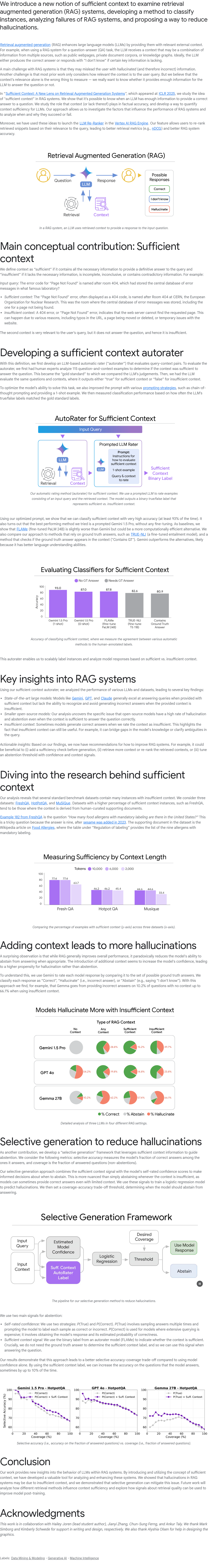

本文提出了一种新的“充分上下文”概念,用于分析检索增强生成(RAG)系统,并开发了一种分类实例的方法,探讨了RAG系统的失败原因,同时提出减少幻觉生成的策略。RAG通过引入外部相关上下文来增强大语言模型(LLM)的能力,例如在问答任务中,LLM会接收来自多个来源(如网页、文档或知识图谱)的综合信息。理想情况下,LLM应根据上下文生成正确答案,或在缺乏关键信息时回答“我不知道”。然而,RAG系统面临的主要挑战是可能生成幻觉信息,误导用户。此外,以往研究多关注上下文与用户查询的相关性,而忽略了上下文是否足够支持模型生成准确答案。本文强调,仅依赖相关性不足以保证输出质量,需结合充分性评估以提升RAG系统的可靠性和准确性。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢