DRUGAI

本文介绍一篇来自浙江大学侯廷军、谢昌谕和康玉团队联合发表的一篇论文。该研究提出了一种仅使用词元的三维药物设计模型Token-Mol,可以将二维和三维结构信息以及分子性质编码为离散的词元。Token-Mol基于Transformer解码器构建,采用因果掩码进行训练,并针对回归任务提出了高斯交叉熵损失函数(GCE),取代了传统的交叉熵损失。这种创新的损失函数在训练过程中为每个词元分配权重,使其能够感知数值词元的大小。Token-Mol在多个下游任务的测试中表现优异,有望成为创新药物研发的有力工具。

研究背景

近年来,人工智能(AI)技术取得了巨大进步,正逐渐渗透到药物开发的各个环节,有望缩短新药研发周期,降低研发成本。然而,药物发现领域在数据层面仍面临严峻挑战。获取高质量、带注释的数据集成本高昂,这已然成为制约该领域进一步发展的重大瓶颈。最近,以BERT和 GPT为代表的无监督学习框架迅速发展,这些框架在药学和生物学等多个学科中催生了大量无监督的预训练模型。这些预训练模型先经过大规模无监督训练,深入学习小分子或蛋白质的表征信息,之后再针对特定应用场景进行微调。通过在大规模数据集上运用无监督学习,这些模型成功应对了稀疏词元和分布外泛化不佳的难题,显著提升了在药物研发相关任务中的性能表现。

尽管大模型在药物设计领域取得了令人瞩目的进步,但现有模型仍存在不可忽视的局限性。基于化学语言的大规模分子预训练模型虽在处理分子序列信息方面表现出色,却无法有效处理三维结构信息,而三维结构信息对于精准确定分子的物理、化学和生物学性质至关重要。相比之下,基于图的分子预训练模型能够更好地整合三维信息,为分子性质研究提供了更全面的视角。不过,现有基于图的分子预训练模型大多聚焦于学习用于性质预测的分子表征,而在分子设计这一关键环节上尚未取得实质性突破。此外,将这些专业模型与通用自然语言处理(NLP)模型进行集成,面临着技术、数据格式和模型架构等多方面的巨大挑战。不同模型之间的兼容性问题,导致难以构建一个能够处理所有药物设计任务的综合模型。因此,如何克服基于化学语言的预训练模型和基于图的预训练模型各自的局限性,开发出一种既适用于各类药物设计场景,又能轻松与现有通用大语言模型集成的化学大模型,已成为当下药物研发领域亟待突破的关键问题。

方法概述

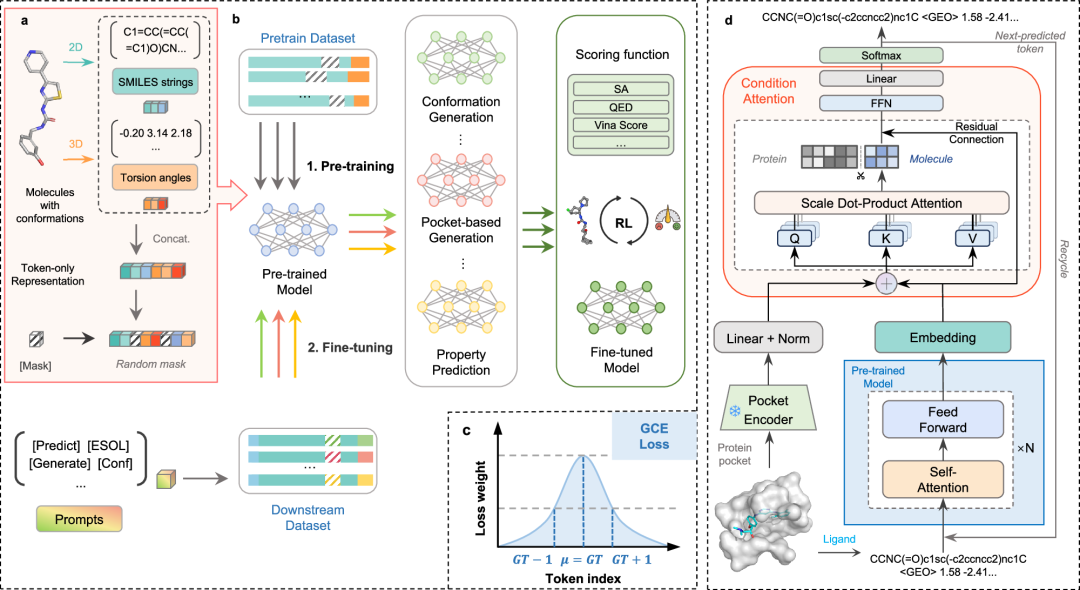

本研究提出了分子预训练的大语言模型Token-Mol。为了增强与现有通用模型的兼容性,该研究采用仅基于词元的训练范式,将所有回归任务重新定义为概率预测任务。Token-Mol采用Transformer解码器架构构建,通过SMILES和扭转角词元整合关键的二维和三维结构信息。此外,在预训练过程中,利用泊松分布和均匀分布的组合随机掩码训练数据。这种策略增强了模型的填空生成能力,提高了它对各种下游任务的适应性。为了解决仅基于词元的模型对数值敏感度有限的问题,该研究引入了高斯交叉熵(GCE)损失函数,取代了传统的交叉熵损失。这种创新的损失函数在训练过程中为每个词元分配权重,使模型能够学习数值词元之间的关系。此外,Token-Mol与其他先进的建模技术(包括微调和强化学习(RL))具有出色的兼容性。Token-Mol在分子构象任务中,在两个数据集上生成的表现提高超过10%和20%,同时在性质预测任务方面优于其他仅基于词元的模型达30%。在基于口袋的分子生成中,相比起其他专家模型,Token-Mol分别将药物相似性和合成可及性提高了约11%和14%, 在生成速度上相较于基于扩散模型的专家模型快35倍。在模拟真实世界场景的生成中,Token-Mol提高了生成分子到达特定目标的成功率。与强化学习相结合后,模型进一步优化了生成分子的亲和力和药物相似性。

图 1. Token-Mol流程示意图

结果与讨论

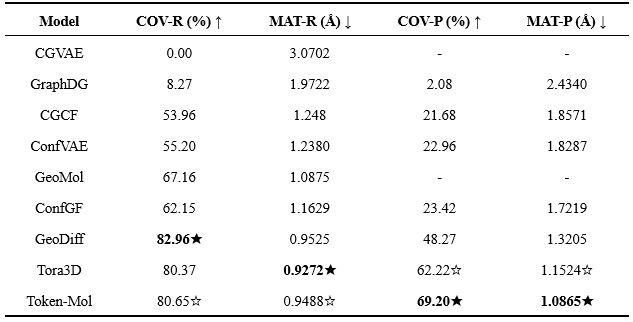

分子构象生成

研究人员在两个数据集上进行了评测。结果表明,对测试集I,Token-Mol在两个精确率指标上均超越了基准方法(表1)。值得注意的是,Token-Mol在COV精确率(COV-P)指标上取得了显著提升,比Tora3D高出约11%,这表明了Token-Mol生成的分子相较于其他方法具有更高的质量。然而,与GeoDiff和Tora3D相比,Token-Mol生成的构象在召回率方面表现略低,总体排名第二。对测试集II,Token-Mol在基于精确率的两项评估指标COV-P和MAT-P上均取得了最佳成绩,分别比其他模型高出约24%和21%(表2)。

表1. 模型在测试集I上的性能对比

表2. 模型在测试集II上的性能对比

分子性质预测

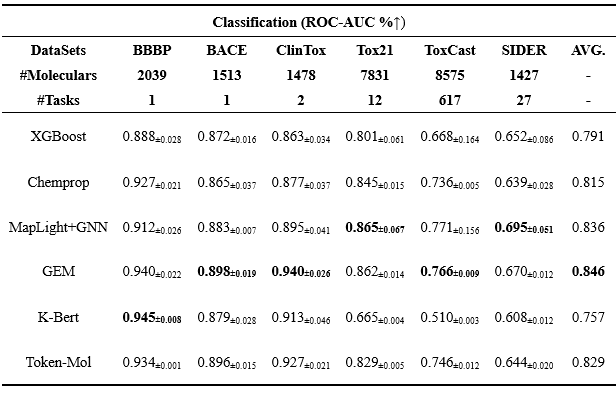

分类任务

Token-Mol与五个不同类型的基线模型进行了比较:XGBoost(传统机器学习模型)、K-Bert(基于序列的模型)、Chemprop(图神经网络模型)、GEM(几何增强图神经网络模型)以及MapLight+GNN(传统机器学习与图神经网络相结合的集成模型)。如表3所示,Token-Mol在所有数据集上均表现出色,其准确率优于XGBoost和Chemprop,尽管在一定程度上落后于MapLight+GNN和GEM。

表3. 分类任务上的性能对比

回归任务

Token-Mol在所有任务中都超越RT,平均性能提升约30%。尤其值得一提的是,Token-Mol在Aqsol数据集上实现了约50%的提升。此外,如表4所示,在Aqsol、LD50等拥有大量数据的数据集上,Token-Mol的表现与基于图神经网络的模型相近。

高斯交叉熵(GCE)

仅基于词元的生成模型通常在回归任务中使用交叉熵损失函数,但它们往往对数值不敏感,无法捕捉数值之间的关系。为解决这一问题,该研究针对分子性质预测中与回归相关的下游任务提出了高斯交叉熵(GCE)损失函数。为评估GCE的有效性,该研究进行了对比实验。结果表明,缺少GCE会显著降低Token-Mol在所有数据集上的性能,均方根误差(RMSE)平均增加约12%,这凸显了GCE在回归任务中的关键作用。与将单个数值分解为多个词元表示的RT相比,Token-Mol采用单个词元预测方法并结合GCE,在预测准确性和效率上都有显著提升。

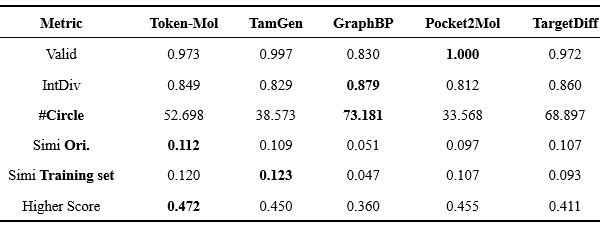

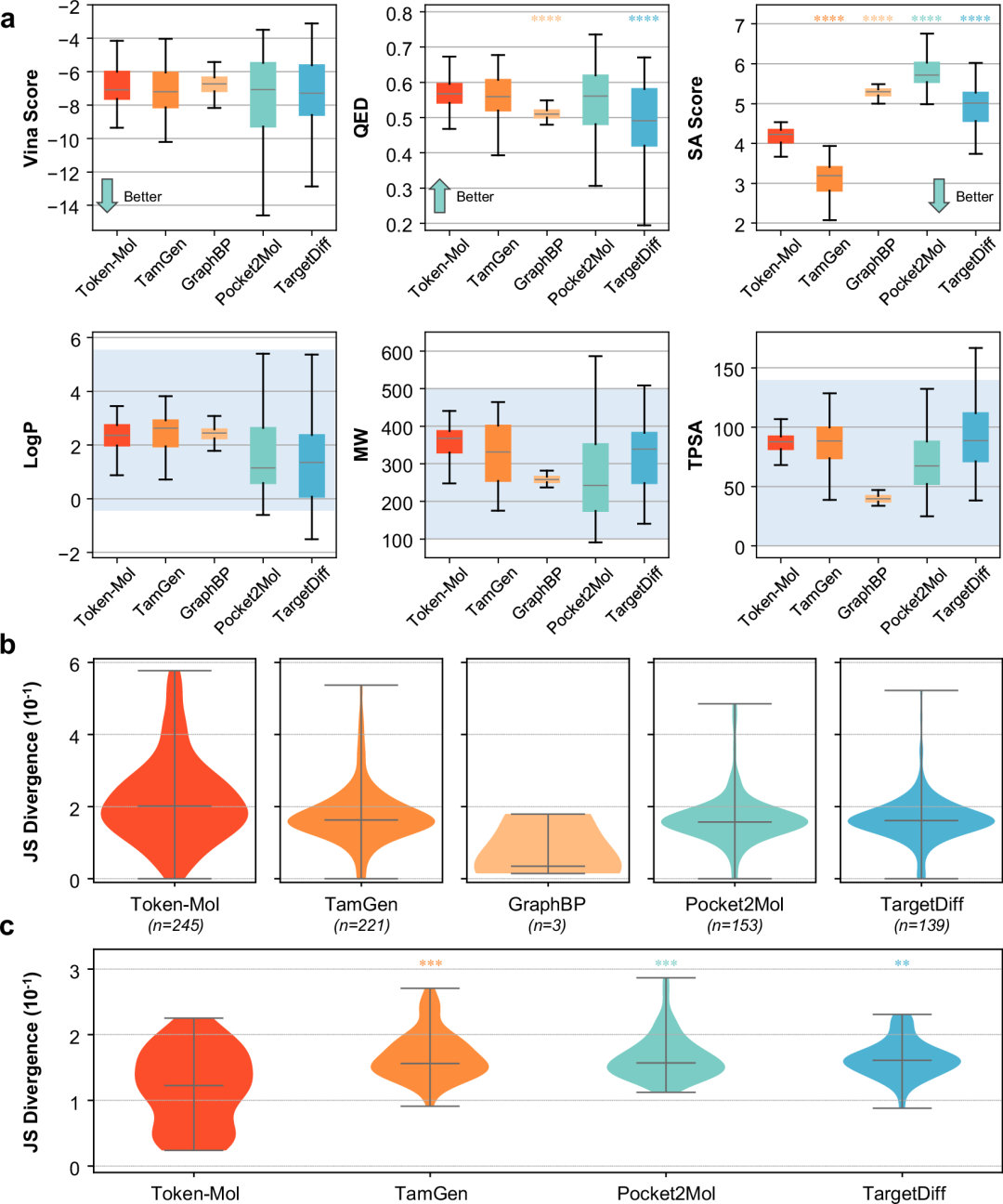

基于口袋的分子生成

在基于口袋的分子生成任务中,Token-Mol整合了ResGen口袋编码器和融合模块(如图1d)来表征蛋白质口袋,并在微调过程中确保其参数保持不变。此外,Token-Mol采用条件注意力机制来整合蛋白质和分子信息,这类似于一种提示机制,将蛋白质口袋信息融入到配体分子生成过程中。

如表4所示,Token-Mol生成的分子在整个分子集中表现出令人满意的性能。在有效性方面,基于图的模型往往会生成一些存在结构缺陷的分子,导致有效性降低。该实验在一定程度上证实了几个基于图的模型存在这一问题。在多样性方面,Token-Mol在内部多样性指标上与基线模型取得了相当的结果,而在基于球排除聚类算法,对化学空间覆盖更敏感的#Circle指标上获得了相对适中的结果。

表4. 模型生成的分子的属性对比

对于相似性而言,基于图的模型相似性相对较差,而基于序列的模型相似性水平则相近。从整体相似性和多样性的角度来看,Token-Mol在与未见口袋中的训练集和原始配体的相似性上达到了令人满意的0.1以上的同时保持了足够的多样性。此外,Token-Mol生成的分子中约47.2%相比原始配体表现出更高的对接打分,超过了基线模型(图2a)。

图2. Token-Mol模型与基线模型之间分子性质的分布情况

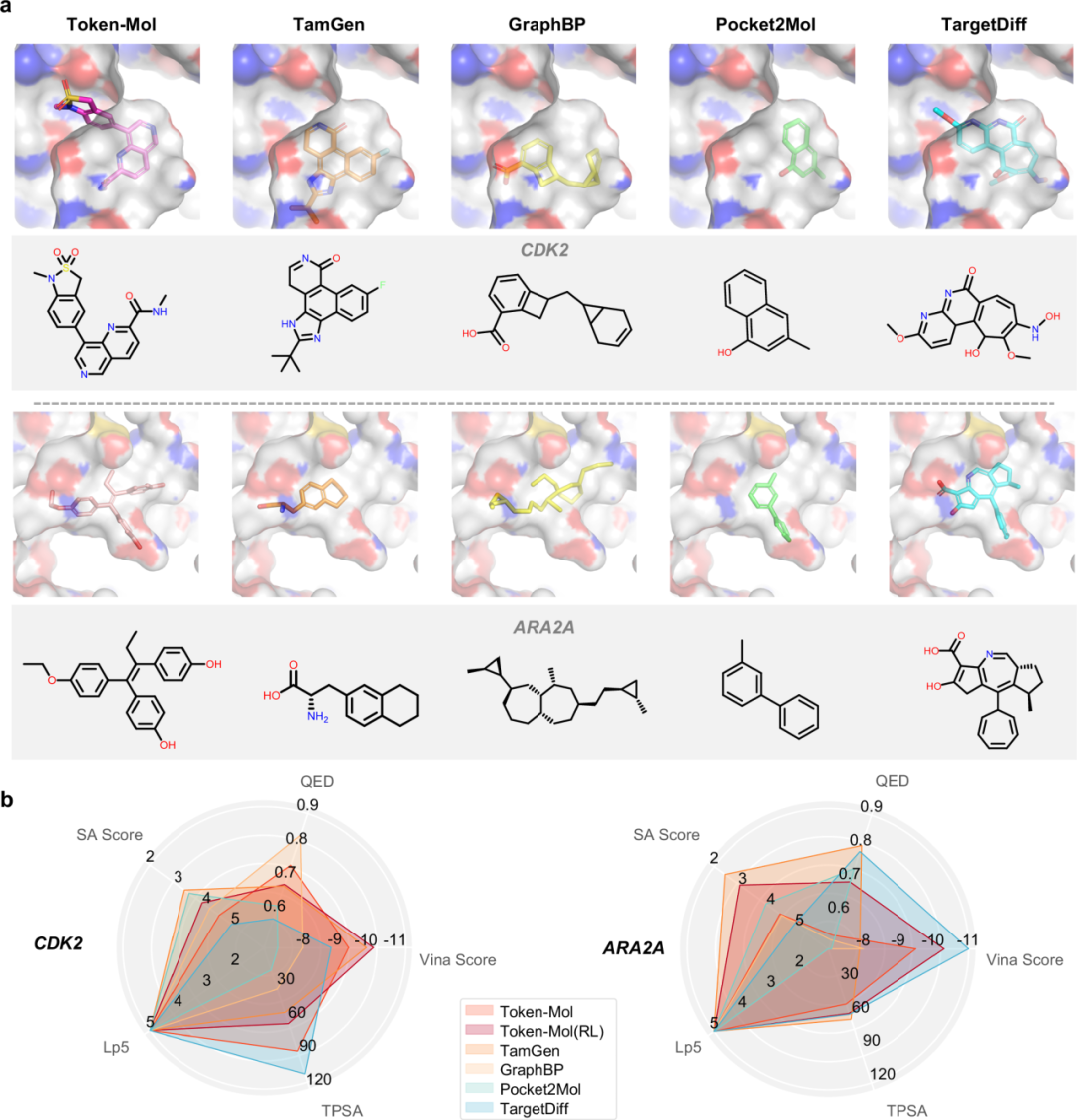

针对真实世界靶点的药物设计

为了评估模型在为现实世界治疗靶点设计候选药物方面的生成能力,该研究从三个重要的蛋白质家族(即激酶、G蛋白偶联受体(GPCRs)和病毒蛋白)中选取了8个靶点。TamGen在大部分靶点中有着一定的优势,其生成的类药分子比例比Token-Mol高出数倍。然而,额外分析揭示了TamGen生成的类药分子比例与原始配体的pIC50值之间存在强正相关,皮尔逊相关系数为0.81,而其他方法得分均低于0.5(原文补充表8)。在这种情况下,模型可能在仅包含天然配体、通过简单筛选获得的低亲和力配体中表现不佳。例如,在3CLPro的案例中,口袋内的原始高亲和力配体是共价结合的,而与之结构相似的非共价配体特拉匹韦的实际亲和力为18 μM。相比之下,Token-Mol这个靶点上表现出色,大约25%的生成分子在保持优良类药性质的同时,对接打分超过了参考配体的平均水平。总体而言,尽管Token-Mol并非在所有靶点上都取得最佳结果,但其展现出了稳定的泛化能力,为未知靶点生成了相当比例的有潜力分子。

表5. 针对真实世界靶标生成分子性能的对比

图 3. 针对真实世界靶标评估

此外,研究人员从两个重要家族中选取了两个表现中等的靶点进行评测。如图3所示,Token-Mol生成的分子在这两种结构和功能差异显著的蛋白质靶点口袋中,展现出良好的类药性、可合成性以及可观的亲和力。与其他模型生成的分子相比,这些分子具有更合理的结构,并且在两个不同靶点之间呈现出不同的结构骨架。

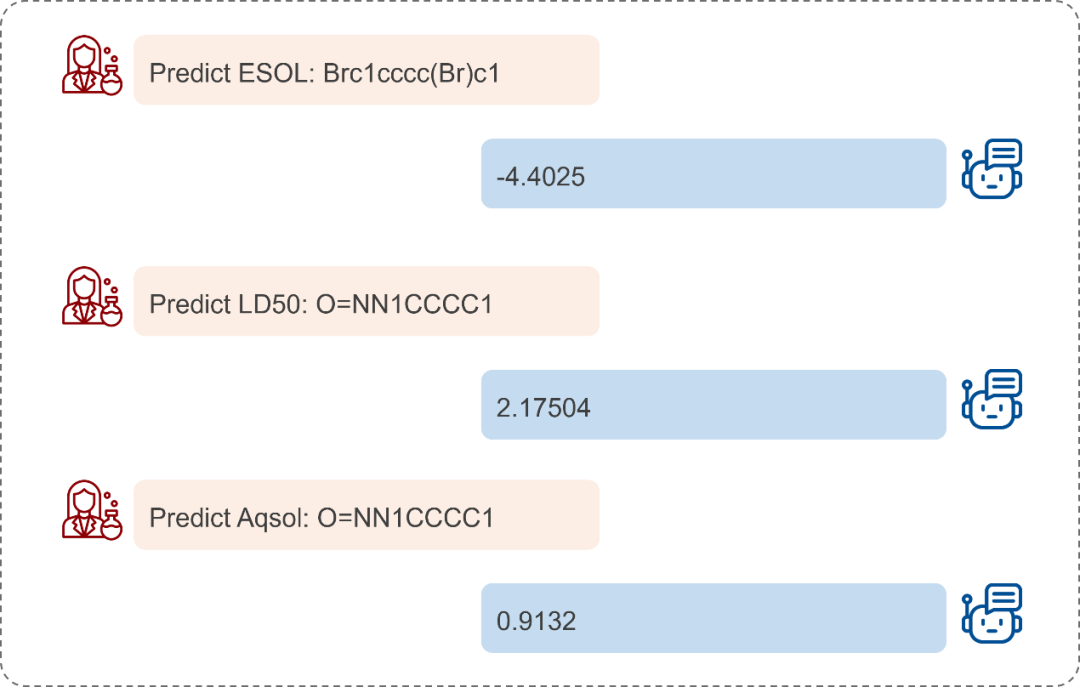

与Token-Mol对话

Token-Mol的纯词元框架相比传统回归模型具有显著优势,它能够无缝集成前沿的大规模模型技术,包括提示学习、专家混合(MoE)以及检索增强生成(RAG)。在此,研究人员展示了一个提示学习的实例。该应用突出了纯词元模型能够与通用模型无缝集成的独特之处,这是传统的回归模型所不具备优势。

图 4. Token-Mol对话实例

总结

本研究提出了一个用于药物设计的仅基于词元的基础模型Token-Mol 的初始版本。它的开发为统一人工智能药物设计模型提供了新的途径,为使用单一基础模型进行全流程的药物设计奠定了基础。

参考资料

Wang, J., Qin, R., Wang, M. et al. Token-Mol 1.0: tokenized drug design with large language models. Nat Commun 16, 4416 (2025). https://doi.org/10.1038/s41467-025-59628-y

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢