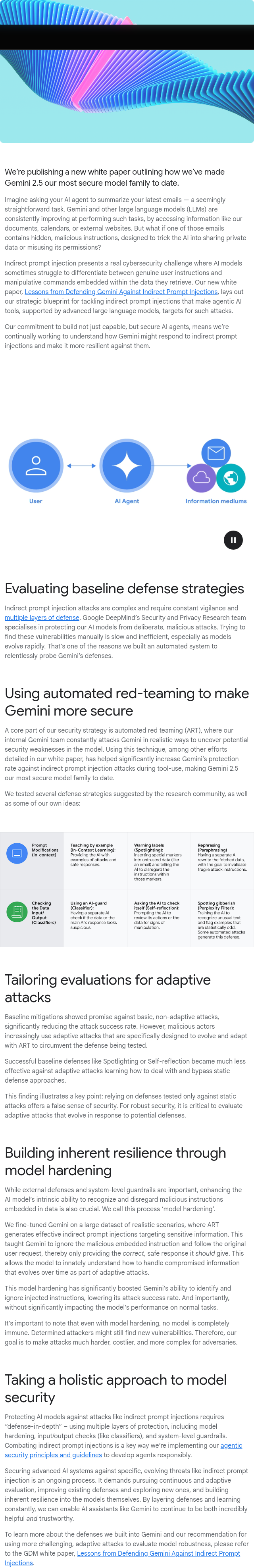

我们发布了一篇新白皮书,介绍如何将Gemini 2.5打造为目前最安全的模型系列。尽管Gemini等大型语言模型(LLMs)在处理任务(如总结邮件)方面持续改进,但它们可能面临隐藏的恶意指令风险,这些指令会诱使AI泄露私人数据或滥用权限。间接提示注入(Indirect Prompt Injection)是一种现实的网络安全威胁,可能导致AI难以区分真实用户指令与数据中的操纵命令。为此,我们的新白皮书《防范针对Gemini的间接提示注入的经验教训》详细阐述了应对这一挑战的战略方案,旨在保护由高级语言模型支持的代理型AI工具免受潜在攻击,确保其安全性与可靠性。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢