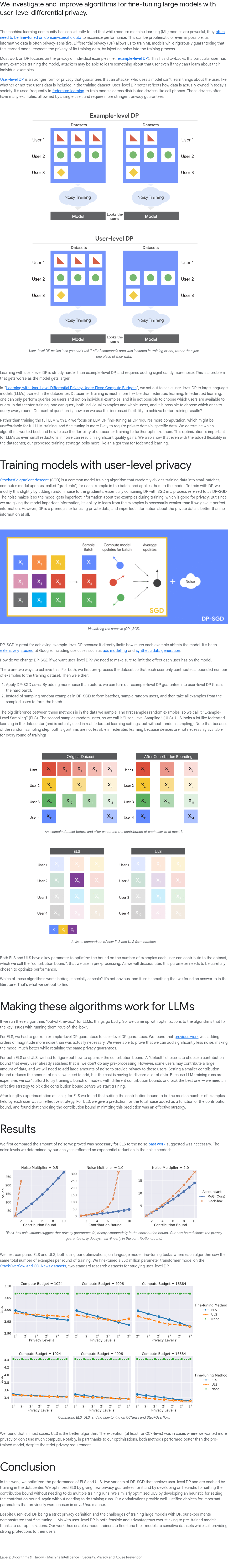

本文研究并改进了在用户级差分隐私(User-level DP)约束下对大型模型进行微调的算法。现代机器学习模型虽然功能强大,但通常需要在特定领域的数据上进行微调以达到最佳性能。然而,这些数据往往包含隐私敏感信息,使得微调变得困难甚至不可行。差分隐私(DP)通过在训练过程中注入噪声,确保模型不会泄露训练数据的隐私。传统的DP方法主要关注单个样本的隐私(例级DP),但这种方法存在局限性:如果某个用户提供了大量数据,攻击者可能仍能从模型中推断出关于该用户的信息,即使无法获取具体样本的细节。用户级DP提供了一种更强的隐私保护形式,确保攻击者无法从模型中获取有关用户的任何信息,从而更好地保护用户隐私。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢