新智元报道

新智元报道

【新智元导读】刚刚,全新AI基准测试工具xbench诞生,通过双轨评估体系和长青评估机制,追踪模型能力与实际场景价值。

随着基础模型的快速发展和AI Agent进入规模化应用阶段,被广泛使用的基准测试(Benchmark)却面临一个日益尖锐的问题:想要真实地反映AI的客观能力正变得越来越困难。

因此,构建更加科学、长效和如实反映AI客观能力的评测体系,正在成为指引AI技术突破与产品迭代的重要需求。

有鉴于此,红杉中国今天正式推出一款全新的AI基准测试工具xbench,并发布论文《xbench: Tracking Agents Productivity ,Scaling with Profession-Aligned Real-world Evaluations》。

在评估和推动AI系统提升能力上限与技术边界的同时,xbench会重点量化AI系统在真实场景的效用价值,并采用长青评估的机制,去捕捉Agent产品的关键突破。(点击文末【阅读原文】即可下载阅读本论文,建议使用电脑端进行下载)

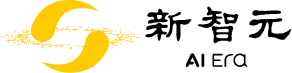

xbench采用双轨评估体系,构建多维度测评数据集,旨在同时追踪模型的理论能力上限与Agent的实际落地价值。该体系创新性地将评测任务分为两条互补的主线:(1)评估AI系统的能力上限与技术边界;(2)量化AI系统在真实场景的效用价值(utility value)。其中,后者需要动态对齐现实世界的应用需求,基于实际工作流程和具体社会角色,为各垂直领域构建具有明确业务价值的测评标准。

xbench采用长青评估(Evergreen Evalution)机制,通过持续维护并动态更新测试内容,以确保时效性和相关性。我们将定期测评市场主流Agent产品,跟踪模型能力演进,捕捉Agent产品迭代过程中的关键突破,进而预测下一个Agent应用的技术-市场契合点(TMF,Tech-Market Fit)。作为独立第三方,我们致力于为每类产品设计公允的评估环境,提供客观且可复现的评价结果。

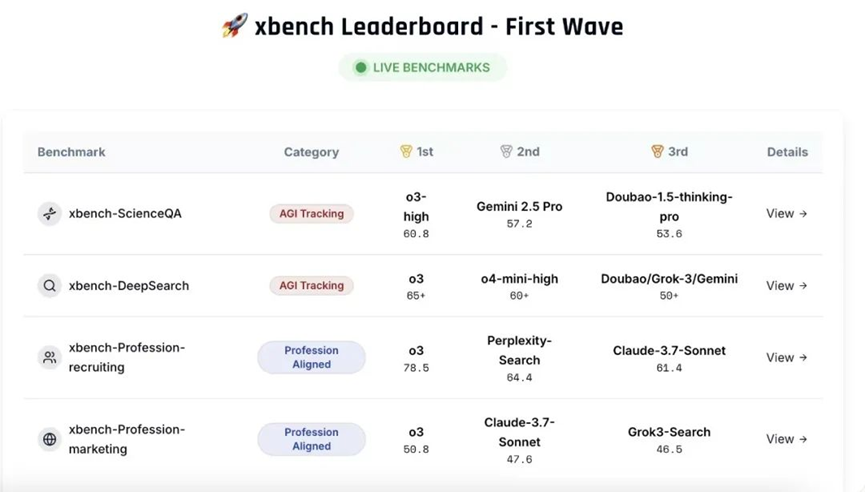

首期发布包含两个核心评估集:科学问题解答测评集(xbench-ScienceQA)与中文互联网深度搜索测评集(xbench-DeepSearch),并对该领域主要产品进行了综合排名。同期提出了垂直领域智能体的评测方法论,并构建了面向招聘(Recruitment)和营销(Marketing)领域的垂类Agent评测框架。评测结果和方法论可通过xbench.org网站实时查看。

在过去两年多的时间里,xbench一直是红杉中国在内部使用的跟踪和评估基础模型能力的工具,今天我们将其公开并贡献给整个AI社区。无论你是基础模型和Agent的开发者, 还是相关领域的专家和企业,或者是对AI评测具有浓厚兴趣的研究者,我们都欢迎你加入,成为使用并完善xbench的一份子,一起打造评估AI能力的新范式。

xbench Dual-track Leaderboard 2025.05

2022年ChatGPT推出后,红杉中国开始对AGI进程和主流模型实行每个月的评测与内部汇报。

2023年3月,我们开始建设xbench的第一批私有题库,题目类型主要针对Chatbot简单问答及逻辑思考,如:

· 香蕉的平方根是多少?

· 小明立志成为最成功的投资人,经过一番努力,最终他成功了。请问用什么谚语描述这个情况比较适合?

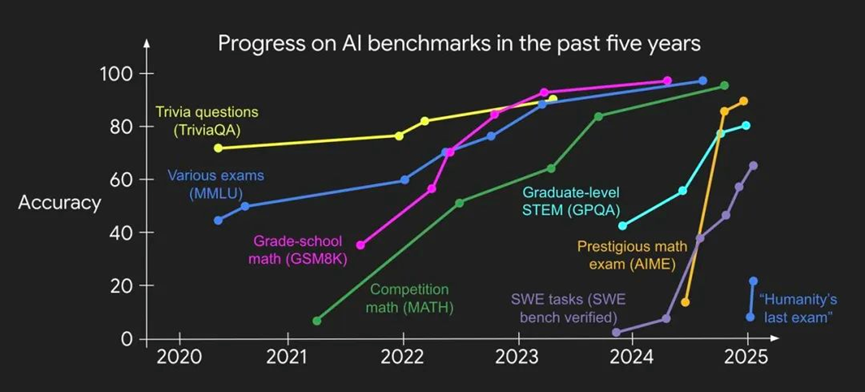

我们见证了主流模型从20-30分,在18个月内,提升到90-100分。2024年10月,我们第二次比较大规模地更新了xbench题库,换掉了所有模型都得满分的题,新题主要针对Chatbot复杂问答及推理,以及简单的模型外部工具调用能力(tool use),如:

· 设 f(x) 是一个奇函数,而 g(x) 是一个偶函数。那么, f(f(g(f(g(f(x)))))) 是奇函数、偶函数还是都不是?

· Q :将 /nt 目录下所有符合 ‘result_*.txt’ 格式的文件,按 * 数字从小到大的顺序,合并到一个文件中。并且命名为 ‘results_total.txt’ 。

我们再次见证了主流模型的进步,这一次的速度更快,主流模型在6个月内“刷爆”了我们的第二期题库。

评估的有效时间在急剧缩短(图源:姚顺雨个人博客)

2025年3月,我们开始第三次对xbench题库进行升级,但这一次,我们开始停下来质疑现有评估方式,思考两个核心问题:

1. 模型能力和AI实际效用之间的关系:我们出越来越难的题目意义是什么,是否落入了惯性思维?AI落地的实际经济价值真的和AI会做难题正相关吗?举个例子,程序员工作的utility value很高,但AI做起来进步非常快,而“去工地搬砖”这样的工作AI却几乎无法完成。

2. 不同时间维度上的能力比较:每一次xbench换题,我们便失去了对AI能力的前后可比性追踪,因为在新的题集下,模型版本也在迭代,我们无法比较不同时间维度上的单个模型的能力如何变化。在判断创业项目的时候,我们喜欢看创业者的“成长斜率”,但在评估AI能力这件事上,我们却因为题库的不断更新而无法有效判断。

为了应对上述两个核心问题,我们迫切需要构建新的评估平台,并重点面向:

■ 打破惯性思维,为现实世界的实用性开发新颖的任务设置和评估方式

以「Search」能力为例,AI能力评估集的进化路径可能是:

Single-turn QA→Search→Deep Search(Multi-step reasoning)→Deeper Search(Multi-hop or Chained Reasoning)

如果我们跳脱出“研究视角”惯性,转向“市场与业务视角”,任务和环境的多样性会爆炸式增长,Search类的题就会变成:

→Marketing→KOL Search→「一家智能投影仪品牌计划在中东市场进行内容投放,目标人群为 35 岁以下、有独立居住空间的科技早期用户,主要通过生活方式类博主触达。 AI Agent 需完成: ① 在中英文多平台上识别优质创作者,判断其内容调性是否贴近 ‘ 居家娱乐 + 智能家居 ’ ; ② 预测不同地区(如迪拜与利雅得)的 CTR 差异; ③ 辅助完成组合推荐。」→$6,000 (人工完成该任务需 3 名中东本地营销人员,约耗时 1 周,总成本约 $6,000 ( $2,000/ 人 / 周))

→Recruiting→People Search→「一家头部 VC 支持的多模态大模型初创公司,正在寻找一位 ‘ 具备高质量开源项目经验、熟悉 transformer 架构、曾在 FAIR 或 DeepMind 实习 / 合作过 ’ 的 AI 工程负责人。目标候选人不一定在招聘平台上活跃,大部分信息分布在 GitHub 、 arXiv 、 X (原 Twitter )、海外社区论坛中。 AI Agent 需完成: ① 跨平台搜索与聚合; ② 候选人背景重建(教育、项目、实习); ③ 对技术契合度自动评分; ④ 生成 Cold outreach 策略邮件草稿。」→¥9,000 (人工完成该任务,通常需1名高级猎头 +1名技术研究员,耗时约 1 周,人力总成本约 ¥9,000 )

下半场的评估,不仅需要越来越难的AI Search能力的考察基准(AI Capabilities Evals),也需要一套对齐现实世界专家的实用性任务体系(Utility Tasks)。

前者考察的是能力边界,呈现是Score,而后者考察的是实用性任务和环境多样性、商业KPIs(conversion rate、closing rate)和直接的经济产出。

我们引入Profession Aligned的基准概念,我们认为接下来的评估会分为AGI tracking与Profession Aligned,AI将面临更多复杂环境下效用的考察,从业务中收集的动态题集,而不单是更难的智力题。

■ 建立长青评估体系

静态评估集一旦面世,会出现题目泄露导致过拟合然后迅速失效的问题。我们将维护一个动态更新的题目扩充评估集来缓解这一现象。

针对AI Capacity Evals:学术界提出了很多出色的方法论,但是受限于资源与时间不充分,无法维护成动态扩充的持续评估。我们希望能延续一系列公开评估集的方法,并提供第三方、黑白盒、Live的评测。

针对Profession Aligned Evals:我们希望建立从真实业务中Live收集机制,邀请各行业的职业专家与我们共同构建和维护行业的动态评估集。

同时,在动态更新的基础上,我们设计可横向对比的能力指标,用于在时间上观察到排名之外发展速度与关键突破的信号,帮助我们判断某个模型是否达到市场可落地阈值,以及在什么时间点上,Agent可以接管已有的业务流程,提供规模化服务。

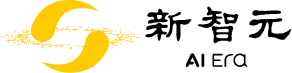

我们推出xbench双轨系列评估集,分为xbench-AGI Tracking与xbench-Profession Aligned。我们将AGI Tracking评测视为Agent应用落地的基础台阶,而Profession Centric评测则是对接真实生产场景的高阶实践。

AGI track评测旨在验证模型在特定能力维度上是否从0到1具备了智能表现,这类评测的关键是要足够难和巧妙、足够有区分度,来挖掘“智能”而非“系统”的边界。只有当某个AI关键能力在AGI Tracking中实现从0到1的突破,才可能进一步解锁更多专业工作流程,进入Profession Aligned评测的范畴。

Profession Aligned评测则聚焦于现实生产场景,是把Agent当成一个数字员工放在具体业务流程里来进行考察。其评估核心并非智能存在与否,而是在真实场景下的交付结果和商业价值。

Profession Aligned可以有很多类型应用来解决,评估不会限定解决方案,只会考核结果。另外,Profession Aligned评估从对生产力的需求出发,是定义垂类应用/寻找垂类AI解决方案,即使这个场景应用还没有做出来。

以营销和人力资源场景为例,我们通过对xbench AGI track中xbench-DeepSearch评测指标追踪,认为AI search这一关键模型能力正在快速成熟,寻找简历、分析候选人匹配度,在各大平台上寻找KOL、分析KOL与需求的匹配度,都是潜在AI能实现的工作流。于是我们开始构建xbench-Profession-Recruitment及xbench-Profession-Marketing希望对齐Agent业务落地价值,预测TMF的时间点。

在AI Search之外,随着AI关键能力可预见的拓展至多模态理解和生成,营销素材的生产和投放会被纳入可能达到TMF的环节-进入Profession Aligned评估的测试范围内。

同样,应用于recruiting时,senior recruiter的工作流不局限于people search、people evaluation,更难的在于对候选人长期维护和沟通甚至是薪酬谈判和达成交易环节——这里AI具备长期记忆、竞争和决策博弈等核心职能,也是下一个阶段关键智能的突破方向,我们会持续监测关键能力突破并增加Profession-Aligned测评的丰富度。

2023-2024年大模型在知识、多模态、记忆、指令遵循与推理能力上取得显著突破,这些突破的积累造成了Agent应用能力的爆发——但仍然在长期记忆、可信度、问题发现、多智能体协作与博弈能力等上存在短板。

我们希望抓住AI尚未充分解决的核心能力,构建并持续维护对应的评估集。

我们相信针对这些关键能力,学术界提出了很多出色的方法论,但是受限于资源与时间不充分,无法维护成持续评测、动态扩充的评估。我们希望能延续一系列公开评估集的方法,并提供第三方、黑白盒、Live的评测。

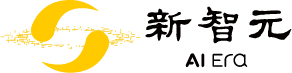

我们把Agent能力拆分成基础智能、专业实践能力、创新能力与组织能力,每个层级中我们会拆分出构成实现AGI的关键要素。

AI的发展不一定是从基础到高阶的顺序进行,我们可以预见的是,在AI获取了组织能力后依然存在基础可信度的问题。

这一次我们发布的xbench-ScienceQA与xbench-DeepSearch评估属于Knowledge与Tool Use的子类别,测试Agent在这两项主能力分类下的子任务能力。后续我们会围绕这些关键问题持续发布新的评估,并追踪市面产品的表现。

■ xbench-ScienceQA: 考察基础智能-知识

该评测集用于测试研究生水平的学科知识和推理能力。我们收集可靠、多领域、高等教育难度、搜索引擎上缺少的、答案明确的高质量题目数据。

已有的相关评估集如GPQA、SuperGPQA等获得了很大认可与关注,但他们均为一次性发布,缺少定期更新的机制。无法有效检查评估集泄露的程度。

我们希望建设出一个按照季度更新的ScienceQA题目数据,并每月持续汇报最新模型的能力表现,每季度更新一次。

我们邀请来自顶级院校的博士研究生以及资深行业专家出题,并采用LLM难度检验、搜索引擎检验、同行检验等方式确保题目的公正性、区分度与正确性。

■ xbench-DeepSearch :考察专业生产力-工具使用

自主规划(Planning)→信息收集(Search)→推理分析(Reasoning)→总结归纳(Summarization)的深度搜索能力是AI Agents通向AGI的核心能力之一,也给评估带来了更难的挑战。

基于简单事实的评估集如SimpleQA、Chinese SimpleQA能够评估信息收集能力,但缺乏对自主规划和推理分析能力的考察;基于前沿科学的评估集如HLE、AIME擅长考察模型的推理分析能力,但弱于自主规划和信息收集能力的度量。

为了更好的考察Agents的深度搜索能力,我们推出并开源了xbench-DeepSearch评测集,具备以下特点:

• 适应中文互联网环境,降低搜索信息源对结果的影响;

• 难度高,要求Agent具备规划+搜索+推理+总结的端到端综合能力;

• 所有题目经由人工出题并交叉验证,保证题目的新颖性,答案的正确性和唯一性,方便自动化评测;

• 持续更新,每月持续汇报最新模型的能力表现,每季度更新一次评估集。

我们认为2025年我们会见证AI更多在基础智能与专业生产力上的进展,今年我们的后续评估中会关注:

1. 具有思维链的多模态模型能否生成商用水平视频?(多模态,推理,工具使用)

2. MCP 工具大面积使用是否具有可信度问题?(工具使用,可信度)

3. GUI Agents 能否有效使用动态更新 / 未训练的应用?(工具使用,测试时学习)

追求与真实世界任务对齐是目前AI评估的核心诉求,这里我们提出以专业工作为中心的构建方法。

已有的真实世界评估通常是以AI能力为中心,去广泛地覆盖不同场景与领域,这对于指导通用模型的迭代非常有价值。

然而Agent应用通常需要解决垂类场景任务,并针对垂类需求进行定制设计,此时通用评估结果的参考价值下降。

我们看到在Coding、客服与医疗领域出现高质量的评估,并带动了对应专业Agent能力的快速演进与产品化。专业中心的评估会快速在更多领域延展开,其占主流AI评估的比重也会快速提升。

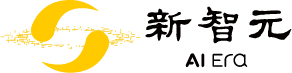

面向专业工作的评估是希望从特定职业专家出发,分析它自身的工作流与思维模式,构建出与专家行为对齐的任务、执行环境与验证方式,流程如下图所示:

xbench Profession Aligned的构建遵循如下三条核心原则:

• 评估由需求定义:针对一个职业构建评估集,优先梳理其业务流程与任务分类,聚焦于可评估的任务项。对于部分暂不可评估的任务,通过模拟方式转化为可评估形式。

• 评估任务随时间逐渐产生的从专家业务中Live收集:任务并非“出题”生成,而是在专家日常业务中逐步积累与收集。对于动态变化的任务,我们持续从真实业务流中获取与市场最贴近的评估内容。

• 领域价值驱动评估目标:每项任务标注专家完成所需时间,并结合薪资基准估算任务的经济价值。每个任务预设TMF目标,一旦Agent达标则停止更新,Profession-Aligned的评估难度追求实际匹配,而不是持续变难。

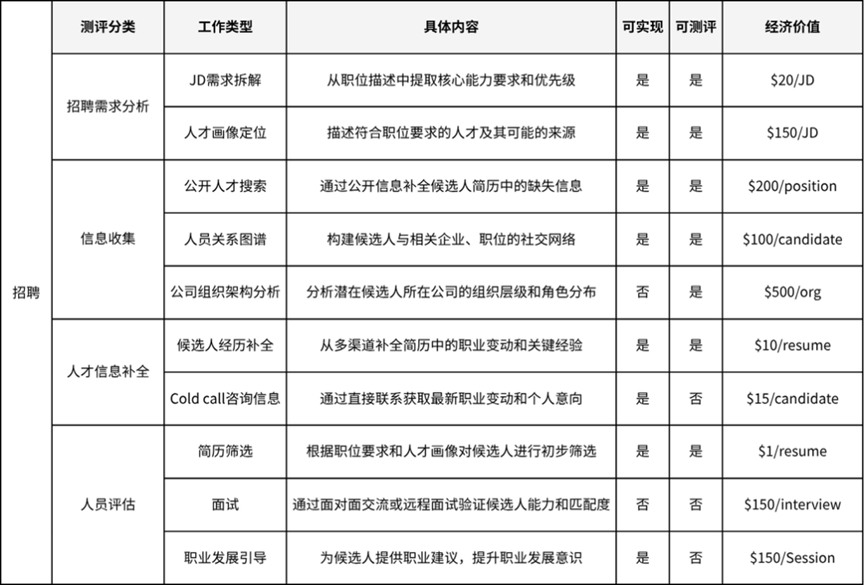

这里我们以招聘专家为例,设计xbench-Profession-Recruitment。

我们通过与多家头部猎头企业合作,梳理专家每周工作在不同任务上的时间分配。并让专家对这些任务的重要性进行评估,筛选出领域工作的拆分图谱。

下面是一个结构化的工作任务拆解和经济价值的对齐,以及对任务在现阶段可实现性和可评测性的梳理:

在每个单项任务中,我们从现有技术角度分析其可测性与可行性。第一期xbench-Profession-Recruitment收录了JD需求拆解、人才画像定位、候选人经历补全、人物关系理解、公开人才搜索等几类任务。

我们与专业猎头公司,以及具有充分历史业务数据积累的营销企业分别共建了xbench-Profession-Recruitment与xbench-Profession-Marketing这两个评估任务。可以点击文末【阅读原文】,在论文中看到更多结果。

我们会以实际生产力需求为出发点,通过上述方法论,联合行业专家拆解专业工作流程形成任务,定义客观、可复现的评价指标,逐个构建Profession Aligned的评估集,先于垂类应用定义出能力目标,用eval指导profession agent的落地。

预计将陆续拓展至金融(Finance)、法律(Law)、销售(Sales)等高价值专业领域的评估任务体系构建。我们欢迎来自相关领域的专家学者、产业企业、研究机构参与共建,共同推进Profession-Aligned Eval的发展。

静态评估集会出现题目泄露的问题。如LiveBench与LiveCodeBench评估的出现,利用动态更新的题目扩充评估集,缓解了题目泄露的问题,然而,在Agent应用的评估任务中仍有新挑战。

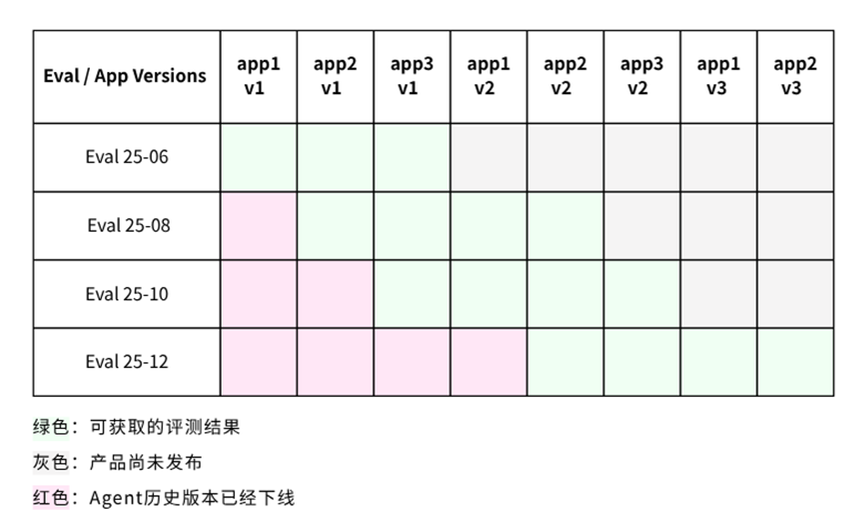

首先,Agent应用的产品版本是具有生命周期的。Agent产品的迭代速度很快,会不断集成与开发新功能,而旧版本Agent可能会被下线。我们虽然可以在同一时间测试同类Agent不同产品的能力,但是不能比较不同时间的产品能力进步。

同时,Agent接触的外部环境也是动态变化的。即使是相同的题目,如果解题需要使用互联网应用等内容快速更新的工具,在不同时间测试效果不同。

上述表格展示了针对Agent的Live评测可获取的结果。利用该结果可以得到同期不同产品的排名,但是由于评估环境与任务的调整,不同期评测之间的能力增长是没有捕捉到的。因此我们希望解决如下问题:

评估集与模型不断迭代情况下,设计指标追踪Agent能力的持续增长。

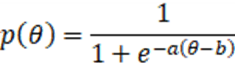

统计上,我们可以针对残缺得分矩阵估计每个Agent版本的能力主成分。我们采用项目反应理论(Item Response Theory, IRT)完成对Agent Capability的估计。IRT理论把被测对象能力θ

这个公式满足题目得分概率p

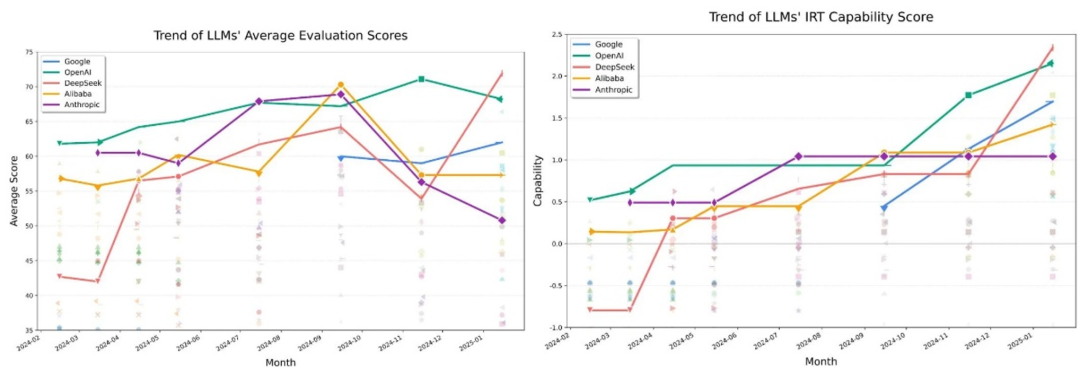

我们使用OpenCompass动态更新的评估结果来验证IRT方法(https://rank.opencompass.org.cn/leaderboard-llm/?m=25-01)。

该榜单从2024年2月开始,每隔1-3个月更新一次题库并发布评估结果,下面左图展示了不同模型在评估时间评测的得分,相同系列模型被同一颜色的线进行连接。虽然榜单结果很好显示了每次评估时模型能力排序,但因为题目更新,不同时间模型得分时不具有可对比性。

而利用IRT估计的能力得分,则可以很好地体现模型能力持续增长的趋势。我们可以观察到2024年10月之后Google Gemini模型能力的快速跟进,以及Deepseek v2与r1发布所带来的两次明显提升。

在后续的Agent评估中,我们会持续汇报Agent评估集不同产品的IRT能力得分,用于在时间上观察到排名之外发展速度与关键突破的信号。

成本也是Agent应用落地的决定性因素之一。

Inference Scaling让模型与Agent可以通过投入更多推理算力来取得更好的效果。这种投入既可以来自于强化学习带来的更长思维链,也可以是在思维链的基础上引入更多次数的推理与汇总进一步提升效果。

然而我们在现实任务中需要考虑Inference Scaling带来的投入产出比,找到在花费、延迟与效果上的平衡。类似于ARC-AGI,我们会追求为每个评估集汇报在效果-成本图上的需求曲线、人类能力曲线以及现有产品的最优供给曲线。

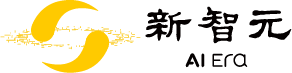

在Benchmark的得分-成本图上,我们可以划分出左上区域的市场接受区与右下的技术可行区。人力成本应当是市场接受区边缘的一部分。左图展示了技术尚未落地的状态,而中间图展示了TMF后的状态,而其中交叉部分是AI带来的增量价值。对于具有TMF的AI场景,人力资源应当更多投入在领域的前沿以及不可评估的任务,并且市场会因为人力资源与AI算力的稀缺性不同重新给人类贡献的价值定价。

我们认为每个专业领域会经历3个阶段:

1. 未达成TMF:技术可信与市场接受区域没有交集,此时Agent应用仅是工具或概念,无法交付结果或规模化产生价值;Agent对人的影响较小。

2. Agent与Human共同工作:技术可信与市场接受区域发生交集,交叉区域是AI带来的价值增量,包括(1)以低于最低人类成本提供可行服务,(2)帮助提升应对重复性、质量要求中等的工作内容。而高水准的工作内容,由于数据稀缺、难度更高、依然需要人来执行,此时由于稀缺性,企业获取的AI Profit可能会被用于支付高端工作产出。

3. 专业化Agent:领域专家在构建评估体系,并指引Agent迭代。专家的工作从交付结果转向构建专业评估训练垂类Agents,并提供规模化服务。

其中从1.向2.的转变是由AI技术突破、算力与数据的Scaling带来的,而2.转向3.的进展依赖于熟悉垂类需求、标准、历史经验的专家。

此外,在部分领域中,AI可能带来新的满足需求的方式,改变已有的业务流程和生产关系组成方式。

AI可能会带来价值转移、改变人力需求的结构,我们相信社会会因为更高效的生产效率与商业模式增加人类的总体福利。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢