点击蓝字

关注我们

卡内基国际和平基金会

在发展之外,风险意识也开始上升到战略层面。报告指出,越来越多的中国政策制定者与技术专家意识到,AI系统已不仅是提升效率与创新能力的工具,更可能带来潜在的灾难性后果。这些风险包括模型被滥用于生成生物化学攻击配方、干预国家舆论场,甚至在极端情境下失控发展出脱离人类控制的目标行为。这种“深层风险感知”过去主要出现在国际AI治理讨论中,而如今正逐步被中国政策系统内部接受并制度化表达。

在这一背景下,中国于2025年2月正式推出“中国人工智能发展与安全研究网络”(China AI Safety and Development Association,以下简称CnAISDA),这是一个被称为“中国版AI安全研究所”的新兴机构。与美英等国的AI Safety Institute不同,CnAISDA并不承担前沿模型的国内测试职能,也不具备独立监管权,而是以“对外代表性”为核心功能。这一制度设计体现出中国在保持发展自主性的前提下,试图参与国际AI治理的现实考量。

图源:中国人工智能发展与安全研究网络官网(cnaisi.cn)

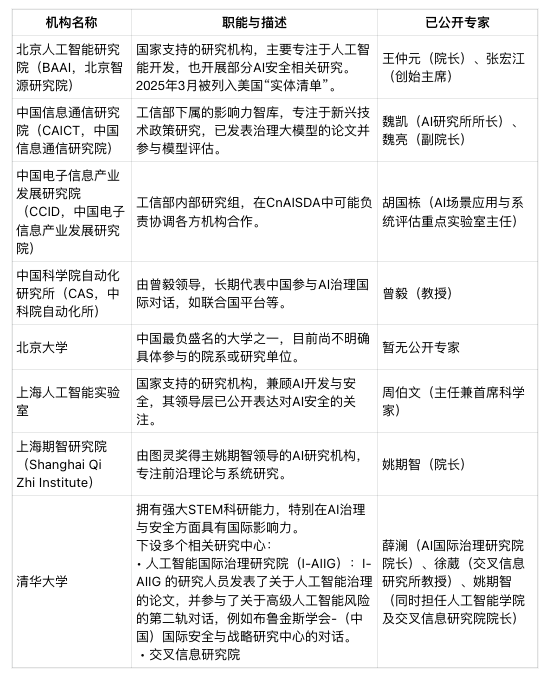

报告认为,CnAISDA的制度结构有其独特性:它以网络型联盟结构取代单一监管机构,由清华大学、智源研究院、中国信息通信研究院、上海人工智能实验室等具备前沿科研能力的机构组成。这样的设计不仅避免了政府在复杂技术路线中“指定赢家”的风险,也为各类政策参与者提供了制度缓冲空间,降低了集中风险。CnAISDA通过统一外部沟通口径、汇聚专家资源,成为中国对接国际AI安全讨论的“中性平台”,而非传统意义上的监管机构。

更为重要的是,CnAISDA的设立被看作是中国AI发展战略中“安全并重”的首次显性化制度表达。过去几年,中国在算法推荐、深度合成与生成式内容方面已出台多个监管条例,但这些多以“内容安全”为核心,主要防范模型生成对国家意识形态、舆论控制造成冲击。相比之下,CnAISDA更明确地聚焦“灾难性系统风险”,将模型可能触发的不可控危害纳入政策视野。这一转变不仅体现了治理逻辑的提升,也反映出一批政策创业者正在尝试将“风险-共识-治理”路径引入中国的AI战略框架中。

与此同时,CnAISDA也标志着中国在国际AI安全制度建构中开始突破以联合国为唯一平台的惯常路径。其设立与运作明确表明,中国希望通过灵活的平台机制在联合国之外争取更大的话语空间,与英国AI安全研究所、美国AI标准与创新中心等国际同行展开平行互动。通过CnAISDA这一平台,中国得以在国际安全对话中拥有正式代表性,又不必承担传统监管机构所附带的政策僵化责任。这种制度设计为中国提供了新的国际参与通道,也为非西方国家参与全球AI安全共识构建提供了制度原型。

正是在这样的背景下,本报告启动了对CnAISDA的系统研究。作者团队基于数十次中外专家访谈、数百份政策文件与舆论资料,首次从制度设计、平台功能、核心人物与国际参与四个维度,对这一新兴机构进行了全景式分析。他们指出,CnAISDA不仅仅是一个政策平台,更是中国在全球AI风险治理版图中塑造自身定位、输出政策理念、争取制度定义权的关键筹码。

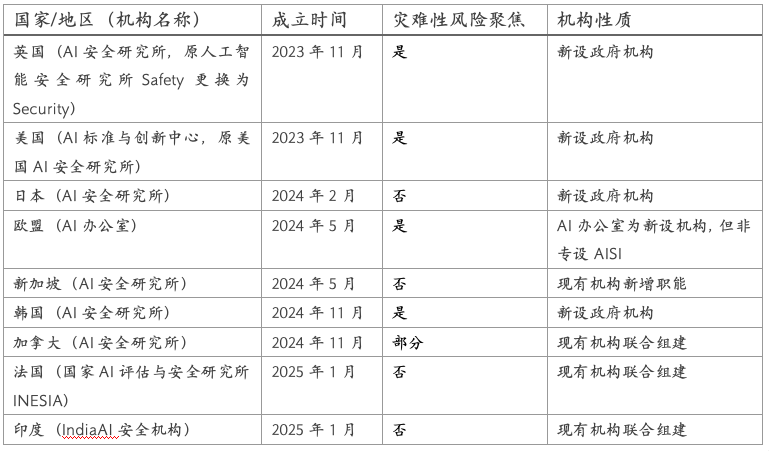

近两年,AI安全问题加速进入各国政策核心,多个国家相继设立前沿模型安全机构,推动以“人工智能安全研究所”(AISI)为代表的制度创新。英国AISI和美国NIST AI Safety Institute最早确立模型测试框架,聚焦灾难性风险(catastrophic risks),并开展评估工具开发和红队测试。其后,日本、欧盟、新加坡、加拿大等国家通过赋能既有监管机构或设立新单位来扩展AI治理体系,使AISI的制度形态呈现出多样性和碎片化特征:有的主打模型能力评估,有的强调公平性和问责机制,有的则注重多边协调职能。这些差异反映出各国在政治结构、监管传统及技术部署节奏上的不同,也表明AI安全尚未形成全球统一制度模型。

在这一背景下,中国选择建立的“中国人工智能发展与安全研究网络”(CnAISDA)并未直接仿效英美那种集测试、标准和监管于一体的AISI结构,而是构建了一个聚焦“对外沟通与代表性表达”的平台机制。CnAISDA由多家高水平研究机构组成,包括清华大学人工智能国际治理研究院、智源研究院、上海人工智能实验室等,其运作方式更接近一个政策参与网络,而非政府监管机构。它不直接对前沿模型进行测试,也不设行政授权或问责机制,而是通过组织专家参与国际对话、协调安全议题立场、发布共识性文件来表达国家立场。其组织松散、权责模糊,但具备政策话语塑造能力,在当前的制度真空中提供了一个更灵活、低风险的国家参与工具。

CnAISDA尽管不承担监管任务,但其文件与国际发言中已明显采用了国际AI治理语言。平台多次强调“灾难性风险”“模型能力不可控”“人类控制权”等术语,并积极参与GPAIS、IDAIS等多边安全机制的对话,实质上与英美在问题定义与优先议程方面达成了高度一致。这种对齐不是为了制度模仿,而是策略性吸纳有国际共识的风险框架,以便在规则制定过程中保留发言权。与一些国家直接设立测试中心、制定门槛不同,中国采取的是“话语接轨、制度自持”的路径,通过代表平台争取议程嵌入空间。

从全球视角看,CnAISDA代表了一种新型的制度应对方式:它不试图复制西式强监管模型,而是以最小制度成本实现最大治理参与。这种路径在当前国际秩序博弈加剧、技术标准尚未统一的阶段,既保留了政策灵活性,也规避了国内制度摩擦的风险。更重要的是,它为其他发展中国家探索AI治理提供了另一种可能性——即不通过建立正式监管机构,而是通过“政策平台+专家网络”的方式参与国际共识制定和风险预警协调。

表格一:世界各国的“人工智能安全研究所”(AISI)

CnAISDA的出现是中国在国际AI风险话语逐步扩张压力下的策略性建制反应,其背后既有国际参与推动下的知识场生成,也有国内政策体系对新型治理工具的主动试探。从2023年起,中国AI学术群体开始频繁出现在国际风险对话中:包括参与CAIS组织的“AI灭绝声明”、出席IDAIS等全球会议,并与OpenAI、DeepMind等公司研究员共同发声,支持对灾难性风险的前瞻治理。这些参与虽未立即转化为国家政策,但为“前沿能力风险”在国内取得语义合法性铺路,推动技术话语从“伦理合规”向“模型能力”延伸。

与此同时,中国政策系统也在探索应对前沿模型挑战的新制度形式。2024年,三中全会正式将AI安全列入治理任务框架,首次提出建设“评估与监管体系”,并在多个官方媒体中强调“大模型的可控性”“前沿能力预警”“AI发展不应以风险为代价”等表述。这些变化并非传统意义上的监管扩张,而是对话语体系的重新定位,赋予非正式平台更多表达与协调功能。在这种背景下,一批具有中外对话经验的政策推动者成为关键组织者。他们来自清华、智源、信通院等研究型机构,具有参与联合国机制、欧美学术网络、国内政策建议渠道的多重身份,主张通过一个松散结构的平台协调技术专家与外交话语,并在国际会议上代表中国发声。

中国人工智能发展与安全研究网络(CnAISDA)参与机构汇总表(卡内基国际和平基金会制作)

CnAISDA最终采取了“非监管性对话平台”的形式,即不承担模型测试职责、不直接介入商业审查,仅作为一个多机构参与、统一发声、低制度敏感度的软性载体。这一结构避免与已有行政体系产生冲突,又能通过“代表性”塑造中国参与全球规则制定的制度席位。它的推出时间也高度策略化——2025年2月在巴黎峰会正式亮相,配合官方边会进行三项合作倡议发布,并以中英双语文件主动嵌入全球治理议程。平台本身没有法律授权,却通过议程设置、共识构建与专家协调实质性介入了多边治理场域,体现出制度设计的“务虚不空转”特征。

CnAISDA采取了一种“代表性替代监管性”的制度结构,它既不是法定机构,也不归属任何单一行政部门,而是由多家顶尖科研单位组成的功能性联盟。平台成员包括清华大学、上海人工智能实验室、中国信息通信研究院、智源研究院等,覆盖AI技术研发、伦理治理、产业政策等多个维度。平台不设常设理事会,也无固定章程,而是通过项目合作、专家提名与共识文件发布等方式维持运作。这种松散结构避免了行政刚性带来的博弈风险,同时增强了在国际机制中的代表弹性。

在功能定位上,CnAISDA主要承担三项任务:一是参与全球AI治理议程,代表中国出席重要安全峰会、对接GPAIS与IDAIS等多边对话机制;二是组织国内学者形成对前沿AI风险的共识性表达,并以中英双语发布倡议文件;三是研究标准协调与能力预警机制,为未来可能的监管工具提供政策储备。平台并不直接从事模型能力测试或制定法律规则,也不会对企业产品发布构成约束,其核心职能是话语协调与制度接口。通过将技术语言转化为国际协作议程,它弥补了中国在全球治理初期缺乏规则嵌入机制的问题。

平台设计突出了“低制度密度、高外交穿透”的策略取向。在国内,CnAISDA不与监管机关重叠,确保其不会被视为职能僭越者;在国际上,它则以非政府属性参与多边谈判,使中国能在规则初创阶段介入,而不必提前承担过高的政策义务。这种策略不仅降低了国内政治成本,也为后续制度升级预留空间。当前,CnAISDA已被默认为中国在AI安全领域的“软代表机构”,其联合发布的文件与英美安全研究所的成果一同被引用于GPAIS相关流程中,显示其国际影响力已初步形成。

这种以平台替代监管、以代表性达成嵌入的结构性安排,反映出中国在AI全球治理中的一个核心判断:在正式规则尚未凝固前,占据议程入口比建构监管体制更具战略价值。CnAISDA就是这样一个制度化的“接口机制”,通过控制进入点,塑造全球规则的边界与重心。

CnAISDA的出现展示了中国在AI全球治理中对“非正式制度工具”的灵活运用,其核心优势在于以最小的政治成本获得国际对话代表性。然而,这种设计本身也限制了平台的功能边界,尤其是在当前AI安全问题技术化、标准化程度不断加深的背景下,缺乏监管权限与测试职能的代表型机构可能在实质性治理竞争中处于不利位置。一旦全球安全机制进一步推进模型能力验证、红队对抗与风险评估程序,CnAISDA是否具备对接能力、是否需要功能转型,都将成为现实问题。

此外,平台目前主要依赖多方机构合作维系运作,其协调机制与产出机制尚未稳定。如果缺乏核心职能牵引与权责配置支持,其代表性也可能逐步边缘化。随着国际治理从“表态期”进入“机制建构期”,CnAISDA是否会继续保持现有定位,或被引导承担更具体的政策职能,是中国AI安全治理体系中亟待进一步观察的转折点。

这一制度结构所承载的功能张力和政治意图,如何在日益具体化的全球治理博弈中展开回应,还需结合接下来的平台演化路径与中国政府在双边、多边机制中的具体部署来判断。

中国人工智能安全与发展研究网络(CnAISDA)被定位为中国参与国际AI安全治理的重要平台,但它的成立时机恰逢美国AI政策重大转向,尤其是2025年特朗普重新当选总统后,美国AI安全政策发生重大调整,2023年拜登政府的AI行政令被废除,新政府更强调“AI机遇”(AI Opportunity)而非风险管控。美国AI安全研究院(AISI)原本是全球协调网络的牵头机构,但在新政府上任后面临重组,资金和领导层存在不确定性,削弱了其国际协调能力。同时,美国对华技术合作态度趋于保守,立法提案限制中美AI研究合作,进一步阻碍两国在AI安全领域的协作。

尽管CnAISDA具有对外协调意愿,但中美之间在AI安全领域的合作空间十分有限。美国政策制定者担心与中国合作会无意间增强中国的“双用途技术能力”(Dual use capabilities),特别是在军事领域。同时,有提案试图限制美中之间的AI研究合作,而CnAISDA的重要成员机构之一——北京智源研究院(BAAI)已被列入美国“实体清单”,进一步限制了与美国的官方或学术往来。文章指出,尽管中美存在战略竞争,但技术理念(如AI安全风险评估)可通过非正式渠道在不同政治体系中传播。例如,中国可以通过参与国际声明(如Bletchley宣言)和学术网络,逐步内化全球安全共识。

在美国之外的其他国家,CnAISDA正在积极寻找着合作伙伴。新加坡与北京智源研究院(BAAI)合作开展AI系统“红队测试”(对抗测试);英国也曾寻求与中国合作。这为CnAISDA提供了绕开中美对抗、推动AI国际安全协作的潜在空间。然而,法国、印度等新兴AI安全国家更关注短期风险,而非前沿AI的长期失控风险,这或许会导致合作目标分歧,增加协调难度。

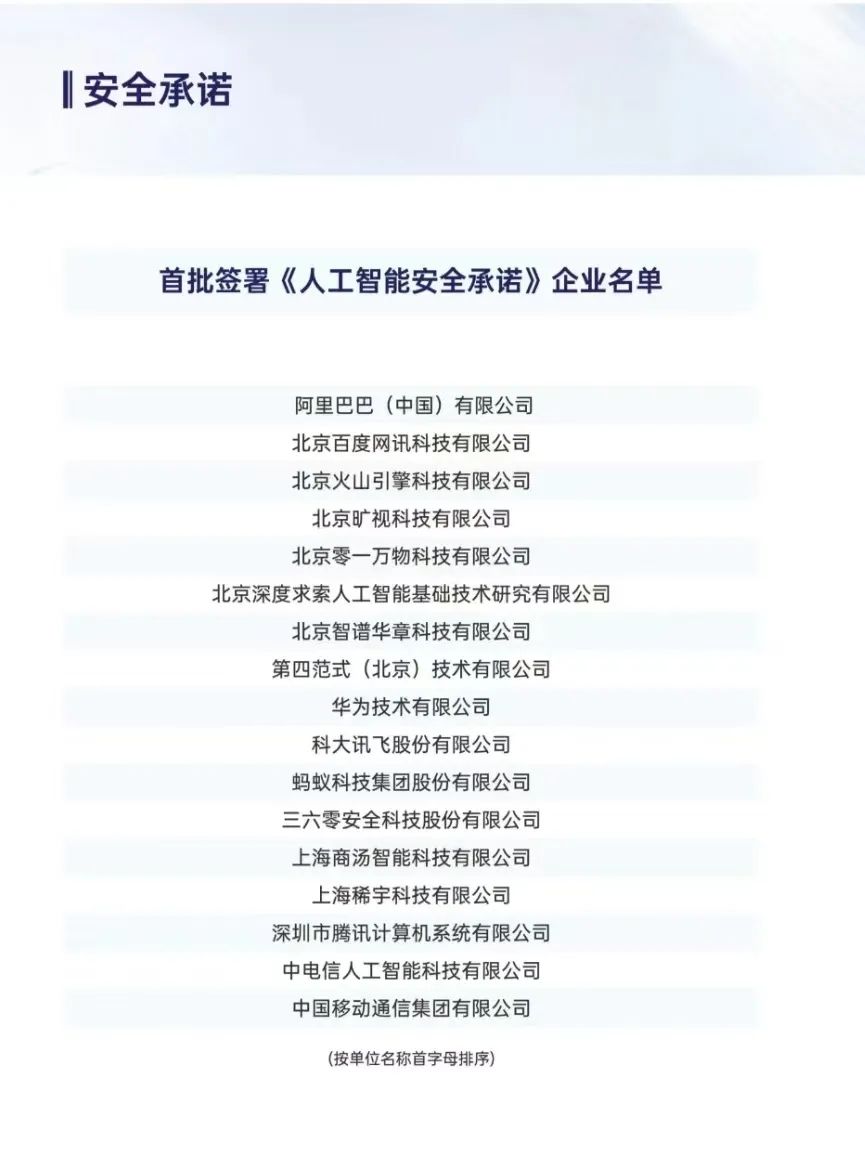

DeepSeek-R1的突破标志着中国AI技术已具全球竞争力,但也使得中国自身面临更高的安全治理压力。虽然中国一直将AI视为经济增长引擎,但国内对AI灾难性风险的研究和担忧也日益增多。CnAISDA的成功组建为中国AI安全政策推动者(policy entrepreneurs)打开了空间,标志着中国在AI安全领域从被动回应转向主动塑造全球议程。目前,在模仿国际前沿AI安全框架(如Frontier AI Safety Commitments)的基础上,中国人工智能产业联盟(AIIA)已发布包含17家企业的安全承诺,有助于实现“软着陆”式的制度吸收。但是,CnAISDA目前以国际参与为主,尚未承担国内AI安全评估职能。因此,CnAISDA的实际影响力取决于能否将国际理念的影响力转化为国内政策和执行力,例如推动行业安全承诺落地。

图源:网络

对中国而言,CnAISDA是参与全球治理的“通行证”,也是国内政策精英争取话语权的平台。对国际社会而言,该组织提供了接触中国AI治理思路的窗口,可能推动在联合国框架外形成务实合作(如联合技术标准制定)。这种“平行演化”模式可能比强制性的国际协议更具韧性,尤其在技术快速发展且地缘分歧加剧的背景下。尽管中美协调面临政治与技术障碍,但通过非正式合作(如行业承诺、技术网络)和聚焦共同利益(如防止AI滥用),双方仍可能找到突破口。报告强调,全球AI治理的关键在于将技术风险共识嵌入各国发展需求,而非依赖僵化的制度约束。

终审丨梁正 鲁俊群

清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢