点击蓝字

关注我们

海外智库观察

随着人工智能技术的快速发展,AI系统在国家安全、社会稳定与人类未来等关键议题上所带来的潜在风险愈加引起国际社会关注。面对AI带来的“灾难级风险”(catastrophic risk)与系统性外部性问题,越来越多的政策研究机构将“人工智能安全”定义为全球公共产品,主张在全球层面进行制度共建与风险协作。在这一框架下,中美作为技术主导国,分别提出了截然不同的治理路径:美国强调“开放科学”“责任机制”与多边参与,而中国则强调“国家主导”“安全底线”与全球对话。两种模式在AI治理基本原则、跨境安全评估、以及模型发布审查机制上呈现出制度分化趋势,也在国际合作与信任构建上形成张力。

为系统分析中美在“AI安全作为全球公共产品”这一概念下的政策输出与制度互动路径,本文选取2025年由卡内基国际和平基金会(Carnegie Endowment for International Peace)发布的两篇代表性研究报告,将分别从全球合作理论与技术领域合作实践入手,提出构建AI国际治理机制的新框架。本文将围绕三方面展开分析,分别为全球公共产品视角对AI治理机制建构的启发,中美在AI安全合作机制上的核心冲突与可行合作空间,以及以安全为核心的AI制度创新对未来治理趋势的塑造。

卡内基国际和平基金会

Carnegie Endowment for International Peace

将AI安全视为全球公共产品:含义、挑战与研究优先事项

2025年3月,卡内基国际和平基金会发布的本篇研究报告,首次系统性地将“人工智能安全”纳入“全球公共产品”(Global Public Goods, GPG)范畴,并提出借鉴气候变化治理与传染病防控经验,构建跨国合作机制、分担治理成本与共享治理成果。文章指出,当前AI系统所带来的安全风险,包括模型滥用、系统性崩溃、深度伪造扩散、自动武器失控等问题,其外部性远超单国可控范畴,具有典型的“跨境、不可排他、广泛受益”特征,符合公共产品的判定标准。

文章强调,美国在AI安全治理方面,鼓励多边协作与开放研究,支持以NIST(国家标准与技术研究院)为中心制定AI安全框架,并通过“人工智能风险管理框架”(AI RMF)推广可控、安全、可验证的模型使用流程。2025年,美国国防高级研究计划局(DARPA)启动“AI Alignment Grand Challenge”,投入超6亿美元研发具有安全校验机制的下一代模型,对标GPT-5与Claude 3等高级系统。政府层面,美国白宫科技政策办公室(OSTP)推动“联邦模型安全审查计划”,要求在高风险模型发布前进行第三方测试,并鼓励企业签署《AI开发者安全协议》(SAIL)。

与此同时,两国在参与方式与路径上也呈现出结构性差异。美国主张通过开放研究与多边参与机制,将AI安全纳入跨国科学合作与政策共识之中。其支持的“全球公共产品”框架不仅借鉴了气候变化与流行病治理的逻辑,还强调AI安全知识的非竞争性(non-rivalry)与非排他性(non-excludability),认为标准制定、科学共识、能力建设都应具有国际共享属性。相比之下,中国则更强调国家主导的制度安排与全球南方包容性参与,主张在维护主权前提下推动全球AI治理秩序的共建。这种“自主治理+全球对话”的路径,强调应对发展中国家不平等地位的结构性改革,同时借助数字丝路倡议强化全球南方合作纽带。

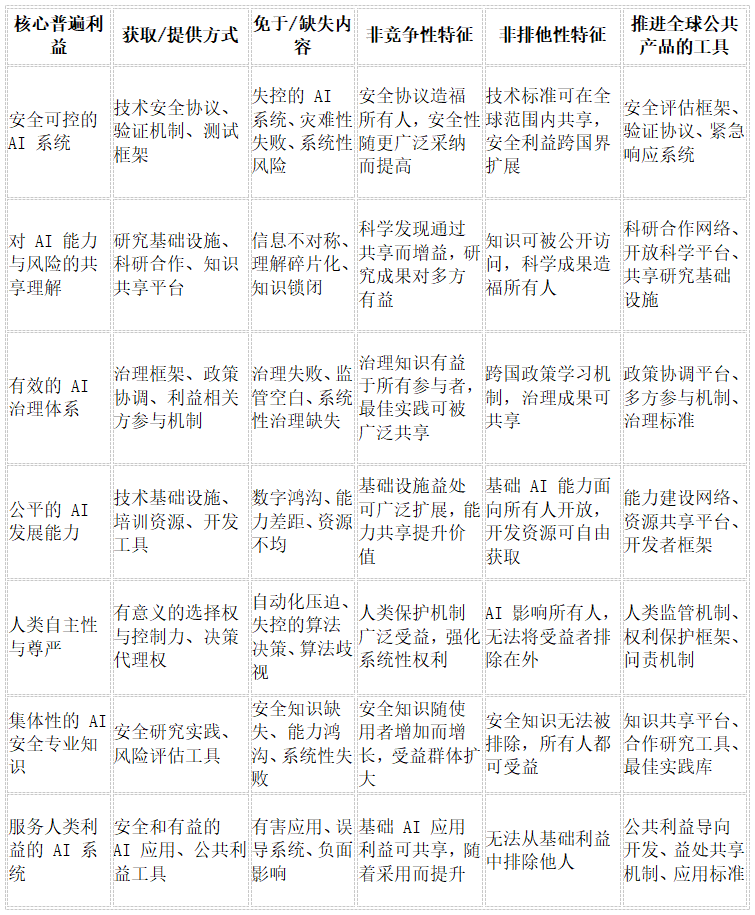

为更清晰理解中美分歧背后的制度理念,可参考卡内基报告中对“AI作为全球公共产品”的多维框架分类(见下表)。该框架将AI安全划分为技术安全、科学理解、治理能力等多个维度,并明确指出每一维度中,何种资源具备非竞争性与非排他性,需以全球合作方式保障其公共性。

表 1:人工智能与全球公共产品的替代性框架(完整译表)

由此可见,美国的制度设计更倾向于通过跨国科研机制与政策平台推动全球治理标准的一体化,而中国则更关注制度治理能力的本地适配与可控性差异化。尽管两者路径不同,但在“模型验证”、“安全共识”与“基础能力共享”等关键领域,表格所列出的多项维度仍为中美未来实现最低限度协调提供了概念空间。

与之相对,中国在全球公共产品逻辑下构建了一套更强调“自主可控”的治理机制。文章指出,中国国家互联网信息办公室于2023年发布的《生成式人工智能服务管理办法》,明确提出“上线即备案、安全先行”的制度原则,所有面向公众的生成式模型必须接受伦理影响评估、敏感场景测试与安全红线审核。至2025年第一季度,已有148个国产模型通过备案,其中包括百度“文心一言”、阿里“通义千问”、讯飞“星火”等国家级平台。此外,中国推动在全球南方国家中推广“可转移的AI治理模板”,尤其在“一带一路”合作框架下输出模型审查标准与政务AI监管技术。例如,2024年与马来西亚联合建立“AI政策沙箱”,测试用于社交媒体监管的模型安全参数;2025年与乌干达合作部署“舆情预警与AI输出监管系统”,实现对虚假生成内容的快速识别与分级处理。这些案例展示出中国将“安全—可执行性—国家控制”三者结合的治理输出模式。

该报告还特别指出,中美在是否支持“全球模型审查机构”、是否认同“技术共享与底线协定”上仍存在根本分歧。美国更倾向于推动跨国开放标准制定组织,如GPAI、OECD AI Principles等;而中国则强调国家参与主导、强化联合国系统在模型风险评估中的角色。文章最后提出建立“差异包容型协作机制”,即允许在多样模式并存的前提下,围绕灾难级风险领域开展有限合作,譬如共同制定“红队测试”最小指标集、共享训练数据偏误警示信息等,以减少中美制度冲突对全球治理带来的不稳定性。

卡内基国际和平基金会

Carnegie Endowment for International Peace

在哪些技术AI安全领域地缘对手可合作?

2025年4月,卡内基国际和平基金会发布的这篇分析报告,聚焦于地缘政治背景下的人工智能安全合作可能性,系统探讨了中美在“灾难级AI风险”(catastrophic AI risks)、模型验证机制、技术出口规则等领域的合作空间与信任壁垒。文章的基本立场并非呼吁盲目合作,而是通过“安全领域分层”分析模型,辨析出“高敏感-低合作”“中敏感-有限合作”“低敏感-可对话”三类议题。

报告指出,在“高敏感”领域,如军事AI部署、指令控制系统嵌入、国家级红队测试数据库共享,中美间存在高度戒备。尤其在美国通过AI与半导体出口管控法案(2023年、2024年版)后,中国将算法安全视为国家战略安全组成部分,限制海外参与其模型测试与训练流程。而美方则对中国企业如商汤、科大讯飞等参与国际AI安全论坛持审慎态度。这些结构性障碍,使得两国在军事关联性较高的领域合作基础薄弱。然而,文章也指出,若将合作重点下沉至“技术性安全底层标准”与“通用风险场景响应”,中美之间仍具备有限协作空间。例如,OpenAI、Anthropic等企业在2025年与清华大学AI安全实验室建立非政府研究对话平台,讨论如何构建模型输出可验证性的通用技术框架;百度与MIT共同发表论文,提出一种基于水印的模型伪造检测算法,并在国际AI治理会议中得到采纳。

此外,报告也特别提及“模型验证(model evaluation)”作为潜在合作突破口。目前,美国国家标准与技术研究院(NIST)和中国科学院自动化所,分别主导AI benchmark建设,但二者指标分布趋于一致,均强调极端场景鲁棒性与社会偏误辨识。这种在科学技术指标上的趋同性,为未来中美建立第三方共识评估平台提供了可能性。报告进一步建议,在全球AI治理机制尚未成型之际,可推动“多边-双边混合路径”。例如,2025年GPAI东京峰会中,中美虽未正式签署合作备忘录,但在红队测试共享机制、伦理评估最低指标集上达成非正式协定。文章认为,这类“低信任高冗余”机制,可为AI安全这一“类气候治理问题”提供制度缓冲区。

最后,文章以全球公共产品视角呼吁:AI安全问题若继续被两极对抗框架主导,将加剧“监管碎片化”与“模型歧视性输出”的扩散风险。因此,中美两国需在承认制度分歧的前提下,探索“有限透明、底线共识”的合作模型,推动AI安全成为一种全球共享的制度责任而非地缘对抗的延伸工具。

原文链接:

1.https://carnegieendowment.org/research/2025/03/examining-ai-safety-as-a-global-public-good-implications-challenges-and-research-priorities

2.https://carnegieendowment.org/research/2025/04/in-which-areas-of-technical-ai-safety-could-geopolitical-rivals-cooperate

审核:赵杨博

排版:李森(北京工商大学)

终审:梁正、鲁俊群

往期回顾

清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢