导语

分享简介

分享简介

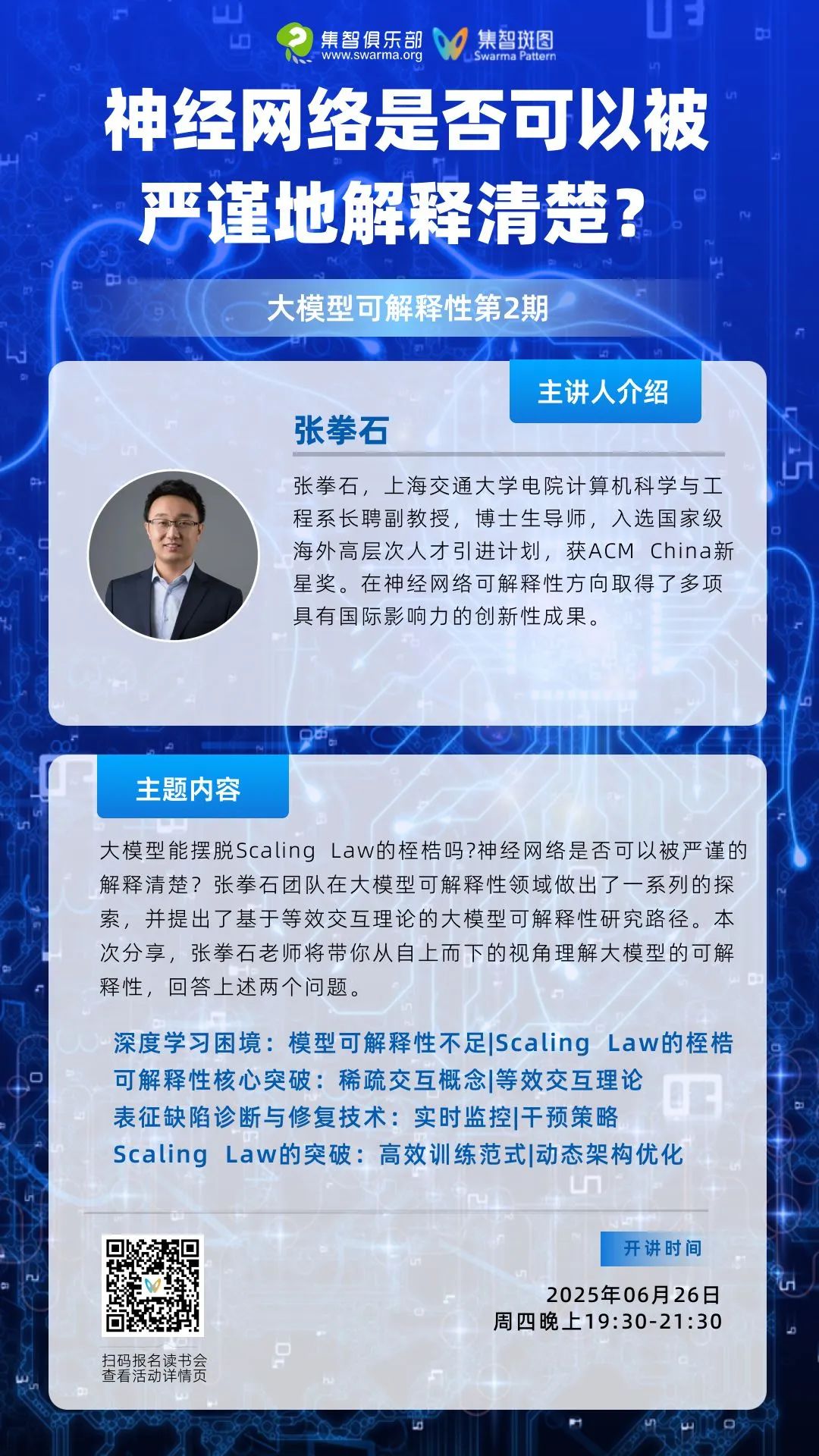

“模型可解释性的不足”和“Scaling Law的桎梏”是深度学习领域中两大瓶颈性问题,但是从内在机理层面却殊途同归地指向同一根因——对模型表征能力缺少根本性解释与建模。目前大部分可解释性研究依然停留在工程技术层面,无法在机理层面直接解释模型表征能力。张拳石团队所提出的基于等效交互可解释性理论体系,从机理层面部分解决了上述问题,证明了神经网络内在复杂表征逻辑可以被严谨且全面地概括为稀疏的交互概念,并基于交互概念可以充分解释神经网络的性能根因,从而跳出黑盒训练范式,有针对性地实时监控并修复模型表征缺陷,提升训练和测试效率,摆脱Scaling Law的桎梏。

分享大纲

分享大纲

深度学习的双重困境

Scaling Law 的历史成就与当前瓶颈

可解释性研究的工程化局限

等效交互理论的核心突破

稀疏交互概念的定义

从神经网络内在复杂表征逻辑到稀疏交互概念

表征缺陷诊断与修复技术

表征缺陷的实时监控

基于交互概念的干预策略

超越 Scaling Law 的路径

小模型的高效训练范式

动态架构优化与资源分配

核心概念

核心概念

稀疏交互概念 神经网络中,仅少数神经元组合(交互概念)对特定任务起决定性作用。这种稀疏性不仅是模型高效运行的基础,更是可解释性研究的关键切入点。通过定位这些交互模式,可精准理解模型决策逻辑。

等效交互可解释性理论 张拳石团队提出的理论体系,证明神经网络的复杂计算可分解为稀疏概念交互,通过数学建模实现对模型行为的机理级解释。该理论突破了传统可解释性方法的工程化局限,为模型优化提供了直接的理论依据。

Scaling Law 描述模型性能与参数规模、数据量、计算资源间关系的幂律规律。尽管曾推动深度学习快速发展,但其边际效益递减趋势(如 OpenAI 的 o3 模型)已引发对大模型可持续性的质疑。

动态表征修复 基于等效交互理论的实时监控技术,通过干预特定交互概念的激活状态,可针对性修复模型在训练或推理中的表征缺陷,显著提升泛化能力与鲁棒性。

参考文献

参考文献

1.证明神经网络精细决策逻辑可以严格解释为符号化等效交互概念

Qihan Ren, Jiayang Gao, Wen Shen, et al. Where We Have Arrived in Proving the Emergence of Sparse Interaction Primitives in DNNs. International Conference on Learning Representations, 2024

2.从神农尝百草到精炼与萃取:论神经网络对抗迁移性

Xin Wang, Jie Ren, Shuyu Lin, et al. A Unified Approach to Interpreting and Boosting Adversarial Transferability. International Conference on Learning Representations, 2020, abs/2010.04055

3.神经网络的博弈交互解释性(六):从博弈交互层面解释对抗鲁棒性

Jie Ren, Die Zhang, Yisen Wang, et al. A Unified Game-Theoretic Interpretation of Adversarial Robustness. arXiv.org, 2021, abs/2111.03536

4.可解释性:神经网络对交互概念表达能力的解析分析

Dongrui Liu, Huiqi Deng, Xu Cheng, et al. Towards the Difficulty for a Deep Neural Network to Learn Concepts of Different Complexities. Neural Information Processing Systems

5.发现并证明神经网络表征瓶颈

Huiqi Deng, Qihan Ren, Xu Chen, et al. Discovering and Explaining the Representation Bottleneck of DNNs. International Conference on Learning Representations, 2021, abs/2111.06236

6.神经网络可解释性:正本清源,论统一14种输入重要性归因算法

Huiqi Deng, Na Zou, Mengnan Du, et al. Understanding and Unifying Fourteen Attribution Methods with Taylor Interactions. arXiv.org, 2023, abs/2303.01506

7.敢问深度学习路在何方,从统一12种提升对抗迁移性的算法说起

Quanshi Zhang, Xin Wang, Jie Ren, et al. Proving Common Mechanisms Shared by Twelve Methods of Boosting Adversarial Transferability. arXiv.org, 2022, abs/2207.11694

8.论文发现深度神经网络(DNN)学习交互特征存在两阶段动态过程,即第一阶段抑制中高阶交互、学习低阶交互以提升泛化能力,第二阶段逐步学习高阶交互导致过拟合,该现象与训练 - 测试损失差距的变化时序一致,揭示了 DNN 从欠拟合到过拟合的起始机制。

Junpeng Zhang, Qing Li, Liang Lin, et al. Two-Phase Dynamics of Interactions Explains the Starting Point of a DNN Learning Over-Fitted Features. arXiv.org, 2024, abs/2405.10262

9.论文通过数学证明揭示了深度神经网络(DNN)学习交互特征的两阶段动态机制:初始阶段抑制中高阶交互以学习低阶泛化特征,第二阶段逐步引入高阶交互导致过拟合,该理论与训练 - 测试损失差距的变化一致,并通过多任务实验验证了其普适性。

Qihan Ren, Yang Xu, Junpeng Zhang, et al. Towards the Dynamics of a DNN Learning Symbolic Interactions. Neural Information Processing Systems, 2024, abs/2407.19198: 50653–50688

主讲人简介

主讲人简介

张拳石,上海交通大学电院计算机科学与工程系长聘副教授,博士生导师,入选国家级海外高层次人才引进计划,获ACM China新星奖。他于2014年获得日本东京大学博士学位,于2014-2018年在加州大学洛杉矶分校(UCLA)从事博士后研究。张拳石在神经网络可解释性方向取得了多项具有国际影响力的创新性成果。张拳石承担了TMLR的责任编辑,CCF-A类会议NeurIPS 2024的领域主席,IJCAI 2020和IJCAI 2021的可解释性方向的Tutorial,并先后担任了AAAI 2019, CVPR 2019, ICML 2021大会可解释性方向的分论坛主席。

参与方式

参与方式

参与时间

2025年6月26日(周四)晚上19:30-21:30

报名加入社群交流

https://pattern.swarma.org/study_group_issue/931?from=wechat

扫码参与「大模型可解释性」读书会,加入社群,获取系列读书会永久回看权限,与社区的一线科研工作者沟通交流,共同探索大模型可解释性这一前沿领域的发展。

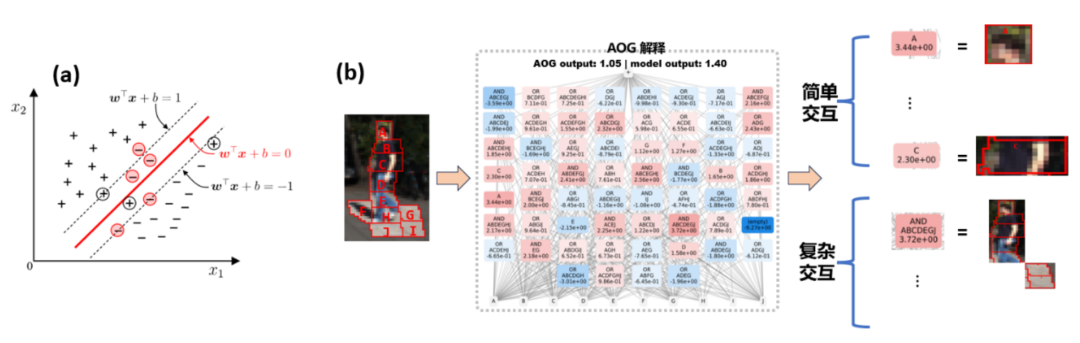

大模型可解释性读书会

集智俱乐部联合上海交通大学副教授张拳石、阿里云大模型可解释性团队负责人沈旭、彩云科技首席科学家肖达、北京师范大学硕士生杨明哲和浙江大学博士生姚云志共同发起「大模型可解释性」读书会。本读书会旨在突破大模型“黑箱”困境,尝试从以下四个视角梳理大语言模型可解释性的科学方法论:

自下而上:Transformer circuit 为什么有效?

自上而下:神经网络的精细决策逻辑和性能根因是否可以被严谨、清晰地解释清楚?

点击“阅读原文”,报名读书会

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢