今天,我们文心4.5系列模型正式开源。现在可以在文心一言(https://yiyan.baidu.com)即刻体验最新开源能力。

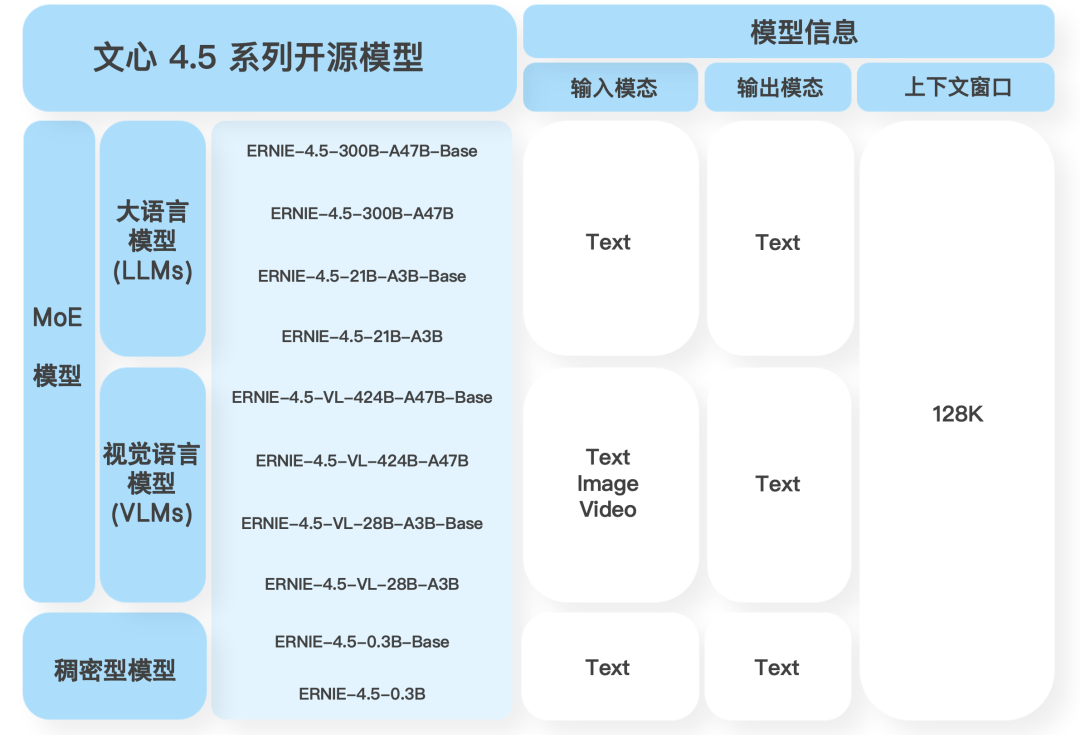

文心4.5系列开源模型共10款,涵盖了激活参数规模分别为47B和3B的混合专家(MoE)模型(最大的模型总参数量为424B),以及0.3B的稠密参数模型。

文心 4.5 系列模型开源说明

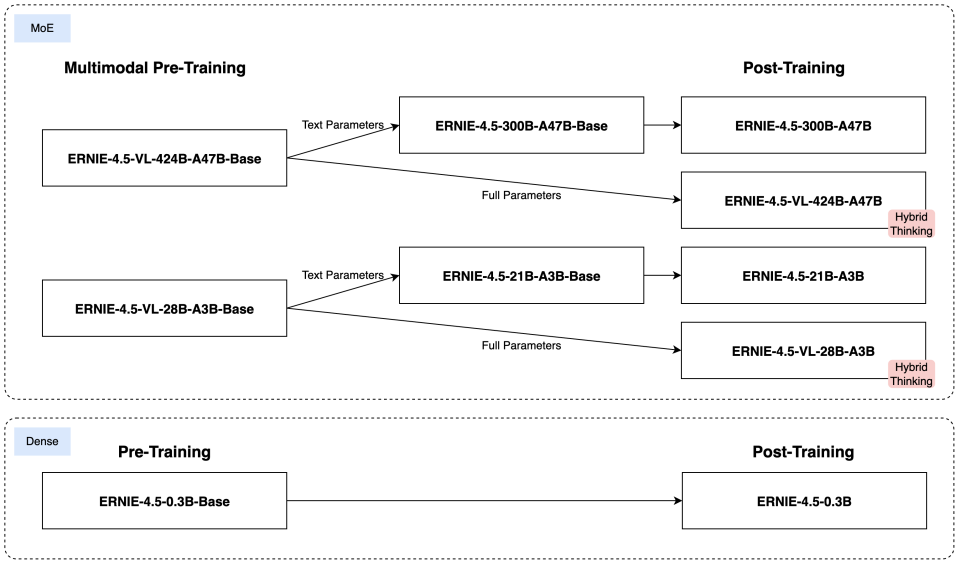

针对 MoE 架构,我们提出了一种创新性的多模态异构模型结构,通过跨模态参数共享机制实现模态间知识融合,同时为各单一模态保留专用参数空间。此架构非常适用于从大语言模型向多模态模型的持续预训练范式,在保持甚至提升文本任务性能的基础上,显著增强多模态理解能力。

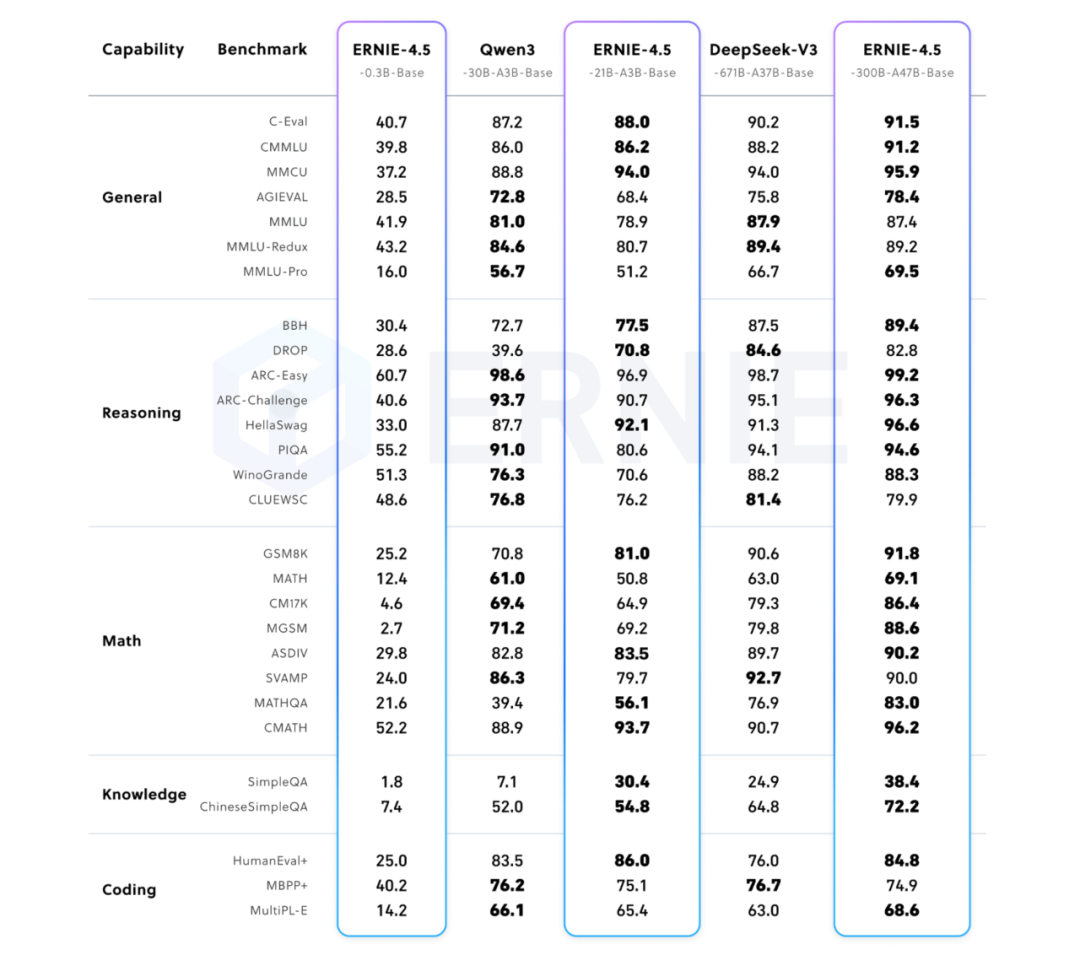

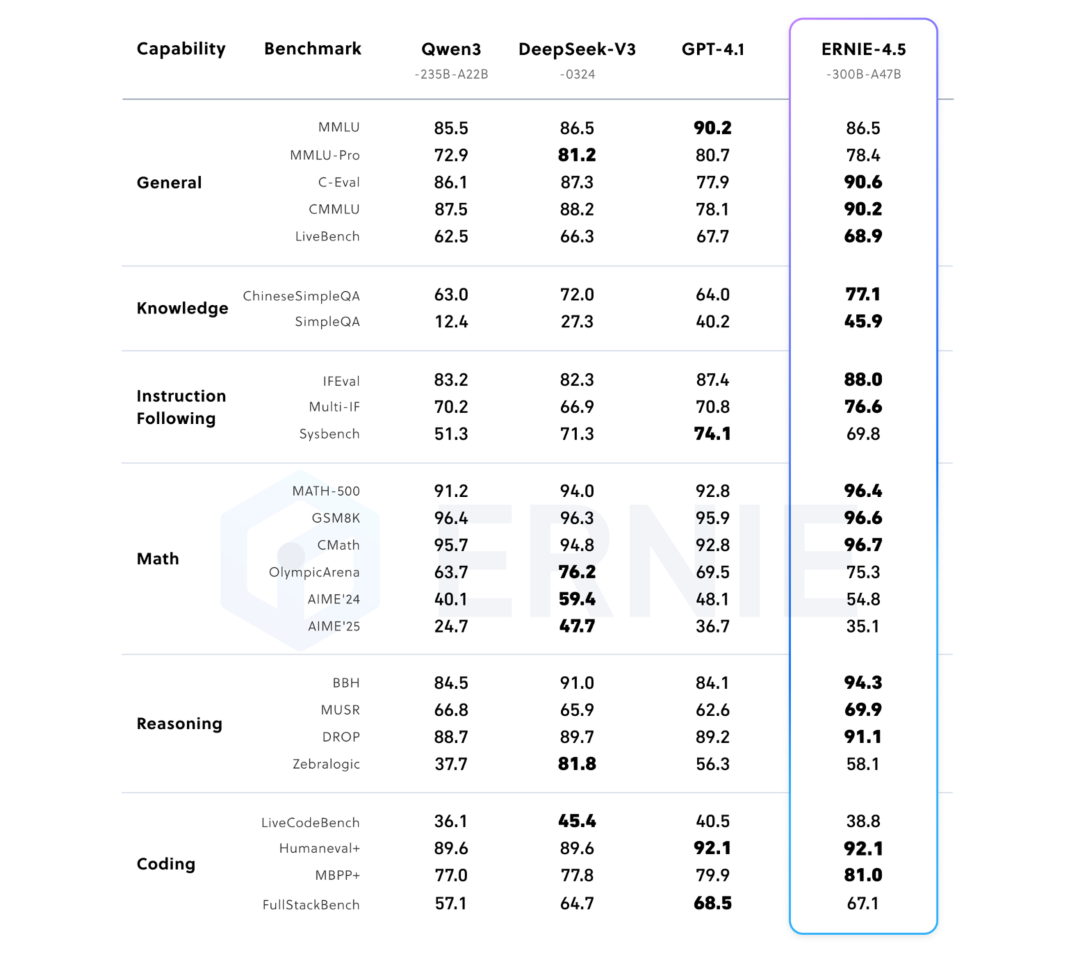

文心4.5系列模型均使用飞桨深度学习框架进行高效训练、推理和部署。在大语言模型的预训练中,模型FLOPs利用率(MFU)达到47%。实验结果显示,该系列模型在多个文本和多模态基准测试中达到SOTA水平,在指令遵循、世界知识记忆、视觉理解和多模态推理任务上效果尤为突出。模型权重按照Apache 2.0协议开源,支持开展学术研究和产业应用。此外,基于飞桨提供开源的产业级开发套件,广泛兼容多种芯片,降低后训练和部署门槛。

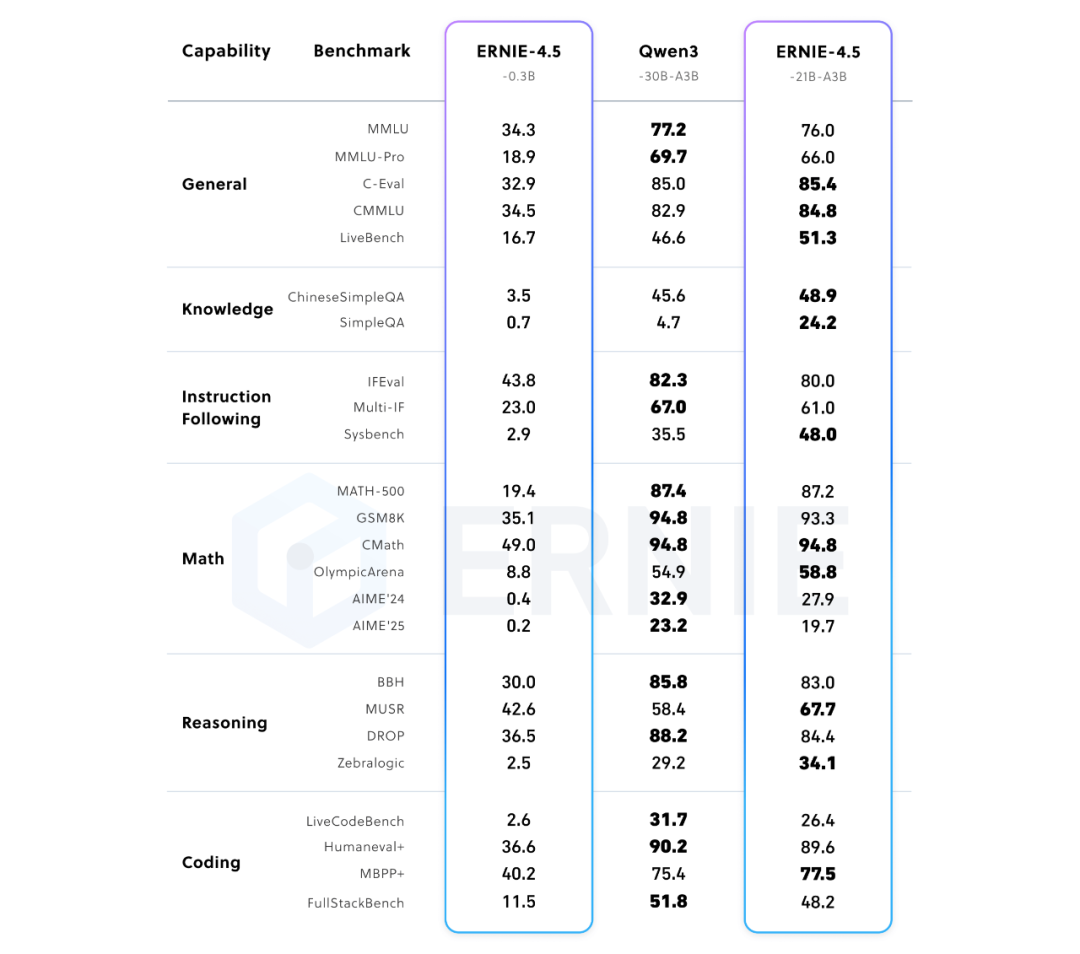

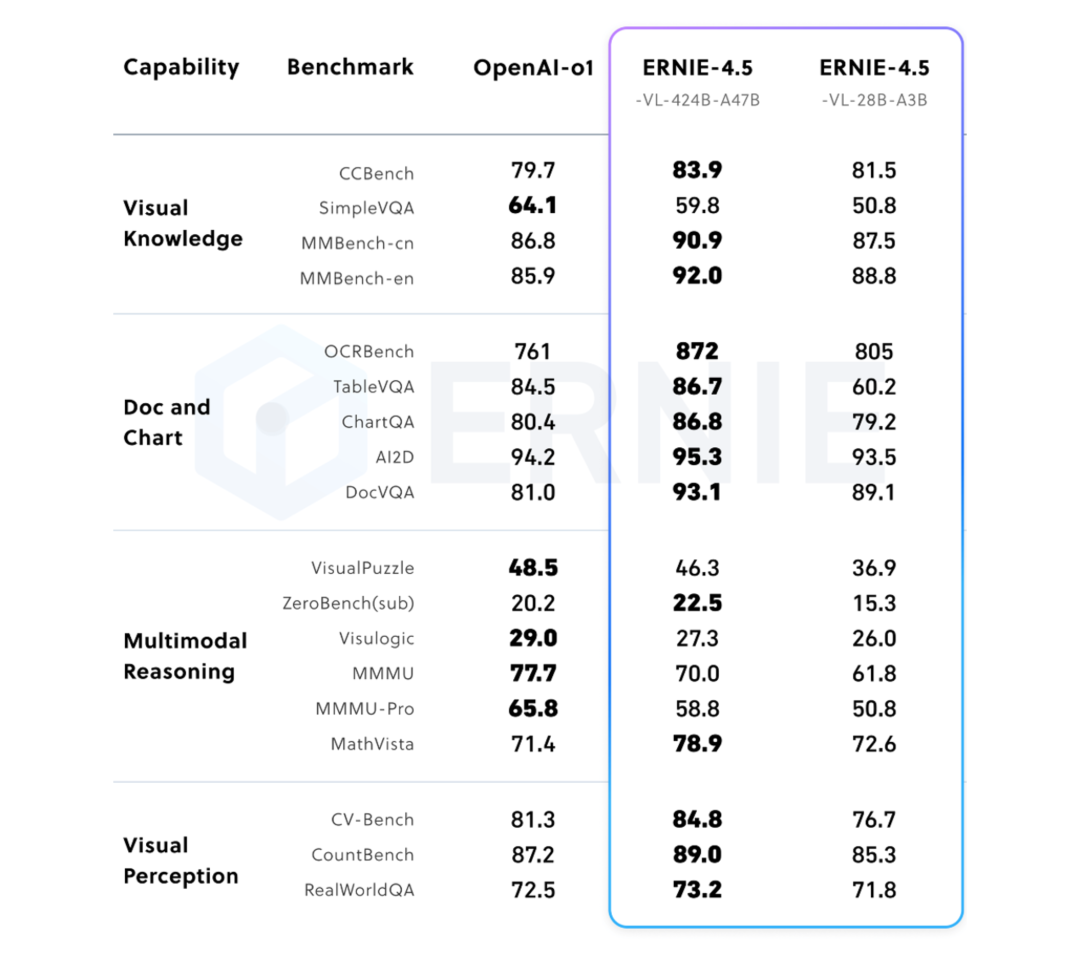

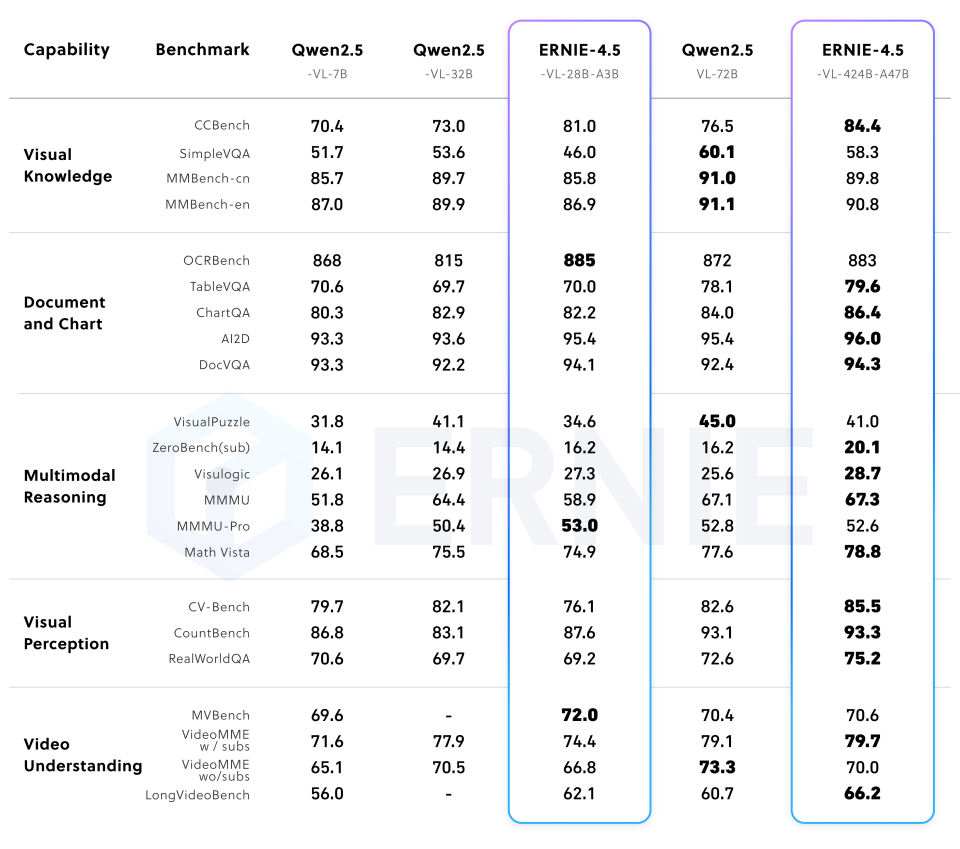

文心4.5系列模型在Benchmark上效果体现

以下是文心4.5系列开源模型核心技术亮点:

多模态混合专家模型预训练

文心4.5通过在文本和视觉两种模态上进行联合训练,更好地捕捉多模态信息中的细微差别,提升在文本生成、图像理解以及多模态推理等任务中的表现。为了让两种模态学习时互相提升,我们提出了一种多模态异构混合专家模型结构,结合了多维旋转位置编码,并且在损失函数计算时,增强了不同专家间的正交性,同时对不同模态间的词元进行平衡优化,达到多模态相互促进提升的目的。

高效训练推理框架

为了支持文心4.5模型的高效训练,我们提出了异构混合并行和多层级负载均衡策略。通过节点内专家并行、显存友好的流水线调度、FP8混合精度训练和细粒度重计算等多项技术,显著提升了预训练吞吐。推理方面,我们提出了多专家并行协同量化方法和卷积编码量化算法,实现了效果接近无损的4-bit量化和2-bit量化。此外,我们还实现了动态角色转换的预填充、解码分离部署技术,可以更充分地利用资源,提升文心4.5 MoE模型的推理性能。基于飞桨框架,文心4.5在多种硬件平台均表现出优异的推理性能。

针对模态的后训练

为了满足实际场景的不同要求,我们对预训练模型进行了针对模态的精调。其中,大语言模型针对通用语言理解和生成进行了优化,多模态大模型侧重于视觉语言理解,支持思考和非思考模式。每个模型采用了SFT、DPO或UPO(Unified Preference Optimization,统一偏好优化技术)的多阶段后训练。

为方便广大开发者使用需求,以下是文心4.5系列开源模型的一站式使用指南,更多项目请查看文心大模型技术Blog:https://yiyan.baidu.com/blog/posts/ernie4.5

使用入门与最佳实践

基于多年飞桨开源技术与生态系统积累,此次文心4.5模型系列开源同步升级发布文心大模型开发套件ERNIEKit和大模型高效部署套件FastDeploy,为文心4.5模型及开发者提供开箱即用的工具和全流程支持。

基于飞桨的文心大模型开发套件ERNIEKit,快速掌握精调、对齐等大模型全流程开发

使用示例:

# 下载模型

huggingface-cli download baidu/ERNIE-4.5-0.3B-Paddle --local-dir baidu/ERNIE-4.5-0.3B-Paddle

# 一行命令启动训练

erniekit train examples/configs/ERNIE-4.5-0.3B/sft/run_sft_8k.yaml要获取更详细的示例,包括使用LoRA的SFT、多GPU配置和高级脚本,请参阅ERNIEKit仓库中的examples文件夹。

ERNIEKit仓库

https://github.com/PaddlePaddle/ERNIE

基于飞桨的大模型高效部署套件FastDeploy,实现高性能、低门槛的多硬件推理部署

FastDeploy 提供了一行代码开箱即用的多硬件部署体验,使用接口兼容vLLM和OpenAI协议。针对旗舰模型提供了产业级多级负载均衡的PD分离部署方案,支持丰富的低比特量化推理、上下文缓存、投机解码等加速技术。

本地推理示例:

from fastdeploy import LLM, SamplingParams

prompt = "把李白的静夜思改写为现代诗"

sampling_params = SamplingParams(temperature=0.8, top_p=0.95)

llm = LLM(model="baidu/ERNIE-4.5-0.3B-Paddle", max_model_len=32768)

outputs = llm.generate(prompt, sampling_params)服务部署示例:

python -m fastdeploy.entrypoints.openai.api_server \

--model "baidu/ERNIE-4.5-0.3B-Paddle" \

--max-model-len 32768 \

--port 9904有关详细文档、安装指南和高级配置选项,请参阅FastDeploy仓库。

FastDeploy仓库:

https://github.com/PaddlePaddle/FastDeploy

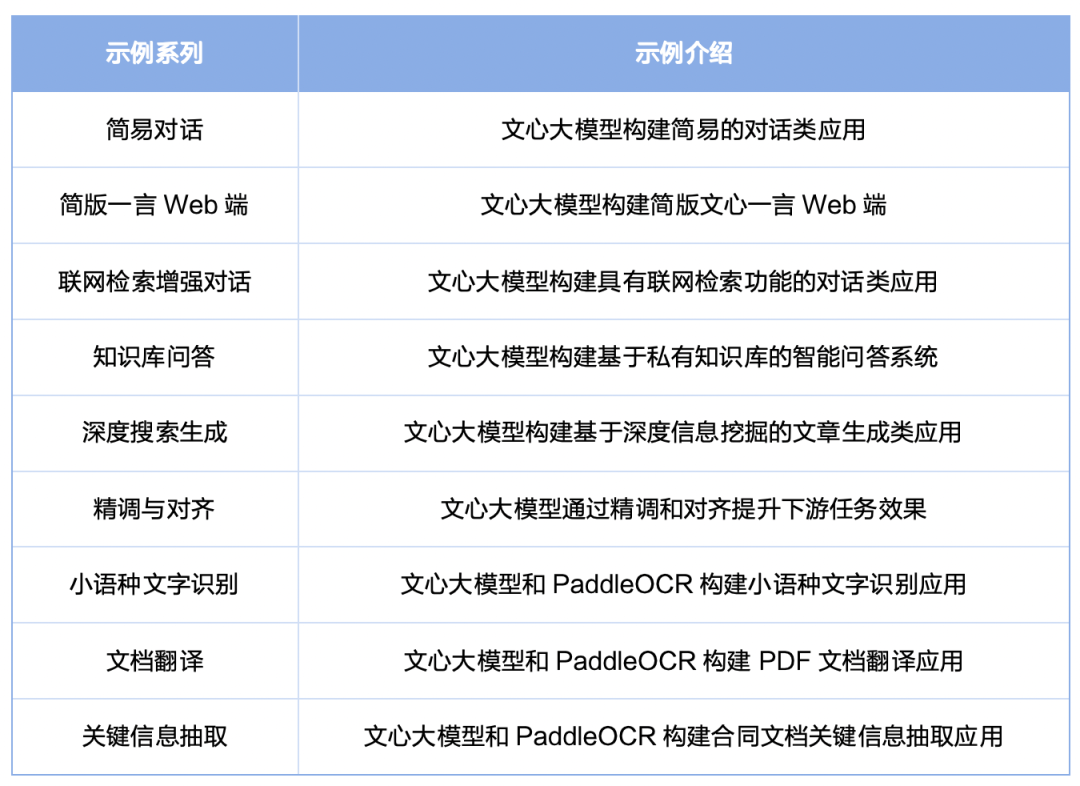

星河社区上线基于文心飞桨的最佳实践应用与项目

为方便社区开发者适配和拓展应用场景,我们提供了文心大模型多种能力的技术实践手册,涵盖对话、检索增强、知识库问答以及 SFT/DPO 模型微调示例,欢迎大家在星河社区应用中心与精品项目中使用与探索!

开源生态服务与活动

截至2025年4月,飞桨文心已累计服务超2185万开发者、67万家企业,创建模型达110万。接下来,我们将联合Hugging Face等30+开源社区推出20节「文心飞桨・开源系列公开课」;携手国网、工行、北京大学、浙江大学、厦门大学等产业导师与高校名师打造「文心名师系列・公开课」;在星河社区AI Studio滚动上线包含基础概念、实操技巧、进阶学习的「动手学大语言模型」系列课程、赛事等;同期举办50+场覆盖各行业、高校、开发者的线下「文心开源开放日活动」;同时,在北京、上海、深圳等10余个城市启动「文心开源服务站」,为文心飞桨应用开发和科研创新提供一揽子生态服务支持。

飞桨与文心同行,持续与社区伙伴,共同推进人工智能最新开源成果繁荣。

相关链接:

文心大模型技术Blog (含技术报告下载):

https://yiyan.baidu.com/blog/posts/ernie4.5

文心一言:

Hugging Face:

GitHub:

https://github.com/PaddlePaddle/ERNIE

百度智能云:

https://cloud.baidu.com/doc/WENXINWORKSHOP/s/4mchtzl8s

星河社区:

https://aistudio.baidu.com/overview

魔搭社区:

文心开源服务站:

https://aistudio.baidu.com/experthub

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢