DRUGAI

本文介绍一篇来自浙江大学侯廷军、谢昌谕和吴健团队联合发表在JACS Au上的研究成果《HiCLR: Knowledge-Induced Hierarchical Contrastive Learning with Retrosynthesis Prediction Yields a Reaction Foundation Model》。该研究提出了一种名为HiCLR的知识引导层次对比学习框架,通过结合逆合成预测和对比学习,构建了一个通用的化学反应基础模型。经HiCLR框架得到的预训练模型能够同时处理生成型任务和理解型任务,在逆合成预测、化学反应分类、反应条件预测、反应产率预测、分子属性预测等一系列下游任务中表现出色,为AI驱动的化学研究提供了新的思路和工具。

研究背景

近年来,人工智能(AI)在化学反应任务中的应用取得了显著进展,例如反应分类、反应条件推荐、反应产率预测和合成路径规划等。然而,基于深度学习的化学反应建模面临两个关键挑战:首先,标记数据的稀缺性严重限制了监督学习模型的泛化能力;其次,反应相关任务的高度异质性导致现有方法的通用性不足。随着预训练/微调 (PT/FT) 范式的广泛应用,化学反应领域也涌现了诸多预训练模型,以提升模型在数据稀缺场景下的泛化性能。当前的预训练模型可以分为两大类:(1)采用BERT框架与掩码语言建模目标的rxnfp,RxnRep等,能够提供反应表征但不具备生成能力;(2)采用Transformer 编码器-解码器框架与自回归生成目标的Chemformer, T5Chem等,在大型分子库PubChem/ZINC上预训练,具备生成能力,但无法学习分子间相互作用和化学反应机制,提供的反应表征质量差。此外,现有方法往往采用纯数据驱动的自监督预训练范式,难以捕捉反应中心的细微差异,提取的反应表征化学含义不清晰、适用范围有限,导致其在处理多样化的下游任务时表现受限。因此,开发一个兼具理解和生成能力且具有广泛适用性的化学反应基础模型成为迫切需求。

方法概述

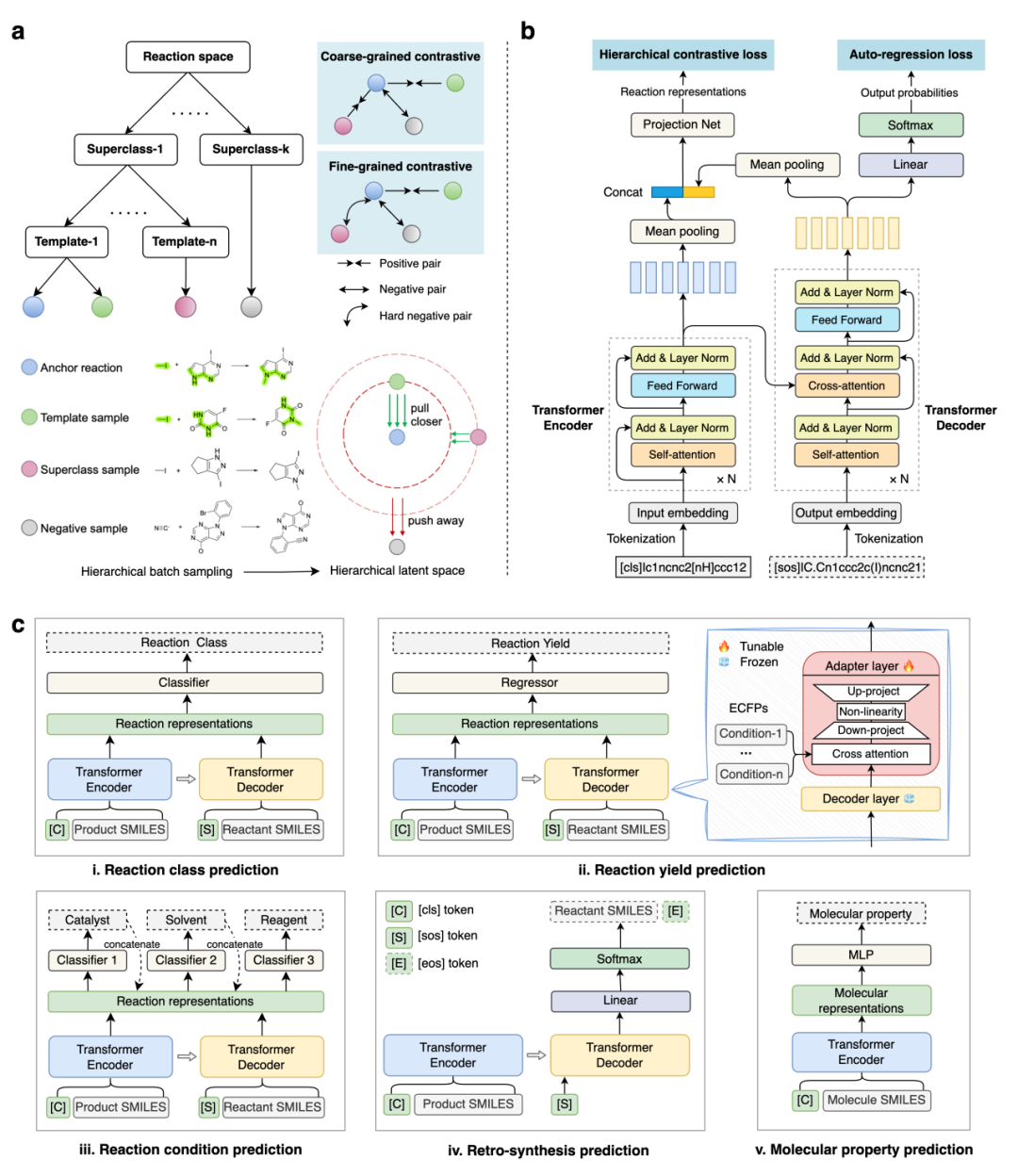

受启发于专家定义的NameRXN反应分类系统,本研究提出了知识引导的预训练HiCLR框架,通过引入关系归纳偏置,构建具有化学意义且广泛适用的化学反应指纹。该框架将逆合成预测任务与层次对比学习相结合,前者学习反应内的化学转化规则,后者学习反应间的层次化语义结构,两个学习目标相辅相成,促成了一个兼具生成和理解能力的化学反应通用模型,能够应用于各类化学反应相关任务。该框架的核心创新在于整合了两层次标签体系(NameRXN超类级和模板级),通过层次对比学习损失和逆合成预测损失联合优化模型。针对不平衡的数据分布,本框架采用层次化批次采样策略,确保每个锚点反应(Anchor)在训练批次中至少匹配一个同超类和一个同模板的正样本,同时引入层次特异性的距离约束,以保证反应表征空间的层次性与专家知识一致,即反应间距离符合如下规则:同模板<同超类但不同模板<不同超类。在模型架构上,HiCLR 采用Transformer 编码器-解码器结构,其中编码器负责提取产物特征,解码器生成反应物特征,两者拼接后通过投影网络映射为低维反应指纹用于对比学习。

实验结果表明,在USPTO 1k TPL(400K)数据集上采用HiCLR框架预训练的模型能够有效捕捉反应空间的语义结构,在反应分类(少样本条件下准确率提升34.4%)、产率预测(相对性能提升17%)等多个下游任务中均达到了最先进的性能水平,为化学反应表示学习领域提供了新的研究范式和方法论支持。

图1. HiCLR预训练框架和下游任务应用示意图

结果与讨论

反应空间的可视化与相似性检索

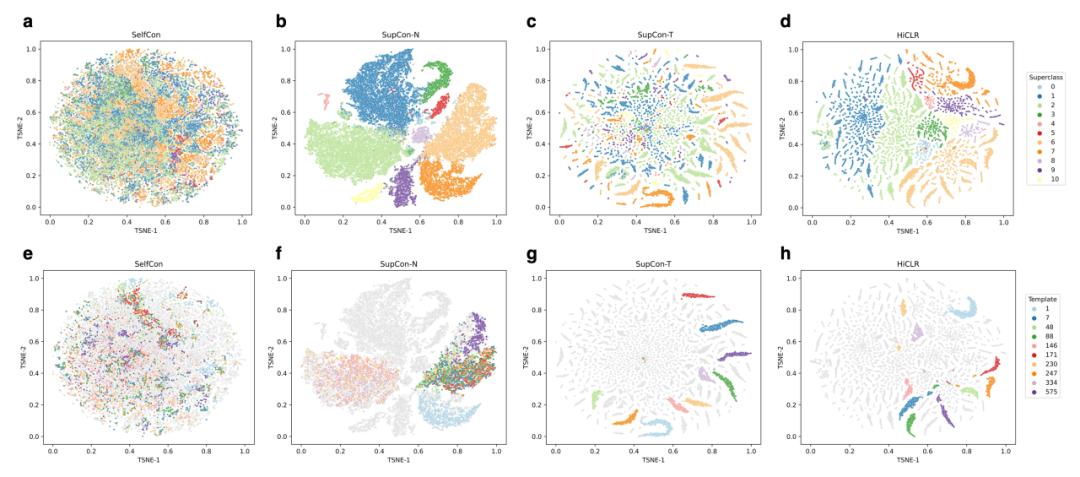

为了证明学习目标中引入的分层约束有助于模型捕获语义结构感知的反应嵌入,研究人员在 USPTO 1k TPL 测试集(未参与预训练)上进行了 t-SNE 可视化和相似反应检索实验。

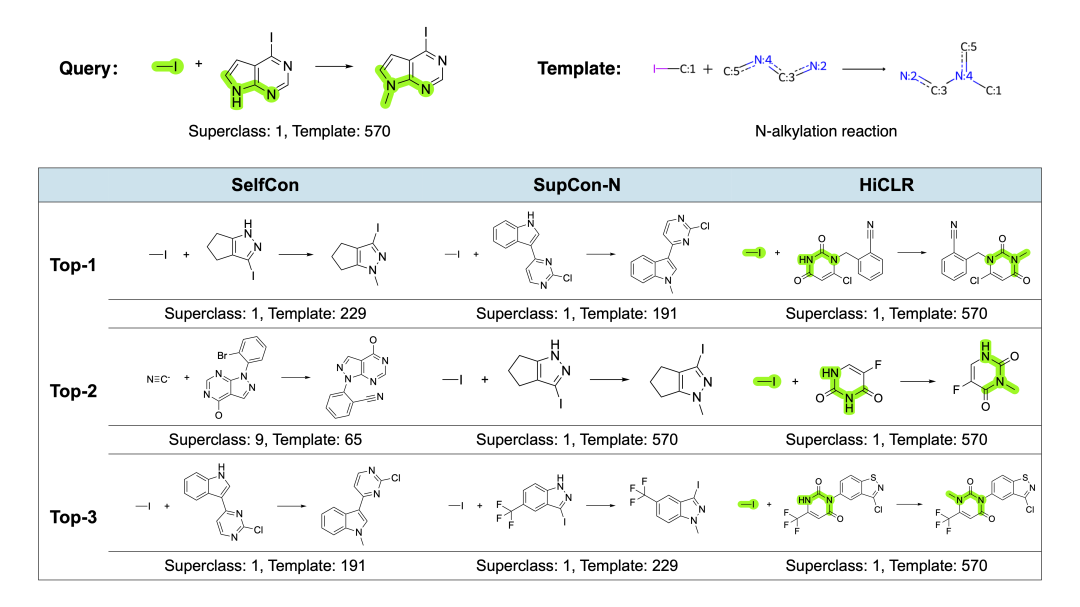

t-SNE可视化实验表明,自监督对比学习模型(SelfCon)表征空间无明显规律,NameRXN 超类标签上的监督对比学习 (SupCon-N) 和模板标签上的监督对比学习 (SupCon-T)只在其相应的层级上形成语义簇,而HiCLR成功地将反应空间组织成层次化的语义簇,与专家知识高度一致(图2)。相似反应检索的结果显示,SelfCon模型能够匹配到整体结构相似度较高但反应类别完全不同的反应;SupCon-N模型能够准确辨别反应超类,对缺乏对模板结构差异的感知能力;而HiCLR能够准确匹配反应模板,根据反应中心周围局部环境的相似性来进行匹配检索(图3)。

图2. HiCLR及其变体的反应空间可视化

图3. 相似反应检索

与其他反应指纹的基准测试(反应分类性能)

为了验证预训练表征空间的可泛化性,研究人员冻结了预训练模型的参数并提取了反应表征,作为多层感知器(MLP)的输入来训练反应分类器。考虑到标记的反应数据在现实世界中是稀缺的,研究人员以小样本学习(few-shot learning)的方式进行评估。实验结果表明,HiCLR 在所有训练数据大小中均实现了最佳性能。特别是当训练数据量减小时,HiCLR 和最佳基线之间的性能差距会扩大。在4-shot分类任务中,HiCLR的准确率比最佳基线模型高34.4%,展示了其在数据稀缺场景下的强大泛化能力。该数据集的标签是NameRXN的三级类别标签,表明本研究所提出的分层学习目标允许模型提取具有化学意义的反应指纹,而不是简单地记住超类或模板标签。

逆合成预测

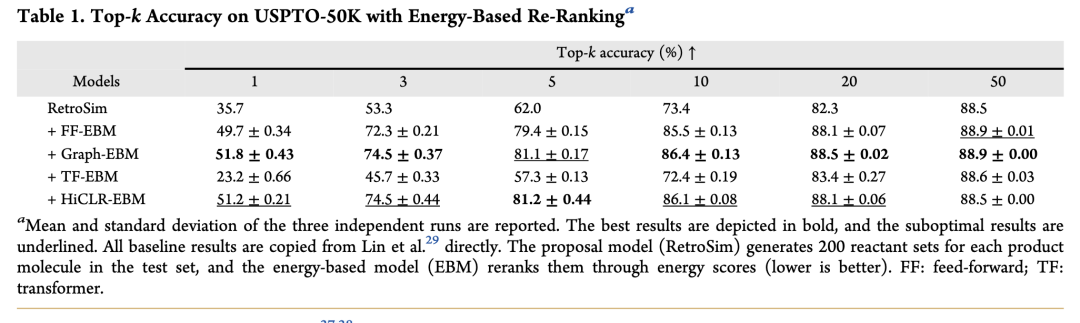

预训练中的多任务协同优化赋予了模型理解和生成能力,因而在逆合成预测中HiCLR既可以作为候选反应物的生成器(Proposal model),也可以对既有的候选反应物进行重排序(Reranking model)。作为生成模型时,HiCLR在USPTO-50K基准测试中表现出色,无需依赖模板或数据增强即可达到先进水平。与R-SMILES方法结合后,将Top-1和Top-10准确率分别提升7.6%和5.8%。作为重排序模型时,HiCLR克服了从头训练Transformer在能量建模中的局限性,其性能与图神经网络模型相当,进一步验证了预训练范式可以提供更有意义的化学反应指纹(表1)。

反应条件推荐

本研究将反应条件推荐任务构建为自回归式多标签分类问题。具体实现上,采用级联式预测架构:每个条件类别(催化剂、溶剂等)由独立的分类器预测,先前预测的条件通过独热编码向量表示,并与当前反应指纹拼接后作为下一条件分类器的输入。这种设计有效建模了不同条件组分间的依赖关系。

在USPTO-Condition数据集的评估中,HiCLR表现出零样本迁移能力,在冻结预训练模型参数的设置下,HiCLR的Top-1准确率已超越专为条件预测设计的Parrot模型,证实预训练过程隐式学习了与反应条件相关的关键特征。经适配器(Adapter)微调后,Top-1准确率较最佳基准模型相对提升7.2%,优于全参数微调方案,表明适配器能有效缓解小样本场景下的过拟合问题。

反应产率预测

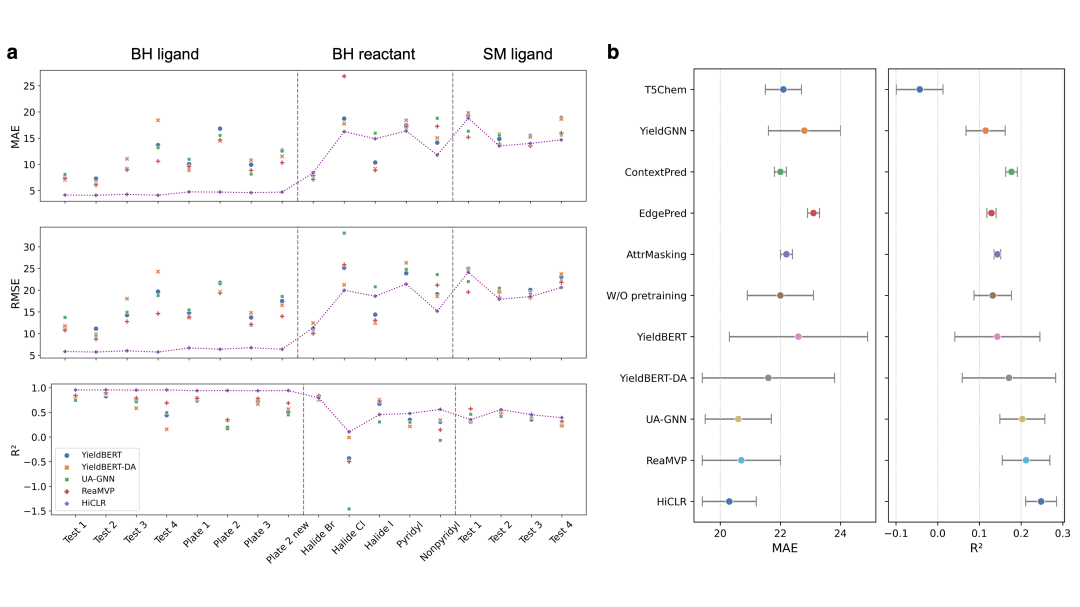

在反应产率预测任务的评估中,本研究采用了两类具有代表性的数据集:包含Suzuki-Miyaura(HTE)和Buchwald-Hartwig(HTE)的高通量实验数据集,以及来自制药企业电子实验记录的真实世界数据集Buchwald-Hartwig(ELN)。实验结果表明,在HTE数据集的17种out-of-sample分割测试中(图4 a),HiCLR模型展现出优异的泛化性能,在13种分割方案上取得了最优结果。值得注意的是,在基于配体的数据划分场景(如卤化物Cl分割)中,HiCLR是唯一保持预测结果与真实值呈正相关性的方法。对于更具挑战性的真实世界数据集Buchwald-Hartwig(ELN)(图4 b),HiCLR在R²指标上较最优基准模型实现了17%的相对提升。即使ReaMVP模型在预训练阶段使用了更多反应数据和产率标签,HiCLR仍然具有显著优势。消融实验证明,研究人员设计的条件适配器(condition adapter)层进一步提升了模型性能,该结构能够有效区分不同反应条件对最终产率的特异性影响。

图4. HiCLR在产率预测任务中的表现

分子性质预测

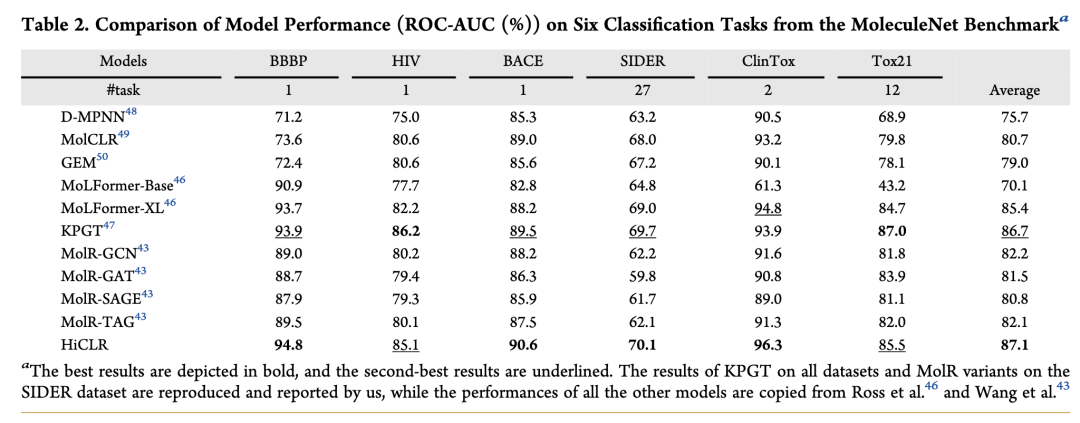

HiCLR框架的适用性不仅限于化学反应任务,其预训练编码器还可有效提取分子表示用于分子性质预测任务。在MoleculeNet基准测试的评估中,HiCLR在6个分类任务中的4个取得了最优性能(表2),并在平均指标上优于所有基线模型。值得注意的是,这些表现突出的任务均具有相对较小的数据规模(样本量范围1427-2039),这一结果验证了HiCLR在数据稀缺场景下的优势。此外,与MoLFormer-XL和KPGT等基线相比,HiCLR仅需1/14的参数量即可达到相当或更优的性能,展现了显著的参数效率优势。这些实验结果证实,通过反应数据预训练获得的化学知识能够有效迁移至分子表征领域。

总结

本研究提出了一种基于知识引导的层次对比学习框架 HiCLR,用于构建通用的化学反应基础模型。通过融合逆合成预测与层次对比学习方法,首次建立了一个兼具生成和理解能力的统一化学反应表示体系。该体系推动了化学反应建模从面向单一任务的专用模型向多功能通用基础模型的范式转变,不仅为计算机辅助合成设计提供了新的方法论支持,也为构建统一的 AI 化学合成平台奠定了基础。

参考文献

Wu, J.; Zhu, Y.; Wang, X.; Li, Y.; Yin, M.; Wang, T.; Han, Y.; Kang, Y.; Deng, Y.; Wu, J.; Hsieh, C.-Y.; Hou, T. HiCLR: Knowledge-Induced Hierarchical Contrastive Learning with Retrosynthesis Prediction Yields a Reaction Foundation Model. JACS Au 2025, jacsau.5c00289. https://doi.org/10.1021/jacsau.5c00289.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢