导语

分享简介

分享简介

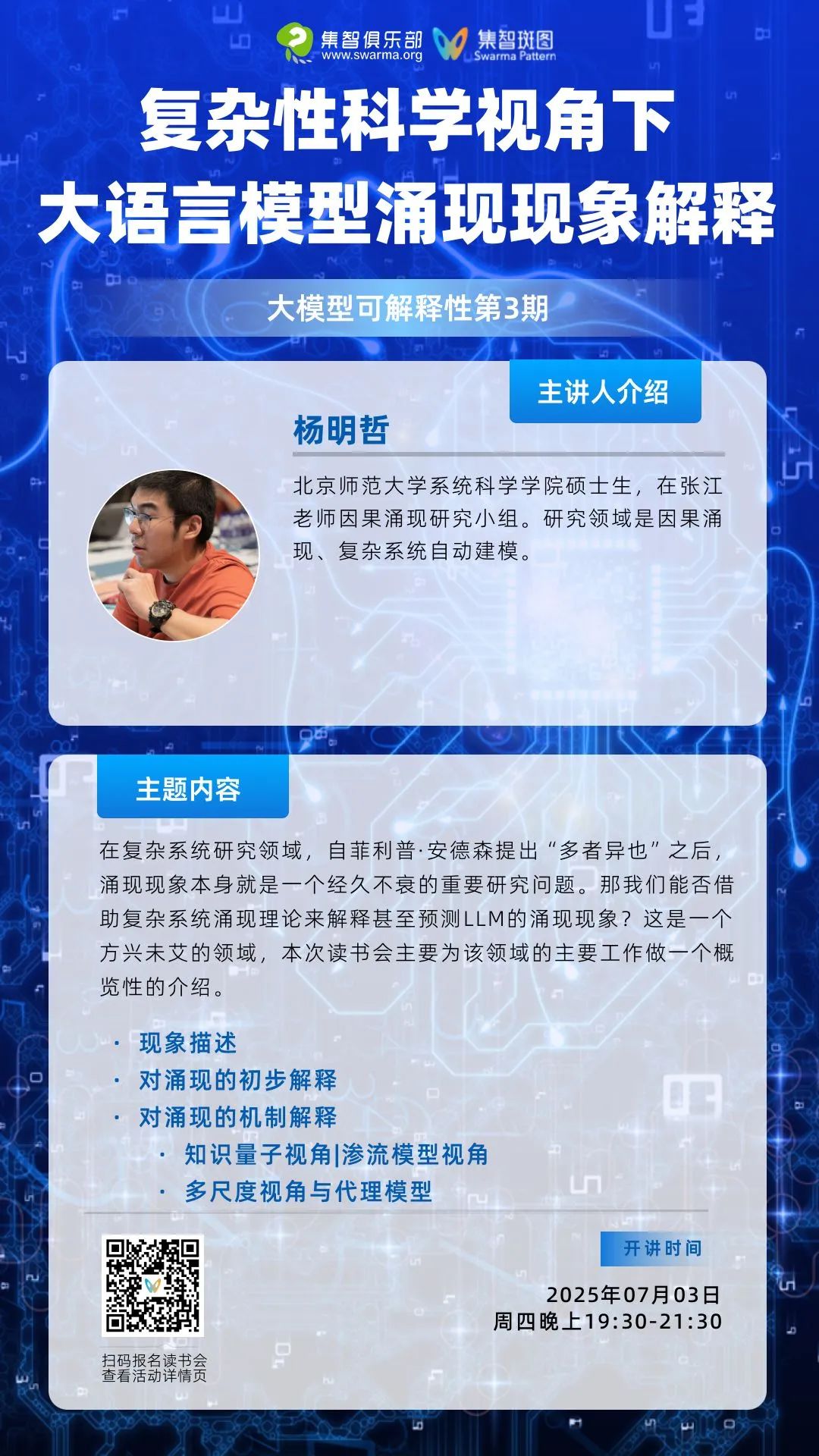

除了人们熟知的神经标度律,大语言模型还展现出了许多神奇的现象,比如涌现、顿悟等等。涌现是指,当LLM的规模达到某一阈值时,模型突然在某些方面的能力有了显著的提升。这种剧烈的非线性变化看起来是不可预测的。为什么会发生这样的现象?很多学者已经注意到这样的现象,并尝试解释它。

实际上,在复杂系统研究领域,自菲利普·安德森提出“More is different”之后,涌现现象本身就是一个经久不衰的重要研究问题。那我们能否借助复杂系统涌现理论来解释甚至预测LLM的涌现现象?这是一个方兴未艾的领域,本次读书会主要为该领域的主要工作做一个概览性的介绍。

分享大纲

分享大纲

1.现象描述

2.对涌现的初步解释

3.对涌现的机制解释

知识量子视角

渗流模型视角

多尺度视角与代理模型

核心概念

核心概念

涌现

渗流相变

互信息

序参量

神经标度律

参考文献

参考文献

1.「大语言模型」通过系统性评估发现,其涌现能力(如复杂推理)在模型规模突破临界阈值后突然显现,而非线性增长。(核心发现:当参数规模超过10^22时,LLMs在算术/推理等任务上表现出现跃升式进步,证明能力涌现具有规模依赖性)

Wei, J., Tay, Y., Bommasani, R., Raffel, C., Zoph, B., Borgeaud, S., Yogatama, D., Bosma, M., Zhou, D., Metzler, D., Chi, E. H., Hashimoto, T., Vinyals, O., Liang, P., Dean, J., & Fedus, W. (2022). Emergent Abilities of Large Language Models (arXiv:2206.07682). arXiv.

2.「大语言模型的涌现能力」通过任务指标重构分析提出质疑,认为其可能是评测中的度量选择(如非线性评分)或分词策略带来的统计假象,而非本质能力跃升。

Schaeffer, R., Miranda, B., & Koyejo, S. (2023). Are Emergent Abilities of Large Language Models a Mirage? (arXiv:2304.15004).

3.「Transformer涌现能力」通过渗流理论建模形式语言任务,揭示其能力突变本质是网络连接性在训练中达到临界阈值后产生的相变现象。

Lubana, E. S., Kawaguchi, K., Dick, R. P., & Tanaka, H. (2024). A Percolation Model of Emergence: Analyzing Transformers Trained on a Formal Language (arXiv:2408.12578).

4.探讨语言模型(LMs)在参数规模和训练数据扩展时,新能力如何涌现(如复杂推理、多步任务等),并尝试提供理论解释。

Arora, S., & Goyal, A. (2023). A Theory for Emergence of Complex Skills in Language Models (arXiv:2307.15936). arXiv. https://doi.org/10.48550/arXiv.2307.15936

5.「神经网络的量化缩放模型」提出信息压缩理论,证明模型性能的幂律缩放源于参数空间对数据分布的逐步量化逼近,且最优量化精度随模型规模对数增长。

Michaud E, Liu Z, Girit U, et al. The quantization model of neural scaling[J]. Advances in Neural Information Processing Systems, 2023, 36: 28699-28722.

6.「语言模型语义涌现量化研究」提出信息熵框架,证明语义理解能力的涌现源于潜在表征空间的层级化重组,其临界阈值与模型深度呈指数关系。

Chen, H., Yang, X., Zhu, J., & Wang, W. (2024). Quantifying Semantic Emergence in Language Models (arXiv:2405.12617). arXiv.

7.「大语言模型的生物学隐喻研究」提出神经可塑性启发的训练框架,证明Transformer注意力机制与生物神经网络突触修剪存在动力学相似性,其层级化信息整合遵循能量最小化原则。

Lindsey, et al., "On the Biology of a Large Language Model", Transformer Circuits, 2025.

主讲人介绍

主讲人介绍

杨明哲,北京师范大学系统科学学院硕士生,在张江老师因果涌现研究小组。研究领域是因果涌现、复杂系统自动建模。

参与方式

参与方式

参与时间

2025年7月3日(周四)晚上19:30-21:30

报名加入社群交流

https://pattern.swarma.org/study_group_issue/935?from=wechat

扫码参与「大模型可解释性」读书会,加入社群,获取系列读书会永久回看权限,与社区的一线科研工作者沟通交流,共同探索大模型可解释性这一前沿领域的发展。

大模型可解释性读书会

集智俱乐部联合上海交通大学副教授张拳石、阿里云大模型可解释性团队负责人沈旭、彩云科技首席科学家肖达、北京师范大学硕士生杨明哲和浙江大学博士生姚云志共同发起「大模型可解释性」读书会。本读书会旨在突破大模型“黑箱”困境,尝试从以下四个视角梳理大语言模型可解释性的科学方法论:

自下而上:Transformer circuit 为什么有效?

自上而下:神经网络的精细决策逻辑和性能根因是否可以被严谨、清晰地解释清楚?

点击“阅读原文”,报名读书会

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢