在人类认知进化的漫长历程中,语言一直是智能发展的关键枢纽。本文深入探讨了从早期自然语言处理到人工智能涌现的迷人旅程,揭示了智能发展背后的深层机理。通过追溯人类认知革命的历史轨迹,带你将探索语言、思维和智能之间错综复杂的关系,并解读人工智能如何逐步接近和模仿人类大脑的认知模式。这是一段关于智能本质、语言理解和认知边界的迷人探索。

欢迎在评论区分享你对“ 语言、思维与智能的关系 ”的理解并转发此文,我们将抽取两位读者赠送本书(留言中选后,凭转发截图获得免费领书资格)。

关键词:通用语法理论,规模法则,涌现,AGI

刘嘉丨作者

通过语言对思想建模通向AGI之路是人工智能研究者的共识。但是,如何让AI学会语言,像人类一样获取知识、推断复杂问题、创造新的思想,一直是人工智能领域最具挑战性的问题之一。早期的自然语言处理方法主要受到诺姆·乔姆斯基的通用语法(universal grammar,UG)理论的影响。这一理论认为,人类语言的学习并不是单纯依赖外部经验,而是人类天生具有一种内在的语法能力,即大脑中预设了一套基本的语法结构,使得我们可以轻松掌握和生成任何自然语言,而不是单纯地通过记忆大量句子进行交流。因此,世界上所有的语言都遵循完全一样的通用语法,即使文字的书写、发音完全不一样。乔姆斯基将语言的结构形式化为乔姆斯基范式,其中包括正则文法(regular grammar)、上下文无关文法(context-free grammar,CFG)等层次,为计算语言学提供了一个结构化的理论框架。在这一体系下,计算机可以使用句法分析技术,将句子分解成更小的语法单元,如名词性短语(noun phrase,NP)、动词性短语(verbal phrase,VP)等,并利用上下文无关文法构建语法树。例如,对于句子“The cat sits on the mat”,自然语言处理系统可以按照规则将其分解为 NP“The cat”+ VP“sits on the mat”,然后进一步细分,使其形成清晰的层级结构。基于通用语法的自然语言处理系统具有两个明显的优点:递归性和生成性。递归性意味着语法规则可以嵌套使用,例如“她说她认为他可能会来”这样的句子,尽管复杂,但可以根据递归规则进行解析。生成性意味着即便使用有限的语法规则,也可以生成无限多的符合语法规则的句子,而不必存储每个可能的表达方式。尽管这些优点使得通用语法在理论上具有很强的表达能力,但当面对庞大的语料库、真实世界的语言复杂性时,乔姆斯基的通用语法就会面临极大的困难。这是因为自然语言并不仅仅是一个数学上的组合问题,而是充满了歧义、隐喻和上下文依赖,甚至是文化影响。这些语言的复杂性和不可预测性使得语法规则的应用举步维艰。例如,句子“Colorless green ideas sleep furiously”(无色的绿色想法猛烈地睡着)虽然完全符合语法规则,但在语义上毫无意义。又如“Time flies like an arrow ”既可以理解为“时间像箭一样飞逝”,也可以理解为“测量时间的苍蝇喜欢箭”(这里“time”是动词,“flies”是名词)。因此,如果 AI 只依赖通用语法去理解语言,那么它要么生成符合语法规则但无法理解的句子,要么对句子产生错误的解析。这就像无限猴子定理(infinite monkey theorem)所揭示的问题:仅仅依靠随机组合,并不能带来真正的理解。无限猴子定理是一个经典的数学思想实验,它设想如果让无限多的猴子在打字机上随机敲击键盘,并且给予足够长的时间,那么最终它们必然会打出莎士比亚的《哈姆雷特》。从数学概率的角度看,这是成立的——即使是极小的概率事件,在无限的时间里也会发生。但是,即使猴子最终敲出了《哈姆雷特》的完整文本,它们仍然不可能理解其中的任何一个单词,也不可能体会“To be, or not to be, that is the question”(生存还是毁灭,这是一个问题)这句话所蕴含的生存的哲学思考。因此,无限猴子定理这个思想实验实际上揭示了一个深刻的问题:仅仅依靠随机排列,并不能带来真正的理解;真正的语言是由高度结构化和复杂语境共同驱动的。如果AI使用通用语法生成语言,它就像是猴子在打字机上随机敲击——生成的文本可能语法正确,但是缺乏逻辑性和真正的意义。例如,AI可能会生成“王子拿起剑,月亮高挂天空”这样符合语法的句子,但它并不清楚“王子”的行为与“月亮”之间是否存在合理的因果关系。因此,语言的确可以被一组有限的规则解析,但是语言的本质远比这复杂——语言涉及上下文推理、语境依赖、世界知识,甚至文化共识,而这些都是通用语法难以捕捉的部分。这就是基于“心理”的智能科学与基于“自然”的数学物理等科学在方法论上的巨大不同。在物理学中,我们可以用牛顿定律或相对论这样的第一性原理来解释和预测整个世界的运行。但是语言并没有“第一性原理”可以描述它的生成和理解,至少我们目前不知道。但是,我们知道人是能够生成和理解语言的;那么,为什么AI不能“抄人的作业”呢?

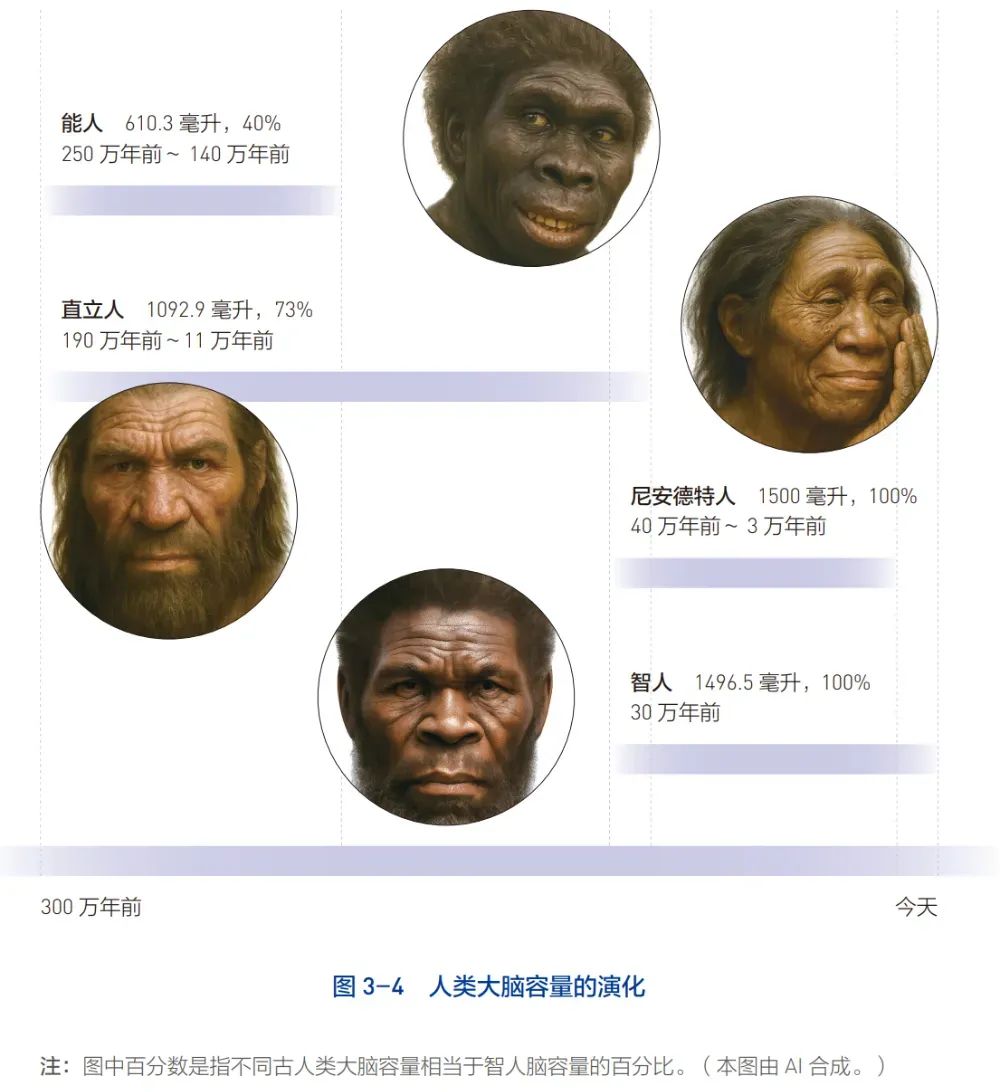

已有的事,后必再有;已行的事,后必再行。日光之下,并无新事。人工智能是人类以自身智能为模板创建的,因此,从考古学和人类学的角度去破解人类智能演化的奥秘,也许能帮助我们理解人工智能发展的道路。人类是在700万年前~500万年前与猩猩的祖先分道扬镳、独立进化的。在这个漫长的进化道路上,古人类留下的痕迹可以说是乏善可陈——他们的行为模式相对简单,与其他灵长类动物并无太大差别。他们能制造工具,但工具形式单一,改进缓慢;他们有基本的社会结构,但社交方式仍局限于小规模的亲缘群体;他们懂得利用自然资源,但缺乏长期规划和象征性思维。但是,在距今10万年前到7万年前,人类犹如被仙人抚顶,瞬间开智,其行为和认知模式突然加速进化,创造出一种完全不同于以往的生存方式(见图3-2)。这个进化路径上的转折点,被人类学家称为“第一次认知革命”。在这场认知革命中,人类从单纯适应环境的生存者,转变为主动创造和改变世界的发明者。在这场认知革命之前,人类的发明速率几乎处于停滞状态,少有的发明主要体现在工具的精细化改良上,而没有质的飞跃。例如,阿舍利手斧(Acheulean handaxe)是旧石器时代中期最具代表性的工具,使用时间跨度在170万年前至20万年前,并随着人类的迁徙传播到欧洲、中东和南亚,甚至远至我国。尽管在材料选择和打磨工艺上有所改进,但是在这漫长的近150万年里,其基本形态保持一致:双面修整,呈椭圆形或泪滴形,一端较尖,另一端较宽,整体对称,边缘锋利。在第一次认知革命中,人类的发明开始呈现突破性变化,在工具制作上出现了前所未有的多样性。例如,现代智人进入欧洲后建立的第一个主要文化——奥瑞纳文化(Aurignacian culture)所发明的骨制鱼叉有多齿设计,明显比之前的简单尖头鱼叉更适合捕鱼。更重要的是,人类开始创造非实用性的物品,如装饰品和象征性符号。例如,分布在今天以色列、巴勒斯坦、黎巴嫩、叙利亚和约旦地区的纳吐夫文化(Natufian culture)遗址中出土了贝壳项链和动物牙饰品,在南非布隆博斯洞穴中有刻画在红色赭石上的几何图案,以及在法国肖维岩洞里描绘动物、手印和抽象符号的绘画。这表明,人类已经学会了用艺术和符号记录信息、表达情感,而不仅仅是制造工具。最能体现这一点的是现代智人在各式物品上留下的条纹。考古学家在出土的7.7万年前的石斧和6万年前的鸵鸟蛋壳化石上都看到了有规律的条纹,但具体意义不详;而在距今4.3万年前的狒狒骨头化石上发现了 28 道平行的刻痕,代表的是一个月的阴晴圆缺。由此,距今约5000年前苏美尔人在泥板上用楔形文字记录南天星座那颗将黑夜照成白昼的超新星,也就水到渠成、自然而然了。在这场认知革命的背后,是人类思维模式的根本性改变。在此之前,人类的思维更接近于直接经验型思维(experiential thinking),即行为依赖于环境中的即时刺激和长期习得的经验。他们的工具制作可能是通过模仿传承,而不是基于创造性推理。在此之后,人类的思维开始转向假设推理型思维(hypothetical-deductive thinking),即能够在实际制造前,先在头脑中构思并模拟可能的结果。正是这个思维模式的转变,人类才真正从“动物”进化成“人”——我们不再是大自然食物链中的一环,而是跳出了食物链,把其他动物变成我们的食物或者宠物,成为这个世界的主宰。触发第一次认知革命的原因并无定论。例如,气候变化学说认为是距今约7万年前地球经历的剧烈的气候波动,极端干旱、冰期和火山爆发迫使古人类改变思维模式,寻找更有效的生存策略。在我看来,300万年的演化并非历史的垃圾时间,古人类在这段漫长的时间里,正在一点点壮大智能的物质基础:大脑。在能人[1]时期(250万年前~140万年前),能人的大脑容量为600~750毫升;在直立人[2]时期(190万年前~11万年前),直立人的大脑容量增长到900~1100毫升。到了尼安德特人[3]时期(40万年前~3万年前),其脑容量已达1200~1700 毫升,甚至超过了现代智人[4]1200~160毫升的脑容量(见图3-4)。因此,尼安德特人曾在与早期智人的竞争中占据优势,这一点并不令人意外。人类大脑的演化是生物进化史上最大的奇迹。300万年放在生命进化的时间尺度上看,只是弹指一挥间,而人类大脑的体积增加了近3倍,远远超过了其他器官的演化速率。更令人惊讶的是,大脑的演化违反了进化的基本原则:演化的目标是能量效率最大化,大脑体积的增长却意味着更高的能量消耗——现代人类大脑仅占体重的2%,但却消耗着超过20%的身体能量。这表明大脑的演化一定带来了巨大的适应性优势,足以抵消其高能耗的缺点。这个优势就是算力的提升。正如我们不能指望只有302个神经元的线虫学会人类的语言,甚至最基本的趋利避害对它而言都是难以触达的智力巅峰。因为它的神经元数量太少,无法承载最基本的认知活动,也无法存储过去的经验。同样,我们也不能指望脑容量不到600毫升的能人创造璀璨的文明、制造脱离地球引力的飞船。所以,一位从事人才选拔的心理测评的同事说过这样一句话:“高个子不一定能打好篮球,但是篮球教练一定会选高个子。”

大脑是一个复杂系统。复杂系统通常由大量的个体组成,如大脑神经网络中的神经元、经济市场中的企业、生态系统中的物种等。复杂系统具备一个关键特点:其规模必须足够大。只有规模大,才能提升系统的复杂度。例如,小型社群的复杂度远小于全球经济的复杂度——全球经济涉及数十亿个体及其相互作用,远比一个小型村落复杂。在这复杂度的背后,是个体之间相互作用的模式变得异常复杂,导致非线性增长。例如,正是从能人到智人的大脑容量的显著增加,使得超大规模的神经网络的信息处理能力呈指数级增长,形成比单个神经元更高级的认知能力。此时,整体系统表现出“1+1>2”的超越个体层面简单相加的状态,即涌现。例如,单个神经元并没有意识,但当众多的神经元交织在一起,意识就会自然涌现。模拟大脑神经网络架构和运行模式的AI也不例外。2022年6月,也就是ChatGPT发布的5个月前,OpenAI发表了一篇划时代的论文《大语言模型的涌现能力》。在这篇论文中,OpenAI的研究者挑战了人们对人工智能能力增长的线性假设,指出某些复杂能力不会随着模型规模的平滑增长而逐步显现,而是在达到某个临界点后,系统的内部表征会发生“非线性跃迁”,使得这些复杂能力突然涌现。例如,小规模的语言模型在面对训练语料较少的小语种,如斯瓦希里语(Swahili,坦桑尼亚和肯尼亚人使用)或他加禄语(Tagalog,菲律宾人使用),或者具有文化背景的成语、俚语,如“望梅止渴”时,无法进行有效翻译。但是,当语言模型的规模足够大时,面对同样少的语料,该语言模型就能对这些语言进行有效翻译。例如,小模型会把望梅止渴直译成“looking at plums quenches thirst”。而大模型在翻译此成语时,首先是理解“望梅止渴”的深层含义,即“通过想象某种美好的事物缓解当下的痛苦”,然后找到更适合英语文化的等效表达:“hope sustains the soul”(希望支撑着灵魂)。也就是说,小模型依赖的是词汇对齐的统计规律,大模型则“理解”了通用的语义表征,从而能够在不同语言之间通过语境和语义理解进行概念映射。大模型对语言的“理解”,就是涌现。更有趣的是,大语言模型还能涌现出非常高的情商。在我们课题组的一个研究中,大家用不同规模的语言模型来分析这个特定场景中小王的情绪体验:“小王参加了一场数学竞赛,但他觉得自己发挥得不够好。然而,当成绩公布时,他发现自己进入了前十名。”语言模型被要求给四种与该场景相关的情绪(惊讶、喜悦、困惑和自豪)分配比例,某种情绪分配的比例越高,表明该情绪的强度越大。大语言模型GPT-4给出了这样的分配和解释:» 惊讶:40%。理由:自我预期与实际成绩之间存在较大落差,因此» 喜悦:35%。理由:进入前十名的好成绩不可避免地带来喜悦。» 困惑:15%。理由:他对自身评价和客观结果之间的差异不理解。» 自豪:10%。理由:尽管之前对自己信心不足,但优异的成绩依然会激发出小王的自豪感。我们拿同样的问题测试了541名17~30岁的大学生和研究生。我们发现GPT-4在这500多人构建的常模中,情商得分是117分(平均分是100分,15分为一个方差),超过了近 90% 的人的情商。测试的小模型,要么完全不能分析小王的情绪,要么得分远低于常人。更有趣的是,比GPT-4更先进的 GPT-o3-mini-high 在完成小王的情绪分析后,还额外指出:原来的题干漏掉了一个重要的情绪——解脱,因为小王在担心自己发挥不佳的情况下,突然收到好的结果,会让小王感到一种心理上的放松和解脱。于是,它的最终答案是:惊讶40%,喜悦30%,困15%,解脱10%,自豪5%。除了语言模型的复杂度随着规模增长而提升和大模型的分布学习能力更强等原因,OpenAI的研究者猜测,大模型表现出高情商的原因是其自组织能力在参数量达到一定规模后,触达智能的临界点,形成了小模型没有的认知结构。这就像人类的大脑一样——当大脑的容量达到一个临界值,第一次认知革命就降临了。为了验证这个猜测,麻省理工学院的研究者提出了 Brain-Score的评估框架,以此探讨人工神经网络的复杂性与大脑相似性的关系。Brain-Score 是通过比较人工神经网络与灵长类大脑在神经活动和行为反应上的相似性,来量化人工神经网络的生物逼真程度。研究发现,具有更深的层数(增加神经元变换次数)、更大的参数量(提升表达能力)以及更丰富的特征抽取能力(能更好地刻画层级关系)的人工神经网络更容易逼近大脑的信息加工机制。例如,视觉模型ResNet-50(50层,约2550万参数)能够学习到复杂的形状和物体特征,但是更复杂的ResNet-152(152层,约6000万参数)能捕捉更高级的语义信息,因此它在Brain-Score 的评估中更接近大脑的视觉系统。这个现象同样适用于语言模型。例如:GPT-2(15亿参数)只能进行简单的句子预测和对话,类似儿童的大脑;GPT-3(1750亿参数)开始展现跨语言翻译、写诗、编程等复杂能力,类似大学生的大脑;而GPT-4(在本书写作时具体参数规模尚未公开,普遍推测可能高达1.8万亿参数)能够进行复杂的法律分析、情感陪伴和医学问答,类似专业人士的大脑。这表明提高神经网络的复杂度不仅可以提升AI的性能,还能让模型更接近生物大脑的工作方式。人工神经网络所展现出来的“大即是好”的现象并非偶然;它遵循的是花费了亿万美元,通过大量实验归纳出来的、在人工神经网络领域里最重要的经验公式:规模化法则。OpenAI 在其2020年发表的论文《神经语言模型的规模化法则》中提出了“规模化法则”的概念,其核心观点是:如果我们不断增加神经网络的参数量(层数、神经元个数等),它的损失(AI 任务表现好坏的指标)会按照可预测的方式下降,即模型越来越“聪明”,任务表现越来越好。简言之,更大规模的模型总是能更好地逼近最优解。一个形象的比喻是人类的智能。想象一下:一个人有100本书的知识储备,另一个人有10000本书的知识储备。显然,后者在面对复杂问题时更具优势,因为他能够从更广泛的信息中找到更合适的答案。同样的道理,当神经网络的参数从 10 亿扩展到 1000 亿时,它就像从一本小字典变成一整座图书馆,不仅能记住更多的信息,还能学会更复杂的模式和推理方式。这就是涌现背后的机制。这种能力的涌现,并不是因为模型被刻意设计去执行这些任务,而是因为当参数规模变大时,神经网络的学习能力超过了某个临界点,从而自然地学会了更复杂的模式和推理方式。所以,如果我们想让人工神经网络真正达到甚至超越人类智能的水平,最简单的方法可能就是“大力出奇迹”——继续扩大参数规模。2020年11月,杰弗里·辛顿在GPT-3问世半年后,接受《麻省理工学院技术评论》采访时说“深度学习将来可以做任何事”,之所以现在GPT-3离人类智能还有一定的距离,是因为“人类的大脑有大约100万亿个突触连接。我们现在所说的真正的大模型,如GPT-3,有1750亿参数,只有大脑的千分之一点几”。致敬《银河系漫游指南》,书中有一个场景:超级计算机“深思”在经过 750 万年的计算后,给出“生命、宇宙以及一切的终极问题”的答案是“42”。辛顿在推特上发文说:“从GPT-3出色的性能可以推断,生命、宇宙和万物的答案不过是4.398万亿参数而已。”是不是4.398万亿参数不重要,重要的是辛顿所表达的理念:“智能不够,参数来凑。”当然,即使在今日,众多学者对于规模化法则还没有完全达成共识,因为不少人至今难以相信,智能的第一性原理竟然只是“大”,而不是精妙的算法或灵巧的设计。可以想象,如果在40年前就坚信并四处宣传这个智能的第一性原理,这个人一定会被世人当成疯子。这个疯子就是深度学习之父:杰弗里·辛顿。在霓虹灯的闪烁、蚁群的精密协作、人类意识的诞生中,隐藏着微观与宏观之间深刻的因果关联——这些看似简单的个体行为,如何跨越尺度,涌现出令人惊叹的复杂现象?因果涌现理论为我们揭示了答案:复杂系统的宏观特征无法通过微观元素的简单叠加解释,而是源于多尺度动态交互中涌现的因果结构。从奇异值分解(SVD)驱动的动态可逆性分析,到因果抽象与信息分解的量化工具,研究者们正逐步构建起一套跨越数学、物理与信息科学的理论框架,试图解码复杂系统的“涌现密码”。

为了系统梳理因果涌现最新进展,北京师范大学系统科学学院教授、集智俱乐部创始人张江老师领衔发起「因果涌现第六季」读书会,组织对本话题感兴趣的朋友,深入研读相关文献,激发科研灵感。

读书会将从2025年3月16日开始,每周日早9:00-11:00,持续时间预计10周左右。每周进行线上会议,与主讲人等社区成员当面交流,之后可以获得视频回放持续学习。诚挚邀请领域内研究者、寻求跨领域融合的研究者加入,共同探讨。

6. 探索者计划 | 集智俱乐部2025内容团队招募(全职&兼职)

7. 系统科学前沿十讲:理解自然、生命与社会的复杂性

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢