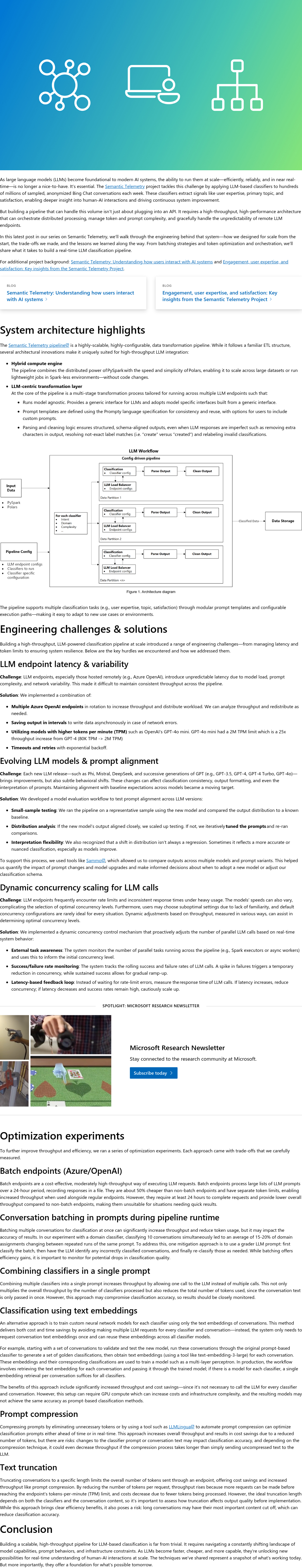

随着大语言模型(LLMs)成为现代AI系统的基础,在近实时条件下高效、可靠地大规模运行LLMs已变得至关重要。Semantic Telemetry项目通过每周对数亿条采样、匿名的Bing Chat对话应用基于LLM的分类器,提取用户专业水平、主要话题和满意度等信号,以深入理解人机交互并推动系统持续优化。然而,构建如此规模的处理流程不仅依赖API调用,还需高吞吐、高性能的架构,以协调分布式处理、管理令牌与提示复杂性,并应对远程LLM端点的不确定性。本文介绍了该系统的工程设计思路与实现方法。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢