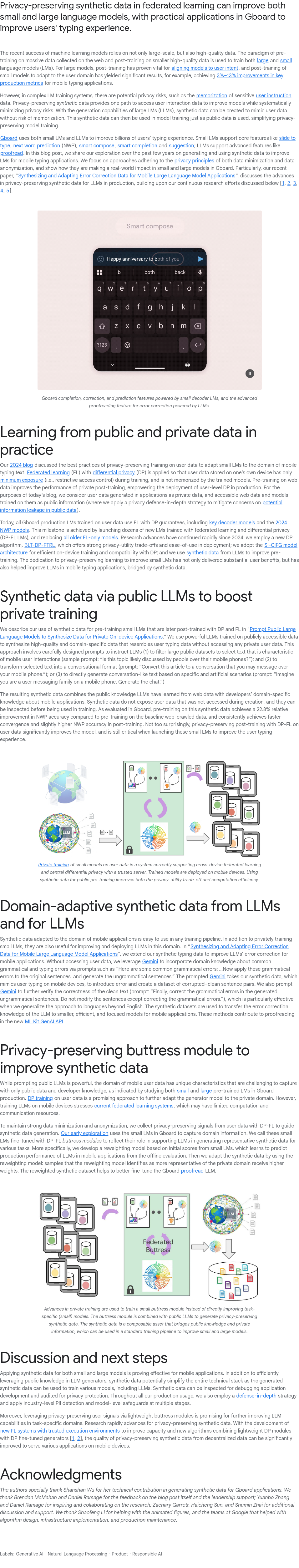

隐私保护的合成数据在联邦学习中可用于改进大小型语言模型,已在Gboard等实际应用中提升用户输入体验。当前机器学习的成功依赖于大规模且高质量的数据。通常采用在海量网络数据上预训练、再在小规模高质量数据上微调的范式来训练语言模型。对于大型模型,微调有助于对齐用户意图;对于小型模型,领域适配也取得了显著效果,例如在移动输入应用中关键指标提升了3%–13%。然而,在复杂的语言模型训练系统中存在隐私风险,如模型可能记忆敏感用户数据。使用隐私保护的合成数据是一种可行路径,既能利用用户交互数据提升模型性能,又能系统性地降低隐私泄露风险。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢