量子机器学习(Quantum Machine Learning, QML)指利用量子算法对经典或量子数据进行编码,并结合梯度下降或变分方法等技术自适应地优化量子态,从而实现模型训练。在完成训练后,QML模型可基于学习到的量子表示执行预测或生成任务。尽管当前已有多篇探讨QML在化学领域应用的综述性文献,针对门控量子计算架构下的量子神经网络(Quantum Neural Networks, QNN)的系统性综述仍属稀缺,现有文献多聚焦于宏观概念,缺乏对QNN底层算法结构的深入分析。

2025年6月6日,耶鲁大学、NVIDIA与Moderna的研究人员在《Chemical Reviews》期刊发表题为《Quantum Machine Learning in Drug Discovery: Applications in Academia and Pharmaceutical Industries》的综述文章,探讨了QNN在药物研发中的应用潜力,并分析其面临的机遇与挑战。

背景

量子计算

量子计算通常基于量子寄存器执行酉变换(unitary transformation),即通过“量子门”对量子态进行演化。计算过程通常包括三步,初始化量子态,通过算法进行酉演化,测量坍缩(collapse)得到结果。测量后量子态会坍缩,且每次测量结果具有概率性,因此通常要重复成数千次测量以获得统计平均结果。

量子比特(qubit)与经典比特不同,可以处于|0>、|1>或二者的叠加态(即两个态的线性组合)(公式1)。量子门(quantum gates)实现对量子态的操作,类似于经典计算的逻辑门,但其操作必须保持可逆性并作用于叠加态。测量会将叠加态投影到基态(如|0>或|1>),根据特征方程求解得到相应的本征值(如+1/-1),量子态随即发生坍缩。最终计算结果通过多次测量并取平均,以减少量子噪声的影响。

公式1 qubit的叠加态

量子力学引入了叠加(superposition)和纠缠(entanglement)等概念,从而实现了计算并行性。量子叠加意味着多个量子态可以同时存在于一个量子系统中,是量子计算并行性的根本来源,使得n个qubit可表示2的n次方个状态。量子纠缠指多个qubit之间存在量子关联,一旦对其中一个qubit进行测量,其它qubit的状态也随即确定。

鉴于当前量子硬件仍受限于噪声干扰、qubit数量有限等因素,研究重点转向了量子-经典混合计算方法架构。在该框架中,部分计算由量子计算机执行,其余计算则交由传统的高性能计算机完成。其中一个前景广阔的方向是利用量子计算机实现机器学习算法。借助量子算法的加速能力,有望解决数据分析和模式识别中的复杂问题。

量子机器学习

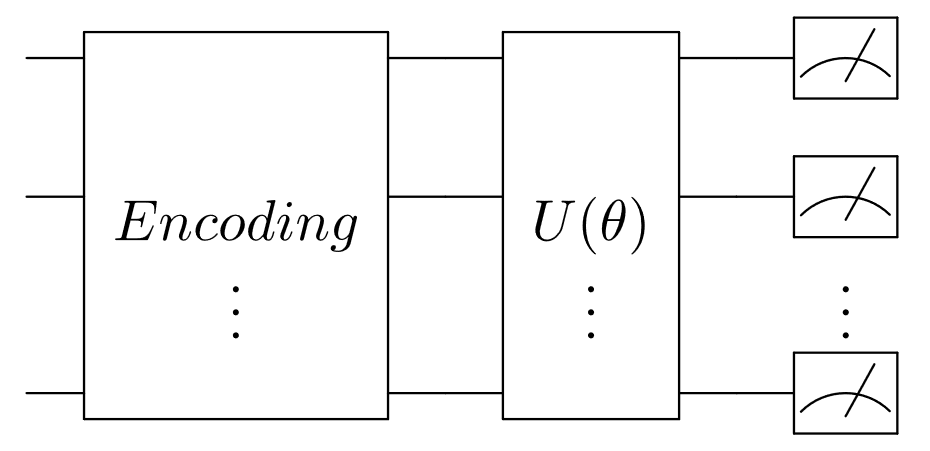

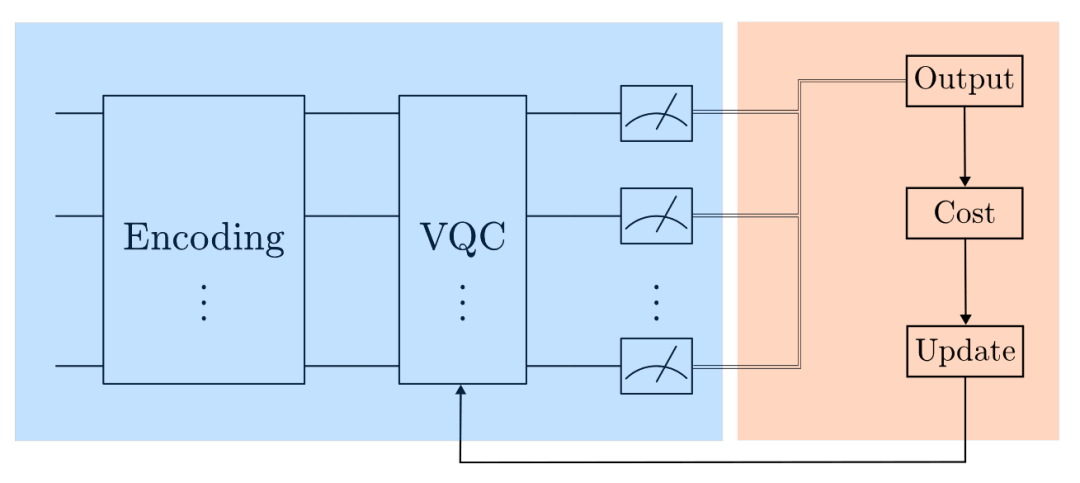

QNN通常包括三个核心模块:数据编码、带有可学习参数θ的变分量子门,以及测量(图1)。数据编码的作用是将经典数据转换为量子态。数据编码策略的选择不仅会显著影响模型性能,还会影响其底层的计算复杂度。

图1 典型QNN架构

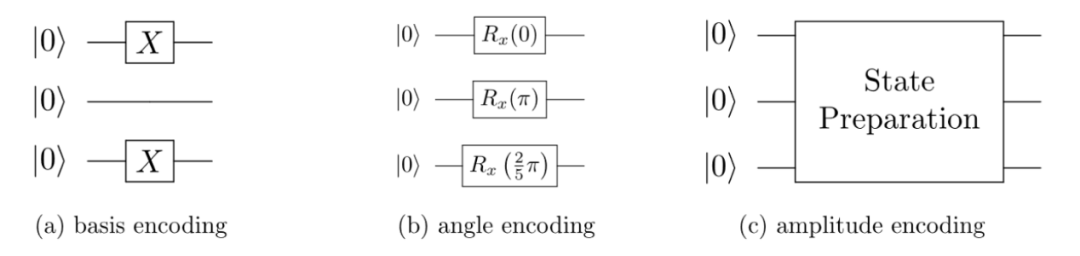

常用的数据编码策略有以下三种(图2):

1)Basis Encoding: 将每个数据转换为n位由0或1组成的线性串。

2)Angle Encoding: 将数据值映射为绕布洛赫球面(Bloch sphere)上某一轴的旋转角度。

3)Amplitude Encoding:将数据点编码为量子态的振幅。能够指数级减少表示数据所需的比特数,因此具有实现经典计算机无法达到的加速潜力。

图2 三种常见的数据编码策略

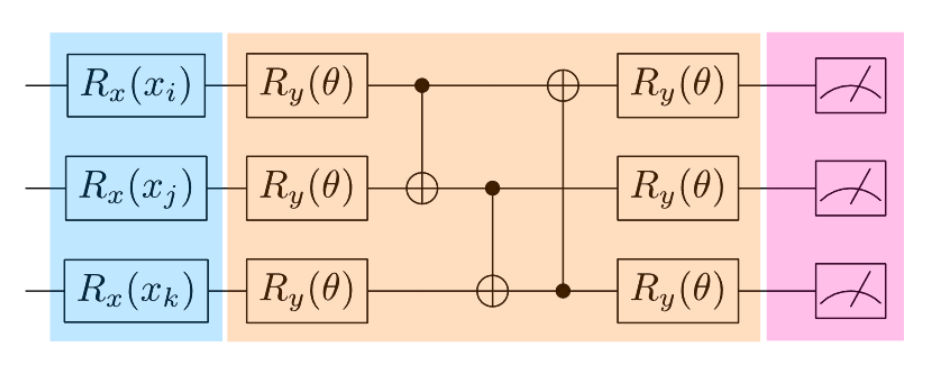

变分量子电路(Variational quantum circuits, VQCs),也常被称为参数化量子电路(parametrized quantum circuits, PQCs),通常承担引入可学习参数θ的功能(图3)。在 VQC之后,会进行测量操作,测量结果通常需要通过经典后处理来获得期望值的平均。随后,经典优化器基于损失函数(通常与期望值相关)调整参数θ,以不断改进模型性能。

图3 3 qubit的QNN架构

整个量子-经典混合机器学习流程如图4所示。

图4 QML整体流程图

预测式QML

量子图神经网络

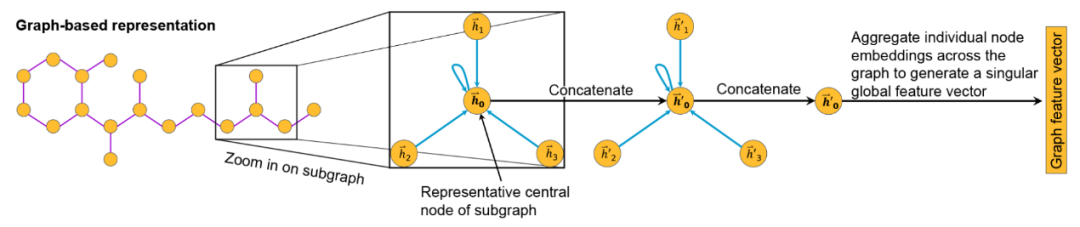

图神经网络(GNNs)因其能将分子自然地表示为图结构(节点代表原子,边代表键)而被广泛应用于化学领域的机器学习任务(图5)。量子图神经网络(QGNNs)最初由Networked Quantum System提出。在该系统中,有着节点集𝒱和边集ℰ的图𝒢={𝒱,ℰ},由表示节点和边的Hilbert子空间的张量积来表示。

图5 GNN提取分子特征

随着研究的推进,学者们相继提出了多种QGNN的理论模型,并探索了等变图(equivariant graphs)上的量子学习方法。例如,等变QGNN和混合量子-经典QGNN已被用于预测QM9数据集中分子的HOMO–LUMO能隙(该指标可反映分子稳定性)。研究表明,在参数数量相同的情况下,QGNN模型通常优于其经典对应模型,且训练效率也更高,表明其具有良好的可扩展性和泛化能力。此外,量子同构图网络和量子图卷积网络也已被用于蛋白-配体结合亲和力预测,结果显示混合模型已能与当前最先进的经典模型持平。Liao等人进一步对Simple GCN和Linear GCN的量子实现进行了系统分析,结果表明其在空间和时间复杂度方面均展现出量子加速的潜力。

量子卷积神经网络

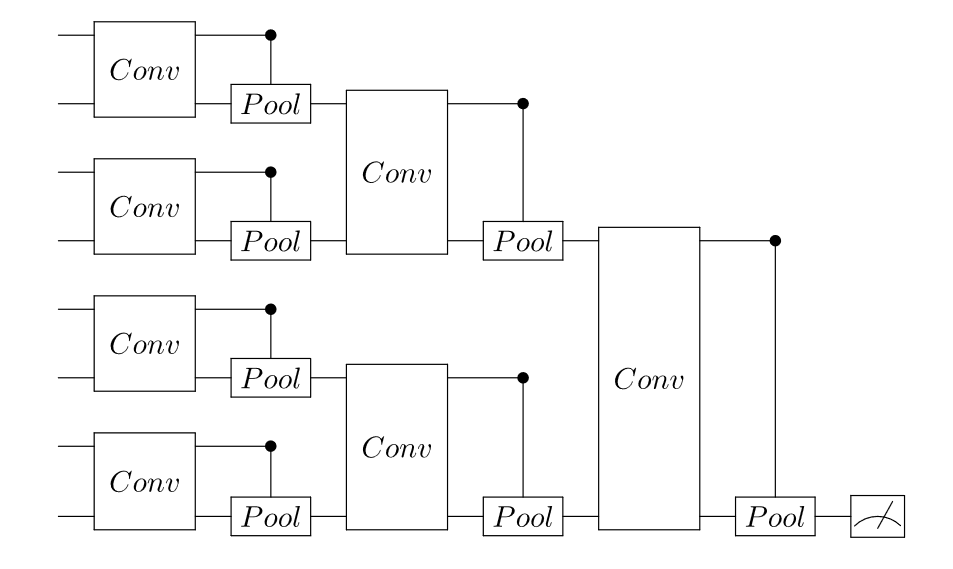

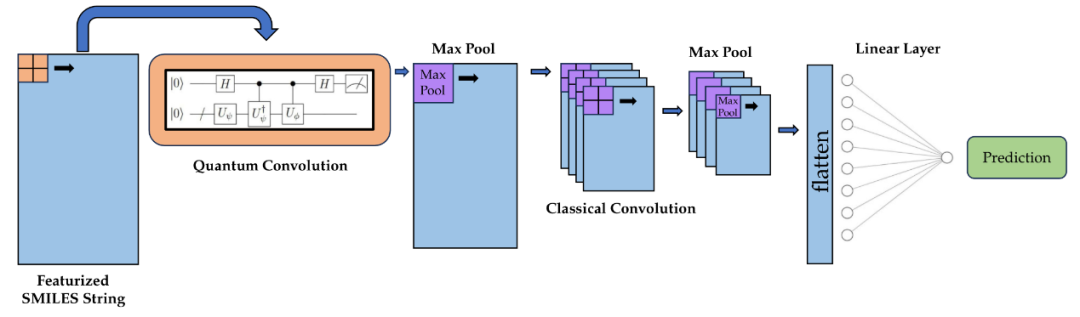

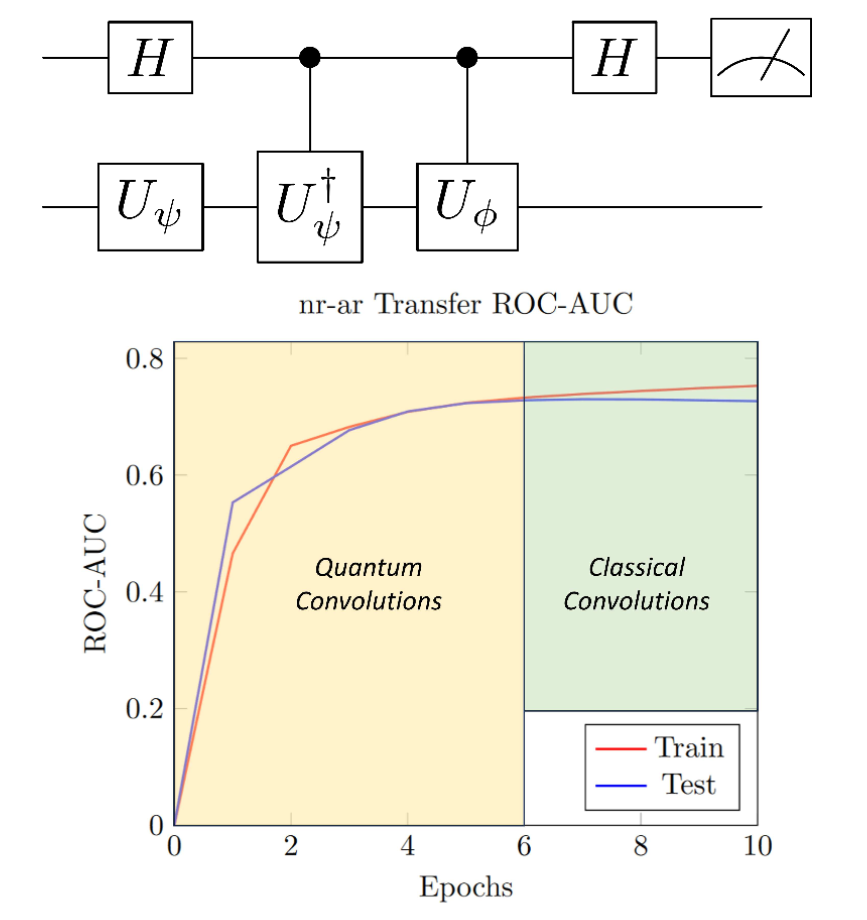

在QCNN中,经典CNN中的卷积滤波器被量子电路所取代(图6)。经典CNN的计算过程涉及小尺寸卷积核与输入数据之间的离散卷积,这一特点使得QCNN可以仅加载少量信息到量子设备中,这在生物学场景下尤为重要,因为完整特征图的数据量过于庞大。

图6 由Cong等人提出有log(N)参数的QCNN架构

当前主要存在两类被认为具有量子优势的QCNN架构:

1)如图6所示的结构:该类QCNN进行池化操作时在每一层将参与计算的量子比特数量减半。其仅使用O(log(N))的参数,能够有效避免barren plateaus问题。

2)Hybrid-QCNN(HQCNN):在前向传播中以量子电路替代卷积操作,但在测量后通过经典方法进行池化。这类模型保留了更多的经典控制能力,量子与经典模块的协同可进一步提升整体性能。然而,这种优势通常伴随着模型可训练性的下降及架构复杂性的增加。

图7 HQCNN架构

与标准QCNN相比,HQCNN具备更高的结构灵活性。研究人员提出,HQCNN可在传统CNN架构中实现量子加速(图7),具体方式为:以量子方式直接计算滤波器与输入数据之间的内积。这种方法与具体任务无关,并且性能的关键主要取决于数据表示方式。此外,Smaldone与Batista将HQCNN应用于药物毒性预测任务中(图8),该方法利用量子电路训练卷积层的权重,并以二次量子加速实现矩阵乘法。此策略在保持与经典CNN相同参数数量的前提下,能获得相似性能,并可在中期训练时切换为经典CNN以实现无噪声的收敛。

图8 Smaldone和Batista的HQCNN架构及学习曲线

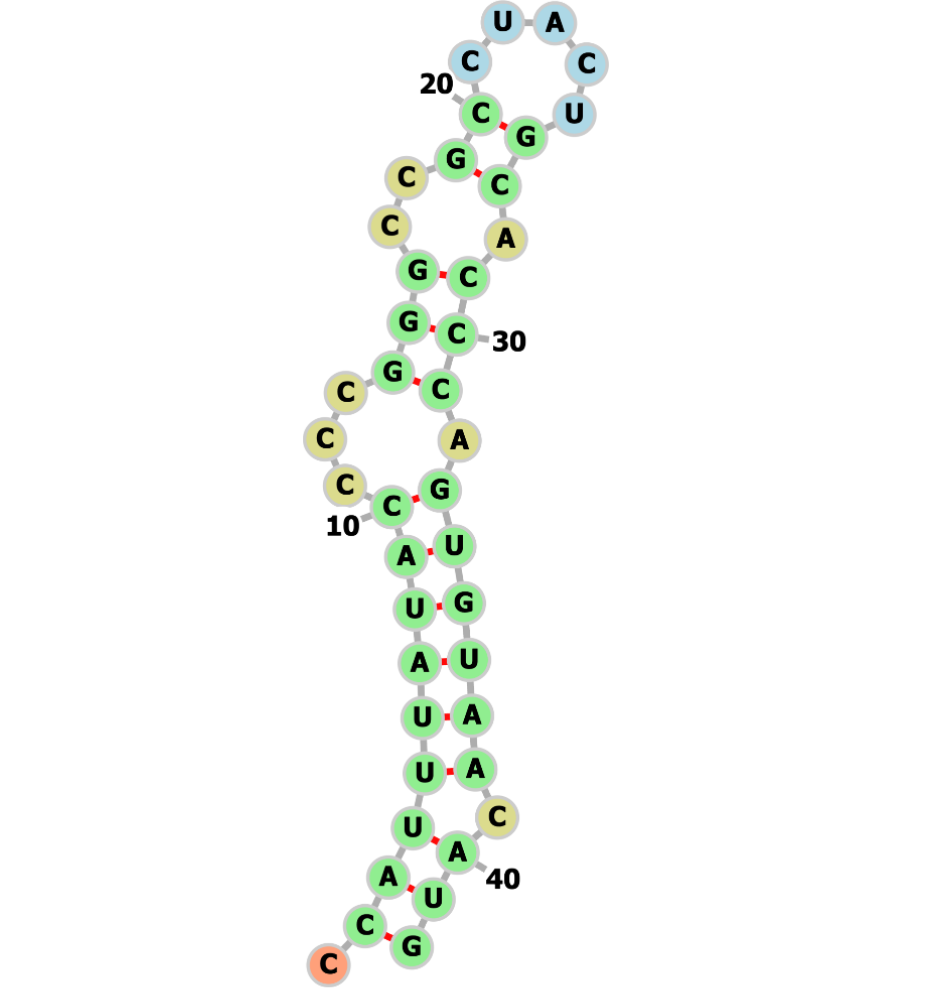

展望:用于大分子的QML

mRNA和抗体类生物治疗药物是下一代疗法开发中的关键组成部分,但它们本身也带来了诸多复杂挑战,例如确定mRNA的结构以及理解抗体-抗原的相互作用。量子计算在预测mRNA 二级结构方面已经展现出潜力(图 9),而QNN如今也正被应用于应对抗体-抗原相互作用等问题。Paquet等人提出了QuantumBound,一种用于预测受体-配体复合物中配体理化性质的混合量子神经网络模型。此外,Jin等人开发了一种QNN模型,利用现有的SARS-CoV-2 RNA序列来预测潜在的新冠病毒变异株。这些早期成果展示了量子神经网络在解决生物治疗关键挑战方面的潜力。

图9 使用IBM量子处理器Heron上的80个物理量子比特,通过VQE算法计算出的42个核苷酸序列的最优折叠mRNA结构。

生成式QML

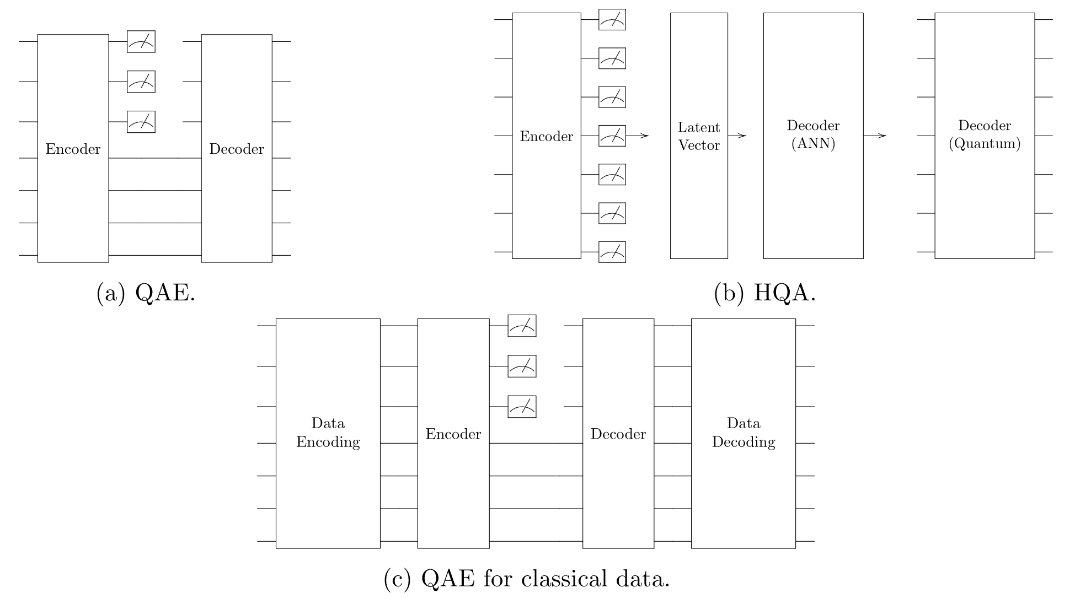

量子自编码器

量子自编码器(Quantum Autoencoders, QAE)主要有两种类型,均采用混合量子-经典架构,即由经典计算机负责参数优化。第一种类型以量子电路为模型结构(图10a),通过量子门和操作符对量子态进行编码与解码。第二种类型为混合量子自编码器(Hybrid Quantum Autoencoder,HQA),将量子测量结果作为隐表示(图10b)。该方法在模型结构中融合了经典神经网络和QNN,利用从量子测量中获得的经典向量进行进一步分析和处理。另一个变体是量子变分自编码器(Quantum Variational Autoencoder, QVAE),它采用第一类QAE的架构,但引入了类似经典VAE的正则化潜在空间,正则化后的潜在空间可提升分类性能。

图10 不同种类QAE架构

尽管QAE展现出一定的潜力,但仍面临若干挑战。首先,其训练过程依赖于经典优化算法,这使得整体计算复杂度难以准确评估。其次,在处理经典数据时,将其编码为量子态本身便是一项非平凡任务,可能抵消量子计算所带来的潜在加速优势(图10c)。目前尚无法宣称QAE在经典数据处理方面优于经典方法。

量子生成对抗网络

Dallaire-Demers和Killoran首次提出了量子生成对抗网络(QGAN)的概念,在GAN框架中引入量子电路,特别是利用量子电路进行梯度测量。Romero和Aspuru-Guzik进一步扩展了QGAN的概念,提出了用混合量子-经典方法对连续的经典概率分布建模。在小分子生成任务中,QGAN 在 QM9 数据集上的实验表明,量子模型在表达能力和参数数量方面具有一定优势,但在生成分子的有效性和类训练性方面仍存在显著不足。Anoshin等人提出了用于小分子生成的混合量子循环生成对抗网络(hybrid quantum cycle-GAN),该模型基于先前研究提出的cycle-consistency框架。在多个评估指标上,该模型展现出与经典方法相当或更优的性能,包括唯一性、有效性、多样性、类药性、可合成性与溶解性,突显出混合量子-经典架构在提升分子生成质量方面的潜力。

尽管QGAN展现出一定前景,仍面临诸多挑战。完整的量子判别器虽然具有较强的表达能力,但这种能力的提升往往以牺牲其他关键性能指标为代价。此外,在药物性质等重要维度上,即便混合网络取得了改进,其背后量子组件所做出的贡献仍不够明确。因此,当前的关键任务之一是在不降低其他性能指标的前提下实现模型表达能力的进一步提升。

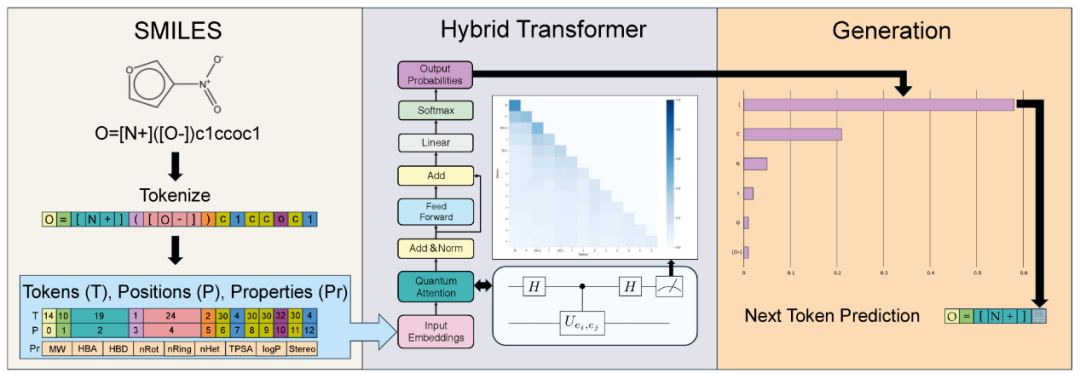

展望:量子Transformer

经典Transformer在机器学习领域的广泛成功,激发了研究者将该架构引入量子机器学习的兴趣。目前,大多数量子Transformer的实现形式更倾向于视觉Transformer(ViTs)。尽管经典的ViT模型已被用于化学和生物物理学中的预测任务,但在药物发现中仍集中于基于Transformer的生成模型。此外,基于量子的GPT类模型(Generative Pretrained Transformers)尚处于初期阶段,目前相关研究多为理论探索,但该领域正在快速发展。

图11 用于分子生成任务的量子-经典混合Transformer模型的整体流程

虽然现阶段这些模型尚未展现出显著的量子复杂度优势,但这不应成为阻碍其在药物研究中应用的理由。该领域仍处于初期探索阶段,为学术界和制药工业提供了发现潜在突破点的良好契机。未来,若能有效融合经典Transformer与量子Transformer提取的多层次特征,或可实现对分子化学与生物功能更深层次的理解,进而推动下游药物设计任务的进展。除了量子Transformer架构外,还存在其它融合量子模块的混合生成模型。例如,Vakili等人展示了一种结合量子玻尔兹曼机与LSTM的模型,成功生成了具有KRAS抑制活性的有效SMILES分子,其中两个候选分子在体外细胞实验中展现出微摩尔级别的活性。这表明即便在非Transformer架构下,量子生成模型也具备现实应用前景。

玻色量子处理器在QML中的潜力

量子模式(Qumode)是量子谐振子的状态(公式2),属于连续变量(Continuous Variable, CV)量子信息处理范畴(公式3)。qumode可以表示为Fock基底的线性组合,实质上是qubit的一种扩展形式(从2维扩展为d维,也称qudit),可用于构建更大的Hilbert空间。基于qubit-qumode的混合架构融合了qubit的离散逻辑与qumode的连续可扩展性,为量子计算带来了更高维度的特征空间、更强的表达能力以及更优的硬件容错性。

公式2 qumode形式

公式3 连续变量表示

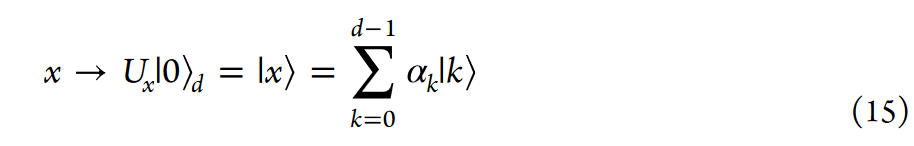

为实现经典或量子数据的编码,可将qumode耦合到qubit的量子态中。当前主要有两种方法:第一种方法类似于qubit系统中的amplitude encoding,将一个长度为d的向量编码为一个d-能级qubit中的幅度(公式4)。其中Ux是一个酉变换,以qumode状态的形式编码振幅。

公式4 qubit-qumode数据编码

第二种方法为广义相位编码(generalized phase encoding),适用于将分子信息(用于描述特定分子的token序列)编码为qubit-qumode状态。该方法使用一个字典,将输入token映射到电路中使用的参数值。然而潜在问题是若未经过正交化处理,不同输入token所映射的编码态可能存在重叠,导致量子表示不唯一,从而影响模型性能。

技术挑战

在当前量子硬件上部署面临的挑战

尽管QNN在理论上具备超越经典神经网络的表达能力,其在实际部署过程中仍面临多方面的技术挑战,主要包括以下三点:

1) 量子比特之间的高连通性需求。QNN的表达能力通常依赖于量子比特之间的高效互连。然而,现有量子硬件在实现高连通性同时维持可扩展性与量子比特保真度方面存在较大困难。这与对可扩展、高质量量子比特系统的基本要求形成矛盾,限制了QNN架构的落地能力。

2) 经典数据的高效量子态编码问题。QNN常采用amplitude encoding将经典数据映射至量子态,但该过程实质上等价于制备任意量子态,所需资源与操作复杂度远高于通常的量子计算任务。因此,部分QML应用可能需要在硬件能力标准上做出调整,或开发更先进的量子态制备方法以满足应用需求。

3) 测量精度与量子态层析需求。当QNN的输出依赖于对量子态振幅的精确测量时,硬件需具备高分辨率的测量能力,甚至支持大规模的量子态层析(quantum state tomography)。然而,目前量子硬件的测量能力仍有限,难以满足此类需求,成为进一步发展的技术瓶颈。

QNN算法面临的挑战及应对策略

在QNN的构建过程中,将经典数据加载至量子态通常是首要步骤,该步骤的效率将直接影响模型性能、量子优势的可获得性,以及整体的量子资源开销。当前面临的主要挑战及应对策略如下:

1) 经典数据加载与状态制备复杂度高。为降低状态制备难度,研究者提出诸如数据重加载(Data Reuploading)和傅里叶特征量子线性模型等策略,用以提升表达能力和学习性能。

2) 梯度消失(Barren Plateaus)问题。应对策略包括设计浅层电路结构与合理的权重初始化方案,以维持梯度的有效传播。

3) 量子权重更新困难。目前主流方法为参数偏移法(Parameter-Shift Method),时间复杂度其时间复杂度通常与参数数量的平方成正比。研究者正积极探索包括量子反向传播、无梯度优化等在内的高效量子梯度计算与优化方法。

展望

本文综述了基于门控量子计算机的量子神经网络在药物研发中的应用潜力与面临的挑战。尽管量子计算有望在这些领域实现重大突破,但其硬件和算法仍存在诸多限制,包括量子比特的相干性、连接性要求、复杂的状态制备过程以及梯度消失和量子梯度计算等关键技术瓶颈。

近期在量子纠错方面取得的重要进展,标志着更可靠量子系统的到来,为量子机器学习的实际应用奠定了基础。然而,量子硬件的可扩展性与纠错机制仍需进一步优化。

展望未来,随着技术的成熟,量子计算与机器学习的结合有望在新药发现、材料设计、反应路径优化等方面带来突破,成为解决复杂科学与工业问题的重要工具。

参考链接:

https://doi.org/10.1021/acs.chemrev.4c00678

--------- End ---------

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢