导语

分享简介

分享简介

本次分享将介绍两项受到神经科学启发的可解释性研究:首先探讨Transformer中的归纳注意力头(induction heads)如何与人类情景记忆的CMR(上下文维护与检索)模型在机制上高度相似,揭示了大模型上下文学习的回路基础;随后介绍一种神经反馈范式,系统量化大语言模型的元认知能力——即模型监控和控制自身内部神经激活的能力。这些发现不仅为理解AI系统的工作原理提供了新的神经科学视角,也为AI安全和可解释性研究带来重要启示。

分享大纲

分享大纲

1. 背景与动机

人工智能与神经科学的交叉研究价值:Neuro4AI和AI4Neuro

Transformer架构的上下文学习现象

2. 第一项研究:上下文学习与人类情景记忆的联系

归纳头的发现与机制

“匹配-复制”行为模式

K-composition和Q-composition机制

人类情景记忆的CMR模型

时间上下文的动态演化

非对称邻近偏差的计算机制

机制相似性

归纳头注意力模式类似CMR

训练过程中类人记忆偏好的涌现

因果验证:消融实验结果

3. 第二项研究:大语言模型的元认知能力

元认知的现象与意义

神经反馈范式

上下文学习框架下的元认知量化

元认知能力的三个层面

神经激活的监控

显式控制

隐式控制

影响因素分析

语义可解释性的作用

方差解释度的影响

模型规模与层深的关系

4. 研究意义与展望

对AI可解释性和安全的贡献

认知神经科学的新研究工具

核心概念

核心概念

归纳头(Induction Heads): Transformer中负责模式匹配和复制的关键注意力机制,是上下文学习的核心组件。

CMR模型(Contextual Maintenance and Retrieval): 人类情景记忆的计算模型,通过时间上下文的动态维护解释记忆检索过程。

神经反馈(Neurofeedback): 将内部神经激活作为反馈信号的实验范式,用于研究神经系统的自我监控能力。

元认知(Metacognition): 对自身认知过程的认知,包括监控、评估和控制等高阶心理功能。

残差流(Residual Stream): Transformer架构中信息传递的主要通道,为理解模型内部机制提供关键视角。

参考文献

参考文献

主要论文:

Li Ji-An, et al. "Linking In-context Learning in Transformers to Human Episodic Memory." NeurIPS 2024.

Li Ji-An, et al. "Language Models Are Capable of Metacognitive Monitoring and Control of Their Internal Activations." arXiv preprint (2025).

Li Ji-An, Marcus K. Benna, and Marcelo G. Mattar. "Discovering Cognitive Strategies with Tiny Recurrent Neural Networks." Nature (2025).

智能之镜:NeuroAI 如何反映大脑与人工智能的未来

相关背景文献:

Elhage, Nelson, et al. "A mathematical framework for transformer circuits." Transformer Circuits Thread (2021).

Howard, M. W., & Kahana, M. J. "A distributed representation of temporal context." Journal of Mathematical Psychology (2002).

Olsson, Catherine, et al. "In-context learning and induction heads." arXiv preprint (2022).

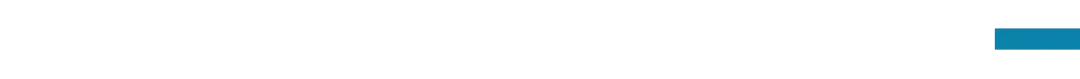

主讲人简介

主讲人简介

李济安,加州大学圣地亚哥分校神经科学博士研究生。主要研究方向包括计算神经科学、大语言模型的机制可解释性、以及人工智能与认知科学的交叉研究。在Nature、NeurIPS等顶级期刊和会议发表多篇论文,致力于通过神经科学视角理解人工智能系统的内在机制。

参与方式

参与方式

参与时间

北京时间2025年8月16日(周六)早上10:00-12:00

报名加入社群交流

(可开发票)

https://pattern.swarma.org/study_group_issue/966?from=wechat

扫码参与「大模型可解释性」读书会,加入社群,获取系列读书会永久回看权限,与社区的一线科研工作者沟通交流,共同探索大模型可解释性这一前沿领域的发展。

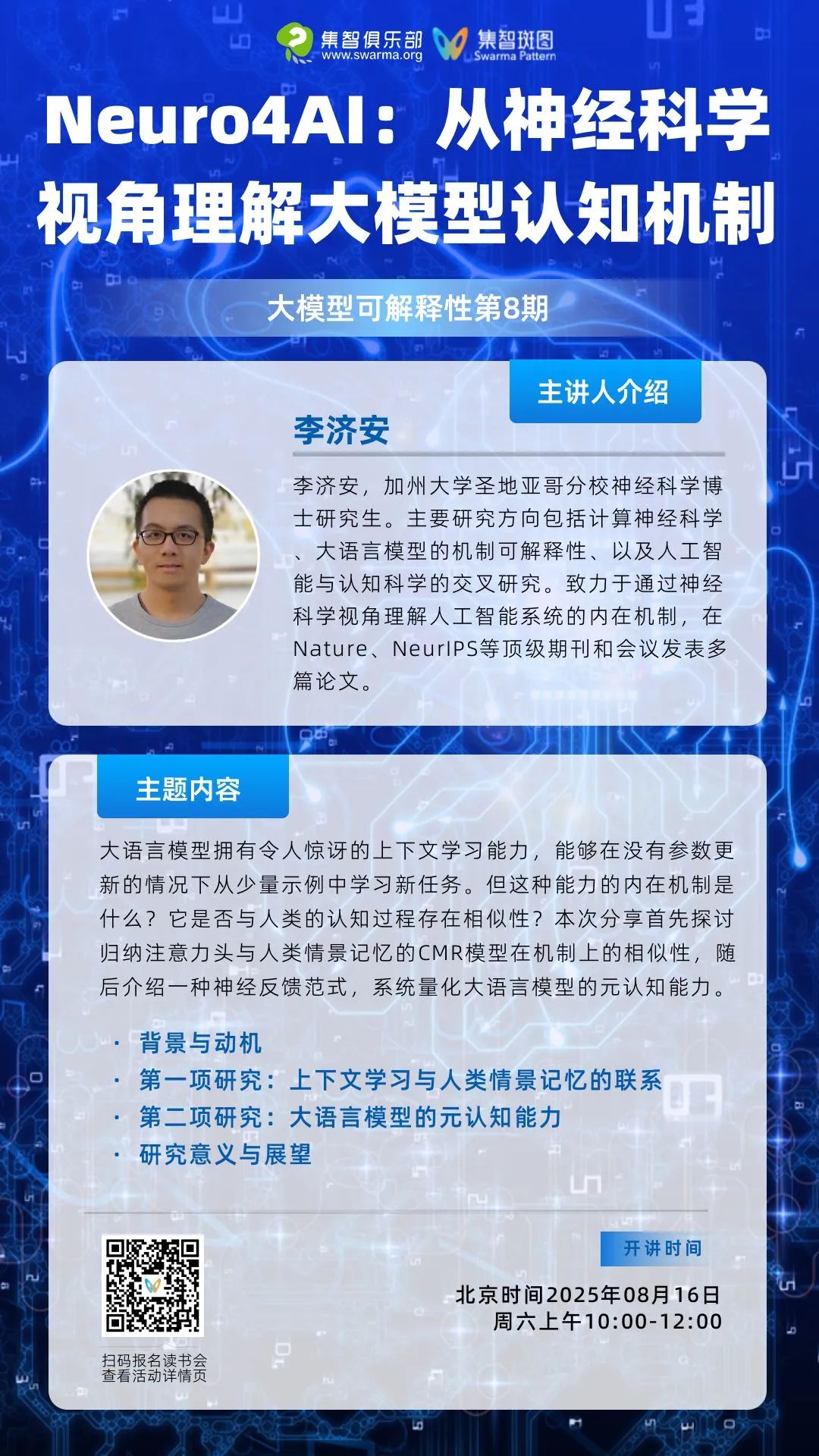

大模型可解释性读书会

集智俱乐部联合上海交通大学副教授张拳石、阿里云大模型可解释性团队负责人沈旭、彩云科技首席科学家肖达、北京师范大学硕士生杨明哲和浙江大学博士生姚云志共同发起「大模型可解释性」读书会。本读书会旨在突破大模型“黑箱”困境,尝试从以下四个视角梳理大语言模型可解释性的科学方法论:

自下而上:Transformer circuit 为什么有效?

自上而下:神经网络的精细决策逻辑和性能根因是否可以被严谨、清晰地解释清楚?

点击“阅读原文”,报名读书会

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢