导语

简介

简介

随着人工智能技术在医疗诊断、金融决策等关键领域与人类深度协作,其潜在的风险也愈发受到关注。长期以来,学界普遍认为AI偏见源于其训练数据中固有的偏见,即“偏见进,偏见出”。然而,伦敦大学学院Glickman与Sharot团队在《自然-人类行为》上发表的这篇论文,首次通过大规模实验揭示了一个更复杂且影响深远的机制。研究发现,当人类与有偏见的AI系统反复互动时,AI会以一种独特的、高信噪比的方式放大其内在的偏见,而人类会学习并内化这些被放大的偏见,从而变得比最初更加偏见。这一“人-AI反馈循环”效应显著强于人与人之间的互动。该研究不仅验证了这种偏见放大机制在知觉、情感和社会判断等多个领域的普适性,更提醒我们AI系统在放大偏见方面所扮演的关键角色,这为AI的伦理设计和风险管理提供了至关重要的实证依据。

大纲

大纲

背景与研究引入

核心实验与关键发现

影响机制与社会启示

展望与Q&A

参考文献

参考文献

Glickman, M., & Sharot, T. (2025). How human–AI feedback loops alter human perceptual, emotional and social judgements. Nature Human Behaviour, 9(2), 345-359.

Anthony Giddens. 1984.The constitution of society: Outline of the theory of structuration.Polity (1984). https://ocw.mit.edu/courses/res-10-002-ethics-of-ai-bias-spring-2023/pages/chapterized-video/

Uwe Messer. 2025.How Do People React to Political Bias in Generative Artificial Intelligence (AI)?Computers in Human Behavior: Artificial Humans 3 (March 2025), 100108. https://doi.org/10.1016/j.chbah.2024.100108

Leonardo Ranaldi, Elena Ruzzetti, Davide Venditti, Dario Onorati, and Fabio Zanzotto. 2024.A Trip Towards Fairness: Bias and De-Biasing in Large Language Models. In *Proceedings of the 13th Joint Conference on Lexical and Computational Semantics (SEM 2024), Danushka Bollegala and Vered Shwartz (Eds.). Association for Computational Linguistics, Mexico City, Mexico, 372–384.https://doi.org/10.18653/v1/2024.starsem-1.30

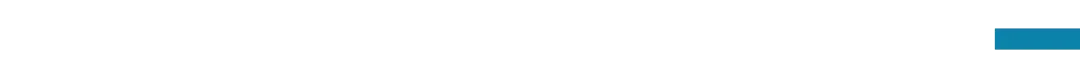

主讲人

主讲人

冉天枢,毕业于清华大学社科学院社会学系,哥伦比亚大学教师学院国际比较教育专业出身,现从事面向企业的AI素养课程开发。从硕士期间开始接触复杂科学,相见恨晚。希望结合所长,为复杂科学的普及做些事。

直播信息

直播信息

时间:

2025年8月23日晚上19:00-21:00

报名加入社群交流:

扫码参与「大模型时代下的人机交互与协同」读书会,加入群聊,获取系列读书会回看权限,成为人机交互与协同社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动人机交互与协同社区的发展。

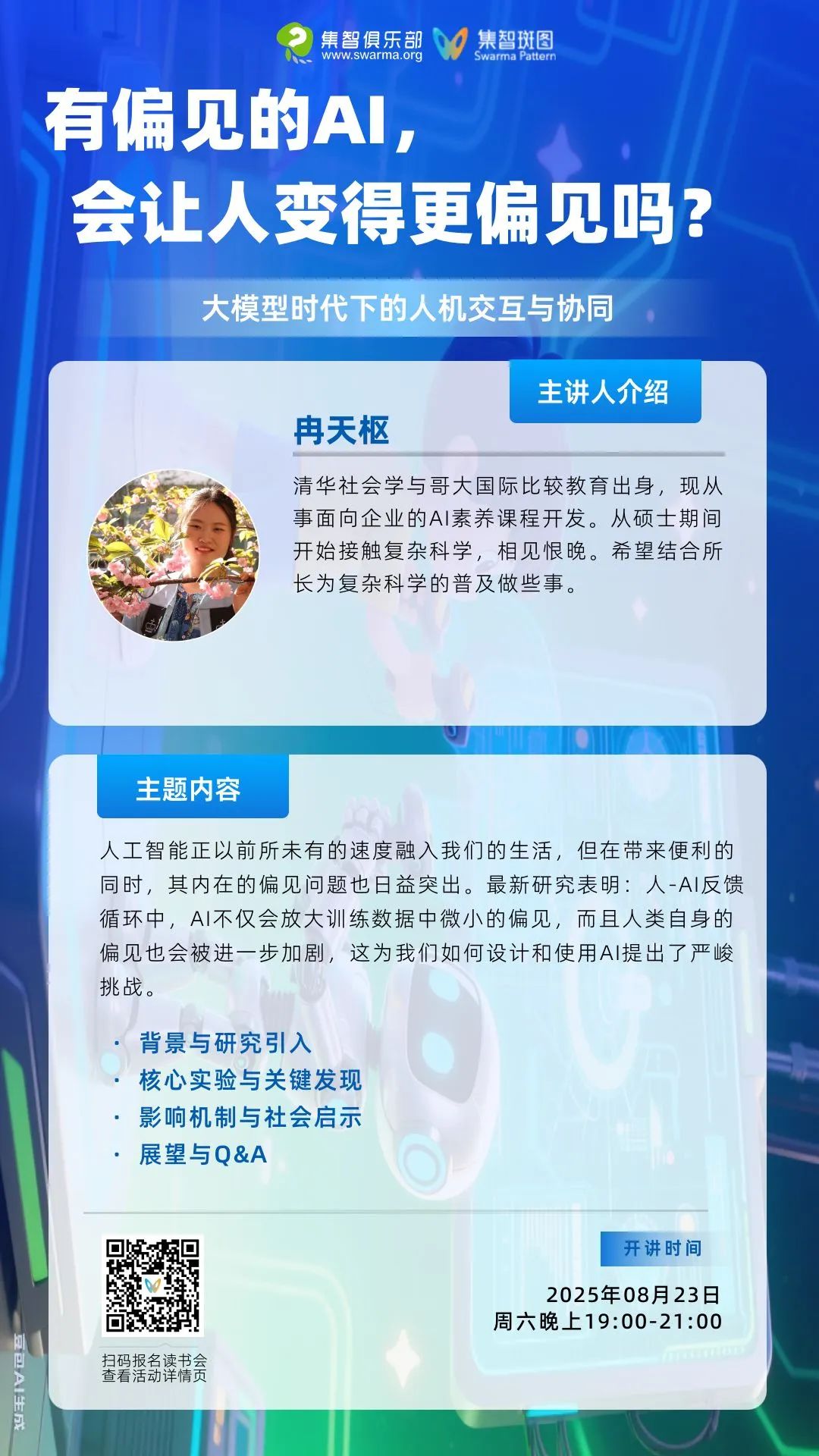

「大模型时代下的人机交互与协同」

读书会

集智俱乐部联合中国科学技术大学教授赵云波、华东师范大学副教授吴兴蛟两位老师共同发起「大模型时代下的人机交互与协同」读书会。本次读书会将探讨:

人类智能和机器智能各自的优势有哪些?智能边界如何?如何通过更有效的标注策略和数据生成技术来解决数据稀缺问题?如何设计更加高效的人机协作系统,实现高效共赢的效果?如何提高机器决策的可解释性与透明性,确保系统的可信度?如何通过多模态协作融合不同感知通道,应对复杂的决策任务?

读书会7月4日开始第一次分享,每周六进行,预计持续约8周,具体时间社群通知,诚挚邀请领域内研究者、寻求跨领域融合的研究者加入,共同探讨。

详情请见:人类与机器的智慧碰撞:人机协同的智能时代读书会启动

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢