随着大型语言模型的快速发展,全注意力机制在准确率上表现出色,但 O(n²) 的计算复杂度导致长上下文任务耗费大量内存与算力,限制高效应用。现有架构多依赖从头训练,成本高且不利于中小型研究机构。混合架构虽兼顾精度与效率,但仍面临设计复杂和硬件适配困难的问题。

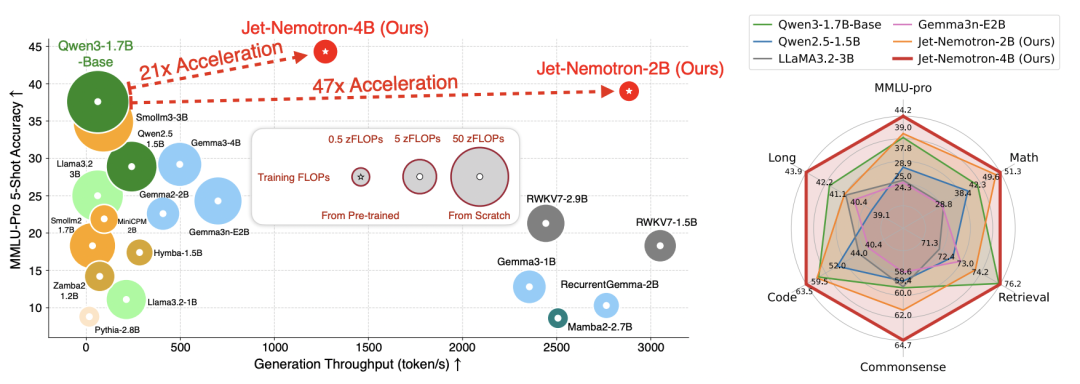

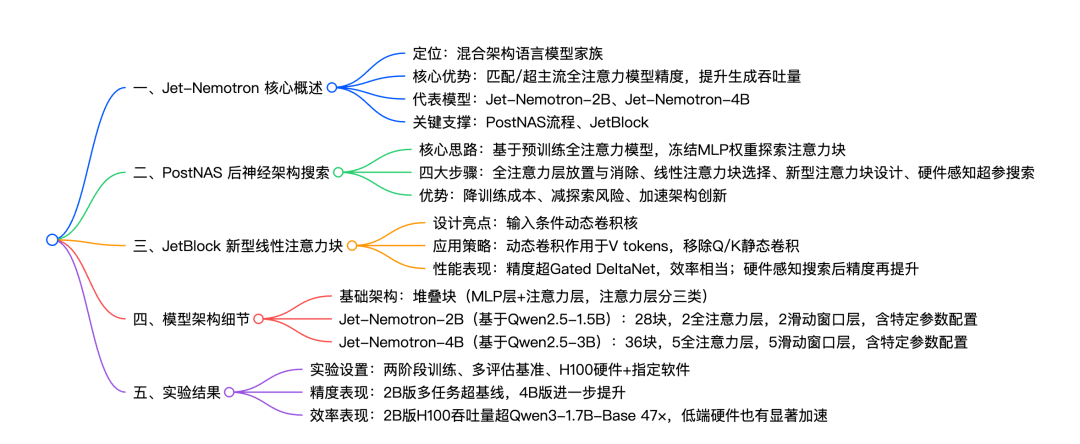

针对这些挑战,研究团队提出 Jet-Nemotron,通过 后神经架构搜索(PostNAS) 在预训练全注意力模型上冻结 MLP 权重,探索最优注意力模块设计,实现 显著提升生成吞吐量的同时保持或超过全注意力模型准确率,为高效语言模型设计提供了一条可行路径。

论文链接:https://go.hyper.ai/8MhfF

最新 AI 论文:https://go.hyper.ai/hzChC

为了让更多用户了解学术界在人工智能领域的最新动态,HyperAI超神经官网(hyper.ai)现已上线「最新论文」板块,每天都会更新 AI 前沿研究论文。以下是我们为大家推荐的 5 篇热门 AI 论文,同时我们还为大家总结了论文架构的思维导图,一起来速览本周 AI 前沿成果吧 ⬇️

本周论文推荐

1

Jet-Nemotron: Efficient Language

Model with Post Neural

Architecture Search

本文提出了 Jet-Nemotron,一个新型混合架构语言模型系列,在保持或超越领先全注意力模型精度的同时,显著提升了生成吞吐量。Jet-Nemotron 采用一种名为「后神经架构搜索」的新型神经架构探索流程进行开发,该流程实现了高效的模型设计。与传统方法不同,PostNAS 从一个预训练的全注意力模型出发,并冻结其多层感知机权重,从而实现对注意力模块结构的高效探索。

论文链接:https://go.hyper.ai/8MhfF

模型架构图

论文思维导图

2

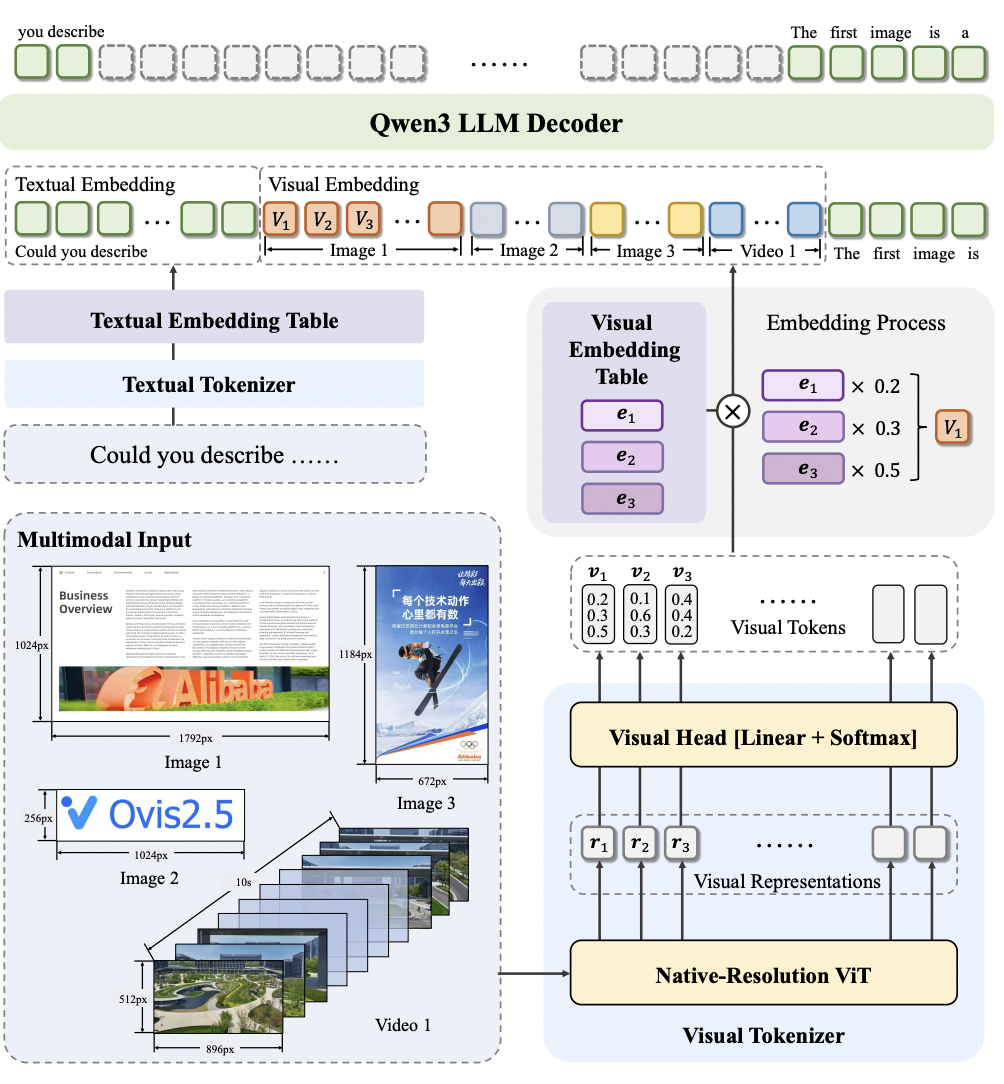

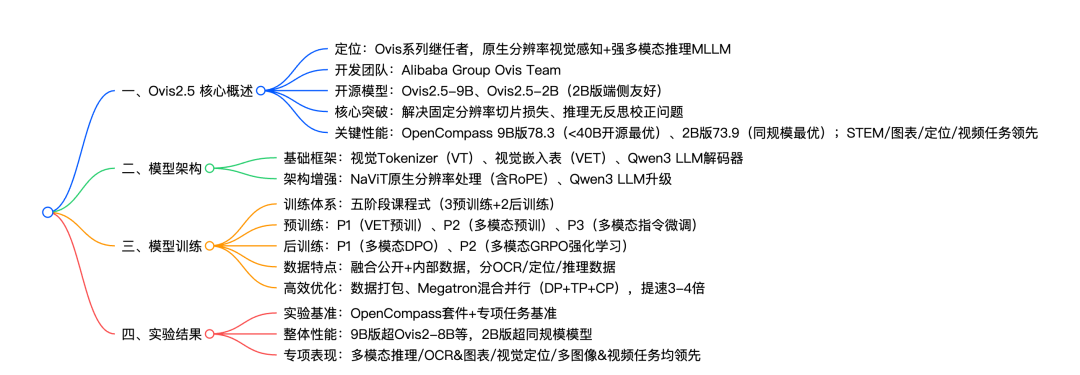

Ovis2.5 Technical Report

本文提出 Ovis2.5,专为原生分辨率视觉感知与强大的多模态推理而设计。Ovis2.5 集成了一种原生分辨率视觉 Transformer,能够以图像的原始、可变分辨率直接处理图像,避免了固定分辨率分块带来的质量退化,同时完整保留了精细细节与全局布局。

论文链接:https://go.hyper.ai/nZOmk

模型架构图

论文思维导图

3

FutureX: An Advanced Live

Benchmark for LLM Agents in

Future Prediction

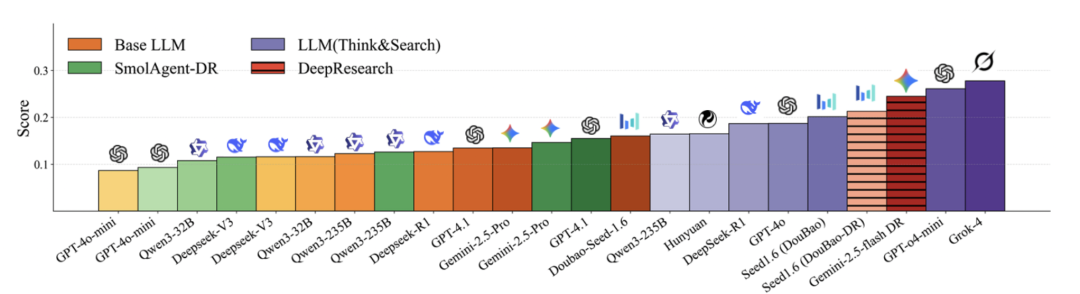

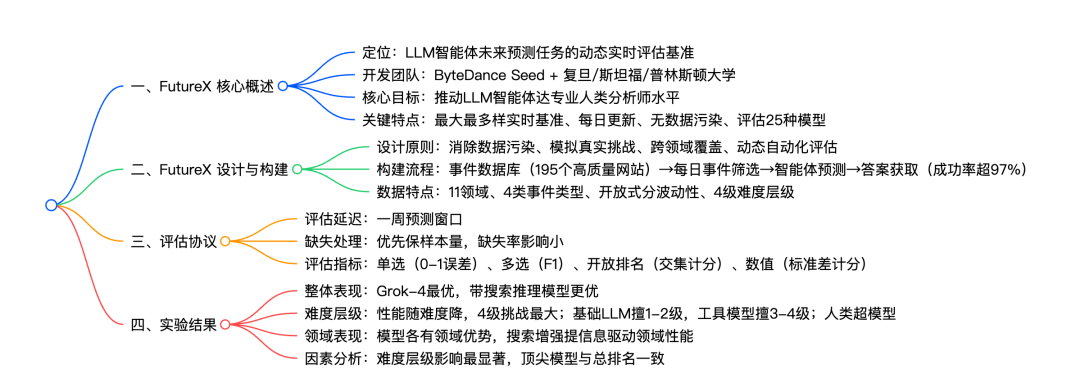

未来预测要求智能体具备复杂推理与动态适应能力,对于大语言模型智能体来说是一项复杂任务,目前缺乏能实时更新并准确评估其预测水平的大规模基准。本文提出了 FutureX ,一个专为 LLM 智能体未来预测任务设计的动态实时评测基准。FutureX 是迄今为止最大、最具多样性的实时预测评测框架,支持每日实时更新,并通过自动化流程实现问题收集与答案采集,从而有效消除数据污染。

论文链接:https://go.hyper.ai/rjbaU

FutureX 实验得分

论文思维导图

4

MeshCoder: LLM-Powered

Structured Mesh Code Generation

from Point Clouds

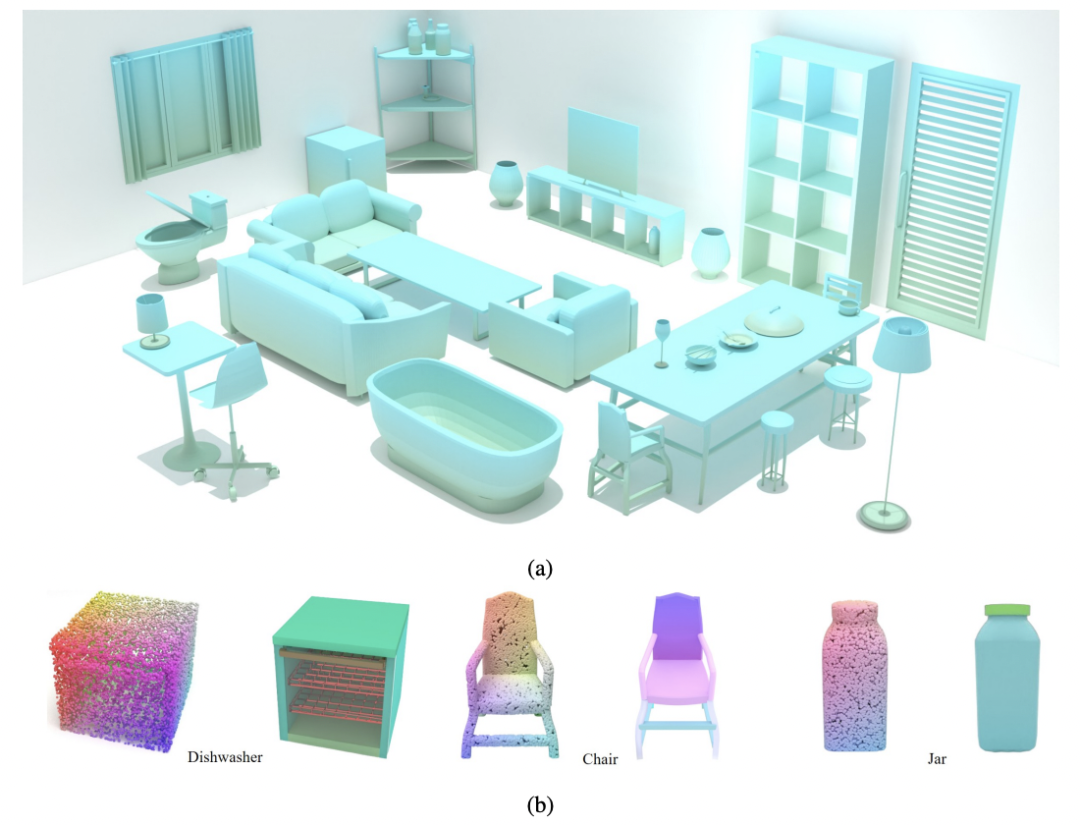

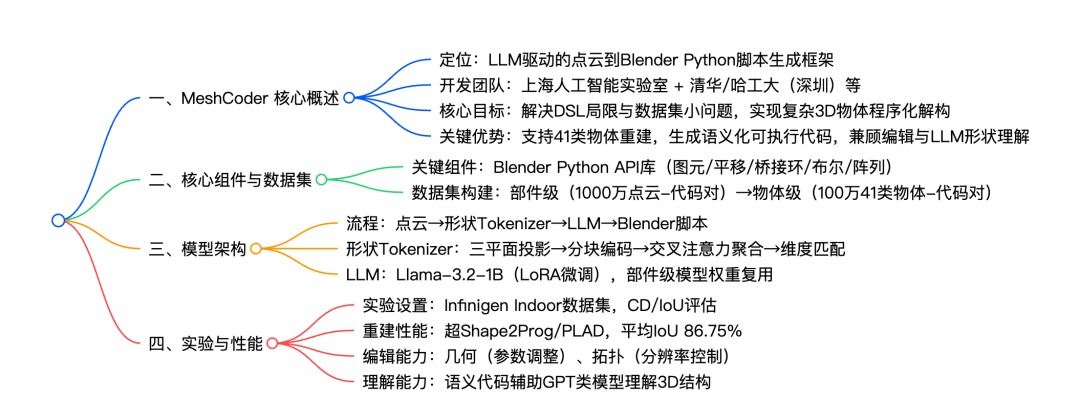

将三维物体重建为可编辑的程序,对于逆向工程和形状编辑等应用至关重要,现有方法仍有很多局限。本文提出了 MeshCoder,一个能够将点云中的复杂三维物体重建为可编辑 Blender Python 脚本的新框架。它通过开发丰富的 API、构建大规模物体-代码数据集,并训练多模态大语言模型,实现了形状到代码的高精度转换。不仅提升了三维重建性能,还支持直观的几何与拓扑编辑,增强了 LLM 在三维形状理解中的推理能力。

论文链接:https://go.hyper.ai/EAWIn

模型框架图

论文思维导图

5

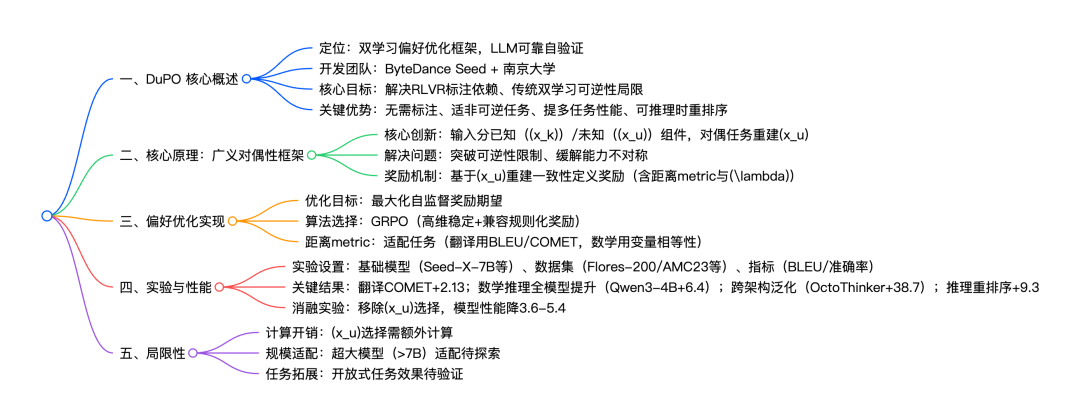

DuPO: Enabling Reliable LLM

Self-Verification via Dual

Preference Optimization

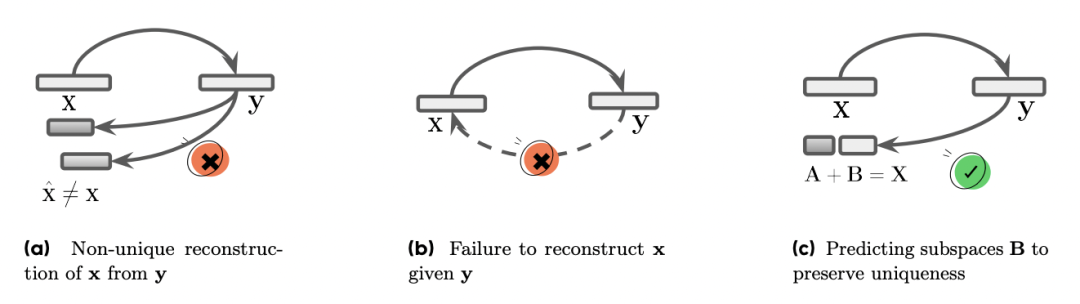

本文提出 DuPO,一种基于双学习的偏好优化框架,通过广义对偶生成无需标注的反馈。DuPO 解决了两个关键限制:一是 RLVR(带可验证奖励的强化学习) 依赖昂贵标注且仅适用于可验证任务;二是传统双学习仅限于严格的对偶任务对(例如翻译与反向翻译)。

论文链接:https://go.hyper.ai/2Gycl

模型架构图

论文思维导图

以上就是本周论文推荐的全部内容,更多 AI 前沿研究论文,详见 hyper.ai 官网「最新论文」板块。

同时也欢迎研究团队向我们投稿高质量成果及论文,有意向者可添加神经星星微信(微信号:Hyperai01)。

下周再见!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢