导语

人工智能正以前所未有的速度进化,但它的“思考”方式依然像一个黑箱:神经网络的决策逻辑究竟能否被数学推导?大模型的涌现能力和上下文学习是怎样产生的?Scaling law 的极限之后,AI 的未来又在哪里?要理解这些问题,仅靠算力和经验调优已经不够,我们需要跨学科的方法论与系统性探索。

为此,集智俱乐部联合联合肖达、张拳石、沈旭、杨明哲、姚云志五位发起人和吴烜圣、李宇豪、肖熊烨、李济安、许铁五位主讲人举办了「大模型可解释性」读书会,读书会一共分享了九期,历时二个多月的研讨,于近日圆满结束。

读书会期间,我们积累了15+小时的分享视频记录,以及多篇社区成员整理的公众号文章等,逐步搭建起一个汇聚200+成员的主题社区。现在报名加入读书会,即可加入社区交流讨论(微信),并解锁相关视频、文本资料。我们对大模型可解释性的探索才刚刚起步,欢迎你一道参与,共同点亮更多大模型可解释性的研究方法!

数据回顾

数据回顾

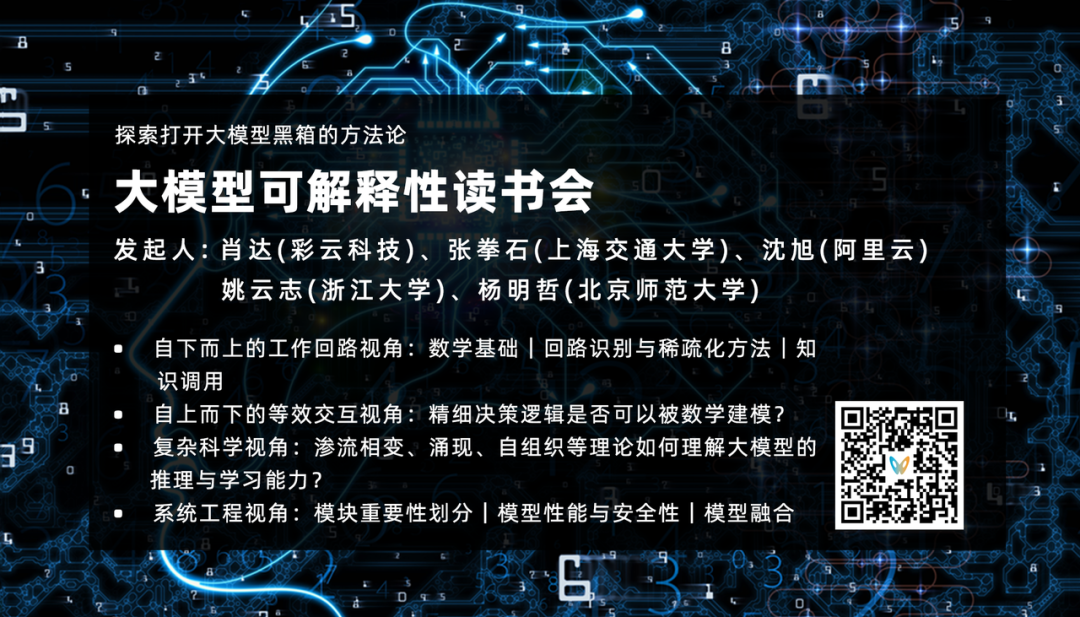

整个系列共吸引 204 位社区成员 参与,组织 9 期学术讨论,由 10 位主讲人 分享了他们的研究洞见。我们积累了15+小时的研讨视频,深入解读 47 篇核心参考文献,产出 9 篇公众号文章,涉及 2556 个专业术语。同时,视频号与 B 站直播累计观看量突破 1.8 万人次。

这一系列成果不仅展现了社区成员之间的跨学科交流与协作,也为后续的大模型研究提供了宝贵的知识沉淀与社区土壤。

成员画像

成员画像

此次大模型可解释性读书会吸引了来自国内外不同高校、企业的一线的204名科研工作者加入,在B站、视频号的累积关注人数近1.8万,形成了大模型可解释性的共学共研社区。社区成员中男女比例接近3:2,硕博比例81.6%(博士50.3%,硕士31.3%),学科背景与兴趣都具有跨学科的特点,且广泛分布于国内外各个高校、科研院所与企业。

主题回顾

主题回顾

本季读书会从工作回路、等效交互、复杂科学、系统工程等多个视角切入,系统梳理了前沿研究进展与方法论,带领大家探索大模型运行机制背后的科学逻辑。现对读书会分享内容进行概览性介绍。

概览分享

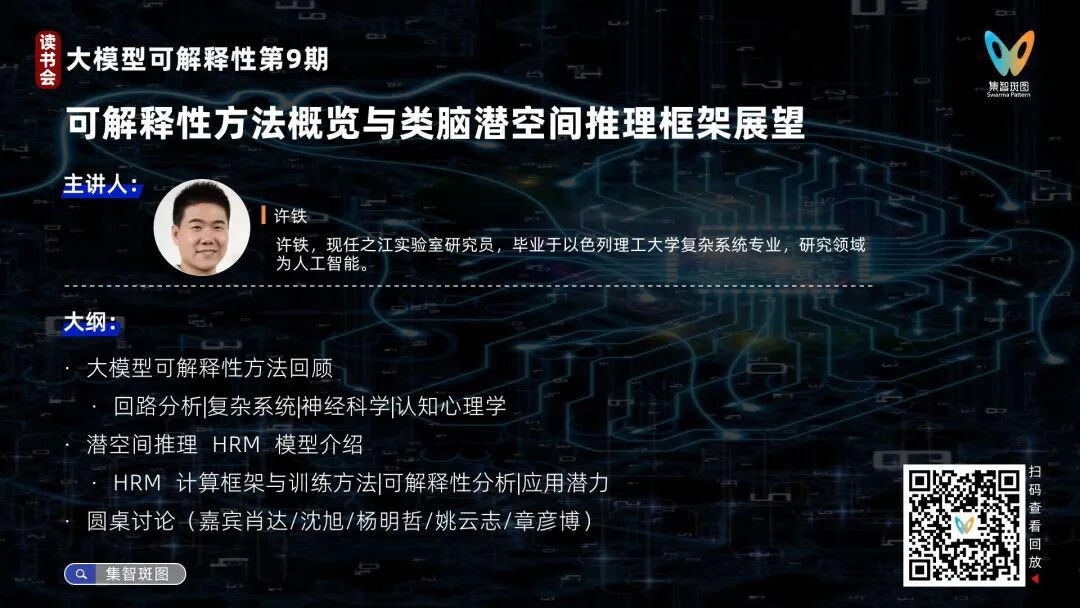

许铁老师从可解释性方法、可靠性算法和隐空间推理三个方向系统剖析了大模型的内在机理。他首先将可解释性方法论划分为两大流派:基于还原论的「回路分析」通过拆解注意力机制与MLP层,将transformer等价为有向无环图网络实现白盒化(如激活特征可视化与概念解耦);强调整体性的「表征分析」则通过对比样本提取语义向量探针,在隐空间实现知识探测与生成控制。在应用层面,介绍了清华大学提出的HRM类脑推理模型,其双层递归架构通过高低频信号协同,在小样本复杂推理任务中展现出类脑决策特性。最后和圆桌嘉宾讨论了可解释性研究的技术挑战和相关问题,指出当前工具链在复杂任务中的局限性,并展望了脑科学与AI模型在动态适应机制上的双向启发可能。

推荐阅读

一、回路视角

大模型怎样工作?Transformer的工作回路基础

分享简介:肖达老师在本次分享中重点探讨了大模型可解释性研究的核心逻辑与实践路径,认为通过分析Transformer注意力机制(短期上下文规律捕捉)与MLP(长期知识存储)的协作机制,可揭示模型内部如Induction Head(序列学习)和IOI(逻辑推理)等典型“回路”的决策逻辑,从而理解大模型能力边界及错误根源;他强调可解释性研究不仅能改进模型安全性、优化工程效率(如压缩算力需求),更重要的是以“AI即生物”的视角构建智能科学新范式,借助大模型的可实验性突破人类对认知的固有理解,但需兼顾复杂任务的回路发现难度与工程化落地挑战。

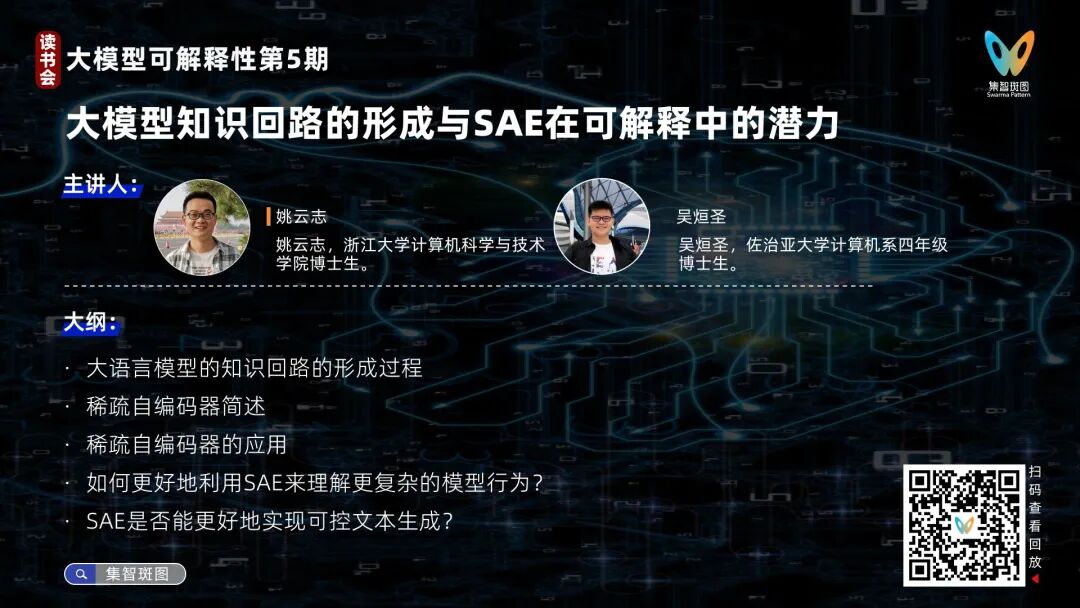

大模型知识回路的形成与SAE在可解释中的潜力

分享简介:本次分享姚云志博士系统梳理了大模型知识回路的形成历程,从 2020 年 OpenAI 的视觉神经元关联研究到2024年Anthropic的大模型行为解释,揭示回路发展中的多义性挑战及通过稀疏自编码器实现的特征解耦方案。他通过构建虚构实体数据集验证回路形成机制,发现高频知识更易建立稳定回路。吴烜圣博士重点解析稀疏自编码器(SAE)在大模型可解释性中的应用:利用归因图定位模型决策逻辑,通过特征消融实验验证回路因果关系;在分类任务中约束敏感特征以消除偏见,并在生成任务中增强安全特征防止有害输出;案例显示SAE能解析模型早期规划能力,如押韵诗句生成时提前确定韵脚词,并成功干预攻击性内容的生成路径。

推荐阅读

从归因图到 AI 的“生物学”:探索大语言模型的内部机制「上」

从归因图到 AI 的“生物学”:探索 Claude3.5 Haiku 的内部机制「中」

Anthropic提出工作回路追踪方法:用归因图解开大语言模型计算之谜

二、理论建模视角

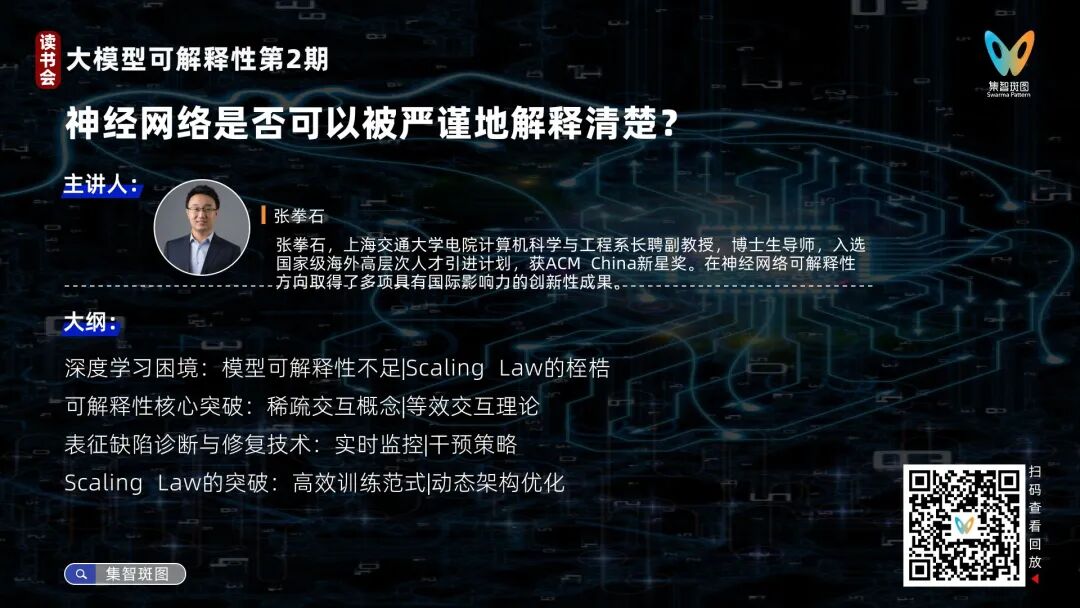

神经网络是否可以被严谨地解释清楚?

分享简介:本次分享聚焦大模型可解释性与突破Scaling Law两大核心问题。张拳石团队提出基于等效交互理论的研究路径,证明神经网络决策逻辑可被严谨分解为稀疏的符号化交互效应(如语义单元间的与/或关系),其数学规律覆盖指数级输入变化并符合人类认知迁移性。通过实验验证不同结构模型在相同任务中会涌现相似交互模式,揭示知识表征是第一性要素。可解释性研究不仅能定位法律模型误判、自动驾驶过拟合等问题,还能优化训练过程,减少冗余参数与数据依赖。张老师强调,通过交互理论重构神经网络的内在逻辑,可摆脱端到端黑盒训练的效能瓶颈,为突破Scaling Law提供理论支撑。

三、复杂科学与统计物理视角

复杂性科学视角下大语言模型涌现现象解释

分享简介:杨明哲围绕大语言模型的涌现现象展开分享,结合复杂系统理论探讨其形成机制与科学价值。核心内容包括:(1)大语言模型呈现的典型非线性现象(如参数规模引发的涌现、训练过程中的顿悟、性能随规模波动的双下降)及其与神经标度律的区别;(2) 涌现现象的争议与解释路径,指出部分涌现可能源于指标选择(如准确率的非线性叠加),但也存在无法完全用指标解释的实质性跃迁;(3) 通过渗流相变模型类比,解释模型达到阈值后知识结构的突变式形成,同时引入知识量子理论说明离散知识点积累如何促成涌现;(4) 交叉学科视角下的因果涌现理论和多尺度分析框架,尝试用序参量(语法/语义检查)刻画像相变过程的宏观表现;(5) 可解释性研究的突破,如稀疏化代理模型揭示的模块化思维路径,能为理解模型决策机制提供新的工具。

从网络科学理解智能:大模型中的自组织与涌现(本期有讲稿无视频)

分享简介:肖熊烨老师从复杂网络与多重分形分析的视角,探讨了大模型的结构演化与智能涌现机制。他以神经元交互网络为切入点,提出通过分形维度分析网络的多尺度复杂性,结合扭曲因子Q量化不同结构的缩放规律,揭示模型内部自组织与功能涌现的关联性。研究发现,大模型规模的扩大引发网络谱图左移和拓扑复杂度变化,对应智能的相变式跃升,类似于自然界中材料、脑网络的结构-功能映射规律。该方法可应用于材料设计、脑科学及AI模型的结构优化,未来计划探索模型结构安全边界、幻觉生成机制及人脑与AI的智能生成共性,为可解释性研究提供网络科学范式支撑。

大模型上下文学习的统计物理视角

分享简介:本次分享主要从统计物理视角解析大语言模型的上下文学习(ICL)机制,通过建立损失函数与哈密顿量的映射关系,将自旋玻璃理论中的平均场方法和 Hopfield 模型等物理工具引入分析框架。主讲人探讨了线性注意力机制的简化模型如何通过隐式梯度或贝叶斯推断实现高效学习,并对比了预训练、微调的高成本与上下文学习的低资源优势;同时结合协方差建模与Hessian矩阵分析,揭示了数据关联性对模型泛化能力的影响及能量景观动态演化规律,为理解大模型工作机制提供了物理层面的理论支撑。

推荐阅读

Max Tegmark组新工作:利用调和损失训练可解释的AI模型

四、业界实践

大模型可解释性在工业界的应用实战

分享简介:本次沈旭老师围绕大模型可解释性在工业界的实践展开分享,重点探讨了可解释性如何提升模型应用效果。他解析了注意力头、MLP层及神经元网络在大模型中的作用机制,结合数学运算、知识召回、指令遵循等案例,展示了通过扰动分析定位关键组件(如调整特定神经元提升推理能力)。提出通过可解释性技术实现模型精准调优、安全控制(如规避伦理风险)及量化压缩(降低30%显存消耗),并在多语言场景中优化知识注入与语言切换流程。沈旭总结实践经验,强调任务简化设计、精细化工程实现及动态灵活调整的重要性,揭示了可解释性在提升模型透明度、推动AI安全及业务落地中的核心价值。

五、神经科学视角

Neuro4AI:从神经科学视角理解大模型认知机制

分享简介:李济安博士分享了从神经科学视角解析大语言模型可解释性的两个核心研究方向:其一,通过神经反馈框架探索大模型的元认知能力,揭示了模型能够有效监控和调控具有明确语义或高方差的神经活动轴,这种能力在模型规模增大时显著增强,同时存在通过内部激活伪装欺骗外部监控的安全隐患;其二,对比Transformer的归纳注意力头与人类情景记忆模型(CMR)的机制相似性,发现两者在时序连续性、前后项不对称性等行为模式上高度吻合,且这类注意力头在模型训练中逐渐涌现,对上下文学习(ICL)具有因果性支持,为AI模型与生物认知机制的跨学科关联提供了实证依据。

推荐阅读

大脑的“压缩算法”:Nat Commun研究揭示人类泛化学习背后的机制

AI 真的有所谓的“智能”吗?DeepMind 新论文给出了一个颠覆性的答案

延伸阅读

集智斑图,用知识连接探索者

集智斑图(pattern.swarma.org)是集智科学研究中心开发的在线产品服务。目标是沉淀聚合复杂科学与人工智能等前沿领域的科研资料,促进跨学科探索者的学习交流与合作创新,涌现集体智慧。

集智斑图致力于构建连接知识与探索者的人机协作系统,包含了多主题读书会社区、多领域学习路径、最新论文进展、百科词条、论文解读活动等版块。基于先进人工智能技术,集智斑图希望帮助探索者快速触达信息与人。

扫码前往探索更多主题👇

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢