DRUGONE

医疗人工智能(AI)系统在支持临床诊断和治疗决策中展现了巨大的潜力,从医学影像到电子健康记录再到可穿戴设备监测,AI 工具已经逐步进入医疗前线。然而,临床使用 AI 的前提是 信任,而信任的建立依赖于 透明性。透明性意味着模型开发过程、数据来源、推理逻辑和临床部署方式对患者、医生、开发者和监管者都是可理解和可验证的。

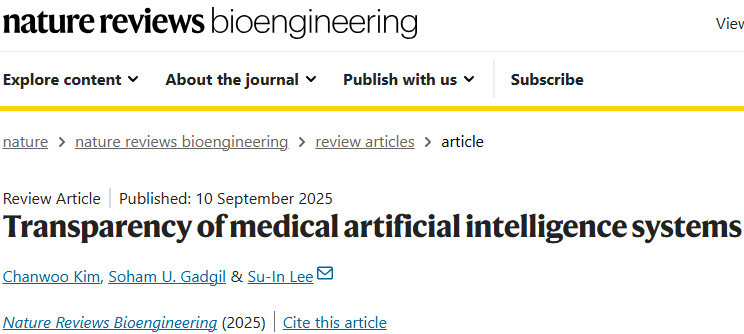

目前,大多数医疗 AI 系统仍被视为“黑箱”,难以解释其预测机制。这导致了对其安全性、公平性和可靠性的担忧,也阻碍了其在真实临床实践中的广泛应用。研究人员在本综述中梳理了医疗 AI 透明性在 数据、模型与部署 三个层面的现状与挑战,并总结了现有方法与未来方向:包括数据文档化与共享、可解释人工智能(XAI)方法、临床环境下的监测与监管要求。研究人员认为,只有在透明性得到保障的前提下,医疗 AI 才能真正实现从研发走向临床应用。

医疗 AI 已成为临床创新的重要驱动力。借助大规模临床数据和强大的计算能力,AI 模型能够识别复杂模式并进行预测,例如通过影像识别早期肿瘤、通过心电图预测心律失常、通过病理切片分类恶性病变。它们不仅能提升医生的工作效率,还能为偏远地区和资源有限的医疗系统提供智能支持。

目前,AI 已经应用在多个领域:

影像学:辅助放射科医生识别肺结节、乳腺癌和脑出血;

病理学:自动化肿瘤分类与分级;

皮肤病学:皮肤病变的智能识别;

心脏病学:预测心脏骤停与心力衰竭风险。

此外,AI 还被广泛用于药物研发、疾病基因挖掘和患者随访管理。部分医疗 AI 系统已获监管批准,甚至以智能手机应用的形式面向患者。

然而,临床实践的复杂性给 AI 带来严峻挑战:

分布转移:模型在新人群、新设备或不同医院环境下可能失效;

虚假相关性:模型可能依赖非病理性特征做出预测,例如依赖图像标签或设备差异;

临床信任障碍:医生难以理解模型预测背后的逻辑,从而不愿依赖 AI。

这些问题使透明性成为医疗 AI 的核心议题。

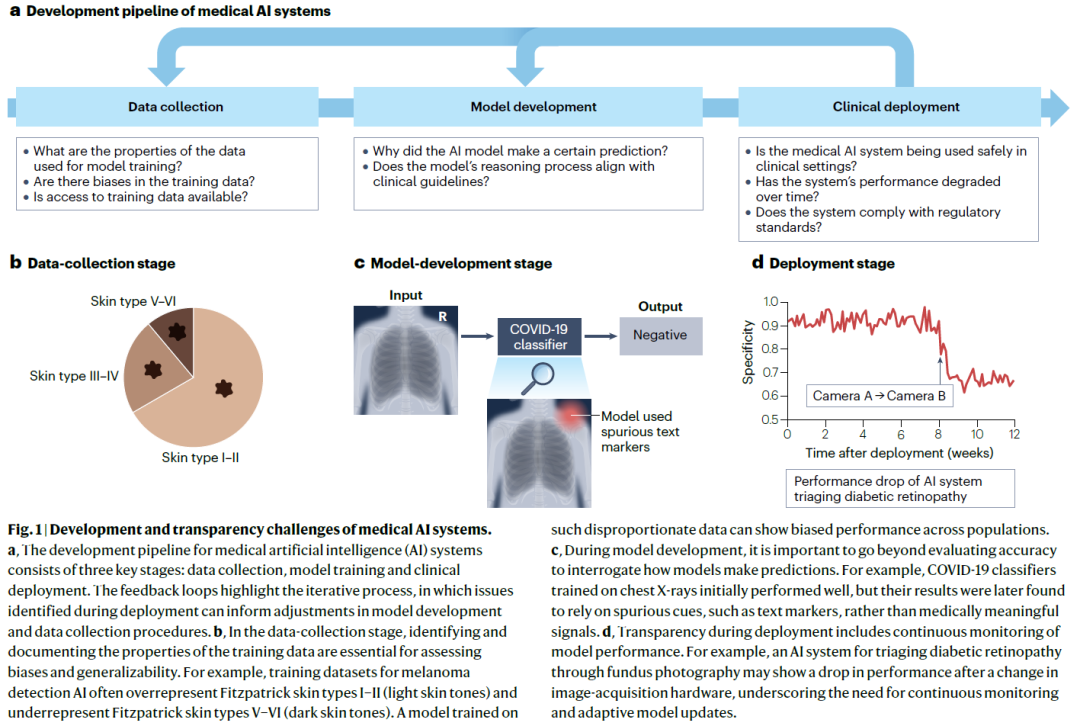

数据透明性

数据是 AI 系统的基础,其透明性直接决定了模型的公正性和可推广性。

数据文档化

详细记录数据集的来源、规模、人口学分布、标注流程和预处理方法,能够帮助研究人员和监管者识别潜在的偏倚。例如,若皮肤病数据集中肤色类型严重不均衡,模型可能在深色皮肤人群中表现不佳。数据文档化还能揭示模型的适用范围,提醒临床医生不要在不合适的场景下使用模型。

数据共享

高质量、多样化的数据对于鲁棒模型的训练至关重要。然而,医疗数据因涉及隐私和法律限制,往往难以共享。大部分公开数据集样本有限,且缺乏多样性,难以代表真实世界。新兴方法如 联邦学习 和 隐私保护计算 提供了解决方案,使得不同机构能够在不交换原始数据的情况下协同训练模型,从而在保持隐私的同时促进透明性。

合成数据

合成数据利用生成模型(如 GANs 或扩散模型)生成具备统计特性的模拟数据。它可用于缓解数据稀缺和类别不平衡问题,并在一定程度上保护隐私。例如,研究人员可以利用合成 MRI 图像扩展罕见病患者的训练样本。然而,合成数据也存在挑战:如何保证其不泄露原始数据?如何确保其统计分布真实可信?这些问题仍需解决。

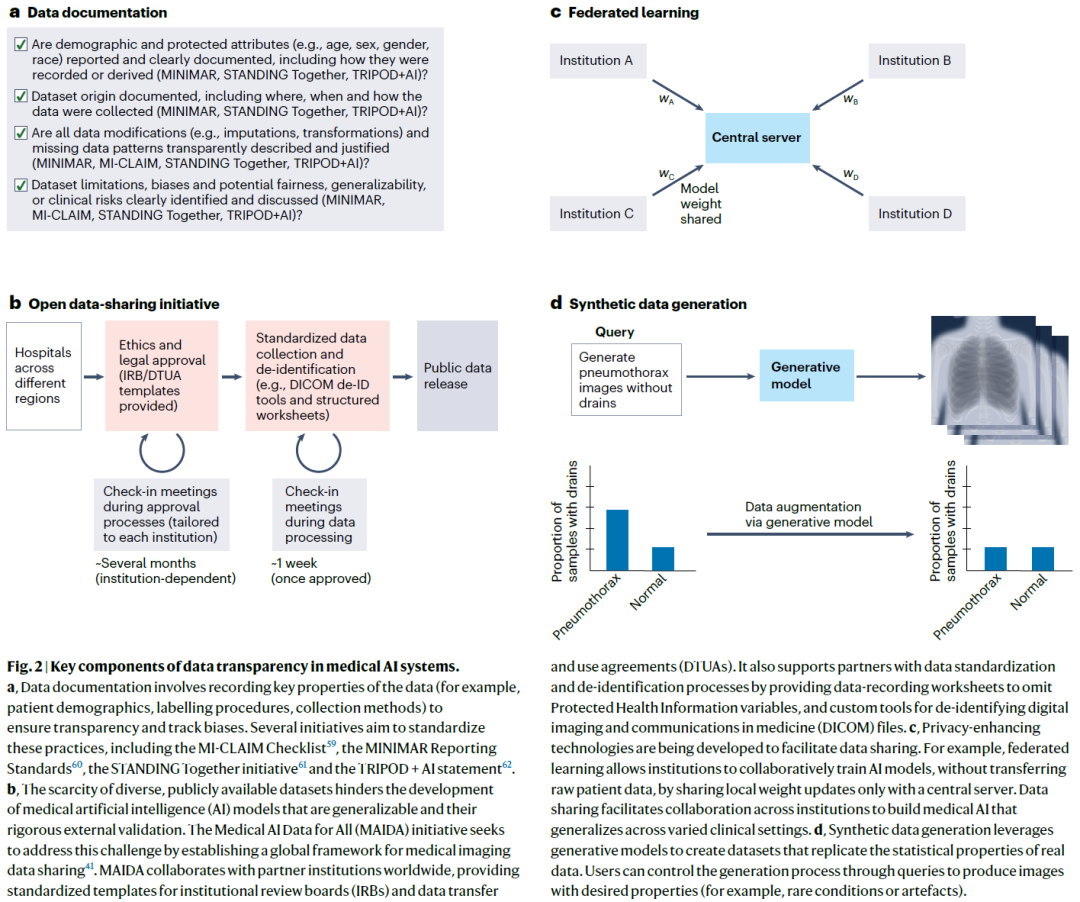

模型透明性

模型透明性涉及解释 AI 如何得出预测结果,是解决“黑箱问题”的核心。

特征归因方法

这种方法揭示输入特征对预测结果的贡献。例如,在肺结节识别中,热力图能显示模型关注的区域是否与病灶一致。常用方法包括:

梯度归因(基于梯度的可解释性);

LIME(局部可解释模型);

SHAP(Shapley 值解释)。

概念驱动解释

医生的诊断往往依赖高层次的医学概念,如“红斑”“色素沉着”。概念驱动解释通过建立模型决策与临床语义概念之间的映射,使得 AI 的推理过程更加直观易懂。

反事实解释

反事实方法回答“如果某些特征不同,模型预测会如何变化”。例如,如果病灶大小减小,AI 是否会给出良性预测?这种解释能帮助医生理解模型的决策边界。

内在可解释模型

与其在黑箱模型外增加解释层,不如从一开始设计具有透明性的模型。原型网络和概念瓶颈模型就是典型例子,它们在预测时明确展示“参考原型”或“中间概念”,增强可理解性。

大语言模型的透明性

医疗大语言模型(如 Med-PaLM、GPT 医学版本)因规模庞大带来新的透明性挑战。提升方法包括:

自我解释:在输出中同时生成预测和理由;

机制可解释性:通过解析注意力头与神经元功能,理解模型内部运算;

检索增强生成(RAG):将外部数据库作为证据,减少“幻觉”式回答。

部署透明性

即使模型在开发阶段透明,也需要在临床部署和应用中保持透明性。

临床实践中的评估

AI 模型通常作为 决策支持工具 嵌入临床工作流,其效果必须通过真实世界研究来验证。例如,部分癌症筛查 AI 已证明在灵敏度和特异性上接近甚至超过双医师阅片,但也存在性能波动的情况。

持续监测与更新

临床环境是动态的。人口结构变化、新型疾病出现、医疗设备更新,都可能导致模型性能下降。部署透明性要求建立 持续监测与更新机制,包括模型性能追踪、定期再训练以及偏倚检测。

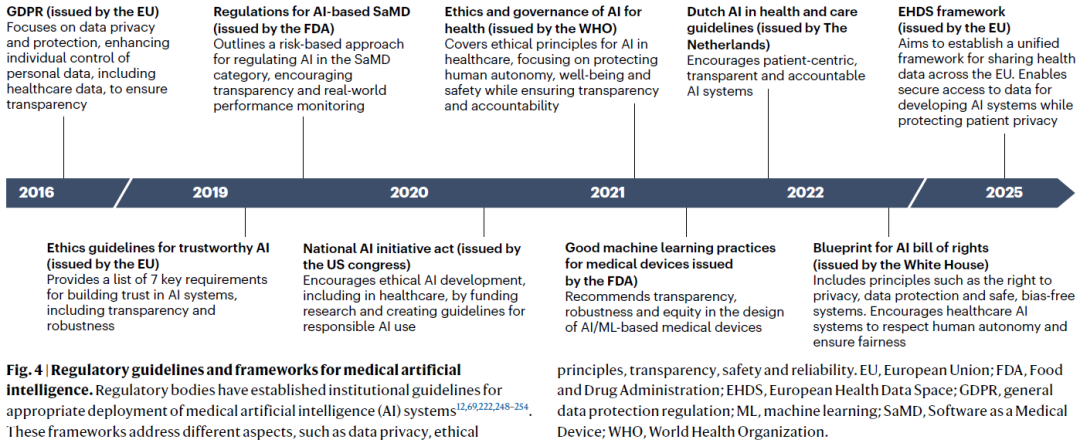

监管与合规

各国监管机构正在制定相关规范。美国 FDA 的“AI/ML 软件即医疗器械(SaMD)行动计划”强调模型的可追溯性与全生命周期监管。欧盟的人工智能法案也提出“高风险医疗 AI 系统必须具备透明性”。这些要求推动了开发者在模型说明文档、风险披露与用户培训中的改进。

展望

未来,医疗 AI 的透明性发展面临以下方向:

技术层面:需要开发计算高效、可实时解释的透明性工具,特别是针对大型基础模型。

临床整合:透明性工具应与临床决策流程深度融合,减少医生的认知负担。

教育与培训:临床人员必须了解透明性工具的优点与局限,提升与 AI 协作的信心。

全球合作:通过跨机构数据共享、隐私保护和国际标准化,促进透明性方法的普及。

研究人员认为,透明性是医疗 AI 系统走向 安全、可靠、可解释与可持续 的基石。只有在透明性保障下,AI 才能在真实医疗环境中发挥最大价值,推动医疗的公平性与普惠性。

整理 | DrugOne团队

参考资料

Kim, C., Gadgil, S.U. & Lee, SI. Transparency of medical artificial intelligence systems. Nat Rev Bioeng (2025).

https://doi.org/10.1038/s44222-025-00363-w

内容为【DrugOne】公众号原创|转载请注明来源

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢