设想一下,当 AI 系统预测“某种药物可能治疗某种疾病”时,它不仅给出结果,还能同时展示背后的逻辑路径——涉及的分子、关系和机制。这听起来像是科研人员梦寐以求的“透明 AI”,但在实际中,却是一道长期悬而未解的难题。

最近,来自于湖南大学、亚马逊AWS和佐治亚理工的团队在ICLR 2025 接收的一项新研究——KGExplainer,正是在这一背景下提出。它为知识图谱推理带来了一种全新的可解释性框架,让 AI 的推理过程不再是黑箱,而是变成可以被追溯、可供验证的推理链条。

论文标题:

Towards Synergistic Path-based Explanations for Knowledge Graph Completion: Exploration and Evaluation

论文链接:

https://openreview.net/pdf?id=WQvkqarwXi

代码链接:

https://github.com/xiaomingaaa/KGExplainer

1. 研究背景

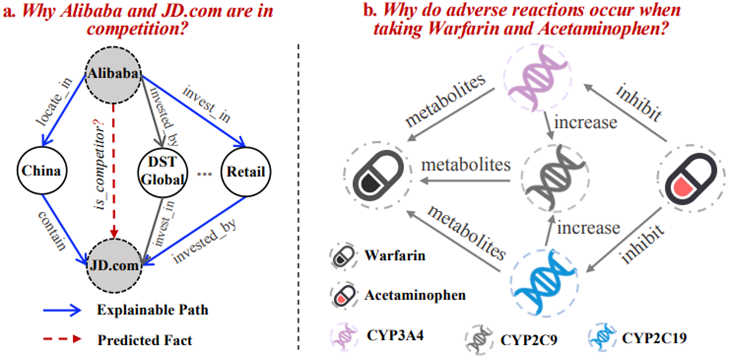

知识图谱(Knowledge Graph, KG)已经成为人工智能的重要基石,广泛应用于推荐系统、问答系统、药物发现等领域。它通过实体与关系构建复杂的网络,帮助模型在大规模数据中进行推理与预测。然而,现有的 KG 推理方法往往只能给出一个“结果”,却难以解释推理过程。这种“黑箱预测”在实际落地时面临巨大挑战,尤其是在医疗、金融等高风险场景中,用户和研究人员需要知道“为什么模型得出了这样的结论”。当前面向知识图谱推理方法的可解释性研究主要使用发现离散的事实或者推理路径来去解释预测结果,往往存在解释事实不完整的情况。一个直观的例子能够帮助我们理解。比如,为什么两家公司会被预测为竞争关系?或者,为什么两种药物会产生不良反应?这类问题的答案往往隐藏在复杂的网络路径之中。图 1 给出了两个典型场景:左侧通过多条关系路径解释了Alibaba与JD.com 的竞争关系,右侧则展示了 华法林与对乙酰氨基酚 之间不良反应的形成机制。

由上述案例可知,在复杂推理场景下单条路径比较难给出合理解释,因此,KGExplainer提出一个探索多条协同路径的方法解释复杂的推理问题,如药物发现等。

2. KGExplainer方法

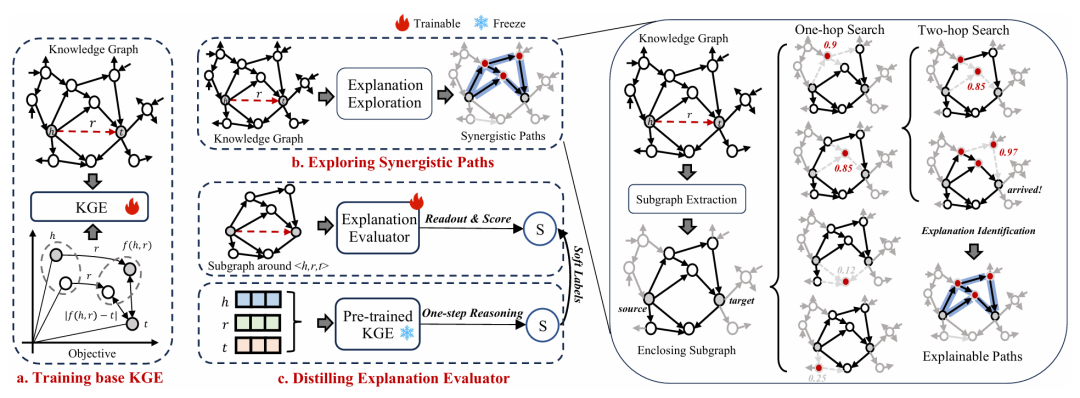

KGExplainer 的核心贡献在于:通过探索并评估协同的多条解释路径,使知识图谱的预测过程既可解释又可靠。

1. 选择与路径探索:模型首先在大规模知识图谱中自动抽取与目标三元组相关的子图,并利用贪心搜索逐步挖掘潜在的推理路径。 2. 多路径协同解释:相比于单一路径,KGExplainer 强调多条路径的互补与协同作用,以更全面的方式揭示源实体与目标实体之间的推理逻辑。 3. 评估与筛选:通过蒸馏预训练的知识图谱嵌入模型,KGExplainer 构建了一个解释评估器,用于对候选路径进行量化打分,筛选出最具可信度的解释。 4. 无关性与可验证性:该框架可适配不同的知识图谱推理模型,并能将最终的多路径解释以可视化形式呈现,既便于理解,又能为科研应用提供可验证的依据。

3. 结果

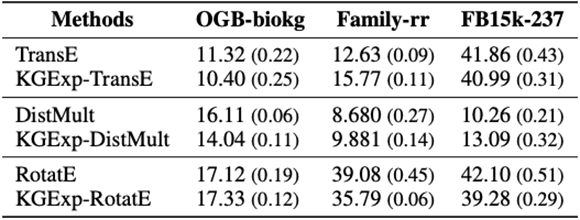

(1)可信性评估

可解释性模型的目标是准确刻画目标模型的局部决策结构。对于知识图谱嵌入(KGE),KGExplainer 能有效复现其推理行为。实验结果显示,KGExplainer 在知识图谱补全上的性能与目标模型接近,例如 KGExp-TransE 与 TransE 表现相当,而基于 RotatE 的 KGExp-RotatE 则在预测精度和路径恢复方面均达到最佳。这表明 KGExplainer 不仅忠实于目标模型,还能通过蒸馏的解释评估器过滤噪声,提升稳健性与泛化能力,从而生成更可信的解释。

(2)可解释性评估

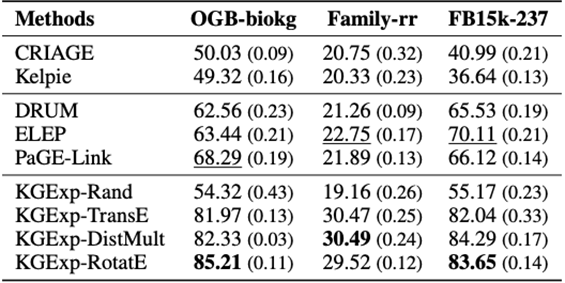

评估解释质量的核心在于客观衡量其可信度。由于难以获得真实的“标准解释”,KGExplainer 通过蒸馏评估器并设计了 F1@1 与 Recall@1 两个指标来量化解释的可靠性。实验结果(见表 2 和表 3)显示,在三个常用数据集上,KGExplainer 相比基线方法显著提升了解释性能:在 OGB-biokg 数据集上,F1@1 和 Recall@1 分别提升了 16.92% 和 12.08%;在 Family-rr 数据集上,分别提高 7.74% 和 4.77%;在 FB15k-237 数据集上,提升幅度为 13.54% 和 4.19%。这些结果表明,KGExplainer 能够生成更加可信和有效的解释。此外,进一步的对比分析表明:与子图级方法(如 CRIAGE 和 Kelpie)相比,KGExplainer 的路径级方法在解释质量上更具优势;同时,相较于基于路径的现有方法(如 DRUM、ELEP、PaGE-link),KGExplainer 通过协同路径探索与评估机制,实现了更高的解释精度与稳健性。

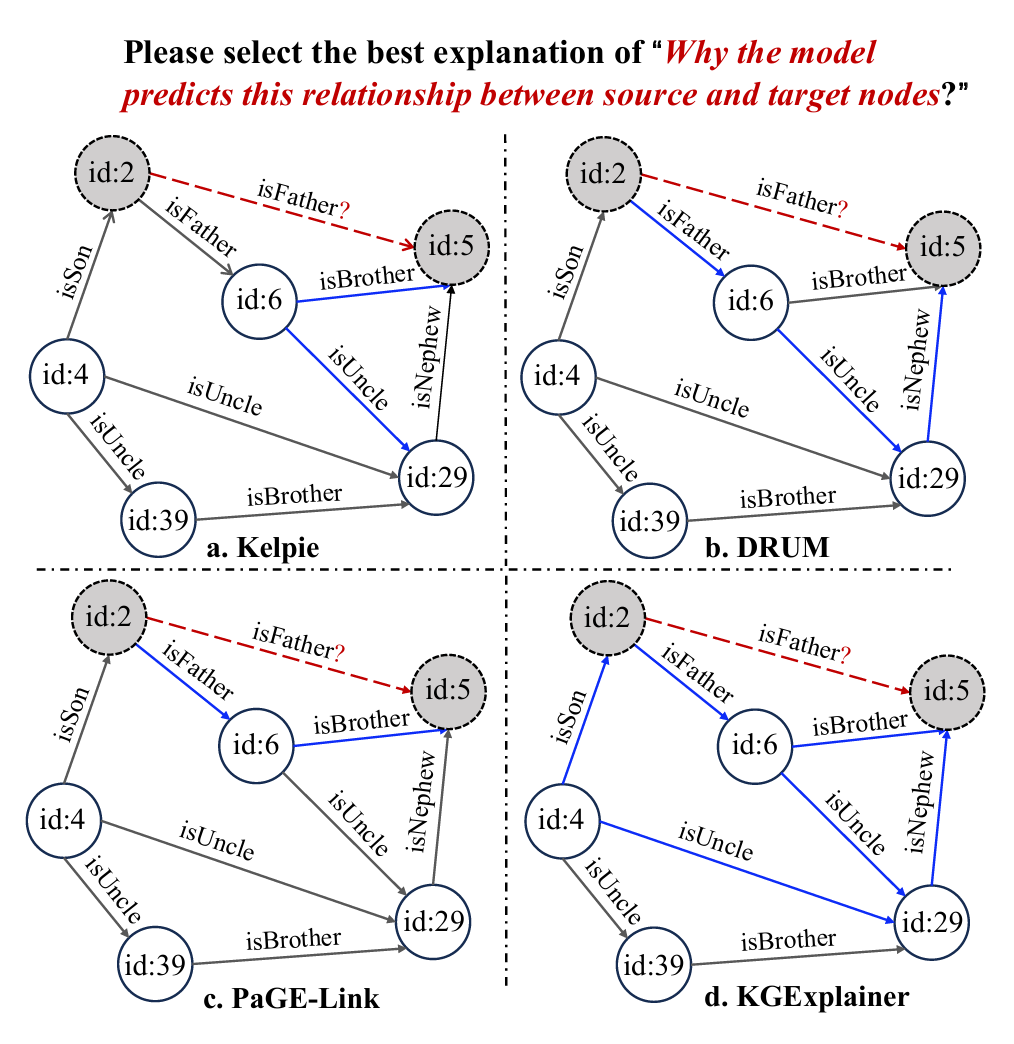

(3)人类评估

为了进一步验证解释的可理解性,我们设计了人工评估实验。从 Family-rr 测试集中随机抽取 20 个预测链接,并分别利用子图方法(Kelpie)、路径方法(DRUM 和 PaGE-Link)以及 KGExplainer 生成对应解释。随后,我们将预测事实及四种解释以节点和边类型信息的形式展示给评估者(不标注具体方法名称),并设计单选题,请受试者选择“哪一种解释最能说明模型为什么预测该关系”。本次调查覆盖了硕士生、博士生及教授群体,参与者既包含具备知识图谱背景的人,也有非专业背景人员。最终共收集 78 份答卷,其中 83.3%(65/78) 的受试者选择了 KGExplainer 给出的解释。这表明,相比其他方法,KGExplainer 在生成更贴近人类理解的解释方面表现更优。

结语

解释性是人工智能走向可信与落地应用的关键一步。KGExplainer 的价值在于,它不仅仅解决了“AI能不能预测”的问题,更回答了“AI凭什么这样预测”。对于读者来说,这不仅是一项学术上的突破,也是一种未来感的提示:也许有一天,我们会像信赖医生的诊断一样,去信赖 AI 给出的答案与解释。

参考资料:

[1] Ma, Tengfei, et al. "Towards synergistic path-based explanations for knowledge graph completion: Exploration and evaluation." The Thirteenth International Conference on Learning Representations. 2025.

[2] https://github.com/xiaomingaaa/KGExplainer

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢