HyperAI超神经在前段时间,为大家带来了阿里巴巴旗下通义万相实验室开源的 AI 视频生成模型 Wan2.2 的在线教程,作为全球首个 MoE 架构视频模型,Wan2.2 以电影级的生成效果与高效的计算效率为我们带来了深刻的印象。不知道亲自体验过的朋友们有怎样的感受呢?欢迎分享在评论区。

就在今年 8 月,通义万相团队又带来了新的进展。他们基于 Wan2.2 文本到视频基础模型,构建了 Wan-14B ,并在其基础上推出了一款音频驱动的视频生成开源模型 Wan2.2-S2V-14B。该模型仅需一张静态图片和一段音频,便能生成电影级质感的数字人视频,且时长可达分钟级,支持多种图片类型和画幅。研究团队通过实验将其与现有的前沿模型进行对比,结果表明 Wan2.2-S2V-14B 在表现力和生成内容的真实性方面均具有显著提升。

为了支持模型在复杂场景中的生成质量,研究团队采用双管齐下的策略整理了一个更为全面的训练数据集。一方面,从 OpenHumanViD 等大规模开源数据集中自动筛选。另一方面,研究人员自制并手动挑选了高质量样本数据。两部分数据统一经过姿态跟踪、清晰度与美学评估、音画同步检测等多重过滤,最终构建出一个头部特写(Talking Head)数据集。通过混合并行的训练策略,实现了模型性能的高效挖掘。

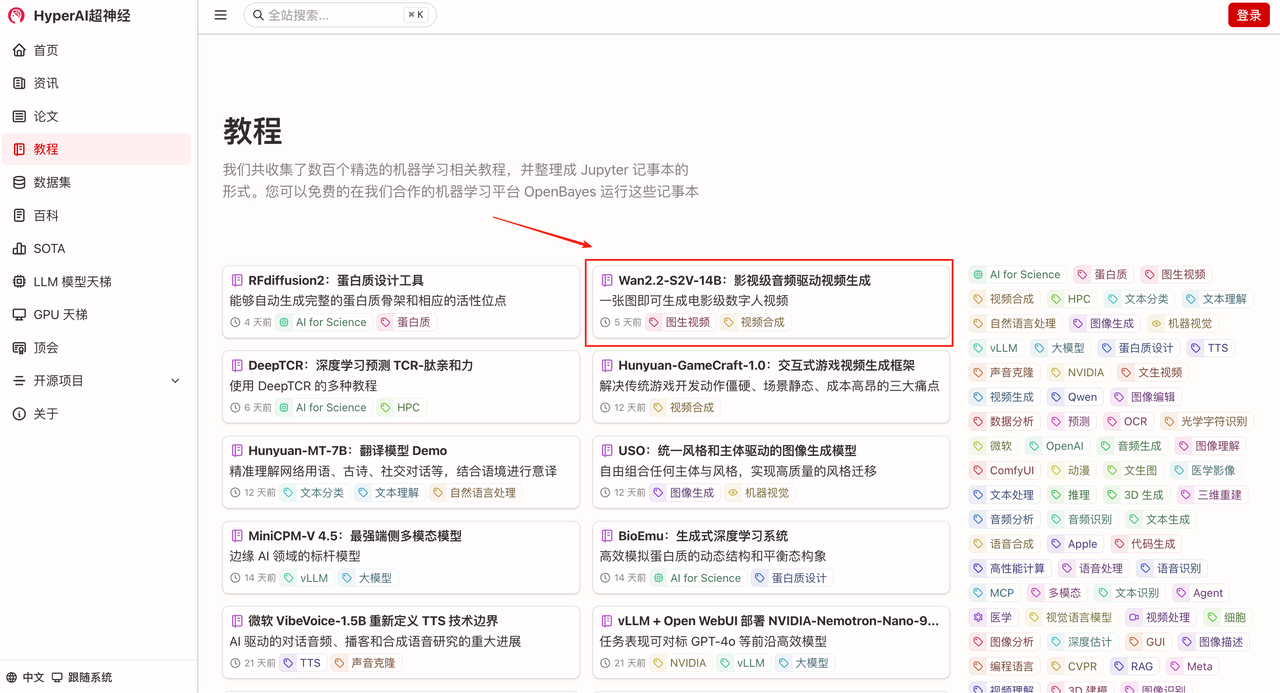

「Wan2.2-S2V-14B:影视级音频驱动视频生成」现已上线 HyperAI超神经官网(hyper.ai)的「教程」板块,快来生成一个属于自己的数字人吧!

教程链接:

Demo 运行

1. 进入 hyper.ai 首页后,选择「教程」页面,并选择「Wan2.2-S2V-14B:影视级音频驱动视频生成」,点击「在线运行此教程」。

2.页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

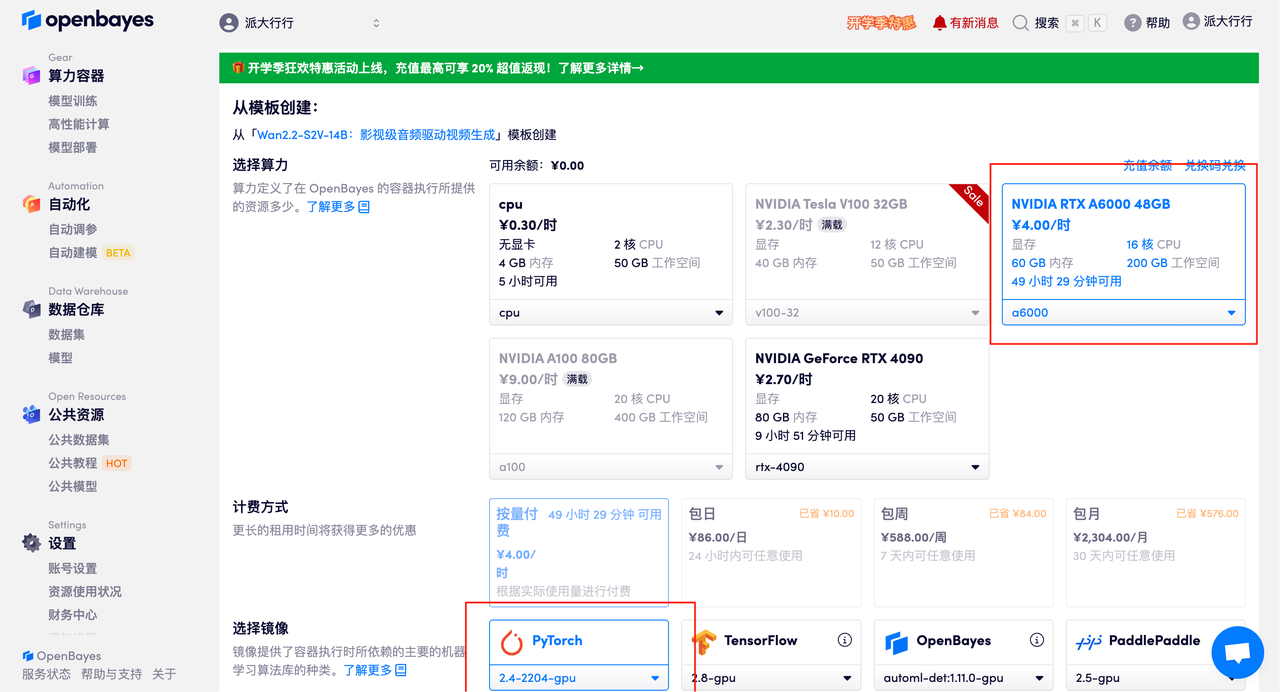

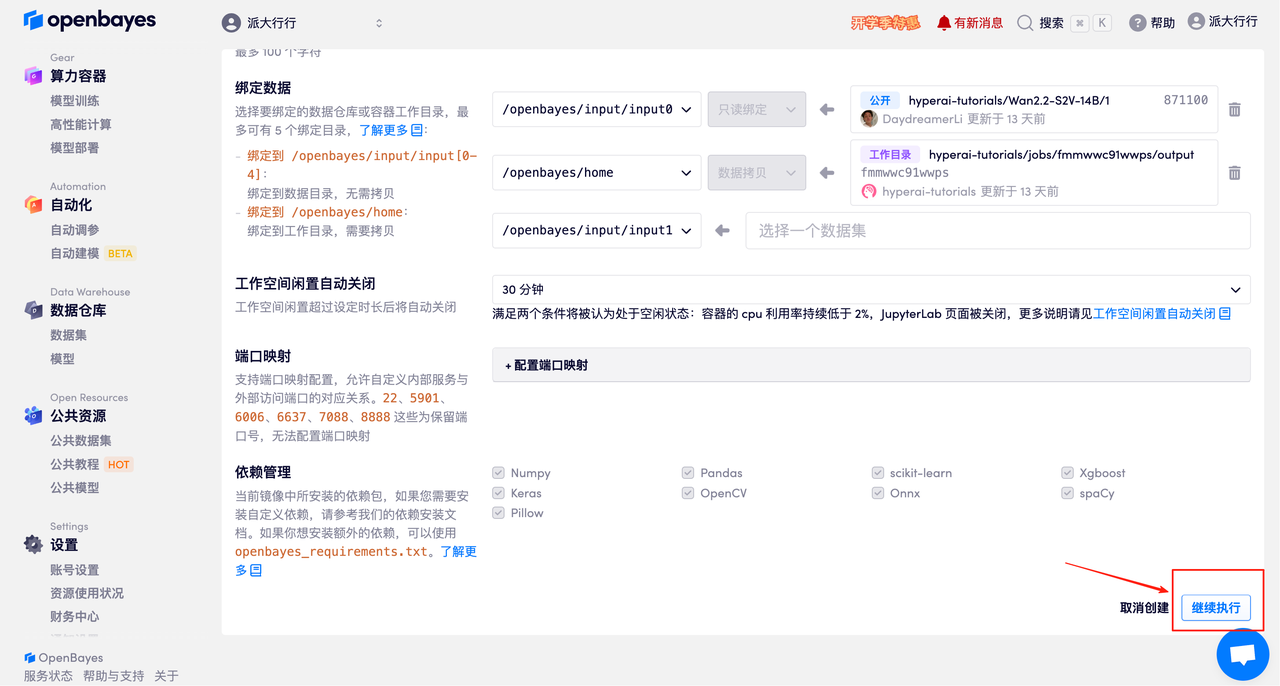

3. 选择「NVIDIA RTX A6000 48GB」以及「PyTorch」镜像,并点击「继续执行」。OpenBayes 平台提供了 4 种计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

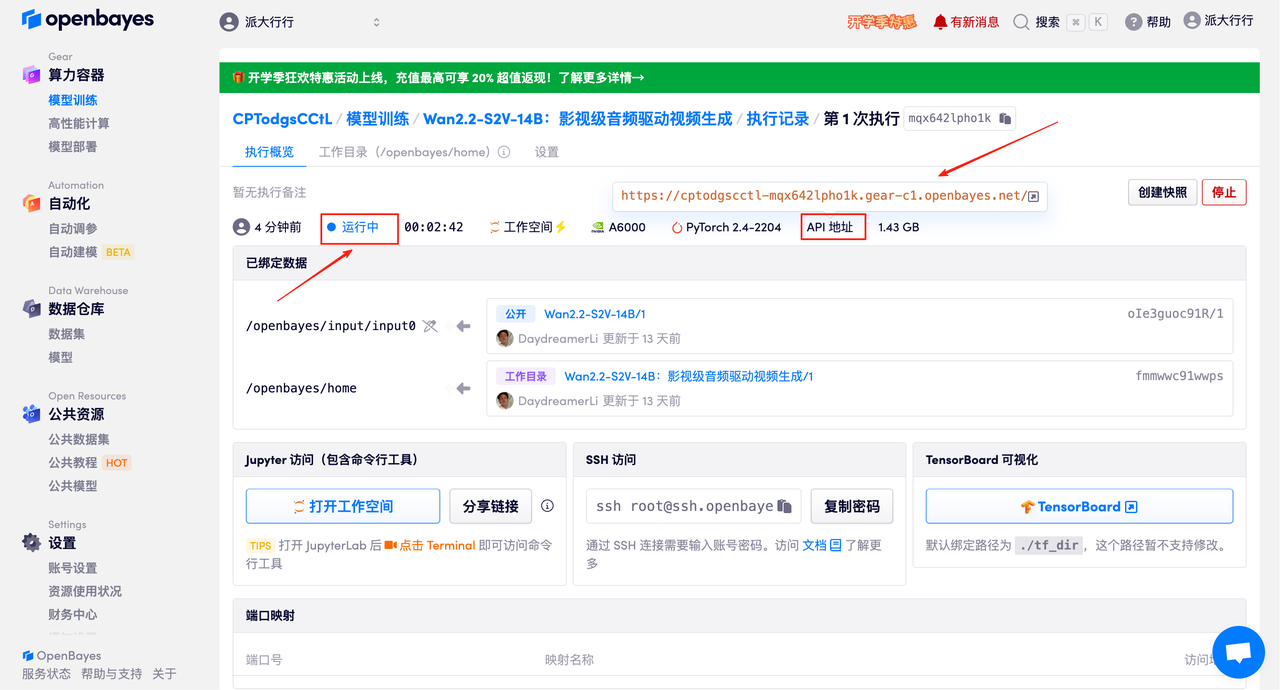

4.等待分配资源,首次克隆需等待 3 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果演示

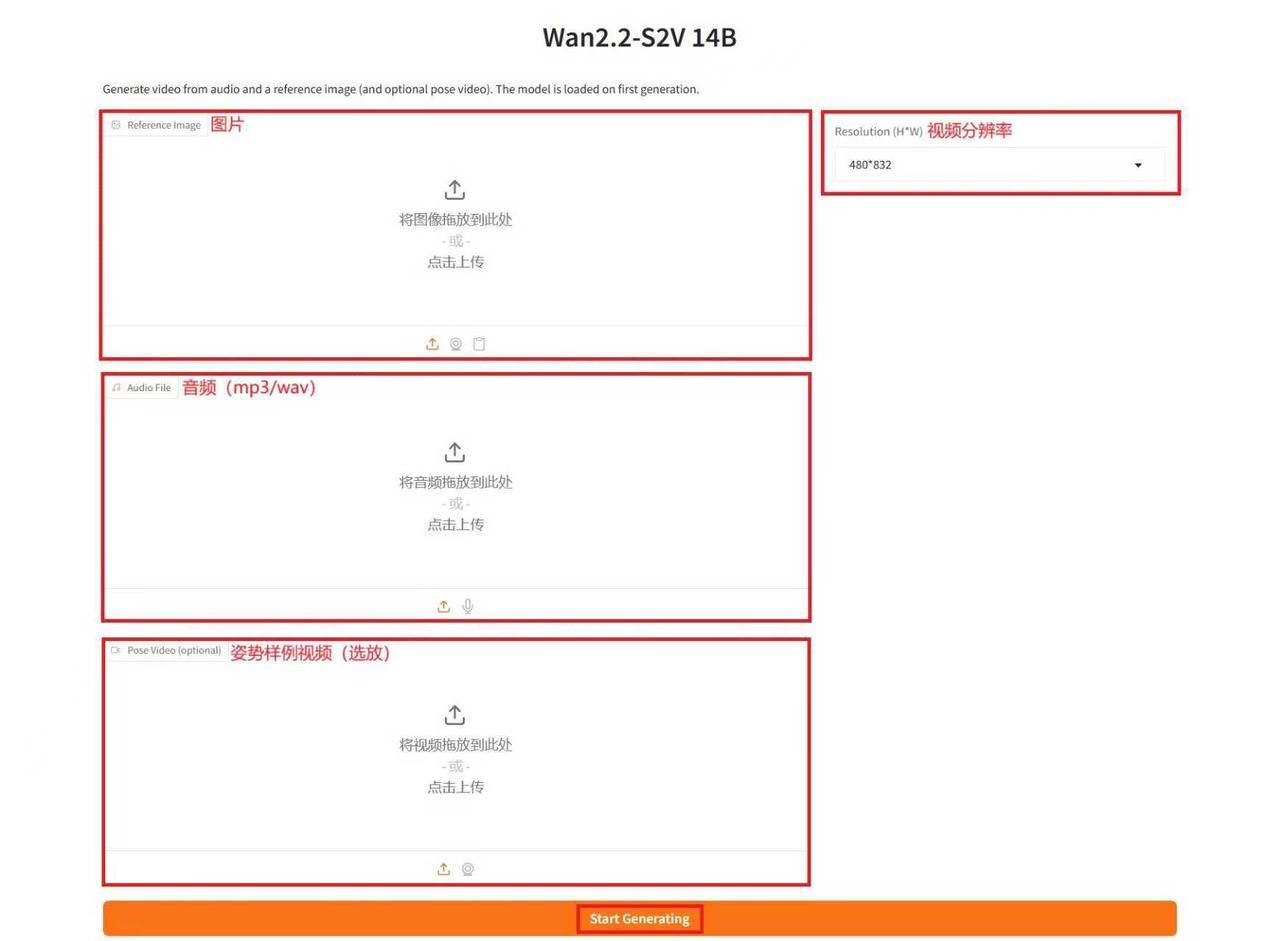

进入 Demo 运行页面后,在文本框内输入相关文字描述,并上传图片以及音频,根据需求调整相关参数,点击「Start Generating」即可生成视频。(注意:推理步数越多,生成的效果越好,同时推理生成时间也会更长,请合理设置推理步数。例如:推理步骤为 10 时,生成视频大约需要 15 分钟左右。)

生成示例

以上就是 HyperAI超神经本期推荐的教程,欢迎大家前来体验!

教程链接:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢