摘要

差分隐私(DP)是隐私保护数据发布与计算的核心范式之一,它像一把“噪声滤镜”:在结果里轻轻混入一点随机扰动,就能让单条记录的信息被彻底淹没,却仍能保留整体趋势。无需对谁可能窃密做任何假设,它就能在数据收集、发布和使用的每一步给出可量化、可审计的安全承诺。面向合规与可信 AI,DP 正与联邦学习、安全多方计算、可信执行环境等技术叠加,形成多层防护,让数据“可用不可见”,在保护个人隐私的同时释放跨机构协作的价值。

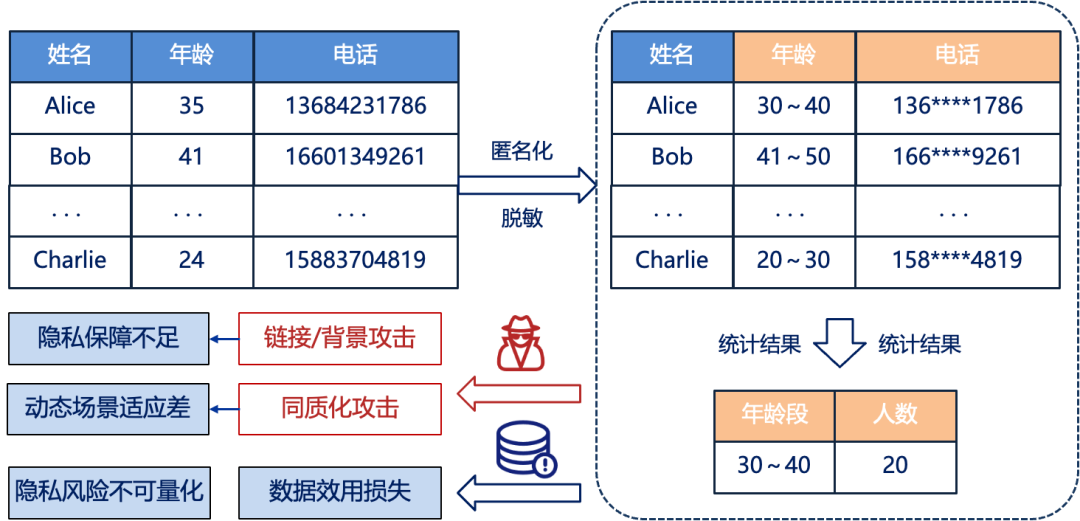

随着互联网技术发展,个人、企业和政府机构对数据存储与共享需求快速增长,海量敏感信息(如医疗健康记录)集中存储于云端或分布式系统中。为平衡数据共享与隐私保护,匿名化/脱敏技术成为主流—通过模糊化、泛化、扰动等处理方式在数据发布前对敏感字段进行处理,例如医疗数据共享中移除患者姓名、身份证号等直接标识符,从而降低个体身份可识别性减少隐私泄露风险。这些技术在早期数据开放场景中发挥了基础保障作用,但随着数据规模扩大和攻击手段升级,传统方案逐渐暴露出隐私保障不足、效用损失显著、动态适应性差等局限性:

隐私保障不足:基于k-匿名、l-多样性等静态处理方法,仅能实现局部匿名化,难以应对动态环境下的隐私风险。例如,k-匿名虽能保证同一组内个体不可区分,但若攻击者掌握关联信息(如出生日期、邮编),仍可能通过重识别技术推断出具体身份,或利用链接攻击、背景知识攻击等手段重构个体信息

数据效用损失:脱敏过程常伴随信息丢失或语义模糊,显著影响分析结果的准确性。例如,过度泛化可能导致金融风控模型失去对异常交易的敏感度,医疗数据的扰动可能掩盖关键疾病特征

隐私风险不可量化:传统技术缺乏数学层面的隐私泄露边界定义,难以在隐私保护与数据可用性之间建立可验证的平衡。例如,脱敏后的数据“匿名化”程度没有可精确比较的数学数值指标,导致难以设定统一的可接受风险阈值,易出现过度或不足脱敏的问题

动态场景适应性差:在实时数据流、多方协同或交互式查询等复杂场景中,静态脱敏技术难以应对数据更新、多轮交互等动态需求,可能因操作漏洞引发隐私泄露风险,尤其是在面对同质化攻击或相似性攻击时更易暴露敏感信息

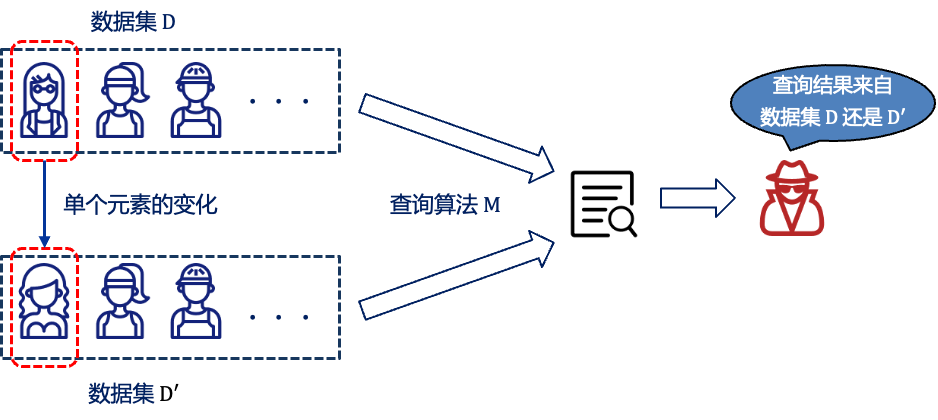

在此背景下,差分隐私(Differential Privacy,DP)作为一种基于数学严格性的隐私保护范式应运而生。考虑如下场景,两个仅在某条记录上存在差异的数据集和,虽然作为查询函数的输入它们之间存在差异,但攻击者依旧很容易通过两次不同的查询结果来推断出差异数据的信息,进而造成数据隐私泄露。

差分隐私通过在数据查询或模型训练中引入可控的随机噪声,保证在相邻数据集上的查询结果与原数据集上查询结果不可区分,确保攻击者无法通过输出结果反推个体数据的存在与否,从而实现了“隐私泄露的边界可量化”,并结合可控噪声机制、动态适应性设计等技术,有效解决了传统匿名化/脱敏技术在隐私量化、效用平衡及动态场景中的不足,成为兼顾数据安全与可用性的核心技术。

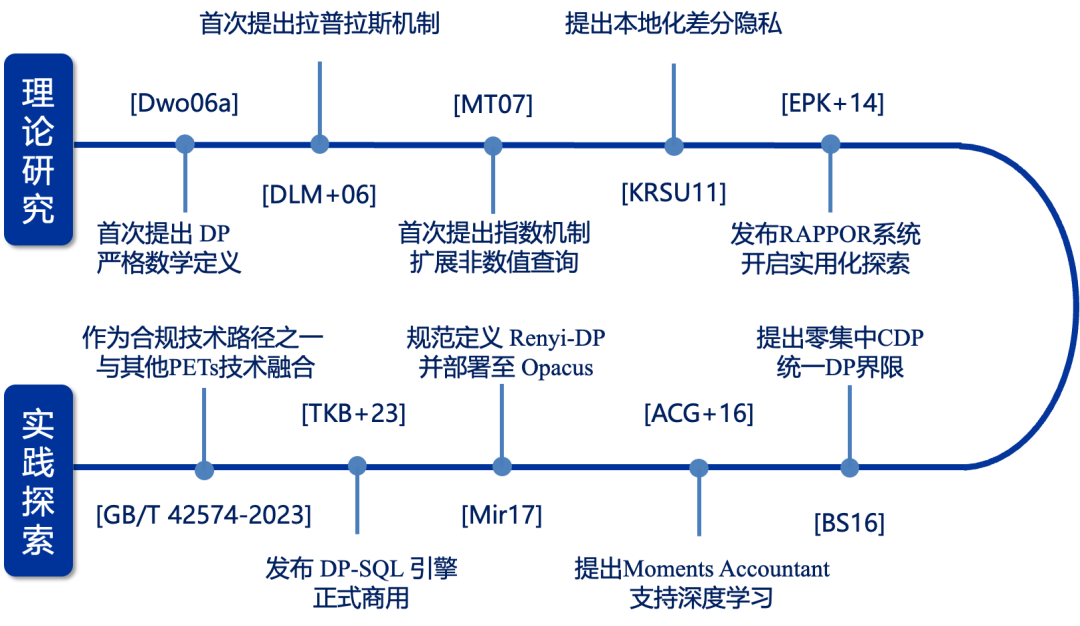

差分隐私目前已从“能否保证隐私”的抽象理论,演进为“能否高效可用”的工程基座,最终迈向“面向业务场景”的普遍部署。其核心由一套层层递进的技术谱系支撑:

1)第一阶段:隐私可证—奠定理论根基

差分隐私的诞生始于对“隐私能否被严格定义”的根本追问。2006年,Dwork[1]首次提出差分隐私的数学定义,使隐私保护首次具备了可量化、可组合的数学基础。基于此原则,噪声注入机制被系统化设计,通过将扰动幅度与查询函数的全局敏感度相匹配,实现对隐私损失的可控约束[2]。为拓展至非数值型输出场景,选择机制被引入,利用评分函数引导采样过程,在保持差分隐私的同时支持类别选择、排序发布等复杂任务[3]。而在去中心化架构中,隐私保障的责任被前置到数据源头,用户在本地完成扰动操作,形成无需信任聚合者的隐私保护范式[4]。这一系列工作共同确立了差分隐私作为可证明隐私保护的标准框架,回答了“隐私是否可以被严格保证”这一基础性命题。

2)第二阶段:高效可用—实现工程突破

随着理论体系的完善,研究重心转向如何在实际应用中维持数据效用与系统效率。2014年,Google[5]发布RAPPOR系统,LDP 首次跨越“实验室到十亿设备” ,开启实用化探索。这一实践验证了差分隐私在去中心化架构下大规模落地的可行性,标志着其从受控实验环境走向开放复杂系统的实用化突破。随后,面对多轮分析或迭代算法中隐私预算快速耗尽的问题,更精细的隐私损失度量工具被发展出来,通过引入集中化散度刻画组合行为,显著提升了预算使用的经济性[6]。在深度学习等高维复杂任务中,传统的隐私边界过于保守,难以支撑有效训练;为此,基于矩估计的追踪方法被提出,在不牺牲模型性能的前提下实现端到端控制[7]。该思路进一步形式化为基于Rényi散度的隐私会计框架,不仅统一了多种隐私变体的分析路径,还适配了随机采样操作下的紧致边界计算,成为现代隐私训练系统的通用组件[8]。这些进展标志着差分隐私从“理论安全”迈向“工程可行”,解决了“在保障隐私的前提下,是否足够高效可用”的关键挑战。

3)第三阶段:面向业务—迈向融合部署与合规落地

当前,差分隐私已进入与业务流程深度融合的新阶段。它不再是一个孤立的算法模块,而是作为数据处理流水线中的内生能力,嵌入大规模交互式分析系统,如Google在2023年发布的DP-SQL 引擎,可支持PB级数据上的低延迟SQL查询,展现出工业级部署的成熟度。与此同时,其技术定位也发生转变:与联邦学习结合形成端到端的分布式隐私保护架构,与可信执行环境协同增强过程可验证性,在安全多方计算中作为中间结果的轻量扰动手段,逐步演化为多技术融合的隐私基座。更重要的是,在制度层面,差分隐私已被纳入国家标准体系,明确作为满足个人信息匿名化合规要求的技术路径之一,获得法律意义上的认可。此时的技术焦点已不再是“是否使用DP”,而是如何实现自动化配置、跨平台集成与全链路审计。差分隐私由此完成了从“可用机制”到“业务必需”的跃迁,真正走向面向场景的普遍部署。

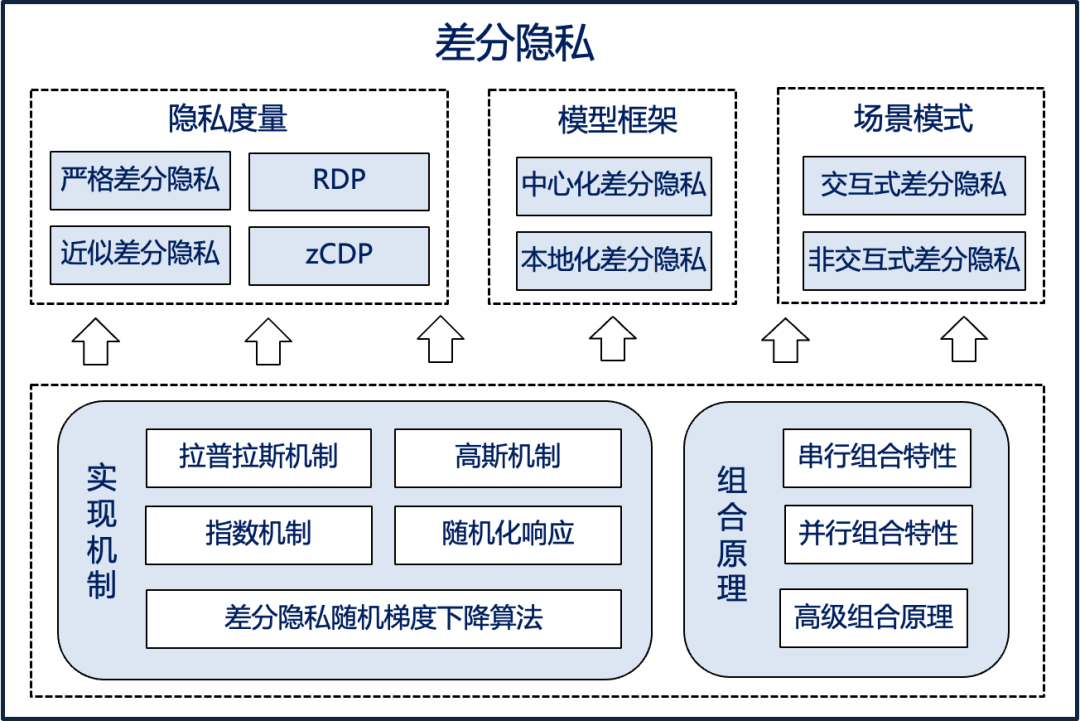

整体来看,差分隐私已发展出一套多维度、系统化的技术谱系,可从隐私度量、模型架构、交互模式、实现机制与预算核算五个核心维度进行分类和演进分析。这一技术体系的持续完善,推动了差分隐私从理论构想走向工业实践,并逐步实现面向业务合规的规模化部署。

a.严格差分隐私(-DP)

作为最严格的隐私定义,

其中,非负参数称为隐私预算,控制着输出分布之间的最大对数差异。该形式提供可证明、绝对的隐私保障,但需引入较大噪声以满足严格约束。

b. 近似差分隐私(-DP)

为提升实用性,-DP 在-DP基础上引入允许的“失败概率”delta。其定义放宽为:

其中参数表示算法以极小概率偏离-DP的保护边界,可能导致敏感信息泄露。因此,通常要求 ,从而在保留强隐私保障的同时显著降低所需噪声,成为工业实践的主流方案。

c.Rényi 差分隐私(RDP)与零集中差分隐私(zCDP)

采用 Rényi 散度来刻画隐私损失,能够更精细地追踪多次查询中的隐私消耗。相比传统组合方法,RDP/zCDP 支持更紧致的隐私预算累加与跨轮次审计,适用于深度学习、联邦学习等高频查询场景,有效平衡了隐私保护与模型性能。

2) 模型架构分类:信任假设与数据处理位置

a. 中心化差分隐私(Centralized DP, CDP)

在 CDP 模型中,用户将原始数据上传至可信的中心服务器,由后者统一执行聚合或统计查询(如均值、频率、直方图等)。为实现隐私保护,服务器在发布结果前通过随机化机制对查询函数的输出添加噪声。由于噪声在全局层面施加,CDP可实现较高的数据精度与较低的噪声总量,广泛应用于云侧数据分析、政府统计与开放数据发布。

b. 本地化差分隐私(Local DP, LDP)

LDP 是对 CDP 的分布式改进,其核心思想是在用户本地完成隐私扰动。每个用户使用本地随机化机制处理自身数据后,再将扰动后的信息发送给不可信服务器。服务端通过去偏估计方法对汇总数据进行校正,获得统计量的无偏估计。LDP 消除了对中心服务器的信任依赖,适配终端设备画像、移动数据采集及联邦学习等高隐私需求场景,但代价是更高的噪声水平和更低的数据效用。

3) 交互模式分类:数据发布的两种范式

a. 交互式差分隐私(Interactive DP)

在该模式下,数据使用者在线提交查询请求,数据拥有者在返回结果前实时注入符合差分隐私要求的噪声,并动态消耗相应的隐私预算。此类系统具有响应延迟低、查询精度可根据预算灵活调整的优点,常用于在线报表系统、API 接口服务等需要按需响应的应用场景。然而,隐私预算有限,需谨慎管理多次查询带来的累积风险。

b. 非交互式差分隐私(Non-interactive DP)

非交互式模式侧重于一次性离线发布经过隐私保护处理的合成数据集。原始数据整体输入差分隐私算法,生成一个“净化”的发布版本(如合成数据库或统计摘要),随后对外公开。所有后续查询均在此脱敏数据上执行,不再消耗额外隐私预算。该方式适合大规模数据开放、离线分析与第三方研究使用,但挑战在于如何在一次发布中兼顾多种潜在查询的需求并保证足够精度。

4) 实现机制分类:多样的隐私扰动单元

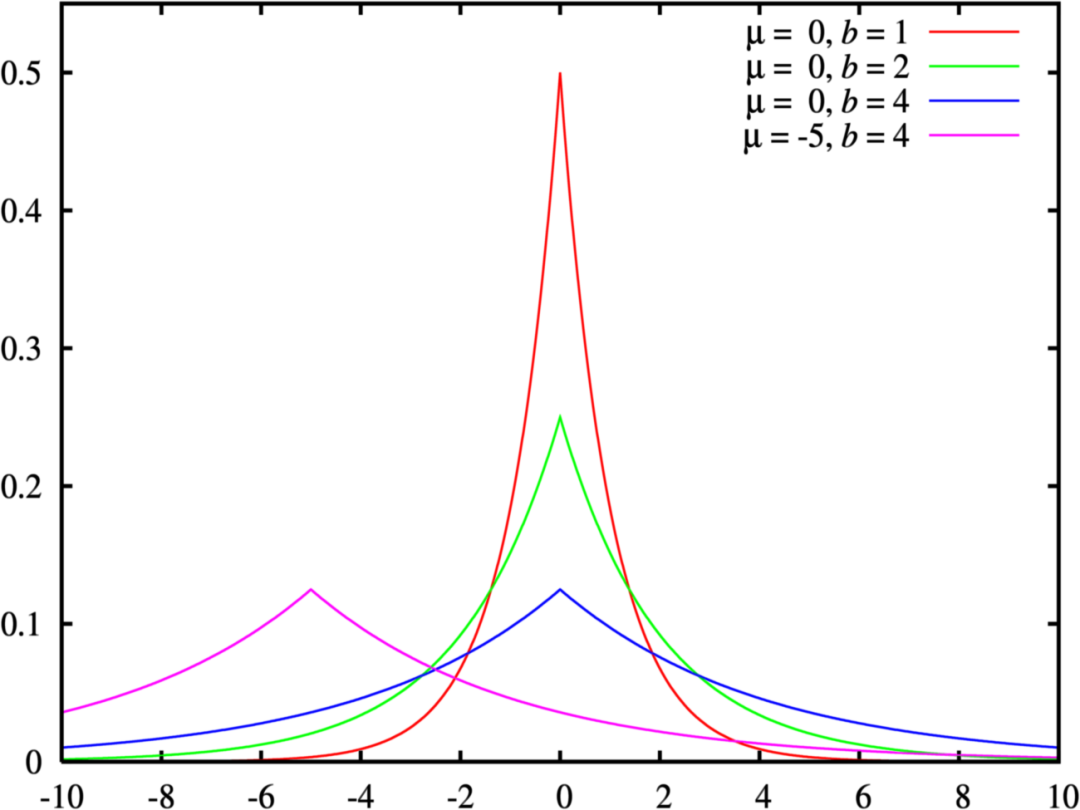

a.拉普拉斯机制

适用于低敏感度的数值型查询,通过拉普拉斯分布添加噪声。

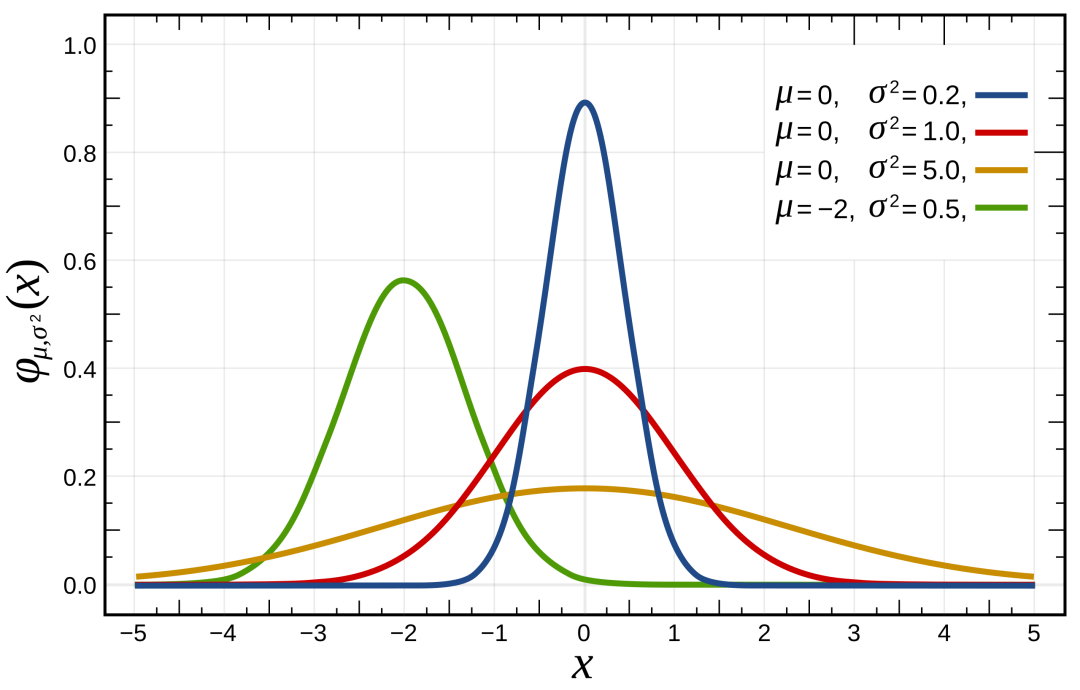

b.高斯机制

基于正态分布,常用于-DP框架下支持更高容错性;

c.指数机制

面向非数值输出(如 Top-K 查询)。

差分隐私的实现依赖于多种随机化机制,作为基础“扰动模块”灵活适配不同场景。这些机制衍生出截断、阶梯、离散化等变体,可在精度、隐私与计算效率之间进行权衡,支撑多样化数据类型与应用场景。

5) 预算核算分类:从粗粒度到精细化的隐私追踪

隐私预算是差分隐私的核心资源,其核算方式经历了从简单到精细的演进。早期采用基本组合原理,保守估计累计开销;随后发展出高级组合原理,利用概率集中性降低噪声总量。如今,基于Moments Accountant、Rényi Accountant 和zCDP Accountant的方法,能够更精确地追踪跨算法、跨训练轮次乃至跨组织协作中的隐私消耗,支持动态调度与预算复用,显著提升模型效用,成为深度学习与联邦学习中隐私管理的关键工具。

正是在上述隐私度量、模型架构、交互模式、实现机制与预算核算工具的螺旋上升中,差分隐私完成了从实验室里“能否保证隐私”的理论验证,到工业级“能否高效可用”的工程落地,再到如今“面向业务合规”的普遍部署的跨越。

三. 实现案例

阿里妈妈营销隐私计算平台(Secure Data Hub, SDH)目前已经实现了交互式的中心化差分隐私,并已应用于多种实际的营销分析业务场景。

SDH实现的DP机制包括拉普拉斯机制和高斯机制,并分别用于实现严格差分隐私和近似差分隐私。

【拉普拉斯机制】

拉普拉斯机制是最经典、也最直观的差分隐私实现方式,通过对查询结果直接添加服从 Laplace 分布的随机噪声,噪声尺度与查询函数的 L1 敏感度成正比、与隐私预算成反比。由于 Laplace 分布的指数衰减特性,输出分布对单条记录的微小变动保持-不可区分;在计数、求和等敏感度可精确度量的场景下,只需一次加法即可完成加噪,计算开销极低,成为教学与原型系统的首选。

拉普拉斯分布属于连续分布,假设其数学期望为,方差为,则其公式可表示为

给定数据集,设有函数,其敏感度为,那么随机算法

提供-差分隐私保护,其中为服从拉普拉斯分布的随机噪声。

【高斯机制】

高斯机制面向 L2 敏感度度量的查询,通过添加零均值高斯噪声实现-近似差分隐私。其核心优势是噪声方差与敏感度平方成正比、与成反比,在相同隐私预算下可达到比拉普拉斯更低的均方误差,特别适合梯度向量、欧式距离等连续值输出。由于高斯噪声的解析性和良好的可组合性,高斯机制已成为深度学习中差分隐私梯度下降算法(DP-SGD) 的标准扰动单元,并被Moments Accountant等高级工具广泛支持。

给定数据集,设有函数,其敏感度为,那么随机算法

提供-差分隐私保护,其中,表示均值为,方差为的高斯分布采样结果。

从DP的实现机制中可看出,加噪大小的关键在于隐私预算

对于多次查询时的隐私预算分配,SDH 采用了基本组合原理,包括串行组合特性和并行组合特性。

【串行组合特性】

在相同输入数据集

满足 -差分隐私 中所有预算之和为

则同时发布所有结果的机制

由串行组合性得到的隐私预算消耗量是一个上界。即给定两个满足差分隐私的数据发布过程,其实际隐私消耗量可能比串行组合性给出的隐私消耗量小,但不可能大于此隐私消耗量。

【并行组合特性】

如果将一个数据集

满足 -差分隐私 中最大值为

则发布所有结果的机制

由于任意个体的数据仅属于一个子集

为保证应用差分隐私机制后加噪数据的可用性,通常需要对数据进行最后的加工。SDH通过差分隐私的后处理性,保证加工后的数据与加工前的差分隐私保护下的数据具有完全相同的差分隐私的隐私保护程度。即如果满足-差分隐私,则对于任意(确定或者随机)的函数,同样也满足-差分隐私。

此外,后处理性保证差分隐私可以抵抗基于辅助信息的隐私攻击方法。例如,函数可能包含关于数据集元素的辅助信息,攻击者期望使用利用该信息实施关联攻击。但后处理行保证,无论中包含何种辅助信息,此攻击的效果都会被隐私参数所约束,即在差分隐私机制的输出结果上执行任意计算总是安全的。利用此性质,SDH对应用差分隐私机制后的加噪结果进行后处理,以降低噪声量、改善输出结果。

差分隐私通过在数据收集、发布与使用过程中注入可量化的受控噪声,在保护敏感记录不被还原的同时,仍能保证下游统计或建模的可用性,已在多个关键领域规模化落地并持续扩展:

● 智慧医疗影像协作:多家医院在原始数据不出域的前提下,通过横向联邦学习联合训练肺结节检测模型,梯度更新中注入拉普拉斯噪声,兼顾模型性能与个体隐私,防止病例逆向还原。

● 银行跨机构征信建模:金融机构与银行基于安全多方计算融合信贷标签与交易特征,在本地对敏感字段添加差分隐私噪声后进行加密协同计算,构建小微企业信用评分模型,满足数据最小化与合规要求。

● 大规模位置统计开放:某通信服务商采用高斯机制对基站级人流统计加噪,以-DP发布区域客流趋势,支持交通调度与商业选址,确保单个用户的行动轨迹不可追踪。

● 能源负荷预测数据共享:省级电网与光伏运营商各自对用电负荷和气象数据序列应用离散高斯机制实现本地化差分隐私,仅共享加噪聚合统计量,用于短期功率预测,防止用户用电模式被重构。

差分隐私的本质,是让数据在被“看见”之前先失去“身份”。它打破“分析必然导致泄露”的宿命论,将隐私保护从模糊的合规要求转化为可量化、可验证的计算过程。其核心思想并非彻底隐藏数据,而是确保任何个体的存在与否,都不会对分析结果产生可被察觉的影响。这一理念颠覆了传统数据发布必须依赖匿名化或访问控制的路径依赖,建立起一种基于噪声扰动与概率约束的新型信任机制。

技术上,差分隐私通过精心设计的随机化机制在统计输出中注入可控噪声,并借助严格的数学框架追踪隐私预算的消耗,使得每一次查询都成为一次可审计、可管理的隐私交易。它与安全多方计算、联邦学习等技术深度融合,构成现代隐私增强技术(PETs)的基石,在不牺牲数据价值的前提下,共同实现“可用不可见”的治理理想。

当前,SDH 平台已实现多种差分隐私技术,并将其集成至人群画像、转化归因、DEEPLINK等多类营销分析场景中。未来,SDH将持续深化差分隐私技术应用研究:一方面拓展其在联邦学习中针对高维数据、图神经网络的适用边界;另一方面融合 MPC (如PSI)实现更细粒度的协同扰动,结合自适应预算分配与语义化隐私策略引擎,构建动态、智能的隐私调控系统。

差分隐私不仅是算法层面的一项技术革新,更是一种面向数据文明时代的伦理基础设施—它不追求绝对的隐蔽,而致力于建立可解释、可信赖、可持续的智能秩序,让大数据技术在尊重个体权利的基础上安全发展。

[1] Dwork C. Differential privacy[C]//International colloquium on automata, languages, and programming. Springer, 2006: 1-12.

[2] Dwork C, McSherry F, Nissim K, et al. Calibrating noise to sensitivity in private data analysis[C]//Theory of cryptography conference. Springer, 2006: 265-284.

[3] McSherry F, Talwar K. Mechanism design via differential privacy[C]//48th Annual IEEE Symposium on Foundations of Computer Science (FOCS'07). IEEE, 2007: 94-103.

[4] Kasiviswanathan S P, Lee H K, Nissim K, et al. What can we learn privately?[J]. SIAM Journal on Computing, 2011, 40(3): 793-826.

[5] Erlingsson Ú, Pihur V, Korolova A. Rappor: Randomized aggregatable privacy-preserving ordinal response[C]//Proceedings of the 2014 ACM SIGSAC conference on computer and communications security. 2014: 1054-1067.

[6] Bun M, Steinke T. Concentrated differential privacy: Simplifications, extensions, and lower bounds[C]//Theory of cryptography conference. Berlin, Heidelberg: Springer Berlin Heidelberg, 2016: 635-658.

[7] Abadi M, Chu A, Goodfellow I, et al. Deep learning with differential privacy[C]//Proceedings of the 2016 ACM SIGSAC conference on computer and communications security. 2016: 308-318.

[8] Mironov I. Rényi differential privacy[C]//2017 IEEE 30th computer security foundations symposium (CSF). IEEE, 2017: 263-275.

💡 关于我们

阿里妈妈SDS(Strategic Data Solutions)团队 致力于用数据让商家和平台的增长战略更加科学有效。我们为阿里妈妈全线广告客户提供营销洞察、营销策略、价值量化、效果归因、隐私计算的技术服务。我们将持续在营销场景下的数据隐私安全和解决方案方向进行探索和落地,欢迎各业务方关注与合作。

📮联系邮箱:alimama_tech@service.alibaba.com

也许你还想看

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢