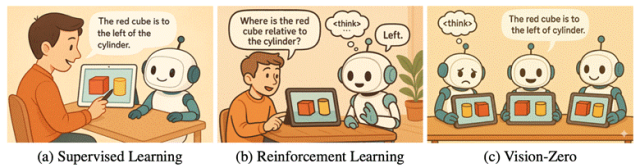

VLM 的数据缺乏已经影响到模型的能力提升了,最近的一项研究试图学习 AlphaGo 的自我迭代方式,实现能力提升。

AlphaGo 不依赖于学习人类的棋谱,通过「左右互搏」的方式分裂成两个自己来下棋,从胜负结果中学习,实现了自我迭代优化。

那 VLM 能不能像 AlphaGo 一样,在不依赖人类标注数据的情况下,通过 self-play 来「修炼」自己?

来自杜克大学、新加坡国立大学、马里兰大学和 Adobe 的研究人员提出的「Vision-Zero」这项工作,为实现 VLM 的零监督训练提供了一个通用框架。

简单来说,研究者设计了一套让 AI 自己和自己玩游戏来学习的框架,类似于「谁是卧底」游戏,通过制定游戏规则,以及「交替训练」策略,让 VLM 实现自我进化。

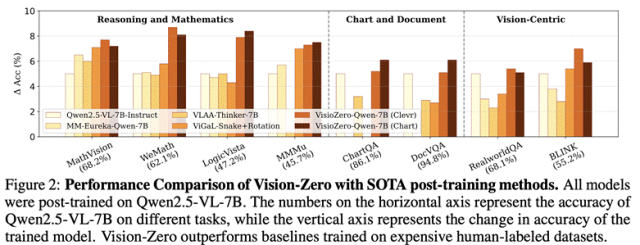

实验结果表明,在没有用任何标注数据做训练,Vision-Zero 在推理,图表问答和 Vision-Centric 理解任务上超越了其他有标注的 SOTA 后训练方法。

以下为这项研究工作的详细内容。

目前代码、模型和项目主页均已放出:

项目主页&代码:https://github.com/wangqinsi1/Vision-Zero

论文链接:https://arxiv.org/abs/2509.25541

本文作者包括来自杜克大学的汪勤思,林阅千,李海教授,陈怡然教授,新加坡国立大学的刘博,马里兰大学的周天翼教授,和 Adobe 的研究员施靖,万锟,和赵文天。

超 15000 人的「AI 产品市集」社群!不错过每一款有价值的 AI 应用。

最新、最值得关注的 AI 新品资讯;

不定期赠送热门新品的邀请码、会员码;

最精准的AI产品曝光渠道

背景介绍

尽管目前 VLM 在多模态任务上表现突出,但训练过度依赖人工标注的数据与精心设计的强化学习奖励。这种依赖带来数据稀缺问题:多模态标注成本高昂,限制了训练数据的规模与多样性。同时存在知识天花板:模型能力受人类监督边界限制,难以突破人类已有知识和策略。曾经 AlphaGo 所使用的自博弈技术通过模型与自身副本竞争交互并自动获取反馈,把计算转变为数据的同时消除了对人工监督的依赖,这使得它能够持续推动模型进步并突破人类能力上限。但是受制于 VLM 的多模态特性,目前鲜有对自博弈在 VLM 上应用的系统性研究。为此研究团队设计了一套适应 VLM 特性的自博弈框架 Vision-Zero,此框架有如下特点:

(1)策略自博弈框架:Vision-Zero 在以社交推理类游戏为模板的环境中训练 VLM,使得 agent 在自博弈过程中自动生成高复杂度推理数据,而无需人工标注。

(2)任意形式的图片都可作为输入:和以往有限制条件的游戏化训练框架不同的是,Vision-Zero 可在任意形式的图片上启动游戏,这使得模型可以在很多不同的领域里获得相应的能力提升,并有很好的泛化性能。

(3)持续的性能提升:研究团队提出了自博弈和可验证奖励的强化学习(RLVR)交替优化的自博弈策略优化算法(Iterative-SPO),这一算法解决了传统自博弈算法中常见的性能瓶颈问题。

尽管没有用任何标注数据做训练,Vision-Zero 在多个领域如推理,图表问答和 Vision-Centric 理解任务上超越了其他有标注的 SOTA 后训练方法。

从棋盘到现实:

AlphaGo 自博弈思想的泛化

自博弈作为 OpenAI 早期的重要技术路线之一,也是人工智能发展历程中多项里程碑事件的关键推动力。典型代表包括 2016 年 AlphaGo 战胜李世石,以及 2019 年 OpenAI Five 在 Dota 2 上击败世界冠军 OG 战队。人们在看到自博弈在某些特定领域大幅超越人类智能的同时,往往也会思考我们是否有可能把这种思想应用到更多的开放场景中。然而让 AlphaGo 从棋盘走入现实需要解决以下几个难题:

(1)Agent 为赢得博弈所习得的技能,应当与目标任务所需的技能高度一致。

(2)博弈环境应当足够多样且复杂,以便广泛的目标任务都能够满足条件 (1)。

(3)技能增长应当具有可扩展性:随着自博弈的进行,环境应当不断提高难度,使得越来越强的智能体能够涌现,而不是让训练收敛到一个固定的上限。

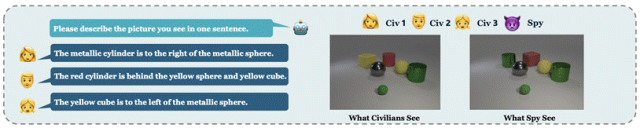

受到社交推理游戏,如「谁是卧底」的启发,研究团队设计了一套完备的自博弈规则以解决上述难题,具体规则如下:

(1)游戏中有 n 名平民和 1 名卧底。玩家首先被告知自己的角色。

(2)每名玩家会得到一张图片,卧底的图片与平民略有不同(如缺失、添加或修改了某个物体)。

(3)线索阶段:每位玩家观察自己的图片,并给出一个口头线索,描述图片内容(可以是物体描述、推断信息等)。

(4)决策阶段:多轮线索给出后,进入决策阶段。玩家根据线索结合自己的图片,投票找出卧底。

此游戏具有高度策略性与挑战性,卧底需要根据他人线索推断并伪装自己,避免暴露。平民需要提供足够准确但不泄密的线索,同时分析他人线索寻找可疑点。如此一来,Agent 在游戏过程中便可生成足够长且复杂的推理链条,并且随着对手能力的提升,其所面临的挑战也会越来越大,并被激发出更强的视觉理解与推理能力。

领域无关的数据输入

此游戏仅需要两张有细微差异的图片对作为输入即可启动,得益于目前强大的图片编辑工具如 ChatGPT 或 nano banana,数据的构建极其简单并且成本低廉,因此此框架的应用场景非常广泛。研究团队使用了三种完全不同的场景图片输入作为训练数据:

(1)CLEVR 合成场景:使用 CLEVR 渲染器自动生成了 2000 对图像。原图有 4–6 个随机排列的物体,修改图中有两个物体在颜色和形状上被改变。

(2)图表数据:从 ChartQA 训练集随机选取了 1000 张图表作为原始图像,并使用 Gemini2.5-Flash 随机交换图表中的数值属性生成对应的修改图像

(3)真实世界图片:从 ImgEdit 训练集中随机抽取了 1000 对图像,该数据集包含高质量的真实世界单轮图像编辑对。

从局部均衡到可持续提升

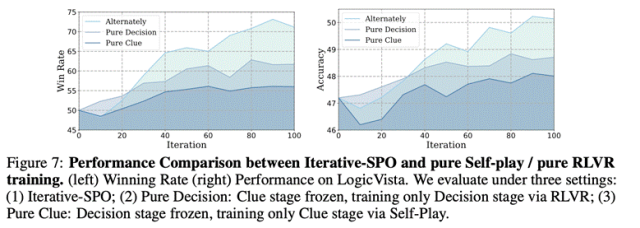

纯自博弈训练容易陷入局部平衡,难以探索新的推理路径,而单独的强化学习方法在掌握现有问题集后也易出现知识饱和。为缓解这些问题,作者团队提出采用双阶段交替训练:当决策阶段表现显示线索阶段已饱和时转向线索训练提高难度,反之则切回决策阶段。此方法被命名为 Iterative Self-Play Policy Optimization。实验表明,两阶段交替训练性能明显优于单阶段训练,对比如下。

实验结果

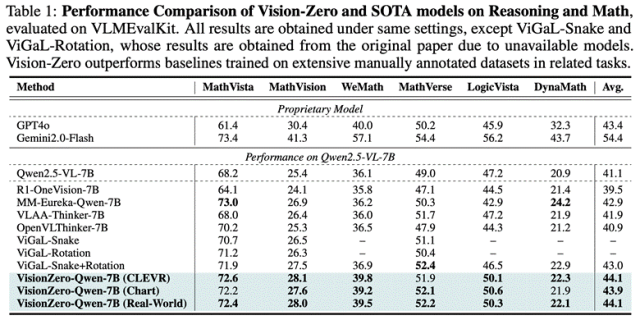

强任务泛化能力。为了评估 Vision-Zero 框架下训练的 VLM 是否能泛化到更广泛的推理与数学任务,作者团队在六个基准数据集上对模型进行测试(结果见表 1)。实验表明,即使没有使用标注数据做训练,Vision-Zero 在各项基准上一致性得优于其他需要标注的 SOTA 方法。其中,VisionZero-Qwen-7B(CLEVR、Real-World)较基线提升约 3%,VisionZero-Qwen-7B(Chart)提升约 2.8%,而目前最优的基线方法仅约 1.9%。值得注意的是,基线方法需要大量数学与推理样本训练,而 Vision-Zero 环境并未显式包含数学任务,只通过自然语言策略博弈提升逻辑推理,并将所学能力有效迁移到更广泛的数学与推理任务,甚至超过专门在大规模任务数据上训练的模型。

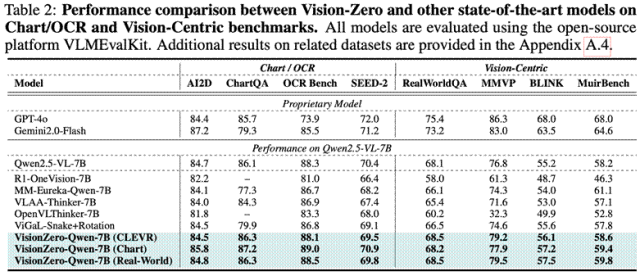

跨能力负迁移的缓解

VLM 后训练的关键难题之一是跨能力负迁移,即在特定任务上训练后,模型在其他任务上反而变差。表 2 显示,基线模型在推理和数学数据上后训练后,性能明显下降,例如 MM-Eureka-Qwen-7B 在 ChartQA 上下降约 10%。相比之下,Vision-Zero 训练的模型能有效缓解负迁移:VisionZero-Qwen-7B(CLEVR)在视觉任务上显著提升,同时在四个图表/OCR 任务上平均仅下降 0.2%;VisionZero-Qwen-7B(Chart)在全部图表/OCR 基准上都有提升,并在视觉任务上平均再涨 1%。这表明 Vision-Zero 的多能力策略训练显著减轻了传统单一任务训练中的负迁移问题。

启示

Vision-Zero 证明了自博弈从单一任务走向通用任务的可行性与巨大潜力。通过构建开放、可扩展的博弈环境,它摆脱人工标注依赖,突破数据和知识瓶颈,使模型在无需特定任务训练的前提下实现可持续的能力进化与跨领域泛化。同时,双阶段交替优化有效避免自博弈常见的局部均衡问题。并且,通过自博弈训练的 VLM 有效缓解了传统的在单一任务上做训练的跨能力负迁移问题。

Sam Altman:我承认我之前错了,AI 超级系统才是 OpenAI 真正想要的

为什么 OpenAI 们都要搞 AI 基建?Groq 创始人把背后的逻辑讲透了

转载原创文章请添加微信:founderparker

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢