「所有能被验证的任务,最终都会被 AI 解决。」

「智能未来将成为一种商品,未来获取知识或进行某种推理的成本和可及性将趋近于零。」

最近,前 OpenAI 核心研究员、CoT作者 Jason Wei 在斯坦福大学 AI Club 做了一场精彩的演讲。这也是他跳槽到Meta 后少有为数的公开分享。

Jason Wei 提出了三个理解和驾驭 2025 年 AI 发展至关重要的核心思想:验证者定律、智能的锯齿状边缘和智能商品化。

Jason 对于此前提出的验证者定律做了进一步补充和完善,「训练 AI 解决某个任务的容易程度,与该任务的可验证性成正比。所有既可能解决又容易验证的任务,都将被 AI 解决。」

某种意义上来说,验证者定律决定「哪些点会被率先突破」,智能商品化解释「突破后如何被规模化与降本」,锯齿状边缘则强调「能力突破的时间序与不均衡版图」。

虽然没提创业,但似乎又句句不离创业。

基于演讲视频,Founder Park 进行了完整编译处理。

Jason Wei 背景:目前在 Meta 超级智能实验室工作。在加入 Meta 之前,是 OpenAI 的核心科学家,参与了 o1 模型和 Deep Research 产品的创建,也是 CoT 的作者之一。

演讲视频:https://www.youtube.com/watch?v=b6Doq2fz81U

超 15000 人的「AI 产品市集」社群!不错过每一款有价值的 AI 应用。

最新、最值得关注的 AI 新品资讯;

不定期赠送热门新品的邀请码、会员码;

最精准的AI产品曝光渠道

我先来问一个问题:「AI 的发展会怎么改变我们的世界?」

你会发现,不同的人会给出完全不同的答案。比如,我有一位做量化交易的朋友会说:「ChatGPT 确实很酷,但它做不了我工作中那些具体的事情。」但另一方面,我最近问了一位顶尖实验室的 AI 研究员,他却觉得,我们基本上只剩下两到三年的工作时间了,之后 AI 就会取代我们的工作。

大家对 AI 未来的走向,看法真是千差万别。

今天,我今天就想从三个角度,跟大家分享一下我的看法。

首先,第一个趋势是:智能将成为一种商品。这意味着获取知识或进行某种推理的成本和可及性将趋近于零。

其次,是我提出的一个观点,我称之为验证者定律(Verifiers Law)。它的核心是:训练 AI 完成特定任务的能力,与验证该任务完成情况的难易程度成正比。

最后,我想谈的是智能的锯齿状边缘(Jagged Edge of Intelligence)。这意味着 AI 在不同任务上的能力水平和进步速度,会因为任务本身的特性,表现出很大的差异。

智能商品化:

智能和知识会变得又快又便宜

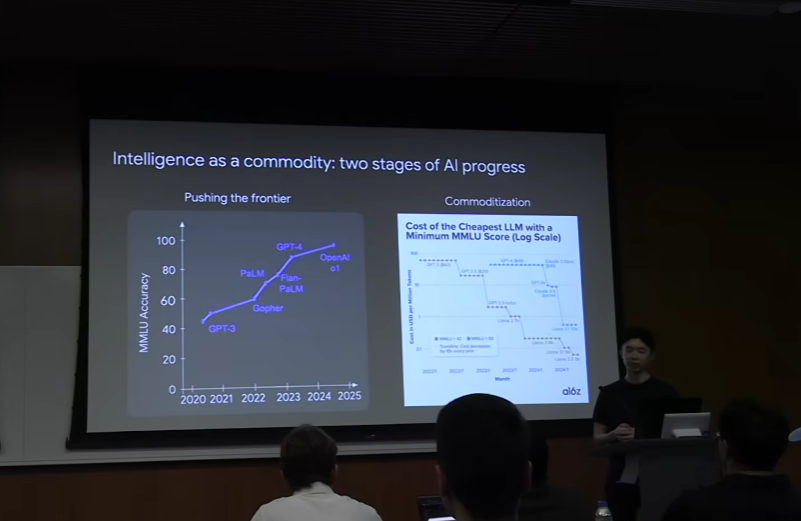

首先,我们来谈谈「智能商品化」。我认为,AI 的发展可以分为两个阶段:

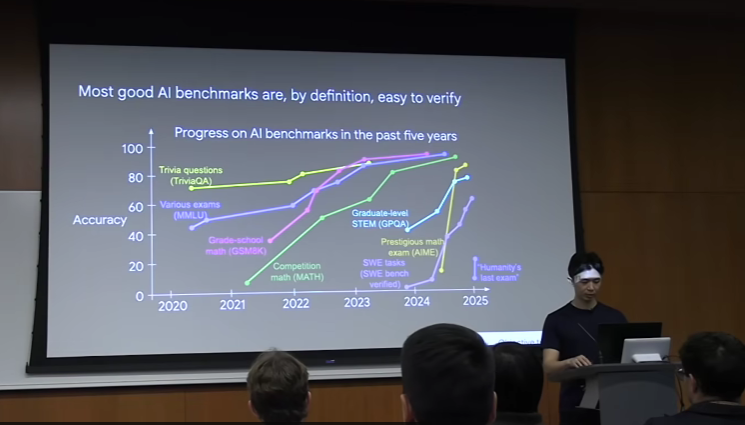

第一个阶段是推动前沿。在这个阶段,AI 还不能很好地完成某项任务,研究人员正在努力解锁这项新能力。比方说,如果我们以 MMLU(大规模多任务语言理解)这个非常常见的基准测试为例,绘制过去五年的表现曲线,你会发现性能是逐渐提升的。

第二个阶段是,一旦 AI 掌握了某种能力,它就会被商品化。这里有一个例子,Y 轴代表时间,你可以看到在 MMLU 基准测试中达到特定性能水平所需的成本(以美元计)。趋势显示,每年使用达到特定智能水平的模型所需的成本都在下降。

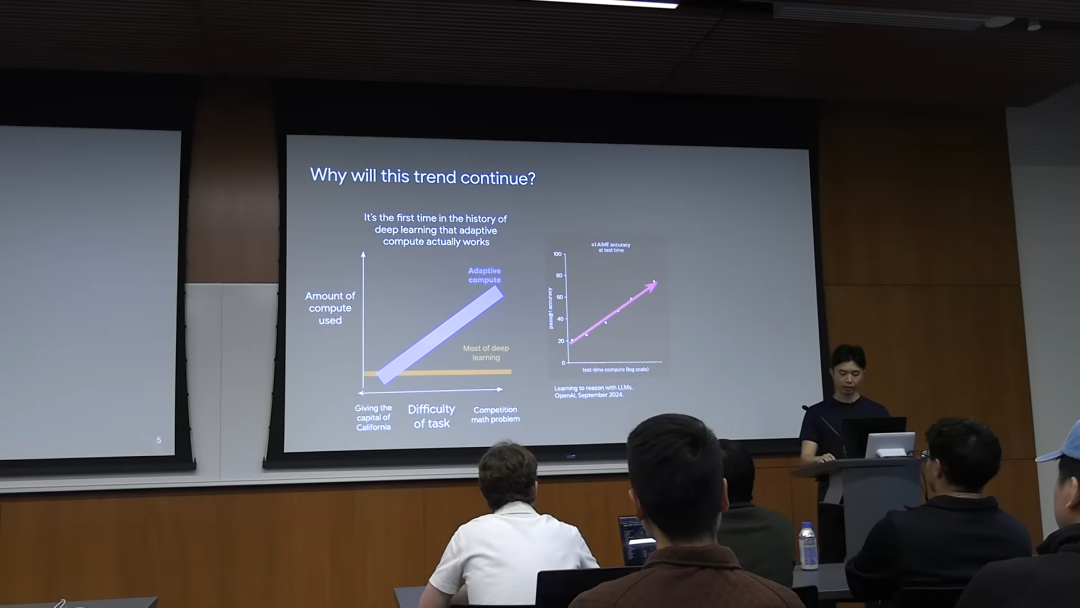

你可能会问,为什么这种趋势会持续下去?我的观点是,这是深度学习历史上,自适应计算(adaptive compute)第一次真正奏效。想一想,过去整个深度学习时代,直到去年,我们都处于一种模式:无论任务是回答「加利福尼亚州的首府是什么」这样简单的问题,还是解决一个非常困难的奥数竞赛题,用于解决特定问题的计算量都是固定的。但现在,我们进入了自适应计算时代,你可以根据任务调整所使用的计算量。

自适应计算之所以能持续降低智能成本,是因为你不再需要持续扩大模型规模。如果任务非常简单,你可以将计算成本降到最低,直到达到执行该任务所需的最低限度。

这项技术的最初突破,是一年多前发布的 o1 模型,它证明了,如果你在测试阶段,为了解决数学问题投入更多的计算资源,那么模型在这个基准测试上的表现就会更好。

AI 商品化还有另外一个方面是,获取公共信息的时间会越来越短。我把信息检索分成了四个时代:前互联网时代、互联网时代、聊天机器人时代,以及智能 Agent 时代。每个时代,你想找点信息,所需的时间都在急剧缩短。

例如,如果你想知道「1983 年釜山的人口是多少」,在 前互联网时代,你可能需要开车去图书馆,然后翻阅大量百科全书才能找到,这可能需要几个小时;在互联网时代,你可能需要搜索,然后浏览网页找到实际答案,这可能需要几分钟;而现在,获取这个答案基本上是即时的。

再问一个更复杂的问题,比如「1983 年釜山有多少对夫妇结婚」。在前互联网时代解决这个问题,如果你不住在韩国,可能需要先飞到韩国,前往最近的政府图书馆,那里收藏有这类信息目录。你可能需要翻阅几十本书才能找到那个具体信息。在互联网时代会容易一些,你可以搜索,但如果你不会韩语,可能需要浏览所有网站并找人帮忙。在聊天机器人时代会更容易一些。而在智能 Agent 时代,我认为这可以在几分钟内找到。

更难的,比如:「1983 年亚洲人口最多的 30 个城市中,按当年结婚人数排序。」我认为现在这可能可以在几小时内完成,但在前互联网时代,回答这个问题可能需要几周。

我举个例子,「1983 年釜山有多少人结婚」并不是一个超级简单的问题,早期的模型 GPT-3 无法做到。但 OpenAI 的 Operator 工具就可以做到,因为它会访问韩国统计信息服务 (KOSIS) 数据库,点击查找,直到找到正确的数据库查询,然后才能找到答案。

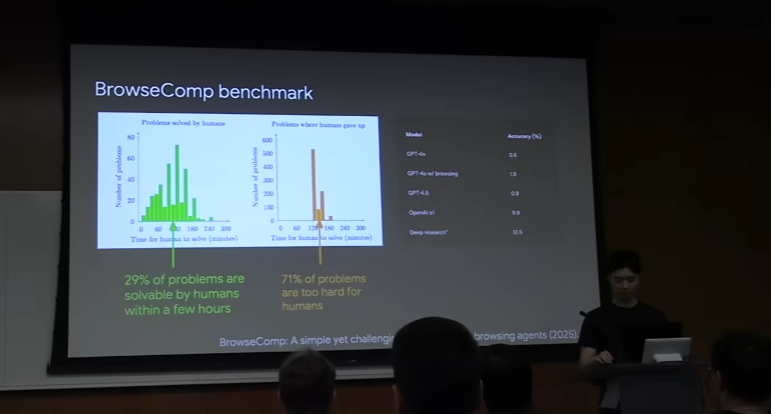

为了衡量这种能力,OpenAI 搞了一个名为 BrowseComp 的基准测试。它包含了一系列问题,里面都是些答案容易验证,但找答案却非常耗时的问题。例如:「这里有一些关于足球比赛的限制条件,请找出符合所有这些限制的比赛。」

我们邀请了很多人类来回答这些问题。平均而言,有些问题人类需要两个多小时才能解决。如果你看图表,你会发现,很多问题人类在两小时内根本无法完成。但是,OpenAI 的 Deep Research 模型可以解决其中大约一半的问题,这是一个相当不错的进展。

所以,总结一下「智能商品化」这个概念。

一旦我们用 AI 实现了某种能力,其成本将趋近于零。我认为这个趋势还会继续下去。

即时知识:任何公开可用的信息,你都能立刻获取。

它会带来什么:

领域民主化:那些过去因为知识门槛(比如编程)而受限的领域,会变得更加开放。编程就是个很好的例子,个人健康也一样。比如,过去你如果想进行生物黑客实验,去医生那里说「我想改善我的鼻呼吸」,医生可能会说「你就试试我告诉你的方法」,而不会帮你理解如何进行自己的实验。但现在,ChatGPT 几乎能提供一个好医生能给你的所有信息。

私有信息价值提升:既然公共信息的成本降得这么低,那那些私密的、内部的、不公开的信息,相对价值就会高得多。比如,非市场挂牌出售的房屋信息现在更值钱。

个性化信息流:最终,我们获取信息会变得无摩擦,毫不费力。你访问的不再是人人共享的公共互联网,而是一个为你量身定制的个性化互联网。你想知道什么,它都会专门为你展示出来。

验证者定律:训练 AI 解决任务的能力,

与任务的可验证性成正比

第二个理念是验证与求解的不对称性。验证的不对称性是计算机科学中一个非常常见的想法,简单讲就是:对于某些任务,验证解决方案比找到解决方案要容易得多。

我举几个例子:

数独:解起来挺难,但有了答案,验证对错就简单了。

写 Twitter 的代码:这活儿明显得几千名工程师,甚至几个「马斯克」级别的老板才能搞定。但要验证它有没有问题,就简单多了,刷刷网页,点几下就行。

竞赛数学题:有些题,解起来和验证起来可能一样难,属于中间地带。

编写数据处理脚本:有时候情况还反过来。你要自己写个处理数据的脚本,可能挺简单。但要是给我一堆别人写的乱七八糟的代码,我可能得花更多时间去搞懂他们在干啥,而不是我自己重写或者直接检查。

写一篇事实性文章:这又是另一个例子。你很容易就能写出一堆听起来有模有样的「事实」,但要逐条核实这些「事实」,可能比写文章本身还费劲。这就是一种反向不对称,写起来容易,验证起来难。

设计一套新的饮食方案:这个概念甚至延伸到饮食。我随口就能说「最好的饮食是只吃野牛肉」,这句话我十秒钟就说出来了。但你要验证它是不是真的,那可麻烦了,需要大量的样本,还得等长期效果,中间噪音也多。这些就是验证不对称性的一些例子,任务在不同维度上表现各异。

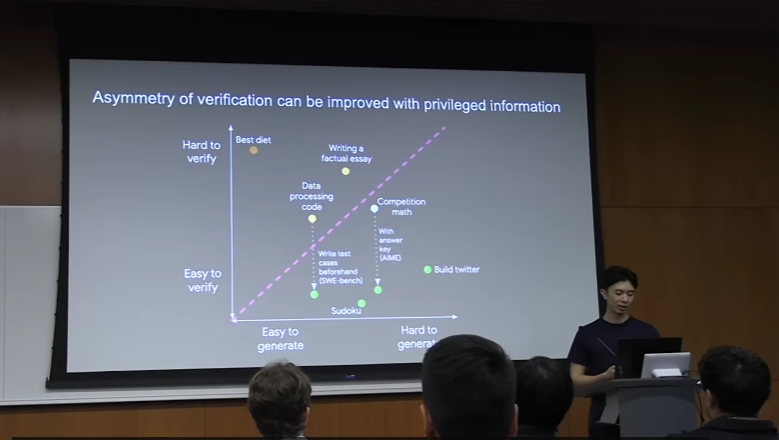

你可以把它想象成一个图:X 轴表示生成(解决方案)的难易程度,Y 轴表示验证(解决方案)的难易程度。

数独:生成中等难度,验证容易。

Twitter:生成困难,验证容易。

最佳饮食:生成容易,验证困难。

还有一些任务居于两者之间。

有意思的是,你可以通过提供一些特权信息(privileged information) 来改变任务在这个图上的位置。例如,在竞赛数学中,如果我给你提供答案,那么检查就变得非常容易。或者如果你在编写代码,我给你测试用例,就像我们在 SWE-bench 中那样,那么检查也变得非常容易。所以,这里的核心思想是,有些任务你可以预先做一些工作,从而增加验证的不对称性。

这就引出了验证者定律(Verifiers Law)的概念。如果「定律」这个词让一些科学家朋友觉得太绝对,你也可以叫它「验证者法则」(Verifiers Rule)。但我的主张是:训练 AI 解决任务的能力,与该任务的可验证性成正比。这意味着:任何可解决且易于验证的任务,最终都会被 AI 攻克。

具体来说,我认为「可验证性」体现在以下五个方面:

客观性:有没有明确的对错标准?

验证速度:检查起来快不快?

可批量验证:能不能一次性检查几百万个方案?

低噪音:验证结果是否稳定可靠?

连续反馈:是只有「对」和「错」两种结果,还是能给出具体的分数,衡量质量的好坏?

大多数 AI 基准测试,从定义上来说,都是易于验证的。这是验证者定律的一个很好的实例,你可以看到,我们在过去五年中关注的所有基准测试都相对快速地被 AI 解决了。

利用验证不对称性的一个绝佳例子,我强烈推荐大家去看看 DeepMind 的 AlphaDev 项目。他们就是通过投入大量计算资源,进行反复采样和运用巧妙算法,成功解决了那些符合验证不对称性特点的任务。这包括数学和计算资源优化等多个领域的任务。

比如设计这样的数学题:「找到这 11 个六边形的放置方式,使得围绕它们绘制的最小外围六边形面积最小。」你会发现,像这样的问题,完全符合我前面说的五个标准。它结果客观,画出来就能验证;验证速度快且可扩展,因为是计算性的,能批量检查;噪音低,每次检查结果都一样;而且是连续反馈,外接六边形的大小直接反映了哪个方案更好。

他们的做法非常巧妙,可以概括为一种进化式搜索算法:

生成 (Sample):让大语言模型生成大量候选的解决方案(代码)。

评估 (Grade):因为任务是高度可验证的(例如,可以通过运行测试来评估代码的正确性和效率),所以可以自动、快速地给每个方案打分。

迭代 (Iterate):将得分最高的方案作为「灵感」,反馈给大语言模型,让它在下一轮生成更高质量的方案。

通过投入海量的计算资源进行这种循环,AlphaDev 能够发现比人类专家设计的算法更优的解。

他们的聪明之处在于,巧妙地避开了大部分深度学习里关注的「泛化」问题。泛化通常有两种:一种是相同的任务但未见过的例子,另一种是未见过的任务。但 AlphaDev 选的问题,是训练和测试是同一个任务。它只关心解决这一个具体问题。这样一来,它就能绕开很多难题。所以,你需要挑选那些有可能找到比已知答案更好的答案的问题。

总结一下,「验证的不对称性」这个概念。

当你面对一个任务时,我建议你好好想想它在「生成难易度」和「验证难易度」这个图谱上的位置。

验证者定律告诉我们,任何容易验证的任务,AI 最终都会攻克。评估基准和 AlphaDev 就是最好的证明。

一些启示:

首先被自动化的任务,将是那些非常容易验证的任务。

其次,我觉得未来一个非常重要的领域(无论是你想创业还是看好它会发展),就是发明衡量事物的方法。如果你能为某个原本难以衡量的领域(比如创造力、用户体验)设计出一套快速、客观、可扩展的评估体系,那么接下来就可以利用 AI 来大规模地优化它。

智能的边缘是锯齿状的,

发展不均衡

最后一个主题是智能的锯齿状边缘。

如果你问 AI 将如何改变世界,我认为人们有非常不同的看法。例如,今年早些时候的情况,我的一位前同事 Boaz 说:「东海岸的人低估了即将到来的变革,他们可能会说‘哦,当前的模型做不到这个’,而不太考虑其发展轨迹。」而在湾区,可能又会低估把我们训练出来的模型真正落地应用,需要克服多少障碍,耗费多少时间。

还有一位我很喜欢的 Roon 说:「现在不应该给出或接受任何职业建议。所有人普遍低估了变革的广度和规模,还有未来职业生涯的巨大不确定性。你在 Meta 的 L4 工程师朋友告诉你‘兄弟,计算机科学学位没用了’,他其实根本不懂。」所以,很明显,关于 AI 将如何影响不同行业,存在着广泛的意见分歧。

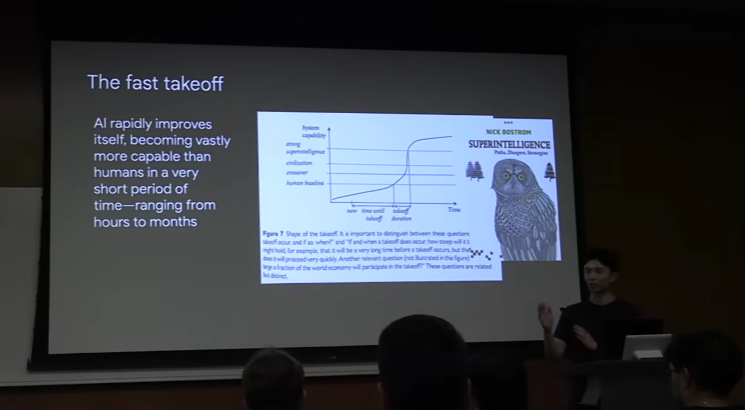

长期以来,有一个假说叫做「快速起飞」(fast takeoff)。它基本的意思是:一旦 AI 在某个方面超越了人类,例如达到了某个特定的目标,就会突然变得比人类强大得多。会在很短的时间内,实现智能的爆炸式增长。

但我想说,这种情景可能不会发生,我来解释一下为什么。

「快速起飞」的观点可能有点过于简单化了。更现实的场景是:

第一年:AI 连研究代码库都跑不起来。

第二年:AI 可以勉强训练一个模型,但效果很差。

第三年:AI 可以自主训练了,但效果不如顶尖的人类研究团队。

第四年:AI 训练得很好,但偶尔还需要人类介入来解决一些疑难杂症。

所以我认为这更像是一个自我改进能力的「光谱」,而不是一个二元的选择,即「一旦你实现了这一个目标,你就能突然创造超级智能」。

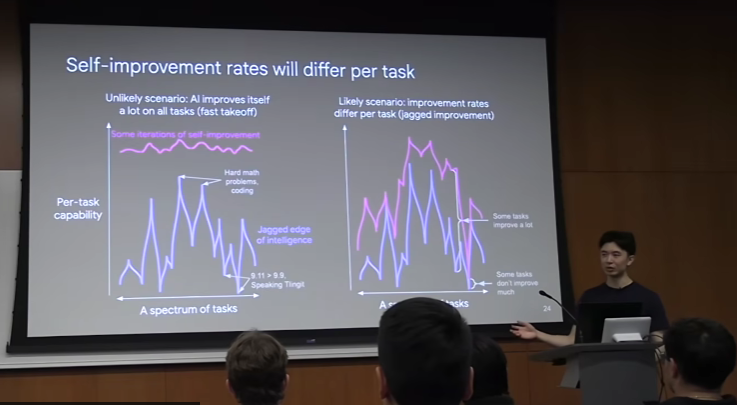

另一个原因是,我认为自我改进的速度,应该按「每个具体任务」来考量。你可以把各种任务想象成一个光谱。更形象地说,就像锯齿状的边缘。在「高峰」的地方,是 AI 目前表现特别出色的问题,比如复杂的数学题、某些编程竞赛题。但也有一些「低谷」,显得有点奇怪。比如,ChatGPT 曾经很长时间都说 9.11 比 9.9 大。还有像说特林吉特语(Tlingit ),那是一种只有几百个美洲原住民才会说的语言,我觉得 ChatGPT 做不好。

所以,我并不认为我们会看到这样的情况:一个自我改进的模型,突然之间就什么都搞定了。我觉得更可能的是右边这种景象:每项任务都会有不同的改进速度。比如,有些任务因为容易验证,而且有了好的算法,所以会突飞猛进;而另一些任务,比如学特林吉特语,可能受限于你得去美洲原住民保留地,去记录他们的语言,这种任务就不会那么快地进步。

我给大家分享几个小窍门,来思考 AI 在某些任务上改进的速度:

AI 擅长数字任务。例如,「家庭作业机器」这种漫画,虽然是 1981 年画的,但它对 AI 工作方式的描绘,在今天看来还挺准的。至于《我,机器人》那种场景,也许很快会有,但我们目前还没实现。我认为 AI 在数字任务上发展这么快的核心原因,就是迭代速度。因为搞数字任务,你想扩展计算资源,那可比用真实机器人做实验容易多了。

另一个很明显的:对人类来说越容易的任务,AI 往往也觉得越容易。所以你可以想象一下人类任务难度的分布。

AI 可能能完成人类因为生理限制而无法完成的任务。 比如预测乳腺癌,如果一个人能看过 1000 万张乳腺癌图像,他也许就能找出预测的规律,但我们人类的寿命和注意力都不够。

还有一个极其简单有效的判断标准:数据越充足,AI 就越如鱼得水。 给大家看个很直观的例子:你可以看看语言模型在不同语言中的数学表现。如果你把某个语言的「使用频率」(也就是我们有多少数据)和它的表现画成图,你会发现一个非常明显的趋势:数据越多,AI 在这个任务上就表现得越好。

如果存在一个明确的、单一的客观评估指标,那么你就可以采用 AlphaEvolve 或 AlphaZero 的策略,通过强化学习来生成「假数据」,实现自我训练。 我前同事 Danny Do 曾发过一条很棒的推特:「只要任务提供清晰的评估指标,可以作为训练时的奖励信号,任何基准测试都可以被迅速解决。」

你可以用这三个小窍门来预测 AI 大概什么时候能搞定某些事情:

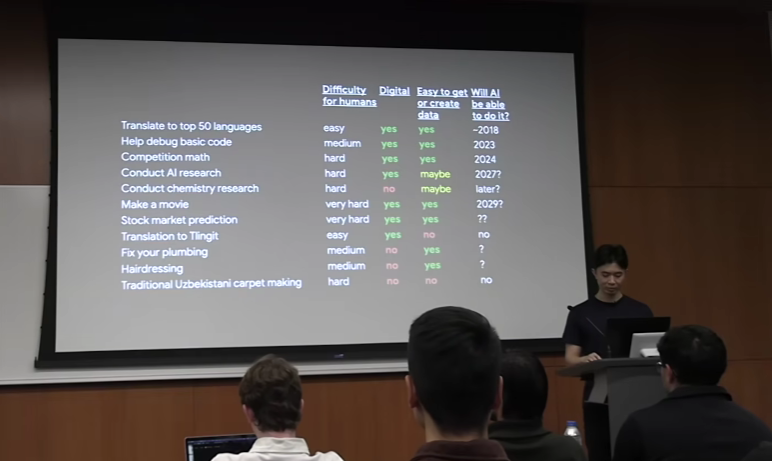

翻译(前 50 种语言):对人类来说不难,是数字任务,数据多。已完成。

调试基础代码:对人类来说中等难度,是数字任务,数据多。我认为 2023 年就搞定了。

竞赛数学:对人类来说挺难的,是数字任务,数据多。在 2024 年完成。

做 AI 研究:对人类来说很难,是数字任务,但数据不太容易搞到或创造。所以我觉得可能要到 2027 年。(这些年份都是我随口说的,大家别当真。)

搞化学研究:对人类来说也难,但它不是数字任务。所以我觉得可能比 AI 研究还要晚。

拍电影:对人类来说非常难,但它是数字任务,数据多。所以也许 2029 年。

预测股市:对人类来说极难,是数字任务,数据多。所以这个我真不确定。

翻译特林吉特语:对懂的人类来说不难,是数字任务,但数据非常少。所以我认为 AI 搞定它的可能性非常低。

修水管:对人类来说中等难度,但它不是数字任务。数据容易搞到吗?不确定。

理发:这也是一个我认为 AI 会觉得很难搞定的任务。

再看那些真正特别难的:比如传统的手工地毯制作。对人类来说非常难,一个团队可能要花一个月才能织出一块地毯。不是数字任务,数据也搞不到。所以我觉得 AI 短期内根本不可能做这个。

带女朋友约会让她开心:不可能!不是数字任务,数据也搞不到。所以我觉得这个 AI 永远也搞不定,我们人类在这一行还能干很久。

总结一下,「智能的锯齿状边缘」这个概念。

我认为不会出现某种快速的超级智能起飞,因为每项任务的能力和改进速度都不同。

AI 影响最大的,是那些符合特定属性的任务:数字任务、对人类来说不难,而且数据丰富。

一些启示:

某些领域将因 AI 而极大地加速,例如软件开发。

另一些领域可能会保持不变,例如理发。

ARR 突破 1 亿美元,HeyGen 创始人公开了他们的内部增长手册,全是干货

硅谷一线创业者内部研讨:为什么只有 5%的 AI Agent 落地成功,他们做对了什么?

转载原创文章请添加微信:founderparker

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢