💙 大语言模型的安全死穴在哪?为何其验证机制既难可靠又难适配复杂场景?

💙 如何为“黑箱”中的AI装上可数学证明的“监视器”,实现真正的可验证安全?

💙 形式化系统能否成为安全AGI的破局关键?

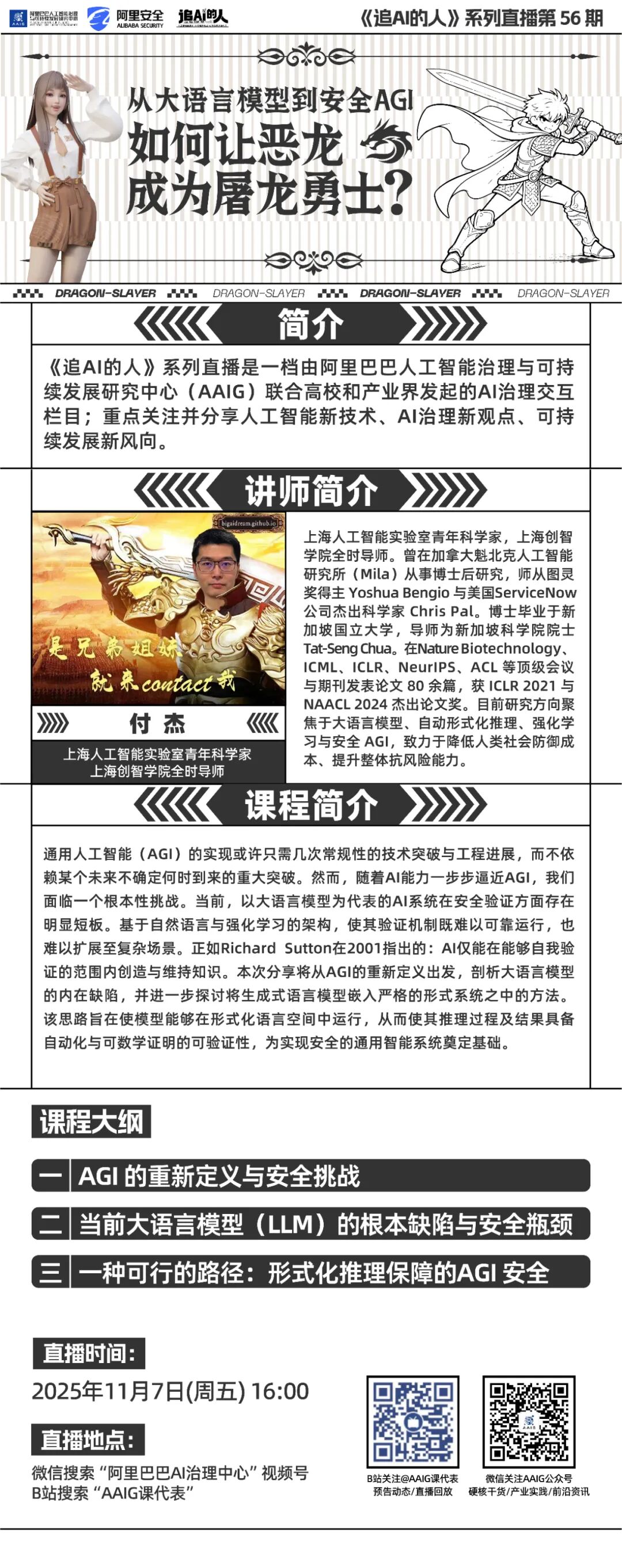

本周五(11月7日)16:00,《追AI的人》系列直播第56期邀请了上海人工智能实验室青年科学家,上海创智学院全时导师付杰分享《从大语言模型到安全AGI:如何让“恶龙”成为“屠龙勇士”? 》。直播主题:《从大语言模型到安全AGI:如何让“恶龙”成为“屠龙勇士”? 》直播时间: 2025年11月7日(周五)16:00直播地点: 微信搜索“阿里巴巴AI治理中心”视频号,B站搜“AAIG课代表”通用人工智能(AGI)的实现或许只需几次常规性的技术突破与工程进展,而不依赖某个未来不确定何时到来的重大突破。然而,随着AI能力一步步逼近AGI,我们面临一个根本性挑战。当前,以大语言模型为代表的AI系统在安全验证方面存在明显短板。基于自然语言与强化学习的架构,使其验证机制既难以可靠运行,也难以扩展至复杂场景。正如Richard Sutton在2001指出的:AI仅能在能够自我验证的范围内创造与维持知识。本次分享将从AGI的重新定义出发,剖析大语言模型的内在缺陷,并进一步探讨将生成式语言模型嵌入严格的形式系统之中的方法。该思路旨在使模型能够在形式化语言空间中运行,从而使其推理过程及结果具备自动化与可数学证明的可验证性,为实现安全的通用智能系统奠定基础。上海人工智能实验室青年科学家,上海创智学院全时导师。曾在加拿大魁北克人工智能研究所(Mila)从事博士后研究,师从图灵奖得主Yoshua Bengio与美国 ServiceNow 公司杰出科学家Chris Pal。博士毕业于新加坡国立大学,导师为新加坡科学院院士Tat-Seng Chua。在Nature Biotechnology、ICML、ICLR、NeurIPS、ACL等顶级会议与期刊发表论文 80 余篇,获ICLR 2021与NAACL 2024杰出论文奖。目前研究方向聚焦于大语言模型、自动形式化推理、强化学习与安全AGI,致力于降低人类社会防御成本、提升整体抗风险能力。 《追AI的人》系列直播是一档由阿里巴巴人工智能治理与可持续发展研究中心(AAIG)联合高校和产业界发起的AI治理交互栏目。重点关注并分享人工智能新技术、AI治理新观点、可持续发展新风向。目前联合高校、律所等多家单位举办了55期直播,吸引全国超100万人次实时观看。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢