当前,大语言模型(LLM)训练严重依赖庞大且不透明的互联网语料,使得模型表现出典型的“黑箱式”特征。

也因此,业内尚难以界定模型在预训练阶段包含的内容,也无法区分基于强化学习(RL)的后训练所带来的能力提升究竟是源于习得新技能,还是对已有能力的激活与放大,关于中期训练的讨论则更为不足。

那么,预训练、中期训练和基于 RL 的后训练,究竟是如何影响 LLM 的推理能力的?

为解答这一问题,卡内基梅隆大学(CMU)团队构建了一个完全可控的实验框架,分别拆解预训练、中期训练和 RL 对推理泛化能力的影响。

论文链接:https://arxiv.org/pdf/2512.07783

其中,论文第一作者现为中国科学院自动化研究所硕士三年级学生,在卡内基梅隆大学求学期间与该论文通讯作者岳翔(现为 Meta 超级智能实验室研究员)共同开展研究工作,另一位作者为卡内基梅隆大学副教授 Graham Neubig。

基于大量可控实验,研究团队得出以下 4 点结论:

只有当预训练留下足够“发展空间”,且 RL 数据瞄准模型“能力边界”,即那些困难但尚能企及的任务时,RL 才会带来真实的能力增益;

上下文泛化的前提是预训练中给予模型“最小但必要”的暴露,在此基础上,RL 才能稳定迁移并发挥作用;

在相同计算量下,中期训练能显著提升性能,其重要性被长期低估了;

过程奖励能减少奖励黑客(reward hacking),并提升推理的真实性与可靠性。

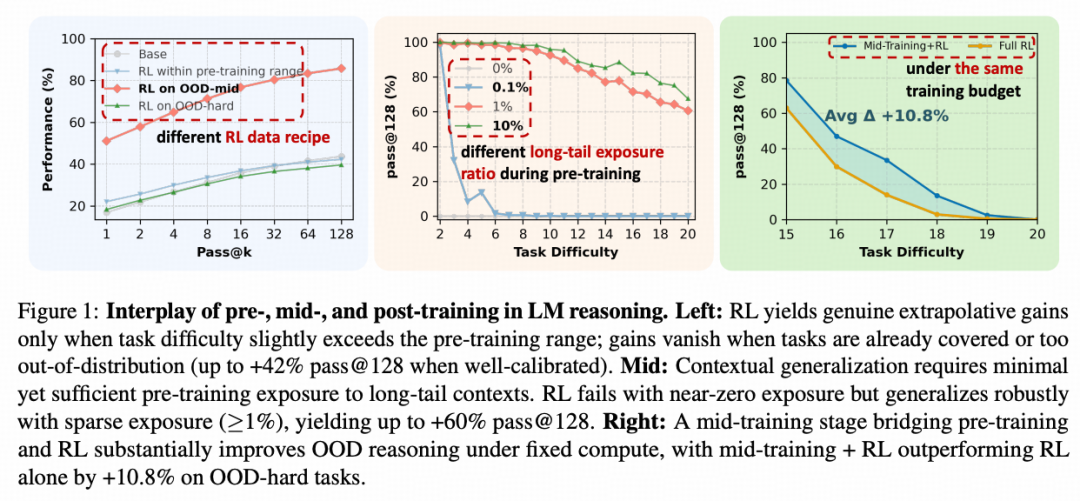

图|语言模型(LM)推理中预训练、中期训练和后训练的相互作用。

以下是对实验结论的详细介绍。

RL何时能让LLM推理突破预训练上限?

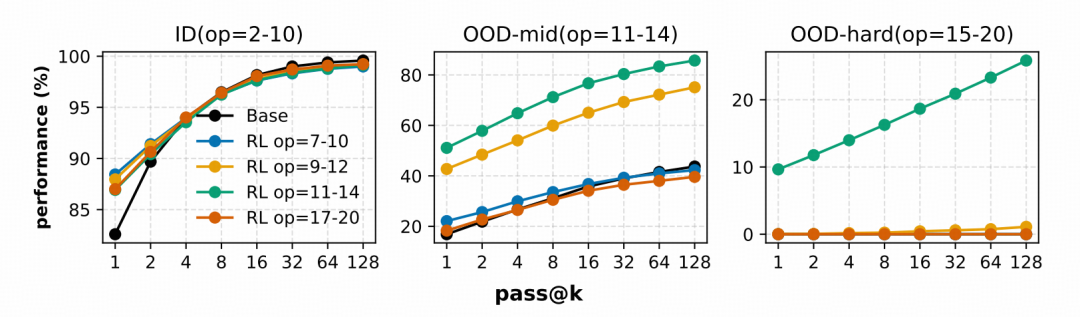

研究团队通过固定预训练阶段、仅改变后训练数据的难度与覆盖范围,来验证 RL 对提高 LLM 推理能力的作用。实验发现,RL 不会直接提升推理能力,它的有效性取决于两方面:

一方面,预训练要留有足够“发展空间”。若一个任务在预训练中已被充分覆盖,模型能力接近饱和,则 RL 的增益几乎可以忽略。

另一方面,RL 数据必须触及模型的能力边界,既不能过易导致训练退化为重复既有模式,也不能过难使模型无法获得有效的奖励反馈,当任务难度恰好处于模型“跳一跳便能得着”的区域时,RL 可以发挥最大作用。

只有这两方面同时被满足,RL 才能够真正推动模型从已有能力向更高层级的推理策略扩展,实现超越基础模型的能力增益。

图|三个不同任务下的 pass@k 性能,证明了 RL 发生作用的边界。

预训练曝光如何塑造后训练泛化能力?

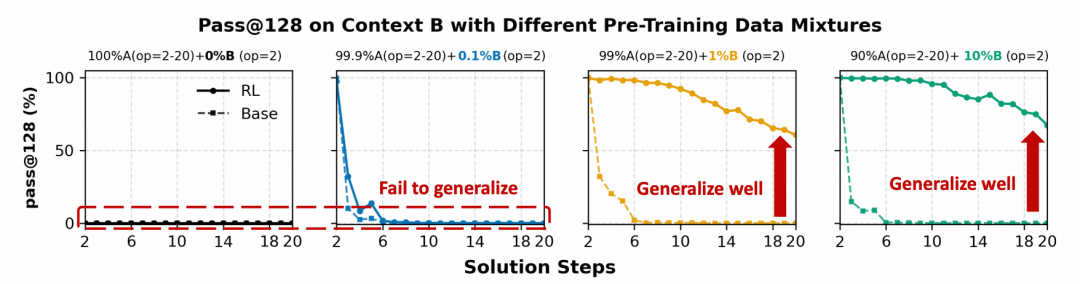

研究团队在保持 RL 数据和训练方式不变的前提下,改变预训练数据的分布,观察预训练的曝光程度对后训练泛化的影响。实验表明,RL 的泛化能力不是凭空出现的,它必须依托于基础模型已有的最小知识结构,如果预训练阶段完全没有涉及某类的内容,RL 就无法有效进行知识迁移。

值得注意的是,即便预训练覆盖率很低(如 ≥1% 的样本),也能为 RL 提供足够的泛化基础。在后训练阶段,RL 可以强化这些基础,从而鲁棒地扩展模型在新上下文中的泛化能力。

图|使用 50% context A + 50% context B 混合数据进行后训练,模型在 context B 上的 pass@128 性能。

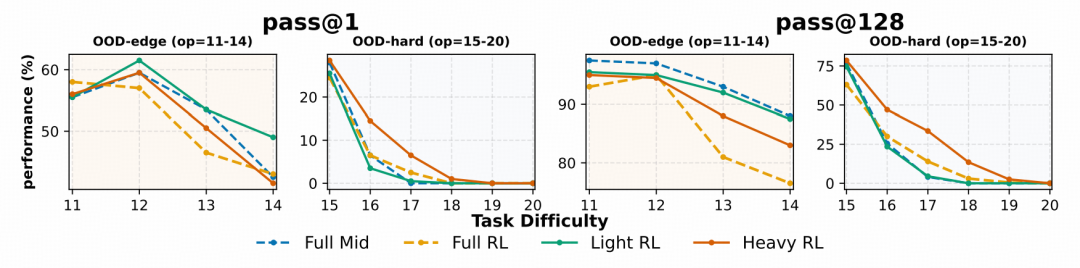

中期训练如何与后训练交互?

RL 的成功,在很大程度上依赖于预训练阶段建立的知识,而中期训练作为一个位于预训练和后训练之间的阶段,其主要目标是弥合数据分布差距并强化推理先验,从而提高模型对下游 RL 的响应能力。

实验结果表明,在固定的总算力预算下,将一部分算力分配给中期训练,另一部分给 RL,其效果远胜于将所有算力都用于 RL。

图|在不同中期和后期训练混合比例下,模型在外推任务上的 pass@1 和 pass@128 性能。

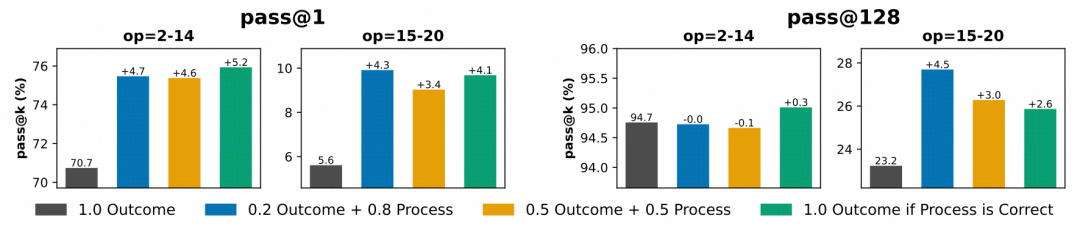

通过结果奖励中的过程监督减轻奖励黑客

在 RL 中,模型有时会出现奖励黑客,即表面上答案正确,但实际推理路径不合理。为解决这个问题,研究团队引入过程验证,不仅检查最终答案,还要求每一步推理都正确。

实验结果表明,过程奖励可以有效减轻奖励黑客,让模型学会忠实推理而不仅仅追求结果正确性。通过引导模型关注每一步的合理性,RL 微调期间的错误模式明显减少,推理行为更加可靠。在高难度、超出训练分布的任务中,这种方法带来了更稳定的提升。

图|在不同奖励组合下的 pass@k 性能。每个条形对应一种独特的奖励混合策略。在所有评估设置中,将过程级信息纳入结果奖励始终能带来可衡量的性能提升。

总之,这项研究让我们更加理解 LLM 如何学习推理能力,也指出了高效训练的关键策略:与其盲目堆砌数据和算力,不如在预训练、中期训练和 RL 阶段精心规划数据和计算资源,让每一步都发挥最大价值,从而真正提升模型的泛化与推理能力。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢