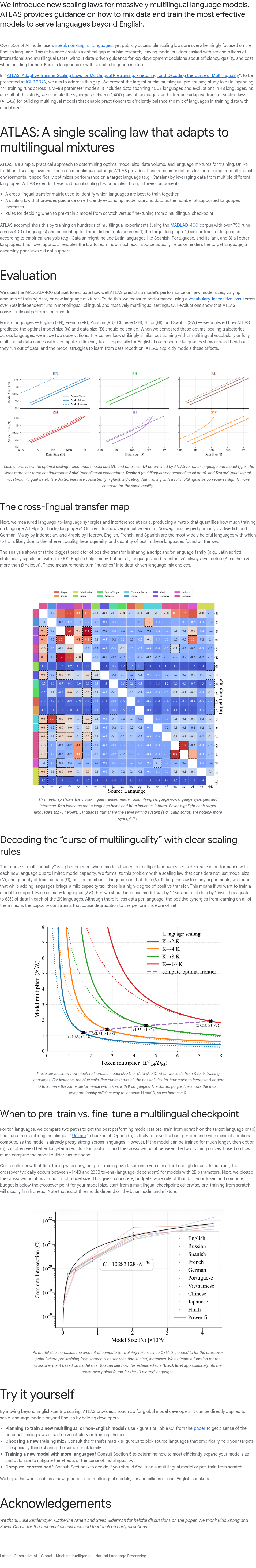

本文介绍ATLAS——首个面向大规模多语言语言模型的新型缩放定律框架,旨在解决当前公开缩放定律严重偏重英语、忽视非英语语言(占AI用户超50%)所导致的研究与实践断层。ATLAS通过迄今最大规模的公开多语言预训练研究(涵盖10M–8B参数模型、774组训练实验),系统探索数据配比、预训练、微调及解码策略对多语言性能的影响,为构建高效、高质量、低成本的多语言模型提供数据驱动的指导,助力服务全球数十亿非英语及多语言用户。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢