【标题】Rule-Based Reinforcement Learning for Efficient Robot Navigation with Space Reduction

【作者团队】Yuanyang Zhu, Zhi Wang, Chunlin Chen, Daoyi Dong

【论文链接】https://arxiv.org/pdf/2104.07282.pdf

【发表时间】2021.4.15

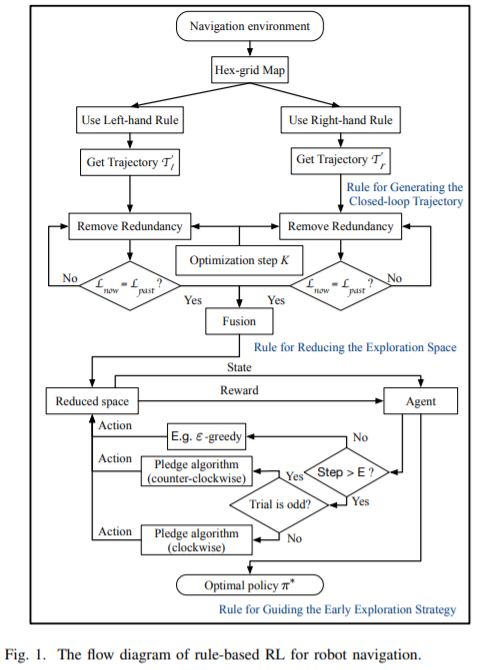

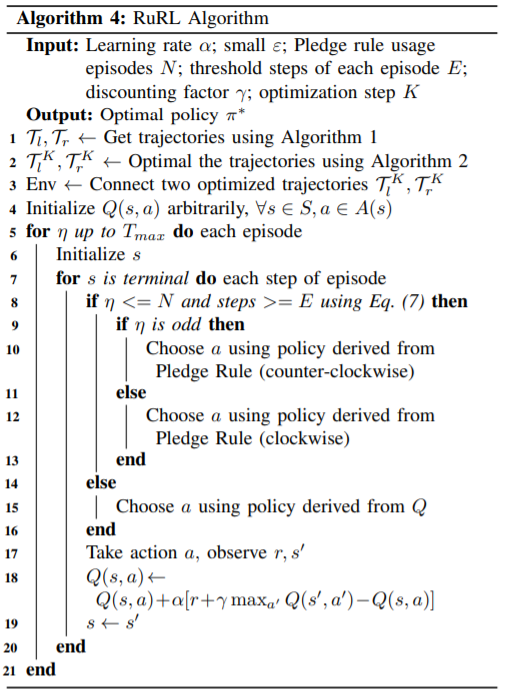

【推荐理由】本文提出了一种基于规则的RL(RuRL)空间缩减机器人导航算法,其利用三条规则以减少冗余的探测空间,并指导探测策略。然后,本文评估了单间环境和多间环境下的RuRL,其中使用SLAM移动机器人构建地图。实验结果表明,RuRL能有效地提高导航性能,并具有良好的可扩展性。

在现实世界中,允许机器人在复杂环境中自主导航是至关重要的。传统的方法通常维护环境的内部地图,然后设计几个简单的规则,结合定位和规划方法,在内部地图中导航。这些方法通常涉及各种假设和先验知识。相比之下,最新的强化学习(RL)方法可以在机器人与初始未知的环境交互时,提供一种无模型的自学习机制,但由于探测效率低,在现实场景中部署成本很高。故本文以RL技术为核心,结合这两种方法的优点,提出了一种基于规则的RL(RuRL)算法,以降低样本复杂度和时间成本。首先,利用壁面跟随规则生成闭环轨迹。其次,采用归约法则来缩小轨迹,从而有效地减少了冗余的探测空间。此外,本文还从理论上详细保证了最优导航路径仍在缩小的空间内。第三,在缩减空间中,利用Pledge规则来指导探索策略,以在早期阶段加速RL过程。在hex网格环境下对实际机器人导航问题进行的实验表明,RuRL算法可以提高机器人的导航性能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢