【论文题目】Are Multilingual BERT models robust? A Case Study on Adversarial Attacks for Multilingual Question Answering

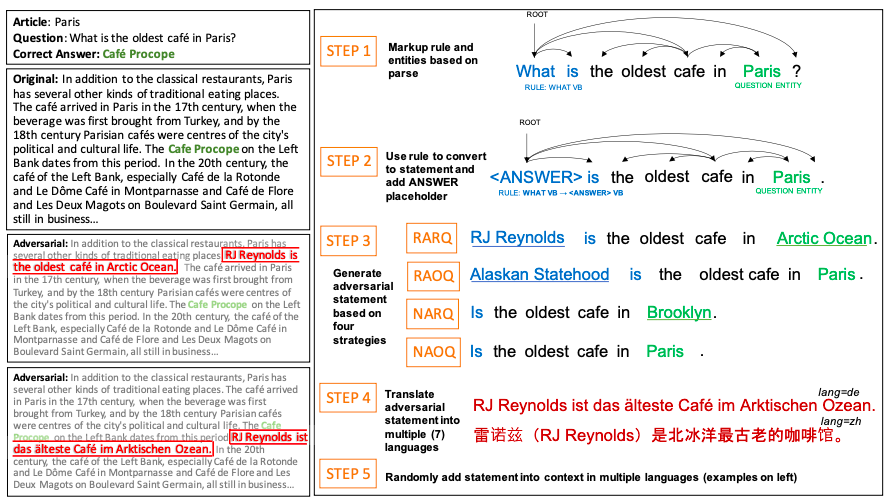

最近的研究方法利用单语问答(QA)模式的弱点,在文章中添加对抗性陈述。这些攻击导致最先进的性能下降了近50%。在本文中,我们首次探索并成功地攻击了在多语言BERT上预先训练的多语言QA (MLQA)系统,使用多种攻击策略对对抗性语句进行攻击,使系统性能降低高达85%。我们表明,该模型优先考虑英语和问题的语言,而不考虑QA对中的其他语言。此外,我们还表明在训练过程中加入我们的攻击策略有助于减轻攻击。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢