【论文标题】Self-Training with Weak Supervision

【论文链接】https://arxiv.org/abs/2104.05514

【代码链接】https://github.com/microsoft/ASTRA

【作者团队】Giannis Karamanolakis, Subhabrata Mukherjee, Guoqing Zheng, Ahmed Hassan Awadallah

【发表时间】2021.4.12

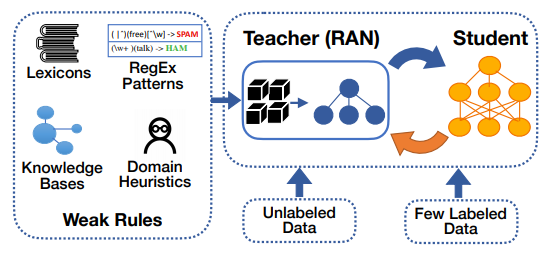

【推荐理由】论文收录于NAACL-2021,研究人员开发出一种弱监督框架,通过学生模型的自训练来利用任务特定的未标注数据以及上下文表示,对未被弱监督规则覆盖的实例预测伪标签。研究人员进一步开发了一个规则注意力网络的教师模型,学习如何在标签保真度和实例上下文表示的条件下,将学生模型预测得到的伪标签与弱标签规则融合。最后,研究人员构建了一个半监督学习目标,用于端到端的训练未标注数据、特定领域规则以及少量标注数据。

最先进的深度神经网络需要大规模标注的训练数据,而这些数据往往是非常昂贵的,或者对于许多任务来说是不可用的。特定领域规则形式的弱监督方法已被证明在这种实验设置下是有用的,可以自动生成弱标记的训练数据。然而,由于弱规则内在的启发式和噪音特性,利用弱规则学习是具有挑战性的。另一个挑战则是规则的覆盖和重叠,弱监督的前人相关研究只考虑弱规则所覆盖的实例,因此留下了有价值的未标注数据。在六个基准数据集上为文本分类任务进行广泛的实验,结果表明论文方法的有效性,对于最先进的基线模型有显著的改进。

图:弱监督学习框架

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢