论文标题:Transformer Transforms Salient Object Detection and Camouflaged Object Detection

论文链接:https://arxiv.org/abs/2104.10127

作者单位:西北工业大学 & 澳大利亚国立大学 & 南开大学

表现SOTA!性能优于SCWS、JLDCF等网络,

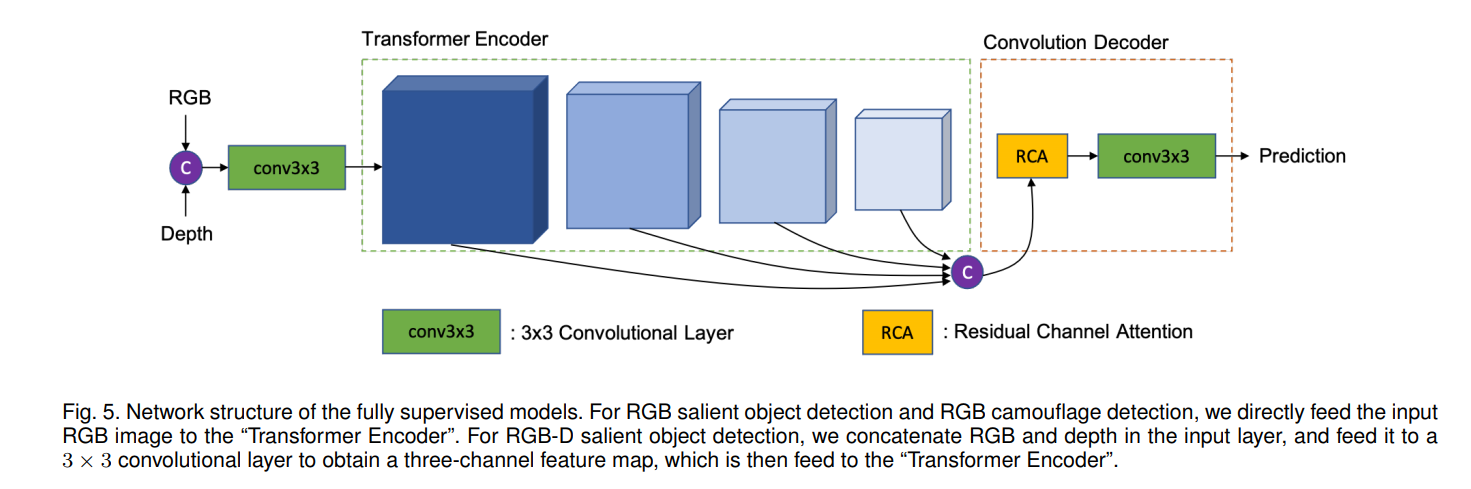

源自机器翻译的Transformer网络特别擅长在长序列中对远程依存关系进行建模。当前,Transformer网络在从高级分类任务到low-level密集预测任务的各种视觉任务中都取得了革命性的进步。在本文中,我们进行了将Transformer网络用于显著性物体检测(SOD)的研究。具体来说,我们采用密集的Transformer主干来进行全面监督的基于RGB图像的SOD,基于RGB-D图像对的SOD,以及通过涂抹监督来进行弱监督的SOD。作为扩展,我们还将完全监督的模型应用于伪装对象分割的伪装对象检测(COD)任务。对于完全监督的模型,我们将密集Transformer主干定义为特征编码器,并设计一个非常简单的解码器以生成一个单通道显著性图(或COD任务的伪装图)。对于弱监督模型,由于在乱写注释中没有结构信息,因此我们首先采用最近提出的Gated-CRF损失对有效的成对关系进行建模,以进行准确的模型预测。然后,我们引入自监督的学习策略来推动模型产生尺度不变的预测,这对于弱监督模型和在小型训练数据集上训练的模型被证明是有效的。在各种SOD和COD任务(基于完全监督的RGB图像的SOD,基于监督的完全监督的RGB-D图像对,通过涂抹监控的弱监督的SOD和基于监督的RGB图像的完全监督的SOD)上的大量实验结果表明,Transformer网络可以转换显著性目标检测和伪装对象检测,从而为每个相关任务提供了新的基准。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢