论文标题:Multiscale Vision Transformers

论文链接:https://arxiv.org/abs/2104.11227

代码链接:https://github.com/facebookresearch/SlowFast

作者单位: Facebook人工智能研究院 & 加州大学伯克利分校

表现SOTA!在图像分类、视频理解等任务上,优于ViT、X3D、SlowFast和TimeSformer等网络,代码即将开源!

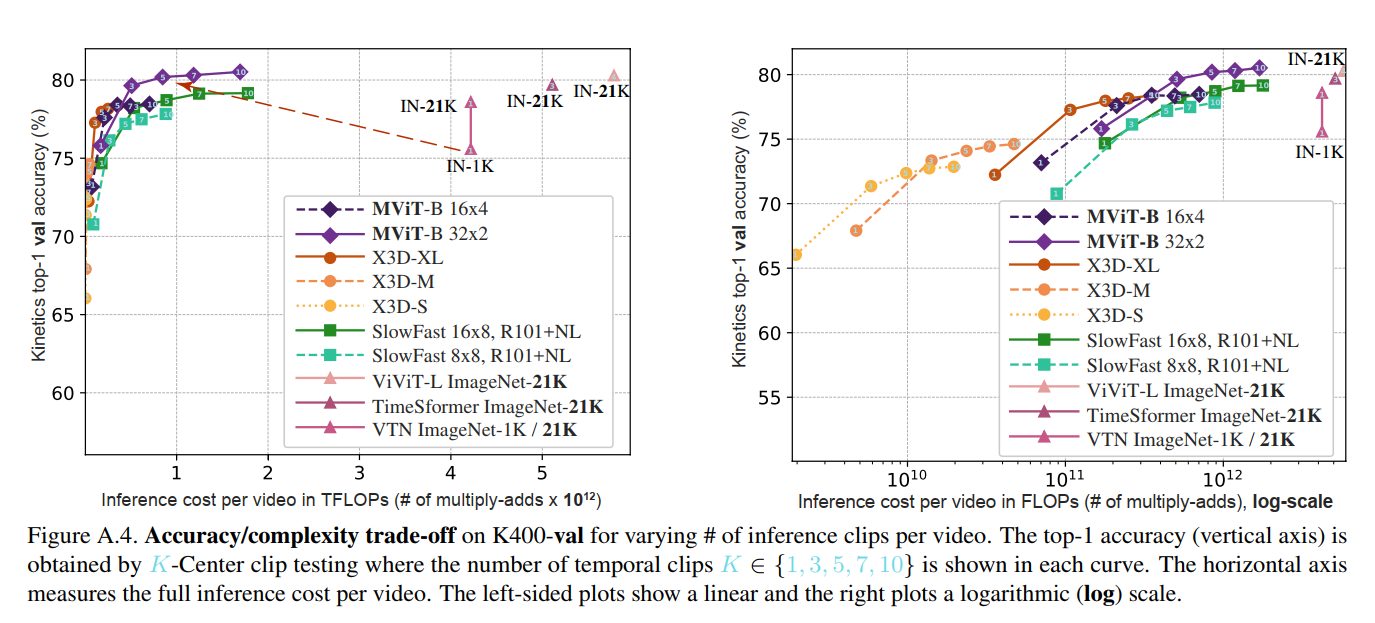

通过将多尺度特征层次结构的开创性思想与Transformer模型联系起来,我们提出了用于视频和图像识别的多尺度视觉Transformer(MViT)。多尺度Transformer具有几个通道分辨率尺度阶段。从输入分辨率和较小的通道尺寸开始,这些阶段会在降低空间分辨率的同时分层扩展通道容量。这将创建一个多尺度的要素金字塔,其中早期的图层以高空间分辨率运行以对简单的低层视觉信息进行建模,而较深的图层则以空间粗糙但复杂的高维要素进行建模。我们评估了用于对各种视频识别任务的视觉信号的密集性质建模的基础架构先验,其性能优于依赖大规模外部预训练的并发视觉Transformer,并且在计算和参数上的成本要高5-10倍。我们进一步去除了时间维度,并将我们的模型应用于图像分类,其性能优于视觉Transformer的先前工作。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢