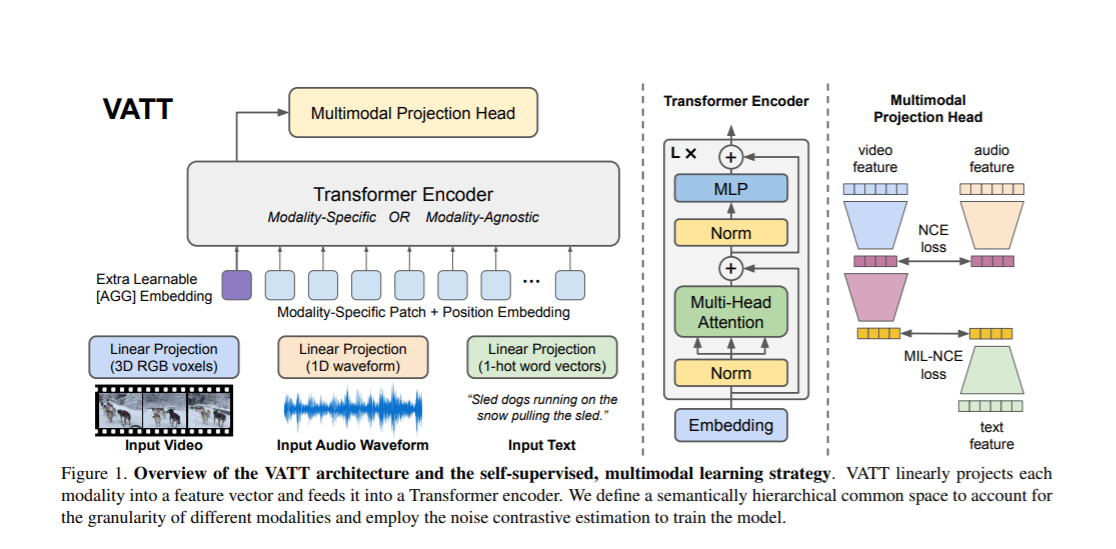

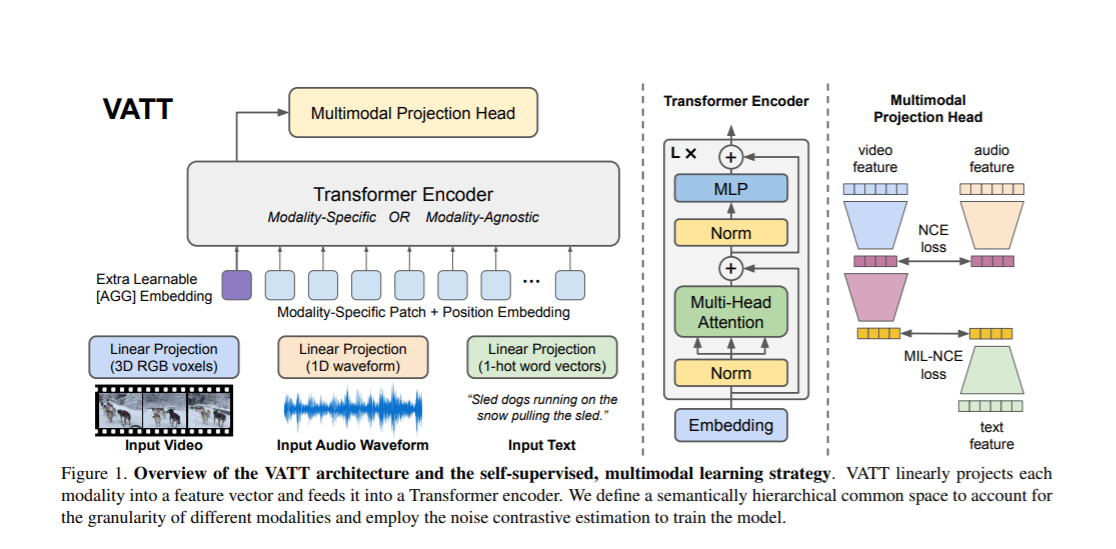

标题:谷歌、哥大、康奈尔|VATT: Transformers for Multimodal Self-Supervised Learning from Raw Video, Audio and Text(VATT:用于原始视频,音频和文本多模式自监督变换器)

https://arxiv.org/pdf/2104.11178.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

标题:谷歌、哥大、康奈尔|VATT: Transformers for Multimodal Self-Supervised Learning from Raw Video, Audio and Text(VATT:用于原始视频,音频和文本多模式自监督变换器)

https://arxiv.org/pdf/2104.11178.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢